GSP1250

Visão geral

Embora o BigQuery ofereça recursos integrados de observabilidade, como as visualizações INFORMATION_SCHEMA, o registro detalhado continua sendo essencial para uma análise aprofundada do uso, auditoria e solução de problemas em potencial. Ao ativar a Análise de Dados de Registros, você pode consultar e analisar seus dados de registros usando consultas SQL conhecidas e, em seguida, visualizar ou representar graficamente os resultados da consulta.

O BigQuery é o data warehouse corporativo e totalmente gerenciado do Google Cloud que ajuda você a gerenciar e analisar seus dados com recursos integrados, como machine learning, análise geoespacial e Business Intelligence.

Neste laboratório, você vai ativar a Análise de Dados de Registros em buckets de armazenamento de registros e visualizar os registros do BigQuery no Cloud Logging. Você também usa SQL para analisar os registros com a ferramenta Análise de Dados de Registros.

Objetivos

Neste laboratório, você vai aprender a:

- Usar o Cloud Logging de forma eficaz para ter insights sobre o uso do BigQuery.

- Criar e executar consultas SQL de forma eficaz usando a Análise de Dados de Registros.

- Visualizar e fazer um gráfico dos resultados.

Fazer a configuração e ver os requisitos

Antes de clicar no botão Começar o Laboratório

Leia estas instruções. Os laboratórios são cronometrados e não podem ser pausados. O timer é ativado quando você clica em Iniciar laboratório e mostra por quanto tempo os recursos do Google Cloud vão ficar disponíveis.

Este laboratório prático permite que você realize as atividades em um ambiente real de nuvem, e não em uma simulação ou demonstração. Você vai receber novas credenciais temporárias para fazer login e acessar o Google Cloud durante o laboratório.

Confira os requisitos para concluir o laboratório:

- Acesso a um navegador de Internet padrão (recomendamos o Chrome).

Observação: para executar este laboratório, use o modo de navegação anônima (recomendado) ou uma janela anônima do navegador. Isso evita conflitos entre sua conta pessoal e de estudante, o que poderia causar cobranças extras na sua conta pessoal.

- Tempo para concluir o laboratório: não se esqueça que, depois de começar, não será possível pausar o laboratório.

Observação: use apenas a conta de estudante neste laboratório. Se usar outra conta do Google Cloud, você poderá receber cobranças nela.

Como iniciar seu laboratório e fazer login no console do Google Cloud

-

Clique no botão Começar o laboratório. Se for preciso pagar por ele, uma caixa de diálogo vai aparecer para você selecionar a forma de pagamento.

No painel Detalhes do Laboratório, à esquerda, você vai encontrar o seguinte:

- O botão Abrir Console do Google Cloud

- O tempo restante

- As credenciais temporárias que você vai usar neste laboratório

- Outras informações, se forem necessárias

-

Se você estiver usando o navegador Chrome, clique em Abrir console do Google Cloud ou clique com o botão direito do mouse e selecione Abrir link em uma janela anônima.

O laboratório ativa os recursos e depois abre a página Fazer Login em outra guia.

Dica: coloque as guias em janelas separadas lado a lado.

Observação: se aparecer a caixa de diálogo Escolher uma conta, clique em Usar outra conta.

-

Se necessário, copie o Nome de usuário abaixo e cole na caixa de diálogo Fazer login.

{{{user_0.username | "Username"}}}

Você também encontra o nome de usuário no painel Detalhes do Laboratório.

-

Clique em Próxima.

-

Copie a Senha abaixo e cole na caixa de diálogo de Olá.

{{{user_0.password | "Password"}}}

Você também encontra a senha no painel Detalhes do Laboratório.

-

Clique em Próxima.

Importante: você precisa usar as credenciais fornecidas no laboratório, e não as da sua conta do Google Cloud.

Observação: se você usar sua própria conta do Google Cloud neste laboratório, é possível que receba cobranças adicionais.

-

Acesse as próximas páginas:

- Aceite os Termos e Condições.

- Não adicione opções de recuperação nem autenticação de dois fatores (porque essa é uma conta temporária).

- Não se inscreva em testes gratuitos.

Depois de alguns instantes, o console do Google Cloud será aberto nesta guia.

Observação: para acessar os produtos e serviços do Google Cloud, clique no Menu de navegação ou digite o nome do serviço ou produto no campo Pesquisar.

Ativar o Cloud Shell

O Cloud Shell é uma máquina virtual com várias ferramentas de desenvolvimento. Ele tem um diretório principal permanente de 5 GB e é executado no Google Cloud. O Cloud Shell oferece acesso de linha de comando aos recursos do Google Cloud.

-

Clique em Ativar o Cloud Shell  na parte de cima do console do Google Cloud.

na parte de cima do console do Google Cloud.

-

Clique nas seguintes janelas:

- Continue na janela de informações do Cloud Shell.

- Autorize o Cloud Shell a usar suas credenciais para fazer chamadas de APIs do Google Cloud.

Depois de se conectar, você verá que sua conta já está autenticada e que o projeto está configurado com seu Project_ID, . A saída contém uma linha que declara o projeto PROJECT_ID para esta sessão:

Your Cloud Platform project in this session is set to {{{project_0.project_id | "PROJECT_ID"}}}

A gcloud é a ferramenta de linha de comando do Google Cloud. Ela vem pré-instalada no Cloud Shell e aceita preenchimento com tabulação.

- (Opcional) É possível listar o nome da conta ativa usando este comando:

gcloud auth list

- Clique em Autorizar.

Saída:

ACTIVE: *

ACCOUNT: {{{user_0.username | "ACCOUNT"}}}

To set the active account, run:

$ gcloud config set account `ACCOUNT`

- (Opcional) É possível listar o ID do projeto usando este comando:

gcloud config list project

Saída:

[core]

project = {{{project_0.project_id | "PROJECT_ID"}}}

Observação: consulte a documentação completa da gcloud no Google Cloud no guia de visão geral da gcloud CLI.

Tarefa 1: configurar buckets de registros

Nesta tarefa, você vai configurar o Cloud Logging para fazer upgrade dos buckets de registros atuais com a Análise de Dados de Registros ativada.

Faça upgrade dos buckets atuais para usar a Análise de dados de registros:

- Na barra de título do console do Google Cloud, digite Armazenamento de registros no campo de Pesquisa e clique em Armazenamento de registros nos resultados da pesquisa.

A página Armazenamento de registros é aberta. Dois buckets, _Default e _Required, são especificados na lista Buckets de registros.

- Para o bucket de registros _Required, clique em Fazer upgrade na coluna Análise de Dados de Registros disponível.

- Clique em Fazer upgrade novamente para confirmar o upgrade e usar a Análise de Dados de Registros.

- Faça o mesmo para o bucket de registros _Default. Clique em Fazer upgrade na coluna Análise de Dados de Registros disponível.

- Clique em Fazer upgrade novamente para confirmar o upgrade e usar a Análise de Dados de Registros.

Clique em Verificar meu progresso para conferir o objetivo.

Fazer upgrade dos buckets de registros.

Tarefa 2: realizar atividades do BigQuery

Nesta tarefa, você vai gerar registros do BigQuery. Para fazer isso, você vai usar a ferramenta de linha de comando do BigQuery bq.

- No Cloud Shell, insira o comando

bq mk para criar novos conjuntos de dados chamados bq_logs e bq_logs_test no seu projeto:

bq mk bq_logs

bq mk bq_logs_test

- Insira o comando

bq ls para listar os conjuntos de dados:

bq ls

- Insira o comando

bq rm para excluir um conjunto de dados (selecione Y quando solicitado):

bq rm bq_logs_test

- Crie uma nova tabela:

bq mk \

--table \

--expiration 3600 \

--description "This is a test table" \

bq_logs.test_table \

id:STRING,name:STRING,address:STRING

Você verá uma mensagem informando que uma nova tabela vazia chamada test_table foi criada com sucesso para seu conjunto de dados.

Agora execute algumas consultas para gerar registros.

- Insira a seguinte consulta no Cloud Shell:

bq query --use_legacy_sql=false 'SELECT current_date'

- Insira o seguinte comando no Cloud Shell:

bq query --use_legacy_sql=false \

'SELECT

gsod2021.date,

stations.usaf,

stations.wban,

stations.name,

stations.country,

stations.state,

stations.lat,

stations.lon,

stations.elev,

gsod2021.temp,

gsod2021.max,

gsod2021.min,

gsod2021.mxpsd,

gsod2021.gust,

gsod2021.fog,

gsod2021.hail

FROM

`bigquery-public-data.noaa_gsod.gsod2021` gsod2021

INNER JOIN

`bigquery-public-data.noaa_gsod.stations` stations

ON

gsod2021.stn = stations.usaf

AND gsod2021.wban = stations.wban

WHERE

stations.country = "US"

AND gsod2021.date = "2021-12-15"

AND stations.state IS NOT NULL

AND gsod2021.max != 9999.9

ORDER BY

gsod2021.min;'

Esta consulta usa dados meteorológicos da Administração Oceânica e Atmosférica Nacional (NOAA, na sigla em inglês)

Clique em Verificar meu progresso para conferir o objetivo.

Realizar atividades do BigQuery.

Tarefa 3: realizar análise de registros

Nesta tarefa, você vai analisar os dados de registro criados na tarefa anterior.

Desafio (opcional): antes de executar uma consulta, você consegue prever o resultado?

Consultar uma operação específica

Uma tarefa comum ao analisar o uso do BigQuery é pesquisar operações específicas nos seus conjuntos de dados. Nesta tarefa, você vai consultar as operações de criação e exclusão.

-

No painel esquerdo, clique em Análise de Dados de Registros e encontre o campo Consulta na seção Análise de Dados de Registros.

-

Para encontrar as operações criadas e excluídas, digite ou cole a consulta a seguir no campo Consulta e clique em Executar consulta:

SELECT

timestamp,

severity,

resource.type,

proto_payload.audit_log.authentication_info.principal_email,

proto_payload.audit_log.method_name,

proto_payload.audit_log.resource_name,

FROM

`{{{ project_0.project_id | "Project ID" }}}.global._Required._AllLogs`

WHERE

log_id = 'cloudaudit.googleapis.com/activity'

AND proto_payload.audit_log.method_name LIKE 'datasetservice%'

LIMIT

100

Sua consulta deve gerar três resultados.

Você também pode limitar sua pesquisa com mais detalhes, como method_name = 'datasetservice.delete'.

Consultar operações para tabelas do BigQuery

- Para encontrar as operações das tabelas do BigQuery, altere a condição da consulta para serviços de tabela. Execute esta consulta para encontrar operações em tabelas criadas ou excluídas:

SELECT

timestamp,

severity,

resource.type,

proto_payload.audit_log.authentication_info.principal_email,

proto_payload.audit_log.method_name,

proto_payload.audit_log.resource_name,

FROM

`{{{ project_0.project_id | "Project ID" }}}.global._Required._AllLogs`

WHERE

log_id = 'cloudaudit.googleapis.com/activity'

AND proto_payload.audit_log.method_name LIKE '%TableService%'

LIMIT

100

Essa consulta gera um resultado.

- Para visualizar as consultas concluídas do BigQuery, pesquise o registro

data_access com base no jobCompletedEvent. Por exemplo, execute a seguinte consulta SQL:

SELECT

timestamp,

resource.labels.project_id,

proto_payload.audit_log.authentication_info.principal_email,

JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobConfiguration.query.query) AS query,

JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobConfiguration.query.statementType) AS statementType,

JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatus.error.message) AS message,

JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.startTime) AS startTime,

JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.endTime) AS endTime,

CAST(TIMESTAMP_DIFF( CAST(JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.endTime) AS TIMESTAMP), CAST(JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.startTime) AS TIMESTAMP), MILLISECOND)/1000 AS INT64) AS run_seconds,

CAST(JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.totalProcessedBytes) AS INT64) AS totalProcessedBytes,

CAST(JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.totalSlotMs) AS INT64) AS totalSlotMs,

JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.referencedTables) AS tables_ref,

CAST(JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.totalTablesProcessed) AS INT64) AS totalTablesProcessed,

CAST(JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.queryOutputRowCount) AS INT64) AS queryOutputRowCount,

severity

FROM

`{{{ project_0.project_id | "Project ID" }}}.global._Default._AllLogs`

WHERE

log_id = "cloudaudit.googleapis.com/data_access"

AND proto_payload.audit_log.service_data.jobCompletedEvent IS NOT NULL

ORDER BY

startTime

Role pelos dois resultados e observe a coluna Consulta. Isso lista as consultas concluídas do BigQuery. Como as strings de consulta estão incluídas na consulta SQL, os resultados podem ser grandes.

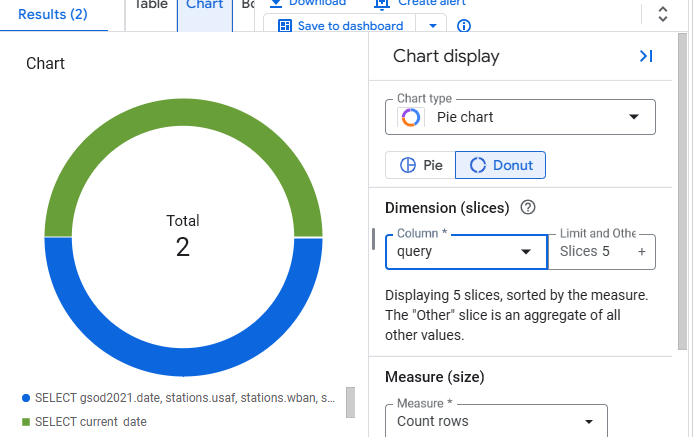

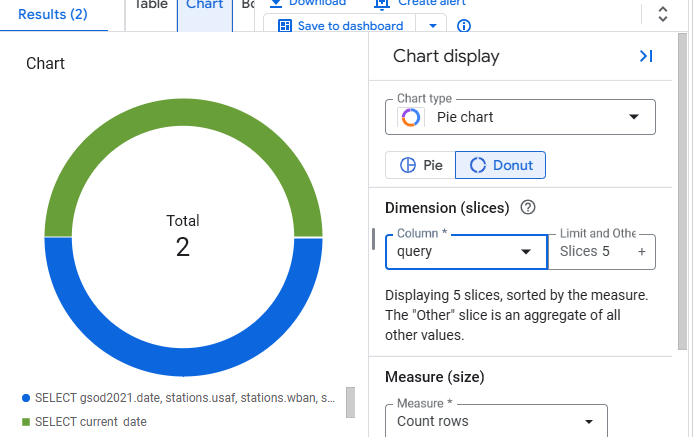

Tarefa 4: criar um gráfico

Em vez de usar uma tabela para ver os resultados, a Análise de Dados de Registros permite criar gráficos para a visualização dos resultados.

- Clique no botão Gráfico na visualização de resultados.

- Selecione Gráfico de pizza como o tipo de gráfico e Consulta como a coluna.

- O gráfico deve ficar assim:

Parabéns!

Agora você tem experiência prática em usar o Cloud Logging e a Análise de Dados de Registros para criar consultas, gerar gráficos de resultados e receber insights sobre o BigQuery.

Próximas etapas / Saiba mais

Treinamento e certificação do Google Cloud

Esses treinamentos ajudam você a aproveitar as tecnologias do Google Cloud ao máximo. Nossas aulas incluem habilidades técnicas e práticas recomendadas para ajudar você a alcançar rapidamente o nível esperado e continuar sua jornada de aprendizado. Oferecemos treinamentos que vão do nível básico ao avançado, com opções de aulas virtuais, sob demanda e por meio de transmissões ao vivo para que você possa encaixá-las na correria do seu dia a dia. As certificações validam sua experiência e comprovam suas habilidades com as tecnologias do Google Cloud.

Manual atualizado em 2 de maio de 2025

Laboratório testado em 2 de maio de 2025

Copyright 2025 Google LLC. Todos os direitos reservados. Google e o logotipo do Google são marcas registradas da Google LLC. Todos os outros nomes de produtos e empresas podem ser marcas registradas das respectivas empresas a que estão associados.

na parte de cima do console do Google Cloud.

na parte de cima do console do Google Cloud.