01

Google Cloud のハンズオンラボの概要

初回のこのハンズオンラボでは、Google Cloud コンソールにアクセスし、Google Cloud の基本機能(プロジェクト、リソース、IAM ユーザー、ロール、権限、API)を使用します。

すべてのデータ パイプラインには、データレイクとデータ ウェアハウスという 2 つの主要コンポーネントがあります。このコースでは、各ストレージ タイプのユースケースを紹介し、Google Cloud で利用可能なデータレイクとデータ ウェアハウスのソリューションを技術的に詳しく説明します。また、データ エンジニアの役割や、効果的なデータ パイプラインが事業運営にもたらすメリットについて確認し、クラウド環境でデータ エンジニアリングを行うべき理由を説明します。 これは「Data Engineering on Google Cloud」シリーズの最初のコースです。このコースを修了したら、「Building Batch Data Pipelines on Google Cloud」コースに登録してください。

通常、データ パイプラインは、「抽出、読み込み」、「抽出、読み込み、変換」、「抽出、変換、読み込み」のいずれかの枠組みに分類できます。このコースでは、バッチデータではどの枠組みを、どのような場合に使用するのかについて説明します。本コースではさらに、BigQuery、Dataproc 上での Spark の実行、Cloud Data Fusion のパイプラインのグラフ、Dataflow でのサーバーレスのデータ処理など、データ変換用の複数の Google Cloud テクノロジーについて説明します。受講者には、Qwiklabs を使用して Google Cloud でデータ パイプラインのコンポーネントを構築する実践演習を行っていただきます。

ストリーミングによって企業が事業運営に関するリアルタイムの指標を取得できるようになり、ストリーミング データの処理を行う機会が増えてきました。このコースでは、Google Cloud でストリーミング データ パイプラインを構築する方法について学習します。受信ストリーミング データの処理のための Pub/Sub について説明します。また、このコースでは、Dataflow を使用してストリーミング データを集計または変換する方法、処理済みのレコードを分析用に BigQuery や Cloud Bigtable に保存する方法についても説明します。そして、Qwiklabs を使用して Google Cloud でストリーミング データ パイプラインのコンポーネントを構築する実践演習を行います。

機械学習をデータ パイプラインに組み込むと、企業がデータから分析情報を抽出する能力を向上できます。このコースでは、必要なカスタマイズのレベルに応じて Google Cloud でデータ パイプラインに機械学習を含める複数の方法について説明します。カスタマイズをまったくしないか、またはほとんどしない場合については、AutoML を紹介します。よりカスタマイズされた機械学習機能については、Notebooks と BigQuery の機械学習(BigQuery ML)を紹介します。また、Kubeflow を使用して機械学習ソリューションを本番環境に導入する方法も説明します。受講者には、QwikLabs を使って、Google Cloud で機械学習モデルを構築する実習を行っていただきます。

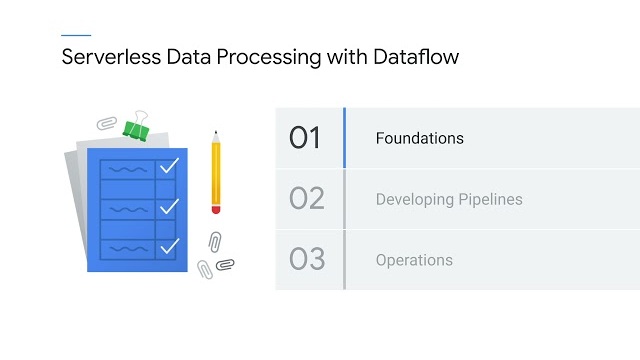

このコースは、Dataflow を使用したサーバーレスのデータ処理に関する 3 コースシリーズのパート 1 です。この最初のコースでは、始めに Apache Beam とは何か、そして Dataflow とどのように関係しているかを復習します。次に、Apache Beam のビジョンと Beam Portability フレームワークの利点について説明します。Beam Portability フレームワークによって、デベロッパーが好みのプログラミング言語と実行バックエンドを使用できるビジョンが実現します。続いて、Dataflow によってどのように費用を節約しながらコンピューティングとストレージを分離できるか、そして識別ツール、アクセスツール、管理ツールがどのように Dataflow パイプラインと相互に機能するかを紹介します。最後に、Dataflow でそれぞれのユースケースに合った適切なセキュリティ モデルを実装する方法について学習します。

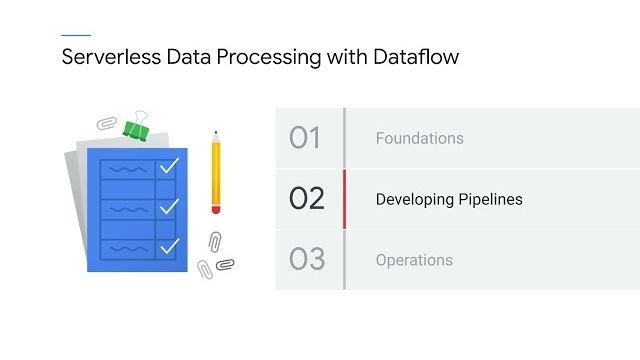

Dataflow コースシリーズの 2 回目である今回は、Beam SDK を使用したパイプラインの開発について詳しく説明します。まず、Apache Beam のコンセプトについて復習します。次に、ウィンドウ、ウォーターマーク、トリガーを使用したストリーミング データの処理について説明します。さらに、パイプラインのソースとシンクのオプション、構造化データを表現するためのスキーマ、State API と Timer API を使用してステートフル変換を行う方法について説明します。続いて、パイプラインのパフォーマンスを最大化するためのベスト プラクティスを再確認します。コースの終盤では、Beam でビジネス ロジックを表現するための SQL と DataFrame、および Beam ノートブックを使用してパイプラインを反復的に開発する方法を説明します。

Dataflow シリーズの最後のコースでは、Dataflow 運用モデルのコンポーネントを紹介します。パイプラインのパフォーマンスのトラブルシューティングと最適化に役立つツールと手法を検証した後で、Dataflow パイプラインのテスト、デプロイ、信頼性に関するベスト プラクティスについて確認します。最後に、数百人のユーザーがいる組織に対して Dataflow パイプラインを簡単に拡張するためのテンプレートについても確認します。これらの内容を習得することで、データ プラットフォームの安定性を保ち、予期せぬ状況に対する回復力を確保できるようになります。

Complete the introductory Prepare Data for ML APIs on Google Cloud skill badge to demonstrate skills in the following: cleaning data with Dataprep by Trifacta, running data pipelines in Dataflow, creating clusters and running Apache Spark jobs in Dataproc, and...

Complete the intermediate Build a Data Warehouse with BigQuery skill badge to demonstrate skills in the following: joining data to create new tables, troubleshooting joins, appending data with unions, creating date-partitioned tables, and working with JSON, arrays, and structs in...

Complete the intermediate Engineer Data for Predictive Modeling with BigQuery ML skill badge to demonstrate skills in the following: building data transformation pipelines to BigQuery using Dataprep by Trifacta; using Cloud Storage, Dataflow, and BigQuery to build extract, transform, and...

Complete the introductory Build a Data Mesh with Dataplex skill badge to demonstrate skills in the following: building a data mesh with Dataplex to facilitate data security, governance, and discovery on Google Cloud. You practice and test your skills in...