GSP1250

Übersicht

BigQuery bietet zwar integrierte Beobachtbarkeitsfunktionen wie die INFORMATION_SCHEMA-Ansichten, aber detaillierte Protokollierung ist nach wie vor entscheidend für eine eingehende Nutzungsanalyse, Audits und die Fehlerbehebung potenzieller Probleme. Wenn Sie Loganalysen aktivieren, können Sie Ihre Logdaten mit vertrauten SQL-Abfragen abfragen und analysieren und die Abfrageergebnisse dann anzeigen oder in einem Diagramm darstellen.

BigQuery ist das vollständig verwaltete Data Warehouse für Unternehmen von Google Cloud, mit dem Sie Ihre Daten mit integrierten Features wie Machine Learning, raumbezogenen Analysen und Business Intelligence verwalten und analysieren können.

In diesem Lab aktivieren Sie Loganalysen für Logs Storage-Buckets und sehen sich dann die BigQuery-Logs in Cloud Logging an. Außerdem verwenden Sie SQL, um die Logs mit Loganalysen zu analysieren.

Lernziele

Aufgaben in diesem Lab:

- Cloud Logging effektiv nutzen, um Informationen zur BigQuery-Nutzung zu erhalten

- SQL-Abfragen mit Loganalysen effektiv erstellen und ausführen

- Ergebnisse ansehen und grafisch darstellen

Einrichtung und Anforderungen

Vor dem Klick auf „Start Lab“ (Lab starten)

Lesen Sie diese Anleitung. Labs sind zeitlich begrenzt und können nicht pausiert werden. Der Timer beginnt zu laufen, wenn Sie auf Lab starten klicken, und zeigt Ihnen, wie lange Google Cloud-Ressourcen für das Lab verfügbar sind.

In diesem praxisorientierten Lab können Sie die Lab-Aktivitäten in einer echten Cloud-Umgebung durchführen – nicht in einer Simulations- oder Demo-Umgebung. Dazu erhalten Sie neue, temporäre Anmeldedaten, mit denen Sie für die Dauer des Labs auf Google Cloud zugreifen können.

Für dieses Lab benötigen Sie Folgendes:

- Einen Standardbrowser (empfohlen wird Chrome)

Hinweis: Nutzen Sie den privaten oder Inkognitomodus (empfohlen), um dieses Lab durchzuführen. So wird verhindert, dass es zu Konflikten zwischen Ihrem persönlichen Konto und dem Teilnehmerkonto kommt und zusätzliche Gebühren für Ihr persönliches Konto erhoben werden.

- Zeit für die Durchführung des Labs – denken Sie daran, dass Sie ein begonnenes Lab nicht unterbrechen können.

Hinweis: Verwenden Sie für dieses Lab nur das Teilnehmerkonto. Wenn Sie ein anderes Google Cloud-Konto verwenden, fallen dafür möglicherweise Kosten an.

Lab starten und bei der Google Cloud Console anmelden

-

Klicken Sie auf Lab starten. Wenn Sie für das Lab bezahlen müssen, wird ein Dialogfeld geöffnet, in dem Sie Ihre Zahlungsmethode auswählen können.

Auf der linken Seite befindet sich der Bereich „Details zum Lab“ mit diesen Informationen:

- Schaltfläche „Google Cloud Console öffnen“

- Restzeit

- Temporäre Anmeldedaten für das Lab

- Ggf. weitere Informationen für dieses Lab

-

Klicken Sie auf Google Cloud Console öffnen (oder klicken Sie mit der rechten Maustaste und wählen Sie Link in Inkognitofenster öffnen aus, wenn Sie Chrome verwenden).

Im Lab werden Ressourcen aktiviert. Anschließend wird ein weiterer Tab mit der Seite „Anmelden“ geöffnet.

Tipp: Ordnen Sie die Tabs nebeneinander in separaten Fenstern an.

Hinweis: Wird das Dialogfeld Konto auswählen angezeigt, klicken Sie auf Anderes Konto verwenden.

-

Kopieren Sie bei Bedarf den folgenden Nutzernamen und fügen Sie ihn in das Dialogfeld Anmelden ein.

{{{user_0.username | "Username"}}}

Sie finden den Nutzernamen auch im Bereich „Details zum Lab“.

-

Klicken Sie auf Weiter.

-

Kopieren Sie das folgende Passwort und fügen Sie es in das Dialogfeld Willkommen ein.

{{{user_0.password | "Password"}}}

Sie finden das Passwort auch im Bereich „Details zum Lab“.

-

Klicken Sie auf Weiter.

Wichtig: Sie müssen die für das Lab bereitgestellten Anmeldedaten verwenden. Nutzen Sie nicht die Anmeldedaten Ihres Google Cloud-Kontos.

Hinweis: Wenn Sie Ihr eigenes Google Cloud-Konto für dieses Lab nutzen, können zusätzliche Kosten anfallen.

-

Klicken Sie sich durch die nachfolgenden Seiten:

- Akzeptieren Sie die Nutzungsbedingungen.

- Fügen Sie keine Wiederherstellungsoptionen oder Zwei-Faktor-Authentifizierung hinzu (da dies nur ein temporäres Konto ist).

- Melden Sie sich nicht für kostenlose Testversionen an.

Nach wenigen Augenblicken wird die Google Cloud Console in diesem Tab geöffnet.

Hinweis: Wenn Sie auf Google Cloud-Produkte und ‑Dienste zugreifen möchten, klicken Sie auf das Navigationsmenü oder geben Sie den Namen des Produkts oder Dienstes in das Feld Suchen ein.

Cloud Shell aktivieren

Cloud Shell ist eine virtuelle Maschine, auf der Entwicklertools installiert sind. Sie bietet ein Basisverzeichnis mit 5 GB nichtflüchtigem Speicher und läuft auf Google Cloud. Mit Cloud Shell erhalten Sie Befehlszeilenzugriff auf Ihre Google Cloud-Ressourcen.

-

Klicken Sie oben in der Google Cloud Console auf Cloud Shell aktivieren  .

.

-

Klicken Sie sich durch die folgenden Fenster:

- Fahren Sie mit dem Informationsfenster zu Cloud Shell fort.

- Autorisieren Sie Cloud Shell, Ihre Anmeldedaten für Google Cloud API-Aufrufe zu verwenden.

Wenn eine Verbindung besteht, sind Sie bereits authentifiziert und das Projekt ist auf Project_ID, eingestellt. Die Ausgabe enthält eine Zeile, in der die Project_ID für diese Sitzung angegeben ist:

Ihr Cloud-Projekt in dieser Sitzung ist festgelegt als {{{project_0.project_id | "PROJECT_ID"}}}

gcloud ist das Befehlszeilentool für Google Cloud. Das Tool ist in Cloud Shell vorinstalliert und unterstützt die Tab-Vervollständigung.

- (Optional) Sie können den aktiven Kontonamen mit diesem Befehl auflisten:

gcloud auth list

- Klicken Sie auf Autorisieren.

Ausgabe:

ACTIVE: *

ACCOUNT: {{{user_0.username | "ACCOUNT"}}}

Um das aktive Konto festzulegen, führen Sie diesen Befehl aus:

$ gcloud config set account `ACCOUNT`

- (Optional) Sie können die Projekt-ID mit diesem Befehl auflisten:

gcloud config list project

Ausgabe:

[core]

project = {{{project_0.project_id | "PROJECT_ID"}}}

Hinweis: Die vollständige Dokumentation für gcloud finden Sie in Google Cloud in der Übersicht zur gcloud CLI.

Aufgabe 1: Log-Buckets konfigurieren

In dieser Aufgabe konfigurieren Sie Cloud Logging, um ein Upgrade für die vorhandenen Log-Buckets mit aktivierten Loganalysen durchzuführen.

So führen Sie ein Upgrade vorhandener Buckets durch, um Loganalysen zu verwenden:

- Geben Sie in der Titelleiste der Google Cloud Console Logspeicher in das Suchfeld ein und klicken Sie in den Suchergebnissen auf Logspeicher.

Die Seite „Logspeicher“ wird geöffnet. In der Liste Log-Buckets sind zwei Buckets aufgeführt: _Default und _Required.

- Klicken Sie für den Log-Bucket _Required unter der Spalte Loganalysen verfügbar auf Upgrade.

- Klicken Sie noch einmal auf Upgrade, um das Upgrade zur Verwendung von Loganalysen zu bestätigen.

- Wiederholen Sie diesen Schritt für den Log-Bucket _Default. Klicken Sie unter der Spalte Loganalysen verfügbar auf Upgrade.

- Klicken Sie noch einmal auf Upgrade, um das Upgrade zur Verwendung von Loganalysen zu bestätigen.

Klicken Sie auf Fortschritt prüfen.

Log-Buckets upgraden

Aufgabe 2: BigQuery-Aktivitäten ausführen

In dieser Aufgabe generieren Sie BigQuery-Logs. Dazu verwenden Sie das BigQuery-Befehlszeilentool bq.

- Geben Sie in Cloud Shell den Befehl

bq mk ein, um in Ihrem Projekt die neuen Datasets bq_logs und bq_logs_test zu erstellen:

bq mk bq_logs

bq mk bq_logs_test

- Geben Sie den Befehl

bq ls ein, um die Datasets aufzulisten:

bq ls

- Geben Sie den Befehl

bq rm ein, um ein Dataset zu löschen (wählen Sie „Y“ aus, wenn Sie dazu aufgefordert werden):

bq rm bq_logs_test

- Erstellen Sie eine neue Tabelle:

bq mk \

--table \

--expiration 3600 \

--description "This is a test table" \

bq_logs.test_table \

id:STRING,name:STRING,address:STRING

Sie sollten eine Erfolgsmeldung sehen, dass eine neue leere Tabelle mit dem Namen test_table für Ihr Dataset erstellt wurde.

Führen Sie nun einige Abfragen aus, um Logs zu generieren.

- Geben Sie die folgende Abfrage in Cloud Shell ein:

bq query --use_legacy_sql=false 'SELECT current_date'

- Kopieren Sie den folgenden Befehl in Cloud Shell:

bq query --use_legacy_sql=false \

'SELECT

gsod2021.date,

stations.usaf,

stations.wban,

stations.name,

stations.country,

stations.state,

stations.lat,

stations.lon,

stations.elev,

gsod2021.temp,

gsod2021.max,

gsod2021.min,

gsod2021.mxpsd,

gsod2021.gust,

gsod2021.fog,

gsod2021.hail

FROM

`bigquery-public-data.noaa_gsod.gsod2021` gsod2021

INNER JOIN

`bigquery-public-data.noaa_gsod.stations` stations

ON

gsod2021.stn = stations.usaf

AND gsod2021.wban = stations.wban

WHERE

stations.country = "US"

AND gsod2021.date = "2021-12-15"

AND stations.state IS NOT NULL

AND gsod2021.max != 9999.9

ORDER BY

gsod2021.min;'

(Diese Abfrage verwendet Wetterdaten der National Oceanic and Atmospheric Administration (NOAA).)

Klicken Sie auf Fortschritt prüfen.

BigQuery-Aktivitäten ausführen

Aufgabe 3: Loganalyse durchführen

In dieser Aufgabe werden die Logdaten analysiert, die Sie in der vorherigen Aufgabe erstellt haben.

Herausforderung (optional): Können Sie das Ergebnis vorhersagen, bevor Sie eine Abfrage ausführen?

Abfrage für einen bestimmten Vorgang

Eine häufige Aufgabe bei der Analyse der BigQuery-Nutzung ist die Suche nach bestimmten Vorgängen für Ihre Datasets. In dieser Aufgabe fragen Sie die Erstellungs- und Löschvorgänge ab.

-

Klicken Sie im linken Bereich auf Loganalysen und suchen Sie im Abschnitt Loganalysen das Feld Abfrage.

-

Geben oder fügen Sie die folgende Abfrage in das Feld Abfrage ein und klicken Sie auf Abfrage ausführen, um die erstellten und gelöschten Vorgänge zu finden:

SELECT

timestamp,

severity,

resource.type,

proto_payload.audit_log.authentication_info.principal_email,

proto_payload.audit_log.method_name,

proto_payload.audit_log.resource_name,

FROM

`{{{ project_0.project_id | "Project ID" }}}.global._Required._AllLogs`

WHERE

log_id = 'cloudaudit.googleapis.com/activity'

AND proto_payload.audit_log.method_name LIKE 'datasetservice%'

LIMIT

100

Ihre Abfrage sollte drei Ergebnisse liefern.

Sie können die Suche auch mit genaueren Angaben einschränken, z. B. method_name = 'datasetservice.delete'.

Abfrage für Vorgänge für BigQuery-Tabellen

- Wenn Sie die Vorgänge für BigQuery-Tabellen finden möchten, ändern Sie die Abfragebedingung für Tabellendienste. Führen Sie diese Abfrage aus, um Vorgänge für Tabellen zu finden, die erstellt oder gelöscht wurden:

SELECT

timestamp,

severity,

resource.type,

proto_payload.audit_log.authentication_info.principal_email,

proto_payload.audit_log.method_name,

proto_payload.audit_log.resource_name,

FROM

`{{{ project_0.project_id | "Project ID" }}}.global._Required._AllLogs`

WHERE

log_id = 'cloudaudit.googleapis.com/activity'

AND proto_payload.audit_log.method_name LIKE '%TableService%'

LIMIT

100

Diese Abfrage gibt ein Ergebnis aus.

- Suchen Sie im Log

data_access nach jobCompletedEvent, um abgeschlossene BigQuery-Abfragen aufzurufen. Führen Sie beispielsweise die folgende SQL-Abfrage aus:

SELECT

timestamp,

resource.labels.project_id,

proto_payload.audit_log.authentication_info.principal_email,

JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobConfiguration.query.query) AS query,

JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobConfiguration.query.statementType) AS statementType,

JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatus.error.message) AS message,

JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.startTime) AS startTime,

JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.endTime) AS endTime,

CAST(TIMESTAMP_DIFF( CAST(JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.endTime) AS TIMESTAMP), CAST(JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.startTime) AS TIMESTAMP), MILLISECOND)/1000 AS INT64) AS run_seconds,

CAST(JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.totalProcessedBytes) AS INT64) AS totalProcessedBytes,

CAST(JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.totalSlotMs) AS INT64) AS totalSlotMs,

JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.referencedTables) AS tables_ref,

CAST(JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.totalTablesProcessed) AS INT64) AS totalTablesProcessed,

CAST(JSON_VALUE(proto_payload.audit_log.service_data.jobCompletedEvent.job.jobStatistics.queryOutputRowCount) AS INT64) AS queryOutputRowCount,

severity

FROM

`{{{ project_0.project_id | "Project ID" }}}.global._Default._AllLogs`

WHERE

log_id = "cloudaudit.googleapis.com/data_access"

AND proto_payload.audit_log.service_data.jobCompletedEvent IS NOT NULL

ORDER BY

startTime

Scrollen Sie durch die beiden Ergebnisse und sehen Sie sich die Spalte Abfrage an. Hier werden die abgeschlossenen BigQuery-Abfragen aufgelistet. Da die Abfragestrings in der SQL-Abfrage enthalten sind, können die Ergebnisse umfangreich sein.

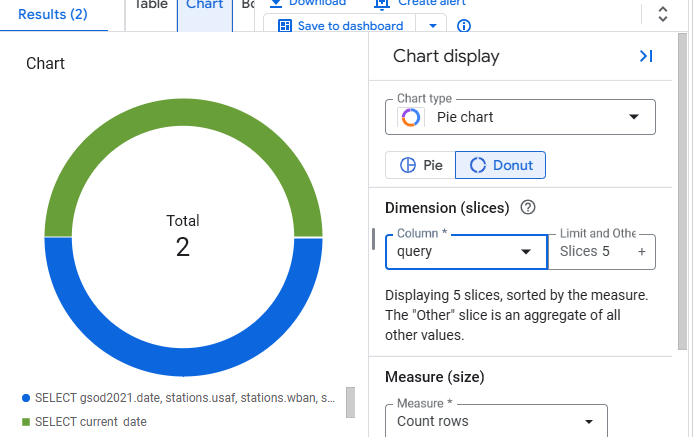

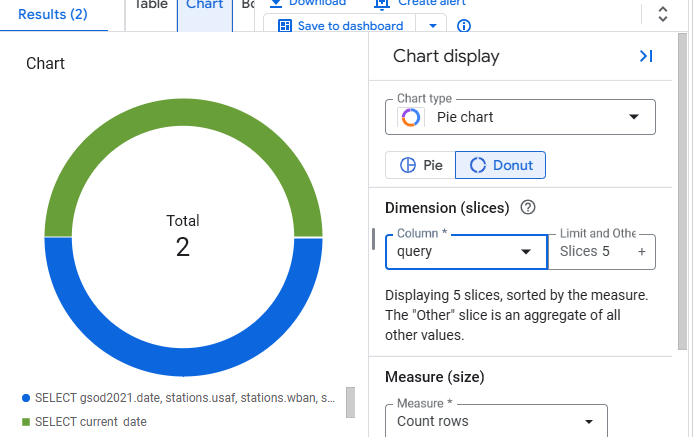

Aufgabe 4: Diagramm erstellen

Anstatt die Ergebnisse in einer Tabelle anzuzeigen, können Sie in Loganalysen Diagramme zur Visualisierung erstellen.

- Klicken Sie in der Ergebnisansicht auf die Schaltfläche Diagramm.

- Wählen Sie Kreisdiagramm als Diagrammtyp und Abfrage als Spalte aus.

- Das Diagramm sollte in etwa so aussehen:

Das wars! Sie haben das Lab erfolgreich abgeschlossen.

Sie haben nun praktische Erfahrung mit Cloud Logging und Loganalysen gesammelt, um Abfragen zu erstellen, Ergebnisse grafisch darzustellen und Einblicke in die BigQuery-Nutzung zu erhalten.

Weitere Informationen

- Dokumentation zu Loganalysen

- Mehr über das Visualisieren von Loganalysen-Ergebnissen finden Sie in der Dokumentation zu Diagrammen

Google Cloud-Schulungen und -Zertifizierungen

In unseren Schulungen erfahren Sie alles zum optimalen Einsatz unserer Google Cloud-Technologien und können sich entsprechend zertifizieren lassen. Unsere Kurse vermitteln technische Fähigkeiten und Best Practices, damit Sie möglichst schnell mit Google Cloud loslegen und Ihr Wissen fortlaufend erweitern können. Wir bieten On-Demand-, Präsenz- und virtuelle Schulungen für Anfänger wie Fortgeschrittene an, die Sie individuell in Ihrem eigenen Zeitplan absolvieren können. Mit unseren Zertifizierungen weisen Sie nach, dass Sie Experte im Bereich Google Cloud-Technologien sind.

Anleitung zuletzt am 2. Mai 2025 aktualisiert

Lab zuletzt am 2. Mai 2025 getestet

© 2025 Google LLC. Alle Rechte vorbehalten. Google und das Google-Logo sind Marken von Google LLC. Alle anderen Unternehmens- und Produktnamen können Marken der jeweils mit ihnen verbundenen Unternehmen sein.

.

.