Puntos de control

Create and use an external table

/ 60

Import data via the console

/ 40

Explora un lakehouse

IMPORTANTE:

IMPORTANTE: Asegúrate de completar este lab práctico únicamente en una computadora de escritorio o laptop.

Asegúrate de completar este lab práctico únicamente en una computadora de escritorio o laptop. Se permiten solo 5 intentos por lab.

Se permiten solo 5 intentos por lab. A modo de recordatorio, es habitual no responder de forma correcta a todas las preguntas en el primer intento o incluso tener que volver a realizar una tarea; esto forma parte del proceso de aprendizaje.

A modo de recordatorio, es habitual no responder de forma correcta a todas las preguntas en el primer intento o incluso tener que volver a realizar una tarea; esto forma parte del proceso de aprendizaje. Una vez comenzado el lab, no se puede detener el cronómetro. Después de 1 hora y 30 minutos, el lab terminará y tendrás que volver a empezar.

Una vez comenzado el lab, no se puede detener el cronómetro. Después de 1 hora y 30 minutos, el lab terminará y tendrás que volver a empezar. Para obtener más información, consulta la lectura Sugerencias técnicas para el lab.

Para obtener más información, consulta la lectura Sugerencias técnicas para el lab.

Resumen de la actividad

Los analistas de datos en la nube suelen trabajar con tres arquitecturas principales de datos: data lakes, almacenes de datos y lakehouses.

Los data lakes son sistemas de bases de datos en los que se almacenan grandes cantidades de datos sin procesar en su formato original hasta que son necesarios. Un principio básico es recopilar datos primero y decidir después qué es útil.

Los almacenes de datos son bases de datos en las que se consolidan datos de múltiples sistemas de origen para brindar coherencia, exactitud y acceso eficaz a los datos. Un principio básico es seleccionar y organizar datos que se sabe que son útiles y confiables.

Los lakehouses son arquitecturas de datos híbridas en las que se combinan las funciones de los data lakes con las de los almacenes de datos.

Cloud Storage es una excelente herramienta para trabajar con data lakes. BigQuery puede configurarse como almacén de datos, data lake o lakehouse.

En este ejercicio, combinarás datos almacenados en un data lake de Cloud Storage con datos almacenados en un almacén de datos de BigQuery para obtener más información sobre cómo integrar datos de diferentes fuentes y almacenarlos de una forma que optimice el análisis. Luego, explorarás esa arquitectura híbrida para conocer cómo funcionan los lakehouses.

Situación

Eres analista de datos en la nube en el comercio electrónico TheLook, una empresa global de ropa que se especializa en moda innovadora y aprovisionamiento sustentable y ético.

Marta, la jefa de Distribución de Productos, te pidió ayuda para completar una serie de tareas para comprender qué productos se venden y cuáles se devuelven, y garantizar que los costos de todos los productos estén actualizados.

Para hacerlo, debes combinar datos de un data lake y un almacén de datos, y usar BigQuery como lakehouse. Puedes usar esa arquitectura híbrida para encontrar datos que respondan las preguntas de negocios de Maribel.

Después de recibir la tarea de Marta, le pides un poco de ayuda a Arturo, el arquitecto de datos.

Arturo te explica que una tabla externa solo apunta a datos almacenados en otro sitio, como un data lake. Para este caso, piensas que lo mejor sería que los datos se almacenaran en una tabla de BigQuery estándar porque será más fácil de administrar y actualizar.

Marta también te pidió que importes datos de un archivo CSV para actualizar los costos de productos, así que le preguntas a Arturo si también deberías usar una tabla externa para hacerlo.

Arturo te explica que, si bien una tabla externa solo apunta a datos que están almacenados en otro sitio, como un data lake, en este caso lo mejor es almacenar los datos en una tabla de BigQuery estándar, ya que será más fácil administrarla y actualizarla.

Le das las gracias a Arturo, y ya tienes todo listo para completar las tareas de Marta.

A continuación, se detalla cómo harás esta tarea. Primero, crearás una tabla externa que apunte a datos almacenados en un data lake. Luego, unirás la tabla externa con una tabla de BigQuery estándar y explorarás los datos combinados. Por último, importarás datos de un archivo CSV a una tabla de BigQuery estándar para comprender mejor la diferencia entre tablas externas y estándares en BigQuery.

Configuración

Antes de hacer clic en Comenzar lab

Lee estas instrucciones. Los labs son cronometrados y no se pueden pausar. El cronómetro, que comienza a funcionar cuando haces clic en Comenzar lab, indica por cuánto tiempo tendrás a tu disposición los recursos de Google Cloud.

En este lab práctico, puedes realizar las actividades por tu cuenta en un entorno de nube real, en lugar de una simulación o un entorno de demostración. Para ello, se te proporcionan credenciales temporales nuevas que usarás para acceder a Google Cloud durante todo el lab.

Para completar este lab, necesitarás lo siguiente:

- Acceso a un navegador de Internet estándar (se recomienda el navegador Chrome)

- Tiempo para completar el lab: Recuerda que, una vez que comienzas un lab, no puedes pausarlo.

Cómo iniciar tu lab y acceder a la consola de Google Cloud

-

Haz clic en el botón Comenzar lab. A la izquierda, se encuentra el panel Detalles del lab, que tiene estos elementos:

- Tiempo restante

- El botón Abrir la consola de Google

- Las credenciales temporales que debes usar para el lab

- Otra información para completar el lab, si es necesaria

Nota: Si debes pagar por el lab, se abrirá una ventana emergente para que selecciones tu forma de pago. -

Haz clic en Abrir la consola de Google (o haz clic con el botón derecho y selecciona Abrir el vínculo en una ventana de incógnito) si ejecutas el navegador Chrome. La página Acceder se abre en una pestaña del navegador nueva.

Sugerencia: Puedes organizar las pestañas de manera independiente (una ventana al lado de la otra) para alternar fácilmente entre ellas.

Nota: Si aparece el diálogo Elige una cuenta, haz clic en Usar otra cuenta. -

Si es necesario, copia el nombre de usuario de Google Cloud a continuación, y pégalo en el diálogo Ingresar. Haz clic en Siguiente.

También puedes encontrar el nombre de usuario de Google Cloud en el panel Detalles del lab.

- Copia la contraseña de Google Cloud a continuación y pégala en el diálogo te damos la bienvenida. Haz clic en Siguiente.

También puedes encontrar la contraseña de Google Cloud en el panel Detalles del lab.

- Haz clic para avanzar por las páginas siguientes:

- Acepta los Términos y Condiciones.

- No agregues opciones de recuperación o autenticación de dos factores (esta es una cuenta temporal).

- No te registres para las pruebas gratuitas.

Después de un momento, se abrirá la consola de Cloud en esta pestaña.

Tarea 1: Crea y usa una tabla externa

Después de analizar preliminarmente los datos, a Marta le preocupa que haya demasiadas devoluciones de pares de vaqueros. Para comprender mejor la situación y detectar cuáles son los centros de distribución con la mayor cantidad de devoluciones, Marta te pidió crear un informe en el que se detalle cuántas devoluciones de vaqueros se hicieron en cada uno de los centros de distribución. La información de las devoluciones se almacena como data lake con Cloud Storage. La información de distribución se almacena como almacén de datos en una tabla estándar de BigQuery.

En esta tarea, crearás una tabla externa que apunte a los datos almacenados en Cloud Storage y, luego, unirás esa tabla con la tabla estándar de BigQuery. De esa forma, se combinarán datos de un data lake y un almacén de datos. Luego, consultarás los datos combinados para obtener los resultados que necesita Marta.

- En el menú de navegación (

) de la consola de Cloud, selecciona BigQuery.

- En el Editor de consultas, haz clic en el ícono Redactar consulta nueva (+). Se abrirá la pestaña Sin título.

En la siguiente consulta, observa el tipo de archivo. Parquet es un formato popular de datos de cadenas en análisis de datos de la nube y se usa con frecuencia para crear tablas externas en BigQuery. Como los archivos Parquet están comprimidos, ocupan menos espacio de almacenamiento. También son fáciles de administrar, ya que los esquemas de datos se almacenan dentro del mismo archivo.

- Copia el siguiente comando y pégalo en la pestaña Sin título:

CREATE OR REPLACE EXTERNAL TABLE `thelook_gcda.product_returns` OPTIONS ( format ="PARQUET", uris = ['gs://sureskills-lab-dev/DAC2M2L4/returns/returns_*.parquet'] );

Cuando creas una tabla externa en BigQuery, creas una tabla que apunta a datos almacenados en una ubicación externa, como Cloud Storage. Los tipos de datos de las columnas en la tabla externa se inferirán de los datos en la ubicación externa.

- Haz clic en Ejecutar.

Ahora consulta las propiedades de la tabla que acabas de crear.

-

En el panel Explorador, expande la lista de conjuntos de datos haciendo clic en la flecha desplegable junto al ID del proyecto.

-

Haz clic en la flecha desplegable junto al conjunto de datos thelook_gcda.

-

Selecciona la tabla product_returns. Actualiza la página si todavía no aparece.

-

Haz clic en la pestaña Detalles y analiza los detalles en la sección Configuración de datos externos.

-

Observa la columna URI de origen y el puntero hacia gs://. En la IU de BigQuery, la columna URI de origen muestra la ubicación de la fuente de datos de una tabla. El prefijo gs:// en la columna URI de origen indica que los datos se almacenan en Cloud Storage. Cuando creas una tabla externa, los datos se almacenan en la ubicación de origen en Cloud Storage, pero se pueden realizar consultas allí como en cualquier tabla de BigQuery estándar.

-

Copia la siguiente consulta en el Editor de consultas:

Nota: Cada vez que ejecutes una nueva consulta en el Editor de consultas, puedes reemplazar la anterior copiando y pegando la consulta nueva en la misma pestaña Sin título o puedes hacer clic en el ícono Redactar una nueva consulta (+) para abrir una nueva pestaña Sin título y ejecutarla. SELECT COUNT(*) AS row_count FROM `thelook_gcda.product_returns`;

Esta consulta devuelve un conteo de 20,000 filas.

- Haz clic en Ejecutar.

Luego, consulta las propiedades de la tabla distribution_centers.

-

En el panel Explorador, en el conjunto de datos thelook_gcda, selecciona la tabla distribution_centers.

-

Haz clic en la pestaña Detalles y estudia los detalles en las secciones Información de la tabla e Información de almacenamiento. No es una tabla externa porque no se hace referencia a archivos externos.

Ahora consulta los datos de la tabla product_returns que creaste en los pasos anteriores.

-

Copia la siguiente consulta en el Editor de consultas:

SELECT * FROM `thelook_gcda.product_returns` ORDER BY status_date desc LIMIT 10;

La consulta muestra las 10 devoluciones más recientes de productos según la fecha de estado de devolución.

-

Haz clic en Ejecutar.

-

Copia la siguiente consulta en el Editor de consultas:

SELECT dc.name, pr.* FROM `thelook_gcda.product_returns` AS pr INNER JOIN `thelook_gcda.distribution_centers` AS dc ON dc.id = pr.distribution_center_id;

Esa consulta une datos de un bucket de Cloud Storage (product_returns) con datos almacenados en BigQuery (una tabla estándar, distribution_centers) y devuelve el nombre del centro de distribución (distribution_centers.name) junto con todas las columnas de los datos de devoluciones en el archivo Parquet.

-

Haz clic en Ejecutar.

-

Copia la siguiente consulta en el Editor de consultas:

SELECT dc.name AS distribution_center, p.category, COUNT(*) AS product_return_count FROM `thelook_gcda.product_returns` AS pr INNER JOIN `thelook_gcda.distribution_centers` AS dc ON dc.id = pr.distribution_center_id INNER JOIN `thelook_gcda.products` p ON p.id = pr.product_id WHERE p.category = "Jeans" GROUP BY dc.name, p.category;

Esta consulta genera la información que solicitó Marta. Muestra el nombre del centro de distribución (distribution_centers.name) y la cantidad de productos que se devolvieron en la categoría de vaqueros (product.category).

- Haz clic en Ejecutar.

Haz clic en Revisar mi progreso para verificar que completaste esta tarea correctamente.

Tarea 2: Importa datos por medio de la consola (de BigQuery Studio)

Un fabricante clave envió una lista de nombres del producto y costos actualizados de productos. Marta necesita que se actualicen esos datos para reflejar los costos nuevos y asegurarse de tener la información más actualizada en sus informes.

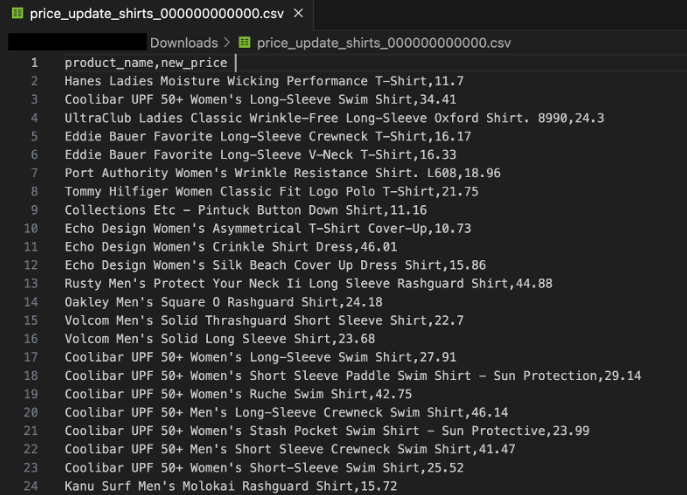

El fabricante envió la lista en formato CSV y el equipo de asistencia técnica la copió en un bucket de Cloud Storage. El equipo también envió una captura de pantalla del archivo para que tengas una idea de lo que debería incluirse:

El archivo se encuentra en el bucket de Cloud Storage “sureskills-lab-dev”, en la carpeta price_update. En esta tarea, importarás los datos al conjunto de datos thelook_gcda.

- En la barra Explorador, haz clic en + AGREGAR para agregar una fuente de datos al proyecto.

- Selecciona Google Cloud Storage.

- En Seleccionar archivo del bucket de GCS, escribe sureskills-lab-dev/DAC2M2L4/price_update/price_update_shirts.csv.

- En Formato de archivo, selecciona CSV.

- En la sección Destino, en Conjunto de datos, selecciona thelook_gcda.

- En el campo Tabla, escribe shirt_price_update

- Verifica que el campo Tipo de tabla esté configurado como Tabla nativa. Esta opción indica que BigQuery copiará el contenido del archivo CSV del bucket de Cloud Storage en su propio almacenamiento.

- En Esquema, marca Detección automática. BigQuery intentará averiguar cuáles son los tipos de datos revisando los valores de cada columna.

- Haz clic en Crear tabla.

Haz clic en Revisar mi progreso para verificar que completaste esta tarea correctamente.

Conclusión

¡Muy bien!

Ayudaste a Marta a obtener más información sobre las devoluciones y ventas de productos, y actualizar los costos de productos. Le diste la información que necesita para completar sus informes y comprender mejor la línea de productos del comercio electrónico TheLook.

También adquiriste experiencia práctica en la combinación de datos almacenados en un data lake de Cloud Storage con datos almacenados en un almacén de datos de BigQuery. De esta manera, aprendiste a integrar datos de diferentes fuentes y a almacenarlos de forma optimizada para realizar análisis. También exploraste el funcionamiento de esta arquitectura híbrida.

Por último, importaste datos de un archivo CSV a una tabla de BigQuery estándar, lo que te ayudó a conocer las distintas formas en las que puedes trabajar y almacenar datos de varias fuentes en BigQuery.

Estás en buen camino para comprender cómo usar data lakehouses y combinar datos en Cloud Storage con BigQuery.

Ejemplos de diferencias entre tablas estándares y tablas externas:

| Tabla estándar | Tabla externa | |

|---|---|---|

| Dónde se encuentran los datos | “Dentro” de BigQuery. | “Fuera” de BigQuery, en Cloud Storage. |

| Archivos externos de instrucciones CREATE TABLE (DDL) | No hay referencias a archivos externos. | Se debe incluir una referencia a archivos externos. |

| Formato de archivo para instrucciones CREATE TABLE | No hay referencias a formatos de archivo como CSV o Parquet. | Se debe especificar el tipo de archivo externo al que se hace referencia. |

| Formato de almacenamiento de datos | Un formato interno específico de BigQuery denominado Capacitor. | Se admiten varios formatos, incluidos CSV, Parquet, Iceberg y Avro. |

| Rendimiento | Alto | Puede ser alto (según factores como el tamaño de los datos, el formato de archivo y la estructura de partición) |

| Ejemplo de instrucción CREATE TABLE | CREATE TABLE thelook_gcda.products (Product_id INT, Product_name STRING, Active BOOLEAN); | CREATE EXTERNAL TABLE thelook_gcda.product_returns OPTIONS (format="PARQUET", uris = ['gs://sureskills-lab-dev/DAC2M2L4/returns/returns_*.parquet']); |

Hay diferencias técnicas, funciones y limitaciones adicionales de esos dos tipos de tablas que no se abordan en este lab. Para obtener más información, busca en Google "tipos de tablas de BigQuery" o consulta la Introducción a las tablas en la documentación.

Finaliza el lab

Antes de que finalices el lab, asegúrate de estar conforme con la forma en que completaste todas las tareas. Cuando estés conforme, haz clic en Finalizar Lab y luego haz clic en Enviar.

Finalizar el lab te quitará el acceso al entorno del lab y no podrás volver a acceder al trabajo que completaste.

Copyright 2024 Google LLC. Todos los derechos reservados. Google y el logotipo de Google son marcas de Google LLC. El resto de los nombres de productos y empresas pueden ser marcas de las respectivas empresas a las que están asociados.