概要

このラボでは、Cymbal Superstore のデータ サイエンティストとして作業します。新規顧客を特定、分類、開拓するための支援をマーケティング チームから依頼されたという設定です。リーダーチームの依頼に応じ、注文行動に基づいて顧客を 5 つのグループに分類し、各グループに関する記述統計を生成する必要があります。それに加えて、マーケティング チームが各グループに対して実行できる次のステップもいくつか提示します。

このような新規顧客を特定するため、Gemini、Vertex AI、BigQuery を使用して e コマースデータで k 平均法クラスタリング モデルを作成、可視化、要約し、マーケティング キャンペーンに役立つ次のステップを示します。このラボは、あらゆる経験レベルのデータ サイエンティストを対象としています。

環境の構成はすでに完了しています。この構成には、Gemini 用の Cloud AI Companion を有効にし、Gemini を使用するのに必要なロールを IAM に付与することが含まれます。詳細については、Gemini for Google Cloud の概要をご覧ください。

注: Duet AI は、Google の次世代モデルである Gemini に名称変更されました。このラボは、この変更を反映して更新されたものです。ラボの手順を実施する際に、ユーザー インターフェースやドキュメントで Duet AI に言及されていた場合は、Gemini と同等であると見なしてください。

注: Gemini は初期段階のテクノロジーであるため、もっともらしく見える出力でも事実に反する場合があります。Gemini からのすべての出力は、使用する前に検証することをおすすめします。詳細については、Gemini for Google Cloud と責任ある AI をご覧ください。

目標

このラボでは、次のタスクの実行方法について学びます。

- BigQuery Studio 内で Colab Enterprise Python ノートブックを使用する。

- BigQuery Studio 内で BigQuery DataFrames を使用する。

- Gemini を使用して、自然言語プロンプトからコードを生成する。

- k 平均法クラスタリング モデルを構築する。

- クラスタの可視化を生成する。

- Gemini Pro モデルを使用して、マーケティング キャンペーンの次のステップを開発する。

- プロジェクト リソースをクリーンアップする。

設定と要件

[ラボを開始] ボタンをクリックする前に

こちらの説明をお読みください。ラボには時間制限があり、一時停止することはできません。タイマーは Google Cloud のリソースを利用できる時間を示しており、[ラボを開始] をクリックするとスタートします。

このハンズオンラボでは、シミュレーションやデモ環境ではなく実際のクラウド環境を使って、ご自身でラボのアクティビティを行います。そのため、ラボの受講中に Google Cloud にログインおよびアクセスするための、新しい一時的な認証情報が提供されます。

このラボを完了するためには、以下のものが必要です。

- 標準的なインターネット ブラウザ(Chrome を推奨)

注: このラボの実行には、シークレット モードまたはシークレット ブラウジング ウィンドウを使用してください。これにより、個人アカウントと受講者アカウント間の競合を防ぎ、個人アカウントに追加料金が発生しないようにすることができます。

- ラボを完了するための時間(開始後は一時停止できません)

注: すでに個人の Google Cloud アカウントやプロジェクトをお持ちの場合でも、このラボでは使用しないでください。アカウントへの追加料金が発生する可能性があります。

ラボを開始して Google Cloud コンソールにログインする方法

-

[ラボを開始] ボタンをクリックします。ラボの料金をお支払いいただく必要がある場合は、表示されるポップアップでお支払い方法を選択してください。

左側の [ラボの詳細] パネルには、以下が表示されます。

- [Google Cloud コンソールを開く] ボタン

- 残り時間

- このラボで使用する必要がある一時的な認証情報

- このラボを行うために必要なその他の情報(ある場合)

-

[Google Cloud コンソールを開く] をクリックします(Chrome ブラウザを使用している場合は、右クリックして [シークレット ウィンドウで開く] を選択します)。

ラボでリソースがスピンアップし、別のタブで [ログイン] ページが表示されます。

ヒント: タブをそれぞれ別のウィンドウで開き、並べて表示しておきましょう。

注: [アカウントの選択] ダイアログが表示されたら、[別のアカウントを使用] をクリックします。

-

必要に応じて、下のユーザー名をコピーして、[ログイン] ダイアログに貼り付けます。

{{{user_0.username | "Username"}}}

[ラボの詳細] パネルでもユーザー名を確認できます。

-

[次へ] をクリックします。

-

以下のパスワードをコピーして、[ようこそ] ダイアログに貼り付けます。

{{{user_0.password | "Password"}}}

[ラボの詳細] パネルでもパスワードを確認できます。

-

[次へ] をクリックします。

重要: ラボで提供された認証情報を使用する必要があります。Google Cloud アカウントの認証情報は使用しないでください。

注: このラボでご自身の Google Cloud アカウントを使用すると、追加料金が発生する場合があります。

-

その後次のように進みます。

- 利用規約に同意します。

- 一時的なアカウントなので、復元オプションや 2 要素認証プロセスは設定しないでください。

- 無料トライアルには登録しないでください。

その後、このタブで Google Cloud コンソールが開きます。

注: Google Cloud のプロダクトやサービスのリストを含むメニューを表示するには、左上のナビゲーション メニューをクリックします。

タスク 1. プロジェクト用の BigQuery データセットを作成する

このタスクでは、BigQuery で e コマース データセットを作成します。このデータセットは、このラボで分類する e コマースデータの保存に使用します。

-

Google Cloud コンソールのナビゲーション メニュー( )で、[BigQuery] を選択します。

)で、[BigQuery] を選択します。

[Cloud コンソールの BigQuery へようこそ] ポップアップが表示されます。

-

[完了] をクリックします。

-

[エクスプローラ] パネルで、 の「アクションを表示」アイコン( )を選択してから、[データセットを作成] を選択します。

)を選択してから、[データセットを作成] を選択します。

テーブルやモデルなどのデータベース オブジェクトを格納するためのデータセットが作成されます。

-

[データセットを作成する] ペインに以下の情報を入力します。

| フィールド |

値 |

| データセット ID |

ecommerce |

| ロケーション タイプ |

[マルチリージョン] を選択 |

| マルチリージョン |

[US(米国の複数のリージョン)] を選択 |

その他のフィールドはデフォルトのままにします。

-

[データセットを作成] をクリックします。

[進行状況を確認] をクリックして、目標に沿って進んでいることを確認します。

プロジェクト用の BigQuery データセットを作成する

タスク 2. 新しい Python ノートブックを作成する

このタスクでは、Gemini in BigQuery を使用できるように、BigQuery で新しい Python ノートブックを作成します。BigQuery で Python ノートブックが必要な理由は、e コマース データセットのショッピング データに基づいて、Python ML ライブラリを使用して顧客を特定し、グループに分類する必要があるためです。

-

Google Cloud コンソールのナビゲーション メニュー( )で、[BigQuery] を選択します。

)で、[BigQuery] を選択します。

-

ページ上部のプラス記号の横にある下矢印をクリックします。

-

[Notebook] > [空のノートブック] を選択します。

-

コードアセットを保存するリージョン をプルダウンから選択し、[選択] をクリックします。

-

[テンプレートを使って開始] ペインで [閉じる] をクリックします。

タスク 3. BigQuery の Colab Enterprise ランタイムに接続する

次のステップは、BigQuery の Colab Enterprise ランタイムへの接続です。このランタイムは、ML ライブラリへのアクセスを可能にする BigQuery のマネージド環境と考えてください。これが、顧客の特定とグループへの分類に役立ちます。

-

BigQuery Studio コンソールを表示したまま、ノートブックの右上隅にある [接続] の横にある下矢印をクリックします。

-

プルダウンで [ランタイムに接続する] を選択します。

-

[ランタイムの新規作成] を選択します。

-

[デフォルト ランタイムの作成] を選択します。

-

Qwiklabs の受講者 ID をクリックします。

注: ランタイムが割り当てられるまで数分待機します。ブラウザ ウィンドウの下部にある接続ステータスの表示が更新されて、接続済みになります。プロジェクトのエクスプローラのノートブック セクションにも Python ノートブックが追加されます。

[進行状況を確認] をクリックして、目標に沿って進んでいることを確認します。

BigQuery の Colab Enterprise ランタイムに接続する

タスク 4. Python ノートブックをビルドする

このタスクでは、次の手順に沿って Python ノートブックのビルドを開始します。

- Python ライブラリをインポートする

- 変数を定義する

- パブリック データセットから BigQuery DataFrame としてベーステーブルを作成してインポートする

- k 平均法クラスタリング モデルと可視化を生成する

Python ライブラリをインポートし、変数を定義する

Python ノートブックのビルドの最初のステップは、Python ライブラリのインポートと変数の定義です。

ライブラリをノートブックにインポートするには、以下の手順に従います。

-

ノートブックにコードセルを追加し、ノートブック ウィンドウの上部にある [+ コード] ボタンをクリックします。

-

次のコード スニペットをセルに貼り付けます。

from google.cloud import bigquery

from google.cloud import aiplatform

import bigframes.pandas as bpd

import pandas as pd

from vertexai.language_models._language_models import TextGenerationModel

from vertexai.generative_models import GenerativeModel

from bigframes.ml.cluster import KMeans

from bigframes.ml.model_selection import train_test_split

-

セルを実行  します。

します。

ランタイムによって Python ライブラリが読み込まれますが、これに約 1 分間かかります。ブラウザ ウィンドウの下部にあるランタイムのステータスにより、進捗を確認できます。

完了すると、セルの [実行] ボタンの横に緑色のチェックマーク  が表示されます。

が表示されます。

下記の表で、先ほどノートブックにインポートした Python ライブラリに関する情報を、各ライブラリの簡単な説明とともに確認できます。

注: 各ライブラリの詳細を学習するには、示されたリンクを使用してください。

変数を定義し、BigQuery と Vertex AI の接続を開始する

次に、変数を定義し、BigQuery と Vertex AI の接続を開始します。

-

ノートブックの末尾に別のコードセルを追加します。

-

次のコード スニペットをセルに貼り付けます。

project_id = '<project_id>'

dataset_name = "ecommerce"

model_name = "customer_segmentation_model"

table_name = "customer_stats"

location = "<location>"

client = bigquery.Client(project=project_id)

aiplatform.init(project=project_id, location=location)

-

<project_id> を に置き換えます。

-

<location> を に置き換えます。

-

セルを実行  します。

します。

ecommerce.customer_stats テーブルを作成してインポートする

次に、thelook_ecommerce BigQuery パブリック データセットのデータを e コマース データセットの customer_status という新しいテーブルに保存します。

-

ノートブックの末尾に別のコードセルを追加します。

-

次のコード スニペットをセルに貼り付けます。

%%bigquery

CREATE OR REPLACE TABLE ecommerce.customer_stats AS

SELECT

user_id,

DATE_DIFF(CURRENT_DATE(), CAST(MAX(order_created_date) AS DATE), day) AS days_since_last_order, ---RECENCY

COUNT(order_id) AS count_orders, --FREQUENCY

AVG(sale_price) AS average_spend --MONETARY

FROM (

SELECT

user_id,

order_id,

sale_price,

created_at AS order_created_date

FROM `bigquery-public-data.thelook_ecommerce.order_items`

WHERE

created_at

BETWEEN '2022-01-01' AND '2023-01-01'

)

GROUP BY user_id;

-

セルを実行  します。

します。

BigQuery DataFrame を作成し、Gemini プロンプトを使用してデータを読み込む

このステップでは、Gemini プロンプトを使用して BigQuery DataFrame を作成し、そこに顧客統計データを読み込みます。これにより、後でデータを k 平均法クラスタリング モデルで処理できるようになります。

注: このラボの冒頭で説明したように、Gemini からのすべての出力は、使用する前に検証する必要があります。ユーザーをサポートするために用意されているサンプルコードを使用しますが、コードをそのままコピーして貼り付けないでください。動作しないことがあります。より適切な出力を得るために、Gemini からコードを再生成することもできます。

-

ノートブックの末尾に別のコードセルを追加します。

-

セル内の [生成] をクリックします。これにより、Gemini でコードを生成できるようになり、テキストを追加できるプロンプトが表示されます。

-

プロンプトに次のテキストを貼り付けます。

テーブル ecommerce.customer_stats を bigframes データフレームに変換し、上位 10 件のレコードを表示する

-

[生成] をクリックします。Gemini によって以下のコードが生成されます。

bqdf = client.read_gbq(f"{project_id}.{dataset_name}.{table_name}")

df.head(10)

注: 以前のステップで、ノートブックのセル番号 2 に、プロジェクト ID、データセット名、テーブル名を変数として保存するコードを追加しています。このステップが完了していれば、次のステップでセルを実行したときに問題は発生せず、DataFrame が作成されて最初の 10 行が表示されます。

-

出力が次に示すコードと同様になるように、コードを再生成します。

bqdf = bpd.read_gbq(f"{project_id}.{dataset_name}.{table_name}")

bqdf.head(10)

-

セルを実行  します。

します。

BigQuery DataFrame 出力にデータセットの最初の 10 行が表示されます。

k 平均法クラスタリング モデルを生成する

顧客データが BigQuery DataFrame に入ったので、k 平均法クラスタリング モデルを作成し、注文時期、注文数、支出額などのフィールドに基づいて、顧客データをクラスタに分割します。その後、ノートブックでチャート内のグループとして直接可視化します。

-

ノートブックの末尾に別のコードセルを追加します。

-

セル内の [生成] をクリックします。これにより、プロンプトを使用して Gemini でコードを生成できるようになります。

-

セルに次のプロンプトを追加します。

1. df をテストデータとトレーニング データに分割し、k 平均法クラスタリング アルゴリズムがこれらを df_test および df_train として保存できるようにします(ランダム状態を使用し、テストサイズとして 0.2 を使用します)。2. 5 つのクラスタで bigframes.ml.cluster KMeans を使用して k 平均法クラスタリング モデルを作成します。3. to_gbq メソッドを使用してモデルを保存します。モデル名は project_id.dataset_name.model_name です。

-

[生成] をクリックします。出力は次のようになります。

#prompt: 1. df をテストデータとトレーニング データに分割し、k 平均法クラスタリング アルゴリズムがこれらを df_test および df_train として保存できるようにします(ランダム状態を使用し、テストサイズとして 0.2 を使用します)。2. 5 つのクラスタで bigframes.ml.cluster KMeans を使用して k 平均法クラスタリング モデルを作成します。3. to_gbq メソッドを使用してモデルを保存します。モデル名は project_id.dataset_name.model_name です。

df_train, df_test = train_test_split(bq_df, test_size=0.2, random_state = 42)

kmeans = KMeans(n_clusters=5)

kmeans.fit(df_train)

kmeans.to_gbq(f"{project_id}.{dataset_name}.{model_name}")

-

セルを実行  します。

します。

注: このステップには 2 分ほどかかります。

モデルが作成されました。

-

プロジェクト名の横にあるその他アイコンをクリックしてから [コンテンツを更新] を選択して、エクスプローラ パネルのコンテンツを更新します。e コマース データセットの下にポップアップが表示されます。

次に、k 平均法モデルから生成されたセグメント / クラスタを元のデータに結合する、新しい BigQuery DataFrame を定義します。

-

ノートブックの末尾に別のコードセルを追加します。

-

セル内の [生成] をクリックします。

これにより、プロンプトを使用して Gemini でコードを生成できるようになります。

-

セルに次のプロンプトを追加します。

1. df データフレームで k 平均法予測モデルを呼び出し、結果を predictions_df として保存し、最初の 10 レコードを表示します。

-

[生成] をクリックします。出力は次のようになります。

# prompt: 1. df データフレームで k 平均法予測モデルを呼び出し、結果を predictions_df として保存し、最初の 10 レコードを表示します。

predictions_df = kmeans.predict(df_test)

predictions_df.head(10)

-

セルを実行  します。

します。

最初の 10 レコードが CENTROID_ID 付きで表示されます。CENTROID_ID は、この後のラボで分類される顧客のクラスタです。user_id、days_since_last_order、count_orders、average_spend の各フィールドも確認できます。

[進行状況を確認] をクリックして、目標に沿って進んでいることを確認します。

k 平均法クラスタリング モデルを生成する

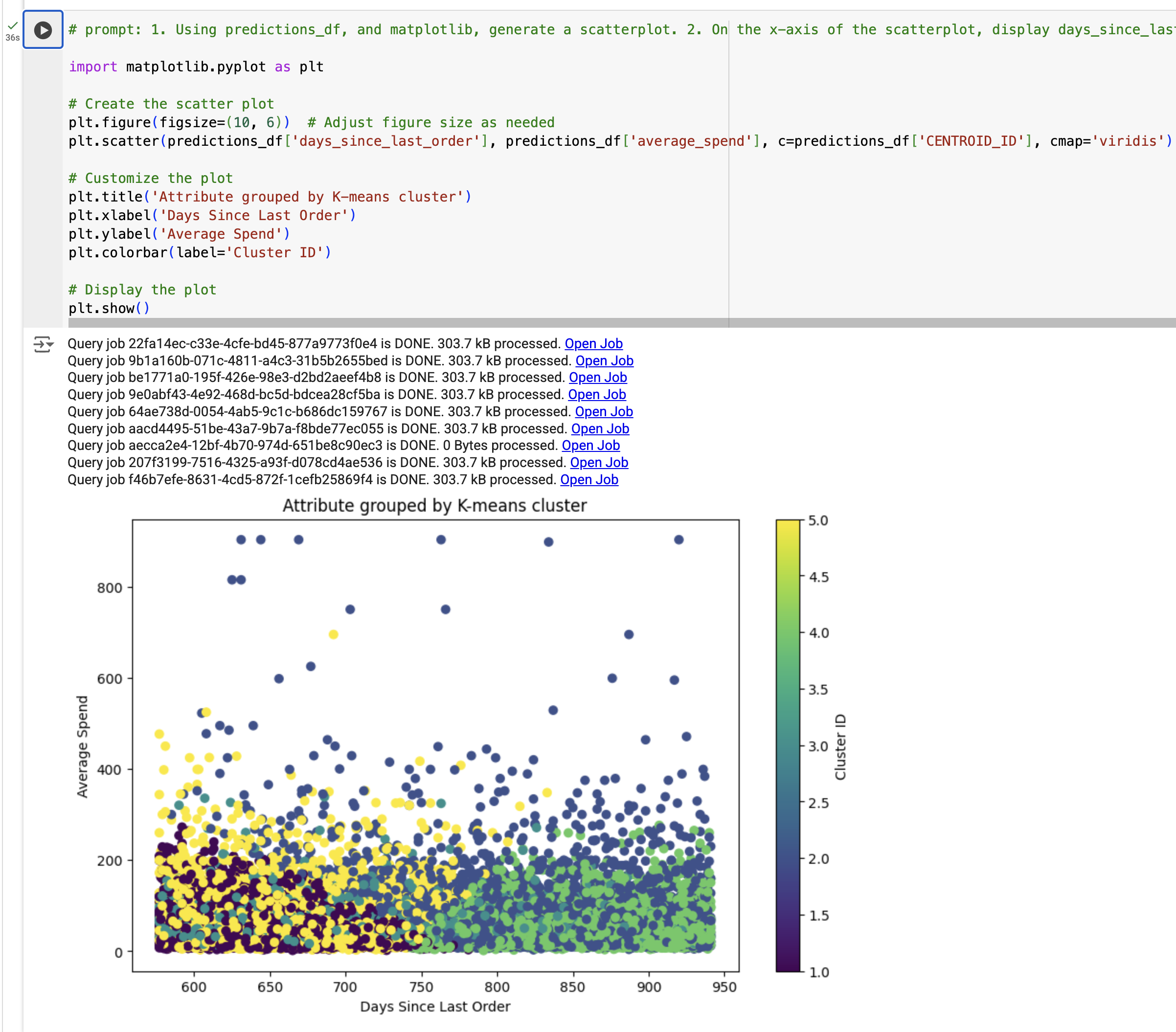

k 平均法クラスタリング モデルの結果の可視化を作成する

このステップでは、k 平均法クラスタリング モデルの結果の可視化を作成します。具体的には、predictions_df を使用して散布図を生成し、前回の注文から経過した日数と平均支出額の間の関係に注目します。segment_id で色分けされています(これは k 平均法モデルを使用して生成されました)。

-

ノートブックの末尾に別のコードセルを追加します。

-

セル内の [生成] をクリックします。

これにより、プロンプトを使用して Gemini でコードを生成できるようになります。

-

セルに次のプロンプトを追加します。

1. predictions_df と matplotlib を使用して散布図を生成します。2. 散布図で、x 軸には predictions_df の days_since_last_order、y 軸には predictions_df の average_spend を表示します。3. クラスタで色分けします。4. チャートのタイトルは「k 平均法クラスタでグループ化した属性」とします。

-

[生成] をクリックします。出力は次のようになります。

#prompt: 1. predictions_df と matplotlib を使用して散布図を生成します。2. 散布図で、x 軸には predictions_df の days_since_last_order、y 軸には predictions_df の average_spend を表示します。3. クラスタで色分けします。4. チャートのタイトルは「k 平均法クラスタでグループ化した属性」とします。

import matplotlib.pyplot as plt

# 散布図を作成する

plt.figure(figsize=(10, 6)) # 必要に応じて図のサイズを調整する

plt.scatter(predictions_df['days_since_last_order'], predictions_df['average_spend'], c=predictions_df['cluster'], cmap='viridis')

# ロットをカスタマイズする

plt.title('Attribute grouped by K-means cluster')

plt.xlabel('Days Since Last Order')

plt.ylabel('Average Spend')

plt.colorbar(label='Cluster ID')

# プロットを表示する

plt.show()

-

'cluster' または 'cluster_id' を 'CENTROID_ID' に置き換えます(c=predictions_df フィールドのみ)。

-

セルを実行  します。

します。

可視化内容が表示されます。

注: TypeError が発生した場合は、コードをサンプル出力に置き換えてからセルを実行してください。

[進行状況を確認] をクリックして、目標に沿って進んでいることを確認します。

k 平均法クラスタリング モデルの結果から可視化内容を生成する

タスク 5. モデルの結果から分析情報を生成する

このタスクでは、次の手順に沿って、モデルの結果から分析情報を生成します。

- k 平均法モデルから生成された各クラスタを要約する

- マーケティング キャンペーンのプロンプトを定義する

- Gemini を使用してマーケティング キャンペーンを生成する

k 平均法モデルから生成された各クラスタを要約する

このステップでは、k 平均法モデルから生成された各クラスタを要約します。

-

ノートブックの末尾に別のコードセルを追加します。

-

次のコード スニペットをセルに貼り付けます。

query = """

SELECT

CONCAT('cluster ', CAST(centroid_id as STRING)) as centroid,

average_spend,

count_orders,

days_since_last_order

FROM (

SELECT centroid_id, feature, ROUND(numerical_value, 2) as value

FROM ML.CENTROIDS(MODEL `{0}.{1}`)

)

PIVOT (

SUM(value)

FOR feature IN ('average_spend', 'count_orders', 'days_since_last_order')

)

ORDER BY centroid_id

""".format(dataset_name, model_name)

df_centroid = client.query(query).to_dataframe()

df_centroid.head()

-

セルを実行  します。

します。

クラスタがテーブルに要約されて表示されます。このテーブルから得られる分析情報により、一部のクラスタでは平均支出額が高く、他のクラスタでは注文数が高いことがわかります。

次に、データフレームを文字列に変換して、大規模言語モデル呼び出しに渡せるようにします。

-

ノートブックの末尾に別のコードセルを追加します。

-

次のコード スニペットをセルに貼り付けます。

df_query = client.query(query).to_dataframe()

df_query.to_string(header=False, index=False)

cluster_info = []

for i, row in df_query.iterrows():

cluster_info.append("{0}, average spend ${2}, count of orders per person {1}, days since last order {3}"

.format(row["centroid"], row["count_orders"], row["average_spend"], row["days_since_last_order"]) )

cluster_info = (str.join("\n", cluster_info))

print(cluster_info)

-

セルを実行  します。

します。

出力は次のようになります。

cluster 1, average spend $48.32, count of orders per person 1.36, days since last order 384.37

cluster 2, average spend $202.34, count of orders per person 1.3, days since last order 482.62

cluster 3, average spend $45.68, count of orders per person 1.36, days since last order 585.4

cluster 4, average spend $44.71, count of orders per person 1.36, days since last order 466.26

cluster 5, average spend $58.08, count of orders per person 3.92, days since last order 427.36

Gemini モデルを使用してマーケティング キャンペーンを生成する

ここまでで k 平均法モデルを作成し、モデルから各顧客をクラスタに割り当て、各クラスタから統計情報の要約を生成しました。このステップでは、Gemini を使用してプロンプトからコードを生成し、マーケティング チーム向けの顧客インサイトと次のステップを含むマーケティング キャンペーンを作成します。

k 平均法モデルによって定義された各クラスタ / セグメントについて、マーケティング チームで使用できる 3 つの項目を生成します。

-

ノートブックの末尾に別のコードセルを追加します。

-

次のコード スニペットをセルに貼り付けます。

model = GenerativeModel("gemini-2.5-pro")

prompt = f"""

あなたはクリエイティブなブランド戦略家です。以下のクラスタをもとに、\

独創的なブランド ペルソナ、覚えやすいタイトル、次のマーケティング アクションを提案してください。\

順を追って説明してください。クラスタ番号、その人物のタイトル、ペルソナ、次のマーケティング ステップを指定してください。

クラスタ:

{cluster_info}

各クラスタについて:

* タイトル:

* ペルソナ:

* 次のマーケティング ステップ:

"""

responses = model.generate_content(

prompt,

generation_config={

"temperature": 0.1,

"max_output_tokens": 4000,

"top_p": 1.0,

"top_k": 40,

}

)

print(responses.text)

-

セルを実行  します。

します。

各クラスタにタイトル、ペルソナ、次のステップが表示されます。

**クラスタ 1:**

* **タイトル:** 休眠顧客

* **ペルソナ:** これらの顧客は過去に購入したことがあるものの、長期間にわたって再購入していません。良い印象を持っていると思われるものの、最近は利用していないユーザーです。

* **次のマーケティング ステップ:**

1. **リエンゲージメント キャンペーン:** 以前の購入に基づいて、興味を引く可能性のある新しい商品やプロモーションを紹介する、パーソナライズされたメールやターゲット広告を送信します。

2. **限定割引やインセンティブの提供:** スペシャル オファーやリピート特典で、ユーザーの再利用を促します。

3. **パーソナライズされた商品のおすすめ:** 購入履歴とブラウジング行動を活用して、ユーザーが興味を引く可能性のある関連性の高い商品を提案します。

**クラスタ 2:**

* **タイトル:** 購入頻度の低い顧客

* **ペルソナ:** これらの顧客は購入頻度は低いものの、購入する際は高額な商品を購入します。ブランドを特別な機会に利用するプレミアム オプションと見なしている可能性があります。

* **次のマーケティング ステップ:**

1. **特別感とプレミアムな価値の提示:** 商品のユニークな特徴やメリットを強調して、高い価格設定の正当性を示します。

2. **期間限定のプロモーションやセット商品の提供:** 高額商品や厳選されたセット商品を特別価格で提供し、より大きな購入を促します。

3. **緊急性や希少性の演出:** 限定商品や期間限定セールを宣伝して、即座の行動を促します。

**クラスタ 3:**

* **タイトル:** 購入回数が 1 回のみの顧客

* **ペルソナ:** これらの顧客は 1 回しか購入しておらず、その後は購入していません。特に良い印象も悪い印象も持っていないか、再度購入する理由を見つけられなかった可能性があります。

* **次のマーケティング ステップ:**

1. **フィードバックの収集:** 購入後のアンケートを送信して、ユーザーの体験を把握し、改善すべき点を特定します。

2. **パーソナライズされたおすすめの提案:** 最初の購入に基づいて補完的な商品やオプションを提案し、さらなるエンゲージメントを促します。

3. **お客様の声とソーシャル プルーフの紹介:** 高評価のレビューやユーザー作成コンテンツを紹介して、信頼を築き、リピート購入を促します。

**クラスタ 4:**

* **タイトル:** 支出額の大きい顧客

* **ペルソナ:** これらの顧客は他の顧客と比較して支出額が非常に大きく、ビジネスにとって最もロイヤリティが高く価値のあるセグメントであると考えられます。高品質な商品とパーソナライズされたエクスペリエンスを重視します。

* **次のマーケティング ステップ:**

1. **VIP プログラムの開発:** 限定特典、新商品への早期アクセス、パーソナライズされたカスタマー サービスを提供して感謝の気持ちを示し、継続的なロイヤリティを促進します。

2. **パーソナライズされたコミュニケーションと特典:** ユーザーの興味や購入履歴に合わせてマーケティング メッセージやプロモーションを調整します。

3. **限定イベントや特別な体験を企画する:** ブランドや他の価値の高いユーザーとつながる機会を設けます。

**クラスタ 5:**

* **タイトル:** 価格重視の顧客

* **ペルソナ:** これらの顧客は主に価格に動機付けられ、低頻度で低価格の商品を購入します。価格を比較して、最安値の商品を探す傾向があります。

* **次のマーケティング ステップ:**

1. **競争力のある価格と価値主導のオファーの宣伝:** 競争力のある価格やお得なセット販売を強調して、価格に敏感な顧客を引き付けます。

2. **送料無料などの特典の提供:** 送料無料やその他の魅力的な特典を提供して、購入の障壁を減らします。

3. **商品のメリットとコストパフォーマンスの強調:** 商品の品質と機能を強調して、価格の正当性を示します。

[進行状況を確認] をクリックして、目標に沿って進んでいることを確認します。

Gemini を使用してマーケティング キャンペーンを生成する

タスク 6. プロジェクト リソースをクリーンアップする(任意)

このラボでは、Google Cloud コンソールでリソースを作成しました。本番環境では、これらのリソースをアカウントから削除する必要があります。モデルから分析情報を収集した時点でそのリソースは不要になるためです。リソースの使用に対して不要な課金を防ぐためにアカウントからリソースを削除するには 2 つの方法があります。

- プロジェクトを削除する(下記の注意を参照)

- 個々のリソースを削除する

プロジェクトを削除することにより、リソースをクリーンアップする

このチュートリアルで使用したリソースについて、Google Cloud アカウントに課金されないようにするには、このチュートリアルで作成した Google Cloud プロジェクトを削除します。

注意: プロジェクトを削除すると、次のような影響があります。

- プロジェクト内のすべてのものが削除されます。このドキュメントのタスクで使用した既存のプロジェクトを削除すると、そのプロジェクトで行った他の作業もすべて削除されます。

- カスタム プロジェクト ID が失われます。このプロジェクトを作成したときに、将来使用するカスタム プロジェクト ID を作成した可能性があります。appspot.com など、プロジェクト ID を使用する URL を保持するには、プロジェクト全体を削除するのではなく、プロジェクト内の選択したリソースを削除します。

複数のアーキテクチャ、チュートリアル、クイックスタートを確認する計画がある場合は、プロジェクトを再利用すると割り当て上限を超えることがありません。

-

Google Cloud コンソールで、[IAM と管理] > [リソースの管理] ページに移動します。

-

プロジェクト リストで削除するプロジェクトを選択し、[削除] をクリックします。

-

ダイアログでプロジェクト ID を入力し、[このままシャットダウン] をクリックしてプロジェクトを削除します。

個々のリソースを削除することにより、リソースをクリーンアップする

課金されないようにするため、ノートブック内の新しいコードセルで次のコードを実行することにより、このラボで使用したテーブルとモデルを削除できます。

# Delete customer_stats table

client.delete_table(f"{project_id}.{dataset_name}.{table_name}", not_found_ok=True)

print(f"Deleted table: {project_id}.{dataset_name}.{table_name}")

# Delete K-means model

client.delete_model(f"{project_id}.{dataset_name}.{model_name}", not_found_ok=True)

print(f"Deleted model: {project_id}.{dataset_name}.{model_name}")

セルを実行した後、BigQuery Studio でプロジェクトのコンテンツを更新すると、テーブルとモデルが削除されたことを確認できます。

お疲れさまでした

このラボでは、以下の操作について学習しました。

- BigQuery Studio 内で Colab Enterprise Python ノートブックを使用する。

- BigQuery Studio 内で BigQuery DataFrames を使用する。

- Gemini を使用して、自然言語プロンプトからコードを生成する。

- k 平均法クラスタリング モデルを構築する。

- クラスタの可視化を生成する。

- Gemini を使用して、マーケティング キャンペーンの次のステップを生成する。

オプションの資料

Gemini、VertexAI、BigQuery を使用して Cymbal Superstore で顧客の特定、分類、開拓支援を行いました。Gemini の詳細については、以下のリンクを参照してください。

ラボを終了する

ラボでの学習が完了したら、[ラボを終了] をクリックします。ラボで使用したリソースが Qwiklabs から削除され、アカウントの情報も消去されます。

ラボの評価を求めるダイアログが表示されたら、星の数を選択してコメントを入力し、[送信] をクリックします。

星の数は、それぞれ次の評価を表します。

- 星 1 つ = 非常に不満

- 星 2 つ = 不満

- 星 3 つ = どちらともいえない

- 星 4 つ = 満足

- 星 5 つ = 非常に満足

フィードバックを送信しない場合は、ダイアログ ボックスを閉じてください。

フィードバック、ご提案、修正が必要な箇所については、[サポート] タブからお知らせください。

マニュアルの最終更新日: 2025 年 9 月 3 日

ラボの最終テスト日: 2025 年 9 月 3 日

Copyright 2024 Google LLC All rights reserved. Google および Google のロゴは、Google LLC の商標です。その他すべての社名および製品名は、それぞれ該当する企業の商標である可能性があります。