始める前に

- ラボでは、Google Cloud プロジェクトとリソースを一定の時間利用します

- ラボには時間制限があり、一時停止機能はありません。ラボを終了した場合は、最初からやり直す必要があります。

- 画面左上の [ラボを開始] をクリックして開始します

Create a continuous export pipeline to Pub/Sub

/ 20

Export findings to a BigQuery dataset

/ 50

Export findings to a Cloud Storage bucket and create a BigQuery table

/ 30

Security Command Center(SCC)は、次のようなユーザーの作業を支援するセキュリティ モニタリング プラットフォームです。

このラボでは、Security Command Center について学び、このサービスのアセットの分析とエクスポートの機能について確認します。

このラボでは、次のタスクの実行方法について学びます。

このラボを開始する前に、次の知識があることが推奨されます。

こちらの説明をお読みください。ラボには時間制限があり、一時停止することはできません。タイマーは、Google Cloud のリソースを利用できる時間を示しており、[ラボを開始] をクリックするとスタートします。

このハンズオンラボでは、シミュレーションやデモ環境ではなく実際のクラウド環境を使って、ラボのアクティビティを行います。そのため、ラボの受講中に Google Cloud にログインおよびアクセスするための、新しい一時的な認証情報が提供されます。

このラボを完了するためには、下記が必要です。

[ラボを開始] ボタンをクリックします。ラボの料金をお支払いいただく必要がある場合は、表示されるダイアログでお支払い方法を選択してください。 左側の [ラボの詳細] ペインには、以下が表示されます。

[Google Cloud コンソールを開く] をクリックします(Chrome ブラウザを使用している場合は、右クリックして [シークレット ウィンドウで開く] を選択します)。

ラボでリソースがスピンアップし、別のタブで [ログイン] ページが表示されます。

ヒント: タブをそれぞれ別のウィンドウで開き、並べて表示しておきましょう。

必要に応じて、下のユーザー名をコピーして、[ログイン] ダイアログに貼り付けます。

[ラボの詳細] ペインでもユーザー名を確認できます。

[次へ] をクリックします。

以下のパスワードをコピーして、[ようこそ] ダイアログに貼り付けます。

[ラボの詳細] ペインでもパスワードを確認できます。

[次へ] をクリックします。

その後次のように進みます。

その後、このタブで Google Cloud コンソールが開きます。

Cloud Shell は、開発ツールと一緒に読み込まれる仮想マシンです。5 GB の永続ホーム ディレクトリが用意されており、Google Cloud で稼働します。Cloud Shell を使用すると、コマンドラインで Google Cloud リソースにアクセスできます。

Google Cloud コンソールの上部にある「Cloud Shell をアクティブにする」アイコン

ウィンドウで次の操作を行います。

接続した時点で認証が完了しており、プロジェクトに各自の Project_ID、

gcloud は Google Cloud のコマンドライン ツールです。このツールは、Cloud Shell にプリインストールされており、タブ補完がサポートされています。

出力:

出力:

gcloud ドキュメントの全文については、gcloud CLI の概要ガイドをご覧ください。

Cymbal Bank は、米国のリテールバンクで、全米 50 州に 2,000 以上の支店があります。堅牢な支払いプラットフォームを基盤とした包括的なデビットおよびクレジット サービスを提供しています。従来の金融サービス機関からの変革を目指し、デジタル トランスフォーメーションを推進しています。

Cymbal Bank は、1920 年に Troxler という名前で設立されました。Cymbal Group 独自の ATM への積極的な投資を行っていた Cymbal Group は、Troxler を 1975 年に買収しました。Cymbal Bank は、全米をリードする銀行に成長するにつれ、支店での対面サービスと 2014 年にリリースしたアプリを通じオンラインにおいても、カスタマー エクスペリエンスを近代化させることに注力しました。Cymbal Bank は全国で 42,000 人を雇用し、2019 年の収益は 240 億ドルでした。

Cymbal Bank は自社の銀行アプリケーションに一元化されたセキュリティ モニタリング プラットフォームを統合することで Google Cloud リソース全体での脅威のモニタリングや脆弱性の修復に役立てることに関心があります。クラウド セキュリティ エンジニアであるあなたは、Security Command Center の利点について CTO にプレゼンテーションできるように、このサービスのエクスポートおよび分析の機能について学ぶことを任されました。

Security Command Center では、次のような複数の方法を使用して、セキュリティに関する検出結果を外部リソースにエクスポートできます。

このタスクでは、検出結果を Pub/Sub に継続的にエクスポートするように構成する方法を確認します。

Pub/Sub への継続的なエクスポートは、通常、Splunk や QRadar などの外部セキュリティ管理システムに検出結果を転送するために使用されます。

このラボでは、検出結果を Pub/Sub トピックにエクスポートし、Pub/Sub サブスクリプションからメッセージを取得してアプリケーションをシミュレートします。

SCC エクスポートの構成を開始する前に、まず Pub/Sub トピックとサブスクリプションを作成する必要があります。

Pub/Sub」と入力し、Enter キーを押します。次に、検索結果の一番上に表示される「Pub/Sub」をクリックします。export-findings-pubsub-topic」と入力します。これにより、Pub/Sub トピックと関連するサブスクリプションの両方の作成プロセスが自動的に開始されます。

左側のメニューで [サブスクリプション] をクリックします。

[export-findings-pubsub-topic-sub] をクリックします。サブスクリプションが表示されない場合は、ブラウザページを更新してください。

これにより、このサブスクリプションでパブリッシュされたメッセージに関連する統計情報と指標のダッシュボードが表示されます。

Cloud コンソールのナビゲーション メニュー(

[継続的エクスポート] タブをクリックします。

[Pub/Sub のエクスポートを作成] ボタンをクリックします。

[継続的なエクスポート名] に「export-findings-pubsub」と入力します。

[継続的なエクスポートの説明] に「検出結果の Pub/Sub および BigQuery への継続的なエクスポート」と入力します。

[プロジェクト名] で、作業中のプロジェクトのプロジェクト ID である

[Cloud Pub/Sub トピックを選択してください] フィールドで、[projects/

検出結果クエリを次のように設定します。

このクエリにより、新しく作成された Pub/Sub トピックに、すべての新しい ACTIVE および NOT MUTED の検出結果が転送されます。

これで、Security Command Center から Pub/Sub への継続的エクスポートが作成されました。

このセクションでは、新しい検出結果を作成し、Pub/Sub へのエクスポート方法を確認します。

新しい Cloud Shell セッションを開きます(

次のコマンドを実行して、新しい仮想マシンを作成します。

出力:

ERROR: (gcloud.compute.instances.create) You do not currently have an active account selected」というエラー メッセージが表示された場合は、コマンドを再実行してください。このコマンドは、パブリック IP アドレスとデフォルトのサービス アカウントがアタッチされた新しい VM インスタンスを作成します。

このアクティビティを実行すると、3 つの新しい脆弱性検出結果がすぐに生成されます。

Google Cloud コンソールのタイトルバーにある検索フィールドに「Pub/Sub」と入力し、Enter キーを押します。次に、検索結果の一番上に表示される [Pub/Sub] をクリックします。左側のメニューで [サブスクリプション] をクリックします。

[export-findings-pubsub-topic-sub] サブスクリプションを選択します。

[メッセージ] タブをクリックします。

[確認応答メッセージを有効にする] チェックボックスをオンにします。

[pull] ボタンをクリックします。

このサブスクリプションのメッセージのリストが表示されます。これらは、パブリック IP アドレス、デフォルトのサービス アカウントが使用されている、Compute のセキュアブートが無効になっている脆弱性に関連しています。

Pub/Sub サブスクリプションからメッセージを pull することで、これらのメッセージを Splunk などの別のセキュリティ モニタリング システムに転送できるアプリケーションの動作をシミュレートしました。

[進行状況を確認] をクリックして、目標に沿って進んでいることを確認します。

SCC の検出結果は、BigQuery データセットにエクスポートすることもできます。これは、組織で最も頻繁に発生する検出結果の種類を確認するために使用できる分析ダッシュボードを構築するのに役立ちます。

現時点では、継続的エクスポートの構成はコマンドを使用してのみ設定できます(コンソールでは設定できません)。

)。

)。次のような出力メッセージが表示されることを確認します。

出力:

新しい検出結果が BigQuery にエクスポートされると、SCC では新しいテーブルが作成されます。これで、新しい SCC の検出結果を開始できます。

SCC で新しい検出結果が作成されると、BigQuery にエクスポートされます。エクスポート パイプラインでは、findings という新しいテーブルを作成してこれを格納します。

間もなく次のような出力が返されます。

出力:

[進行状況を確認] をクリックして、目標に沿って進んでいることを確認します。

Security Command Center は通常、既存の成熟した Google Cloud インフラストラクチャで有効になります。SCC を有効にすると、既存の脆弱性のスキャンが開始され、最終的には既存のインフラストラクチャに関する数千件の検出結果が報告される可能性があります。

SCC インターフェースでは、これらの検出結果の並べ替えやフィルタリングを行うのに適した方法が提供されない可能性があります。そのため、これらの検出結果を BigQuery データベースにエクスポートして、検出結果に対して分析を実行するのが一般的な方法です。

検出結果の BigQuery への直接エクスポートは、まだサポートされていません。代わりに、Google Cloud Storage バケットを一時的なストレージ ソリューションとして使用できます。

既存の検出結果を BigQuery インターフェースにエクスポートするには、まず Cloud Storage バケットにエクスポートする必要があります。このセクションでは、ストレージ バケットを作成します。

Cloud コンソールのナビゲーション メニュー(

[作成] ボタンをクリックします。

Google Cloud のすべてのバケット名は一意である必要があります。バケット名を「scc-export-bucket-

[続行] をクリックします。

[ロケーション タイプ] を [リージョン] に設定します。

ロケーションとして、「

他の設定は変更しないでください。ページを下にスクロールして [作成] をクリックします。

このバケットに対して「公開アクセス禁止を適用する」かどうかを尋ねられたら、[確認] ボタンをクリックします。

このセクションでは、検出結果をエクスポートして BigQuery データベースで使用します。

Cloud コンソールのナビゲーション メニュー(

[エクスポート] ボタンをクリックします

プルダウン リストから [Cloud Storage] を選択します。

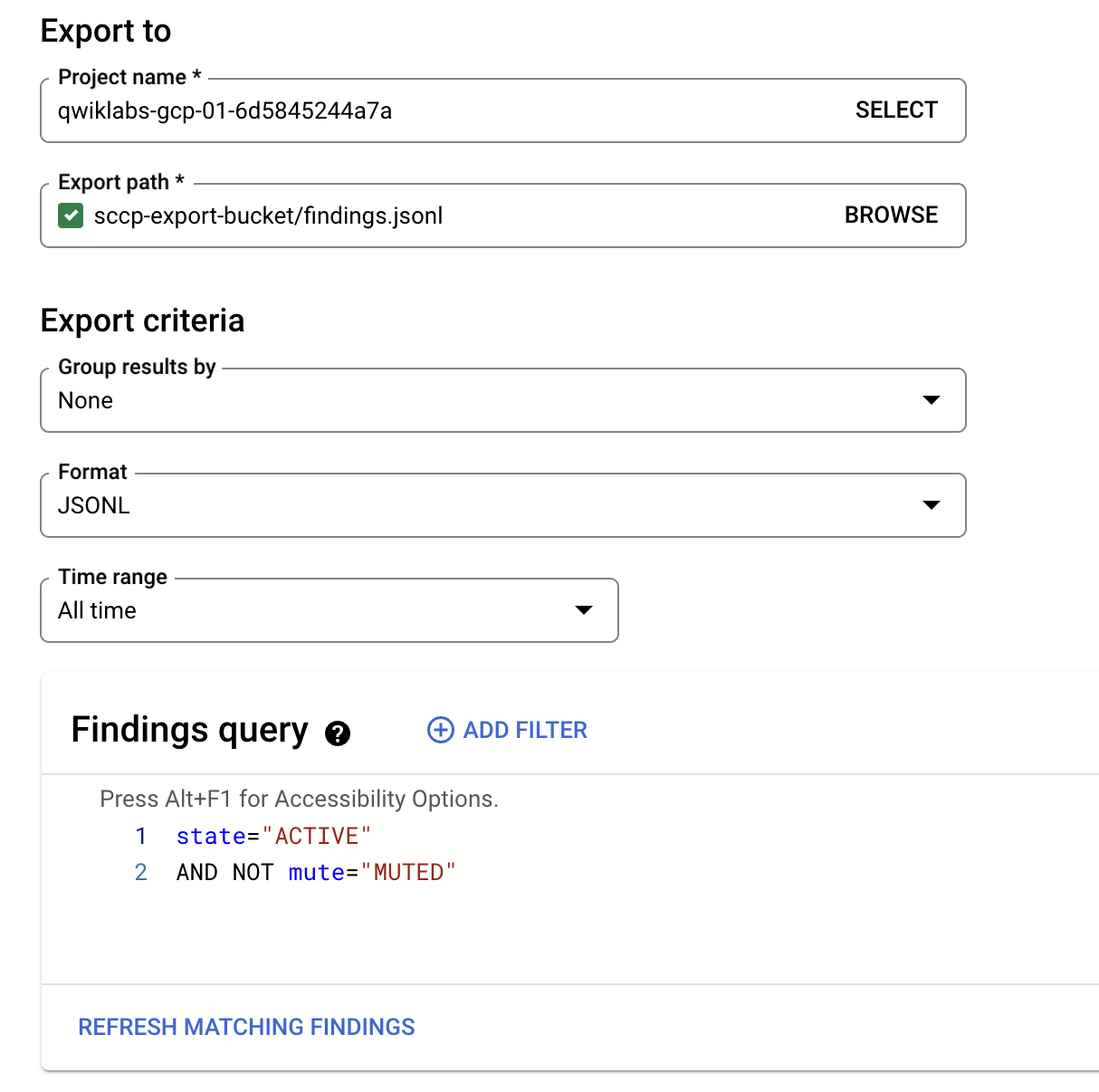

プロジェクト名として、プロジェクト ID を

[参照] ボタンをクリックして、エクスポート パスを選択します。

[scc-export-bucket-

ファイル名を「findings.jsonl」に設定し、[選択] をクリックします。

[形式] プルダウン リストで [JSONL] を選択します。

期間を [全期間] に変更します。

デフォルトの検出結果クエリは変更しないでください。

最終的な「エクスポート先」フォームは次のようになります。

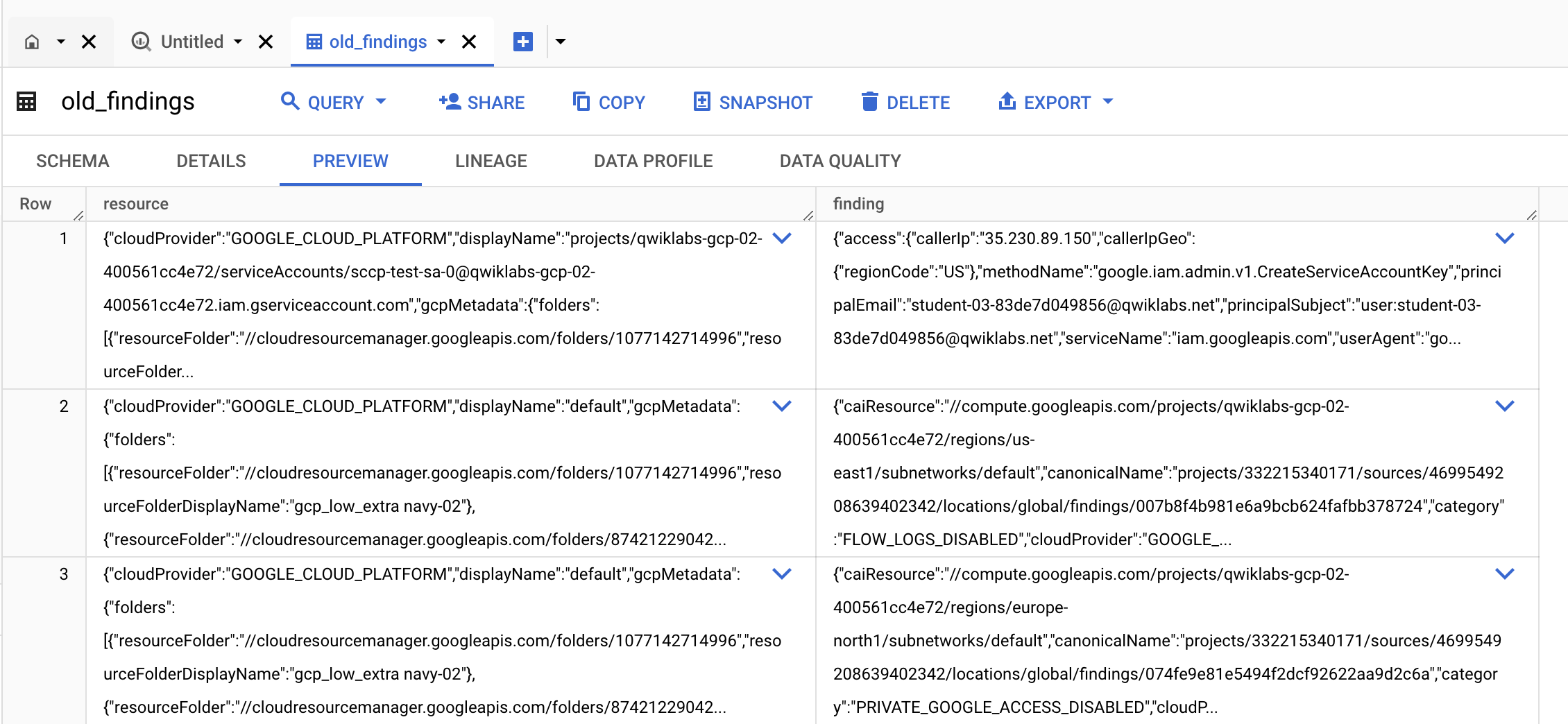

このセクションでは、エクスポートした検出結果データを使用して、BigQuery にテーブルを作成します。

Cloud コンソールのナビゲーション メニュー(

左側の [探索] メニューで、[+ データを追加] ボタンをクリックします。

新しい [データ追加] ウィンドウで、最も人気のあるデータソースとして [Google Cloud Storage] をクリックします。

[外部テーブルまたは BigLake テーブル] をクリックして、GCS データに BigLake テーブルと外部テーブルを手動で作成し、次のパラメータを設定します。

| 設定 | 値 |

|---|---|

| テーブルの作成元 | Google Cloud Storage |

| GCS バケットからファイルを選択 | scc-export-bucket- |

| ファイル形式 | JSONL |

| データセット | continuous_export_dataset |

| テーブル | old_findings |

| テーブルタイプ | Native |

| スキーマ | [テキストとして編集] 切り替えを有効にする |

[テーブルを作成] ボタンをクリックします。

新しいテーブルが作成されたら、通知の [テーブルに移動] リンクをクリックします。

[プレビュー] タブをクリックし、既存の検出結果を表示できることを確認します。

[進行状況を確認] をクリックして、目標に沿って進んでいることを確認します。

このラボでは、Security Command Center について学び、アセットを分析し、検出結果を BigQuery にエクスポートしました。

Google Cloud トレーニングと認定資格を通して、Google Cloud 技術を最大限に活用できるようになります。必要な技術スキルとベスト プラクティスについて取り扱うクラスでは、学習を継続的に進めることができます。トレーニングは基礎レベルから上級レベルまであり、オンデマンド、ライブ、バーチャル参加など、多忙なスケジュールにも対応できるオプションが用意されています。認定資格を取得することで、Google Cloud テクノロジーに関するスキルと知識を証明できます。

マニュアルの最終更新日: 2025 年 6 月 20 日

ラボの最終テスト日: 2025 年 6 月 20 日

Copyright 2025 Google LLC. All rights reserved. Google および Google のロゴは Google LLC の商標です。その他すべての企業名および商品名はそれぞれ各社の商標または登録商標です。

このコンテンツは現在ご利用いただけません

利用可能になりましたら、メールでお知らせいたします

ありがとうございます。

利用可能になりましたら、メールでご連絡いたします

1 回に 1 つのラボ

既存のラボをすべて終了して、このラボを開始することを確認してください