GSP1164

Présentation

Security Command Center (SCC) est une plate-forme de surveillance de la sécurité qui aide les utilisateurs à :

- identifier les erreurs de configuration qui peuvent compromettre la sécurité des ressources Google Cloud ;

- rendre compte des menaces actives dans les environnements Google Cloud ;

- corriger les failles affectant les ressources Google Cloud.

Dans cet atelier, vous allez découvrir Security Command Center en explorant les fonctionnalités d'exportation et d'analyse des ressources du service.

Objectifs

Dans cet atelier, vous allez apprendre à effectuer les tâches suivantes :

- Créer un pipeline d'exportation continue vers Pub/Sub

- Exporter et analyser les résultats SCC dans une table BigQuery

Prérequis

Avant de commencer cet atelier, il est recommandé de maîtriser les éléments suivants :

Préparation

Avant de cliquer sur le bouton "Démarrer l'atelier"

Lisez ces instructions. Les ateliers sont minutés, et vous ne pouvez pas les mettre en pause. Le minuteur, qui démarre lorsque vous cliquez sur Démarrer l'atelier, indique combien de temps les ressources Google Cloud resteront accessibles.

Cet atelier pratique vous permet de suivre les activités dans un véritable environnement cloud, et non dans un environnement de simulation ou de démonstration. Des identifiants temporaires vous sont fournis pour vous permettre de vous connecter à Google Cloud le temps de l'atelier.

Pour réaliser cet atelier :

- Vous devez avoir accès à un navigateur Internet standard (nous vous recommandons d'utiliser Chrome).

Remarque : Ouvrez une fenêtre de navigateur en mode incognito (recommandé) ou de navigation privée pour effectuer cet atelier. Vous éviterez ainsi les conflits entre votre compte personnel et le compte temporaire de participant, qui pourraient entraîner des frais supplémentaires facturés sur votre compte personnel.

- Vous disposez d'un temps limité. N'oubliez pas qu'une fois l'atelier commencé, vous ne pouvez pas le mettre en pause.

Remarque : Utilisez uniquement le compte de participant pour cet atelier. Si vous utilisez un autre compte Google Cloud, des frais peuvent être facturés à ce compte.

Démarrer l'atelier et se connecter à la console Google Cloud

-

Cliquez sur le bouton Démarrer l'atelier. Si l'atelier est payant, une boîte de dialogue s'affiche pour vous permettre de sélectionner un mode de paiement.

Sur la gauche, vous trouverez le panneau "Détails concernant l'atelier", qui contient les éléments suivants :

- Le bouton "Ouvrir la console Google Cloud"

- Le temps restant

- Les identifiants temporaires que vous devez utiliser pour cet atelier

- Des informations complémentaires vous permettant d'effectuer l'atelier

-

Cliquez sur Ouvrir la console Google Cloud (ou effectuez un clic droit et sélectionnez Ouvrir le lien dans la fenêtre de navigation privée si vous utilisez le navigateur Chrome).

L'atelier lance les ressources, puis ouvre la page "Se connecter" dans un nouvel onglet.

Conseil : Réorganisez les onglets dans des fenêtres distinctes, placées côte à côte.

Remarque : Si la boîte de dialogue Sélectionner un compte s'affiche, cliquez sur Utiliser un autre compte.

-

Si nécessaire, copiez le nom d'utilisateur ci-dessous et collez-le dans la boîte de dialogue Se connecter.

{{{user_0.username | "Username"}}}

Vous trouverez également le nom d'utilisateur dans le panneau "Détails concernant l'atelier".

-

Cliquez sur Suivant.

-

Copiez le mot de passe ci-dessous et collez-le dans la boîte de dialogue Bienvenue.

{{{user_0.password | "Password"}}}

Vous trouverez également le mot de passe dans le panneau "Détails concernant l'atelier".

-

Cliquez sur Suivant.

Important : Vous devez utiliser les identifiants fournis pour l'atelier. Ne saisissez pas ceux de votre compte Google Cloud.

Remarque : Si vous utilisez votre propre compte Google Cloud pour cet atelier, des frais supplémentaires peuvent vous être facturés.

-

Accédez aux pages suivantes :

- Acceptez les conditions d'utilisation.

- N'ajoutez pas d'options de récupération ni d'authentification à deux facteurs (ce compte est temporaire).

- Ne vous inscrivez pas à des essais sans frais.

Après quelques instants, la console Cloud s'ouvre dans cet onglet.

Remarque : Pour accéder aux produits et services Google Cloud, cliquez sur le menu de navigation ou saisissez le nom du service ou du produit dans le champ Recherche.

Activer Cloud Shell

Cloud Shell est une machine virtuelle qui contient de nombreux outils pour les développeurs. Elle comprend un répertoire d'accueil persistant de 5 Go et s'exécute sur Google Cloud. Cloud Shell vous permet d'accéder via une ligne de commande à vos ressources Google Cloud.

-

Cliquez sur Activer Cloud Shell  en haut de la console Google Cloud.

en haut de la console Google Cloud.

-

Passez les fenêtres suivantes :

- Accédez à la fenêtre d'informations de Cloud Shell.

- Autorisez Cloud Shell à utiliser vos identifiants pour effectuer des appels d'API Google Cloud.

Une fois connecté, vous êtes en principe authentifié et le projet est défini sur votre ID_PROJET : . Le résultat contient une ligne qui déclare l'ID_PROJET pour cette session :

Your Cloud Platform project in this session is set to {{{project_0.project_id | "PROJECT_ID"}}}

gcloud est l'outil de ligne de commande pour Google Cloud. Il est préinstallé sur Cloud Shell et permet la complétion par tabulation.

- (Facultatif) Vous pouvez lister les noms des comptes actifs à l'aide de cette commande :

gcloud auth list

- Cliquez sur Autoriser.

Résultat :

ACTIVE: *

ACCOUNT: {{{user_0.username | "ACCOUNT"}}}

To set the active account, run:

$ gcloud config set account `ACCOUNT`

- (Facultatif) Vous pouvez lister les ID de projet à l'aide de cette commande :

gcloud config list project

Résultat :

[core]

project = {{{project_0.project_id | "PROJECT_ID"}}}

Remarque : Pour consulter la documentation complète sur gcloud, dans Google Cloud, accédez au guide de présentation de la gcloud CLI.

Scénario

Cymbal Bank est une banque de détail américaine comptant plus de 2 000 agences partout aux États-Unis. Elle propose des services de débit et de crédit adossés à une plateforme de paiement robuste. Cymbal Bank est une banque ancienne qui a désormais entamé sa transformation numérique.

Cymbal Bank a été créée initialement en 1920 sous le nom de Troxler. Après avoir investi massivement dans ses distributeurs automatiques propriétaires, Cymbal Group a acquis l'entreprise en 1975. Devenu l'un des leaders du secteur à l'échelle nationale, l'établissement mise à présent sur la modernisation de l'expérience client : une stratégie déployée tant au sein de ses agences qu'à travers ses services numériques, via une application lancée en 2014. Cymbal Bank emploie 42 000 personnes aux États-Unis et a enregistré un chiffre d'affaires de 24 milliards de dollars en 2019.

Cymbal Bank souhaite intégrer une plate-forme centralisée de surveillance de la sécurité pour contrôler les menaces et corriger les failles des ressources Google Cloud dans ses applications bancaires destinées aux entreprises. En tant qu'ingénieur en sécurité cloud, vous devez vous familiariser avec les fonctionnalités d'exportation et d'analyse de Security Command Center afin de pouvoir présenter les avantages du service au directeur de la technologie.

Tâche 1 : Créer un pipeline d'exportation continue vers Pub/Sub

Security Command Center peut exporter les résultats de sécurité vers des ressources externes à l'aide de plusieurs méthodes, y compris les suivantes :

- Exportations continues vers un ensemble de données BigQuery

- Exportations continues vers Pub/Sub

- Exportations ponctuelles vers des fichiers CSV

- Exportations ponctuelles vers des buckets Cloud Storage sous forme de fichiers JSON

Dans cette tâche, vous allez découvrir comment configurer les exportations continues de résultats vers Pub/Sub.

Remarque : Les exportations continues de résultats ne fonctionnent que pour les résultats nouvellement créés.

Les exportations continues vers Pub/Sub sont généralement utilisées pour transférer les résultats vers des systèmes de gestion de la sécurité externes tels que Splunk ou QRadar.

Dans cet atelier, vous allez exporter vos résultats vers un sujet Pub/Sub, puis simuler une application en récupérant les messages à partir d'un abonnement Pub/Sub.

Remarque : Vous pouvez consulter la page de documentation Qu'est-ce que Pub/Sub ? pour en savoir plus.

Créer un sujet et un abonnement Pub/Sub

Avant de pouvoir configurer une exportation SCC, vous devez d'abord créer un sujet et un abonnement Pub/Sub.

- Dans la barre de titre de la console Google Cloud, saisissez

Pub/Sub dans le champ de recherche et appuyez sur Entrée. Cliquez ensuite sur le premier résultat de recherche, Pub/Sub.

- Cliquez sur le bouton Créer un sujet sur la page Sujets.

- Saisissez

export-findings-pubsub-topic comme ID du sujet.

- Conservez les autres paramètres par défaut, puis cliquez sur Créer.

Cela lance automatiquement le processus de création d'un sujet Pub/Sub et d'un abonnement associé.

-

Cliquez sur Abonnements dans le menu de gauche.

-

Cliquez sur export-findings-pubsub-topic-sub. Si l'abonnement ne s'affiche pas, actualisez la page du navigateur.

Vous obtenez ainsi un tableau de bord de statistiques et de métriques liées aux messages publiés dans cet abonnement.

Créer une exportation continue des résultats

-

Dans la console Cloud, accédez au menu de navigation ( ), puis cliquez sur Sécurité > Aperçu des risques. En haut de la page, cliquez sur Paramètres.

), puis cliquez sur Sécurité > Aperçu des risques. En haut de la page, cliquez sur Paramètres.

-

Cliquez sur l'onglet Exportations continues.

-

Cliquez sur le bouton Créer une exportation Pub/Sub.

-

Pour le Nom de l'exportation continue, saisissez export-findings-pubsub.

-

Pour la Description de l'exportation continue, saisissez Exportations continues des résultats vers Pub/Sub et BigQuery.

-

Pour le Nom du projet, sélectionnez , qui correspond à l'ID du projet dans lequel vous travaillez. (Ne sélectionnez pas "Ressources Qwiklabs".)

-

Dans le champ Sélectionner un sujet Cloud Pub/Sub, sélectionnez projects//topics/export-findings-pubsub-topic.

-

Définissez la requête de résultats comme suit :

state="ACTIVE"

AND NOT mute="MUTED"

Cette requête garantit que tous les nouveaux résultats ACTIVE et NOT MUTED sont transférés vers le sujet Pub/Sub que vous venez de créer.

Remarque : Il est possible qu'un message indique que plusieurs résultats correspondent à la recherche. N'oubliez pas que les résultats existants ne sont pas transférés vers le sujet Pub/Sub.

- Cliquez sur Enregistrer.

Vous avez créé une exportation continue de Security Command Center vers Pub/Sub.

Créer des résultats à exporter vers Pub/Sub

Dans cette section, vous allez créer des résultats et vérifier comment ils sont exportés vers Pub/Sub.

-

Ouvrez une nouvelle session Cloud Shell ( ).

).

-

Exécutez la commande suivante pour créer une machine virtuelle :

gcloud compute instances create instance-1 --zone={{{project_0.default_zone|lab zone}}} \

--machine-type e2-micro \

--scopes=https://www.googleapis.com/auth/cloud-platform

- Assurez-vous que le résultat ressemble à ceci :

Résultat :

NAME: instance-1

ZONE: us-central-a

MACHINE_TYPE: e2-micro

PREEMPTIBLE:

INTERNAL_IP: 10.128.0.2

EXTERNAL_IP: 34.69.82.225

STATUS: RUNNING

Remarque : Si vous recevez un message d'erreur indiquant ERROR: (gcloud.compute.instances.create) You do not currently have an active account selected, réexécutez la commande.

Cette commande crée une instance de VM avec une adresse IP publique et un compte de service par défaut associé.

Cette action génère immédiatement trois nouveaux résultats de recherche de failles :

- Adresse IP publique

- Compte de service par défaut utilisé

- Démarrage sécurisé Compute désactivé

-

Dans la barre de titre de la console Google Cloud, saisissez Pub/Sub dans le champ de recherche et appuyez sur Entrée. Cliquez ensuite sur le premier résultat de recherche, Pub/Sub. Ensuite, cliquez sur Abonnements dans le menu de gauche.

-

Sélectionnez l'abonnement export-findings-pubsub-topic-sub.

-

Cliquez sur l'onglet Messages.

-

Cochez la case Activer la confirmation de messages.

-

Cliquez sur le bouton Extraire.

Vous devriez recevoir une liste de messages dans cet abonnement. Ils concernent l'adresse IP publique, le compte de service par défaut utilisé et les failles liées au démarrage sécurisé Compute désactivé.

Remarque : Vous pouvez cliquer sur le bouton Options d'affichage des colonnes dans la liste des messages pour modifier les détails des messages affichés, y compris body.finding.category pour plus de détails.

En extrayant les messages de l'abonnement Pub/Sub, vous avez simulé le comportement d'une application qui peut transférer ces messages vers un autre système de surveillance de la sécurité, tel que Splunk.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Créer un pipeline d'exportation continue vers Pub/Sub

Tâche 2 : Exporter et analyser les résultats SCC avec BigQuery

Les résultats SCC peuvent également être exportés vers un ensemble de données BigQuery. Cela peut être utile pour créer des tableaux de bord analytiques permettant de vérifier le type de résultats qui apparaît le plus souvent dans votre organisation.

Pour l'instant, la configuration des exportations continues ne peut se faire qu'à l'aide de commandes (et non dans la console).

- Ouvrez une session Cloud Shell (

).

).

- Dans votre session Cloud Shell, exécutez la commande suivante pour créer un ensemble de données BigQuery :

PROJECT_ID=$(gcloud config get project)

bq --location={{{project_0.default_region|lab region}}} --apilog=/dev/null mk --dataset \

$PROJECT_ID:continuous_export_dataset

- Vous n'avez pas encore utilisé d'interface de ligne de commande SCC dans ce projet. Vous devez donc activer le service SCC. Exécutez la commande suivante pour activer le service dans le projet actuel :

gcloud services enable securitycenter.googleapis.com

- Créez maintenant une exportation en saisissant la commande suivante :

gcloud scc bqexports create scc-bq-cont-export --dataset=projects/{{{project_0.project_id}}}/datasets/continuous_export_dataset --project={{{project_0.project_id|PROJECT_ID}}}

Assurez-vous que le message de résultat ressemble à celui-ci :

Résultat :

Created.

dataset: projects/qwiklabs-gcp-04-571fad72c1e8/datasets/continuous_export_dataset

mostRecentEditor: student-03-fbc57ac17933@qwiklabs.net

name: projects/102856953036/bigQueryExports/SCC-bq-cont-export

principal: service-org-616463121992@gcp-sa-scc-notification.iam.gserviceaccount.com

updateTime: '2023-05-31T15:44:22.097585Z'

Une fois que les nouveaux résultats sont exportés vers BigQuery, SCC crée une table. Vous pouvez désormais lancer de nouveaux résultats SCC.

- Exécutez les commandes suivantes pour créer trois comptes de service sans aucune autorisation IAM et créer trois clés de compte de service gérées par l'utilisateur pour ces comptes.

for i in {0..2}; do

gcloud iam service-accounts create sccp-test-sa-$i;

gcloud iam service-accounts keys create /tmp/sa-key-$i.json \

--iam-account=sccp-test-sa-$i@{{{project_0.project_id|PROJECT_ID}}}.iam.gserviceaccount.com;

done

Une fois que de nouveaux résultats sont créés dans SCC, ils sont exportés vers BigQuery. Pour les stocker, le pipeline d'exportation crée une table appelée findings.

- Exécutez la commande suivante pour récupérer des informations sur les résultats nouvellement créés dans BigQuery :

bq query --apilog=/dev/null --use_legacy_sql=false \

"SELECT finding_id,event_time,finding.category FROM continuous_export_dataset.findings"

Vous devriez rapidement obtenir un résultat semblable à celui-ci :

Résultat :

+----------------------------------+---------------------+------------------------------------------+

| finding_id | event_time | category |

+----------------------------------+---------------------+------------------------------------------+

| c5235ebb04b140198874ce52080422b8 | 2024-11-27 08:08:08 | Persistence: Service Account Key Created |

| 94d933ee9803d0f1c807551fd22a0269 | 2024-11-27 08:08:04 | USER_MANAGED_SERVICE_ACCOUNT_KEY |

+----------------------------------+---------------------+------------------------------------------+

Remarque : La génération de ces résultats peut prendre plus de 10 minutes. Si vous n'obtenez pas un résultat semblable, réexécutez la commande ci-dessus.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Exporter les résultats vers un ensemble de données BigQuery

Exporter les résultats vers un bucket Cloud Storage et créer une table BigQuery

Security Command Center est généralement activé dans des infrastructures Google Cloud préexistantes et matures. Dès que SCC est activé, il commence à analyser les failles existantes et peut finir par signaler des milliers de résultats sur l'infrastructure existante.

L'interface SCC n'est peut-être pas le meilleur moyen de trier et de filtrer ces résultats. Il est donc courant de les exporter vers une base de données BigQuery pour les analyser.

L'exportation directe des résultats vers BigQuery n'est pas encore prise en charge. Vous pouvez plutôt utiliser un bucket Google Cloud Storage comme solution de stockage intermédiaire.

Créer un bucket Cloud Storage

Pour exporter les résultats existants vers une interface BigQuery, vous devez d'abord les exporter vers un bucket Cloud Storage.

Dans cette section, vous allez créer le bucket de stockage.

-

Dans la console Cloud, accédez au menu de navigation ( ), puis cliquez sur Cloud Storage > Buckets.

), puis cliquez sur Cloud Storage > Buckets.

-

Cliquez sur le bouton Créer.

-

Chaque nom de bucket dans Google Cloud doit être unique. Définissez le nom du bucket sur scc-export-bucket-.

-

Cliquez sur Continuer.

-

Définissez le Type d'emplacement sur Région.

-

Comme localisation, sélectionnez .

-

Ne modifiez aucun autre paramètre. Faites défiler la page vers le bas et cliquez sur Créer.

-

Cliquez sur le bouton Confirmer lorsque vous êtes invité à "Appliquer la protection contre l'accès public" sur ce bucket.

Exporter les résultats existants sous forme de données JSONL

Dans cette section, vous allez exporter vos résultats pour les utiliser dans une base de données BigQuery.

-

Dans la console Cloud, accédez au menu de navigation ( ), puis cliquez sur Sécurité > Résultats.

), puis cliquez sur Sécurité > Résultats.

-

Cliquez sur le bouton Exporter.

-

Dans la liste déroulante, sélectionnez Cloud Storage.

-

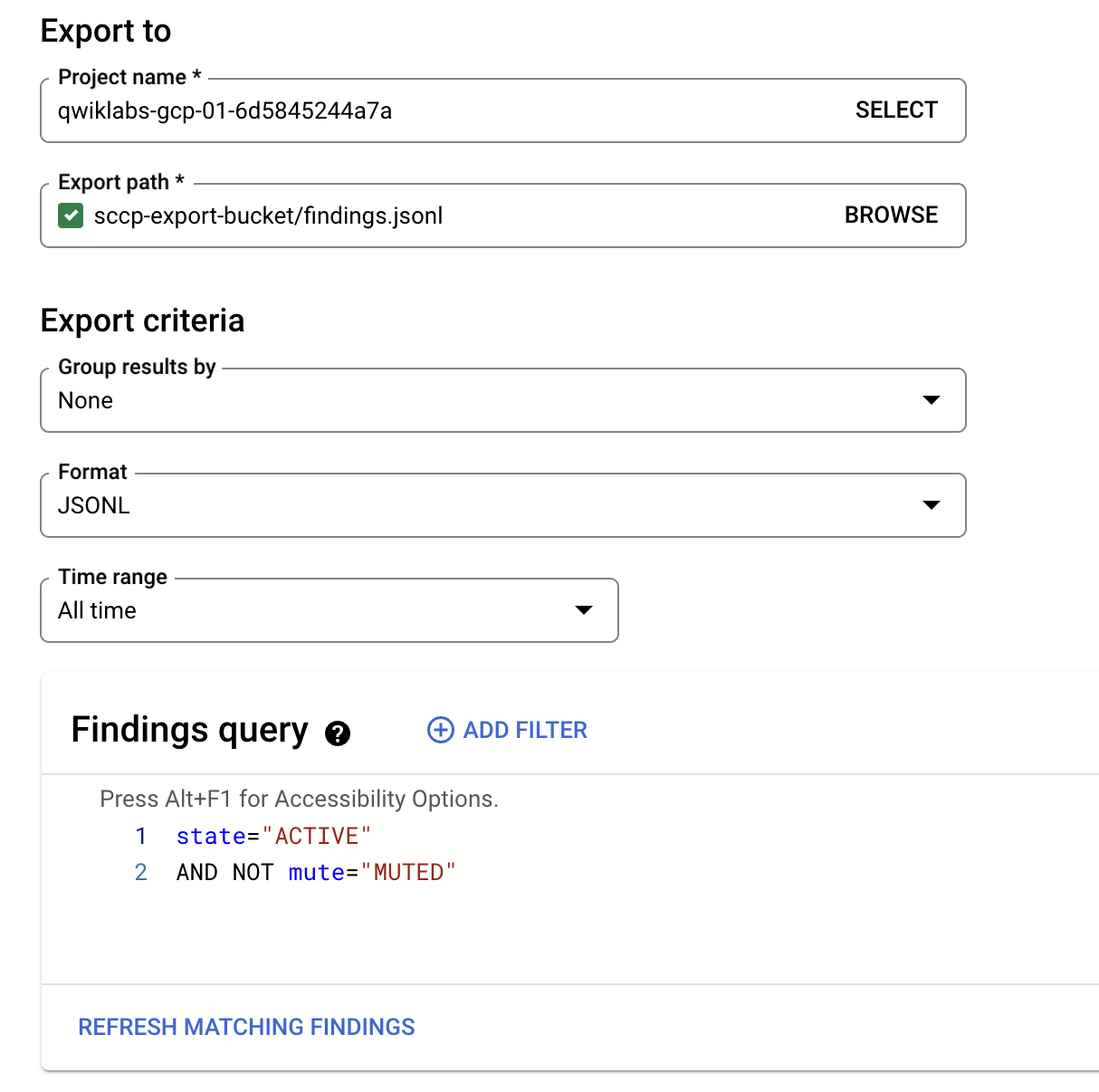

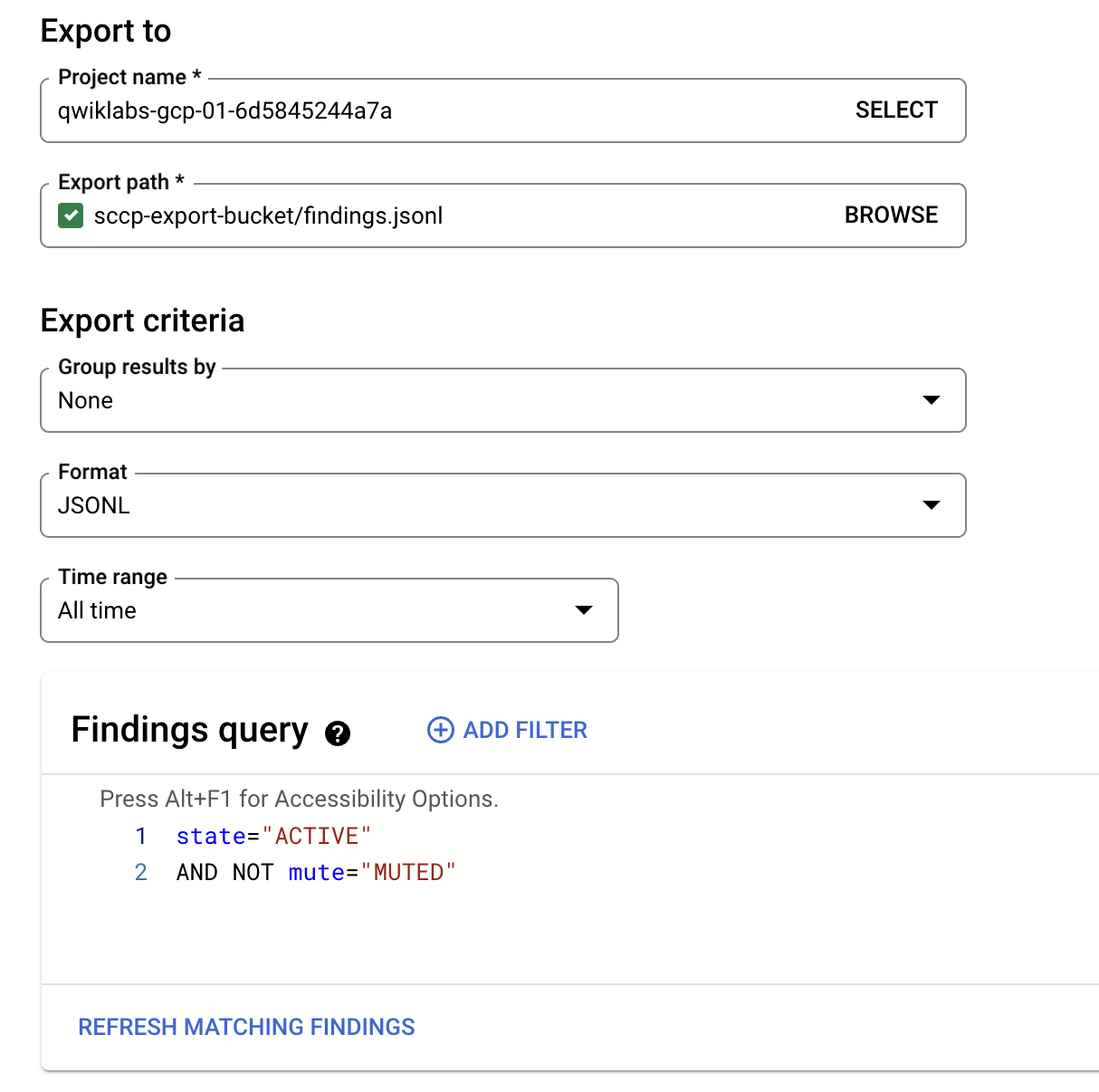

Pour le nom du projet, sélectionnez l'ID du projet (ne sélectionnez pas "Ressources Qwiklabs").

-

Sélectionnez ensuite le chemin d'exportation en cliquant sur le bouton Parcourir.

-

Cliquez sur la flèche à côté du bouton scc-export-bucket-.

-

Définissez le nom de fichier sur findings.jsonl et cliquez sur Sélectionner.

-

Dans la liste déroulante "Format", sélectionnez JSONL.

-

Définissez la période sur Toute la période.

Ne modifiez pas la requête de résultats par défaut.

Le formulaire final "Exporter vers" doit ressembler à ce qui suit.

- Cliquez sur le bouton Exporter.

Créer une table dans BigQuery

Dans cette section, vous allez utiliser les données des résultats exportés pour créer une table dans BigQuery.

-

Dans la console Cloud, accédez au menu de navigation ( ), puis cliquez sur BigQuery > Studio.

), puis cliquez sur BigQuery > Studio.

-

Dans le menu Explorer à gauche, cliquez sur le bouton + Ajouter des données.

-

Dans la nouvelle fenêtre Ajouter des données, cliquez sur Google Cloud Storage parmi les sources de données les plus populaires.

-

Cliquez sur Table externe ou BigLake pour créer manuellement des tables BigLake/externes sur des données GCS et définissez les paramètres suivants :

| Paramètre |

Valeur |

| Créer une table à partir de |

Google Cloud Storage |

| Sélectionner un fichier depuis le bucket GCS |

scc-export-bucket-/findings.jsonl |

| Format de fichier |

JSONL |

| Ensemble de données |

continuous_export_dataset |

| Table |

old_findings |

| Type de table |

Native |

| Schéma |

Activez le bouton "Modifier sous forme de texte". |

- Collez ensuite le schéma suivant :

[

{

"mode": "NULLABLE",

"name": "resource",

"type": "JSON"

},

{

"mode": "NULLABLE",

"name": "finding",

"type": "JSON"

}

]

-

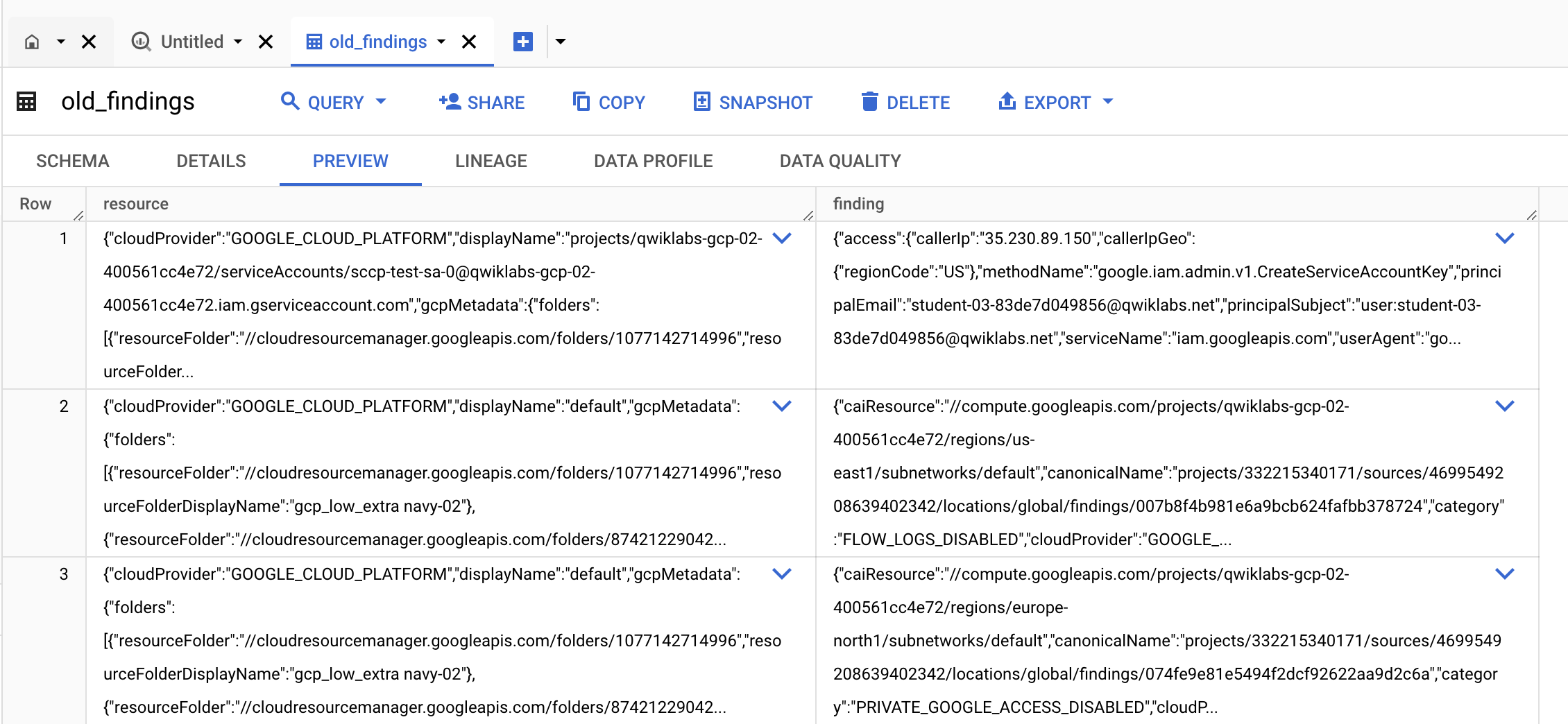

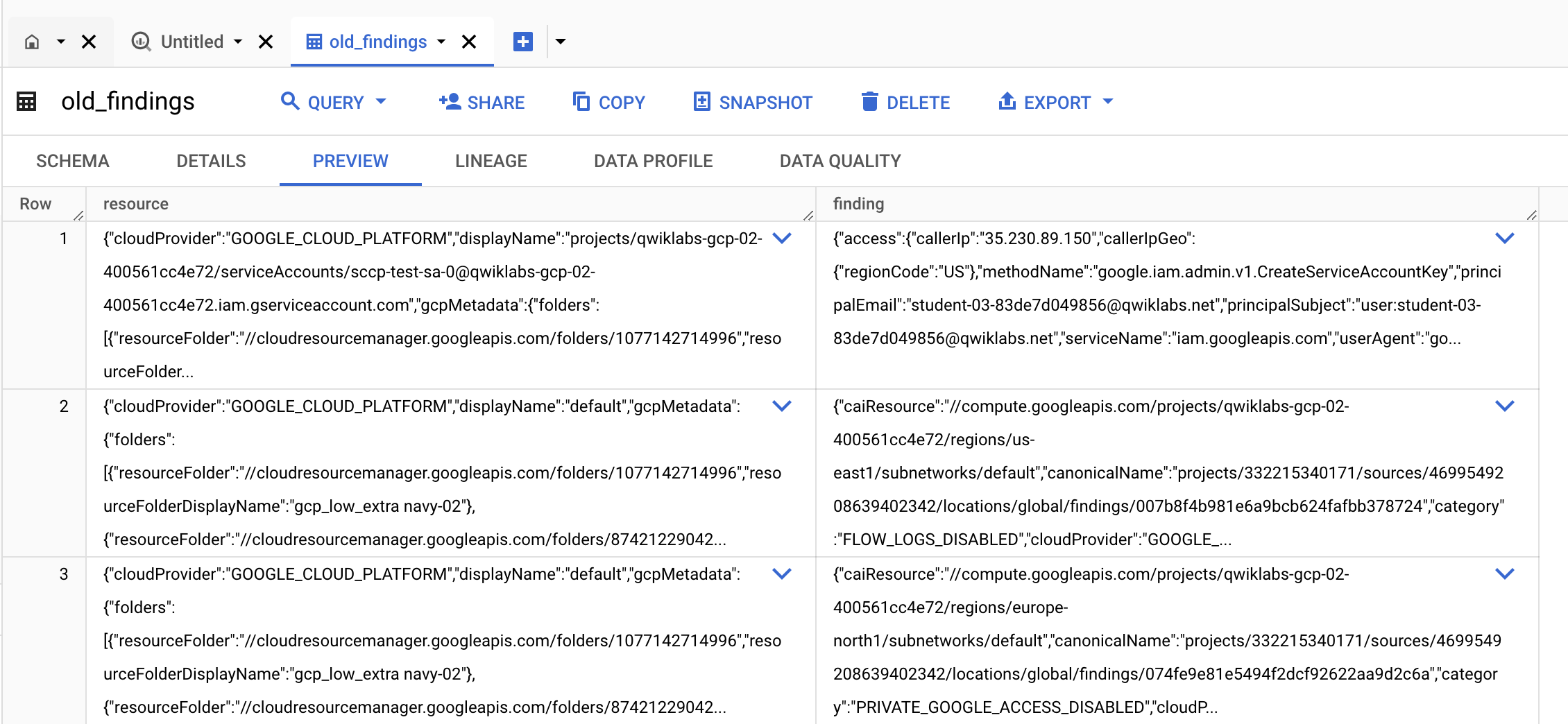

Cliquez sur le bouton Créer une table.

-

Une fois la table créée, cliquez sur le lien Accéder à la table dans la notification.

-

Cliquez sur l'onglet Aperçu et vérifiez que vous pouvez voir vos résultats existants.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Exporter les résultats vers un bucket Cloud Storage et créer une table BigQuery

Félicitations !

Dans cet atelier, vous avez découvert Security Command Center, analysé des ressources et exporté des résultats vers BigQuery.

Étapes suivantes et informations supplémentaires

Formations et certifications Google Cloud

Les formations et certifications Google Cloud vous aident à tirer pleinement parti des technologies Google Cloud. Nos cours portent sur les compétences techniques et les bonnes pratiques à suivre pour être rapidement opérationnel et poursuivre votre apprentissage. Nous proposons des formations pour tous les niveaux, à la demande, en salle et à distance, pour nous adapter aux emplois du temps de chacun. Les certifications vous permettent de valider et de démontrer vos compétences et votre expérience en matière de technologies Google Cloud.

Dernière mise à jour du manuel : 20 juin 2025

Dernier test de l'atelier : 20 juin 2025

Copyright 2025 Google LLC. Tous droits réservés. Google et le logo Google sont des marques de Google LLC. Tous les autres noms d'entreprises et de produits peuvent être des marques des entreprises auxquelles ils sont associés.

en haut de la console Google Cloud.

en haut de la console Google Cloud.

), puis cliquez sur Sécurité > Aperçu des risques. En haut de la page, cliquez sur Paramètres.

), puis cliquez sur Sécurité > Aperçu des risques. En haut de la page, cliquez sur Paramètres.