GSP1158

Informações gerais

O Dataplex Universal Catalog é a malha de dados inteligente usada em empresas para descobrir, gerenciar, monitorar e supervisionar em um só lugar os dados em data lakes, data warehouses e data marts para potencializar a análise em grande escala.

O Dataplex Universal Catalog inclui uma funcionalidade muito útil para configurar e executar verificações de qualidade de dados em recursos como tabelas do BigQuery e arquivos do Cloud Storage. Por isso, é possível integrar tarefas de qualidade de dados do Dataplex em fluxos de trabalho diários. Por exemplo, ao validar dados de um pipeline de produção, monitorar regularmente a qualidade dos dados com base en um conjunto de critérios e criar relatórios de qualidade de dados voltados aos requisitos regulatórios.

Neste laboratório, você vai aprender a avaliar a qualidade de dados com o Dataplex Universal Catalog, criando um arquivo personalizado de especificação de qualidade para configurar e executar um job de verificação nos dados do BigQuery.

Atividades deste laboratório

- Criar um lake, uma zona e um recurso do Dataplex Universal Catalog

- Consultar uma tabela do BigQuery para analisar a qualidade de dados

- Criar e fazer o upload de um arquivo de especificação de qualidade de dados

- Definir e executar um job de qualidade de dados

- Analisar os resultados de um job de qualidade de dados

Configuração e requisitos

Antes de clicar no botão Começar o Laboratório

Leia estas instruções. Os laboratórios são cronometrados e não podem ser pausados. O timer é ativado quando você clica em Iniciar laboratório e mostra por quanto tempo os recursos do Google Cloud vão ficar disponíveis.

Este laboratório prático permite que você realize as atividades em um ambiente real de nuvem, e não em uma simulação ou demonstração. Você vai receber novas credenciais temporárias para fazer login e acessar o Google Cloud durante o laboratório.

Confira os requisitos para concluir o laboratório:

- Acesso a um navegador de Internet padrão (recomendamos o Chrome).

Observação: para executar este laboratório, use o modo de navegação anônima (recomendado) ou uma janela anônima do navegador. Isso evita conflitos entre sua conta pessoal e de estudante, o que poderia causar cobranças extras na sua conta pessoal.

- Tempo para concluir o laboratório: não se esqueça que, depois de começar, não será possível pausar o laboratório.

Observação: use apenas a conta de estudante neste laboratório. Se usar outra conta do Google Cloud, você poderá receber cobranças nela.

Como iniciar seu laboratório e fazer login no console do Google Cloud

-

Clique no botão Começar o laboratório. Se for preciso pagar por ele, uma caixa de diálogo vai aparecer para você selecionar a forma de pagamento.

No painel Detalhes do Laboratório, à esquerda, você vai encontrar o seguinte:

- O botão Abrir Console do Google Cloud

- O tempo restante

- As credenciais temporárias que você vai usar neste laboratório

- Outras informações, se forem necessárias

-

Se você estiver usando o navegador Chrome, clique em Abrir console do Google Cloud ou clique com o botão direito do mouse e selecione Abrir link em uma janela anônima.

O laboratório ativa os recursos e depois abre a página Fazer Login em outra guia.

Dica: coloque as guias em janelas separadas lado a lado.

Observação: se aparecer a caixa de diálogo Escolher uma conta, clique em Usar outra conta.

-

Se necessário, copie o Nome de usuário abaixo e cole na caixa de diálogo Fazer login.

{{{user_0.username | "Username"}}}

Você também encontra o nome de usuário no painel Detalhes do Laboratório.

-

Clique em Próxima.

-

Copie a Senha abaixo e cole na caixa de diálogo de Olá.

{{{user_0.password | "Password"}}}

Você também encontra a senha no painel Detalhes do Laboratório.

-

Clique em Próxima.

Importante: você precisa usar as credenciais fornecidas no laboratório, e não as da sua conta do Google Cloud.

Observação: se você usar sua própria conta do Google Cloud neste laboratório, é possível que receba cobranças adicionais.

-

Acesse as próximas páginas:

- Aceite os Termos e Condições.

- Não adicione opções de recuperação nem autenticação de dois fatores (porque essa é uma conta temporária).

- Não se inscreva em testes gratuitos.

Depois de alguns instantes, o console do Google Cloud será aberto nesta guia.

Observação: para acessar os produtos e serviços do Google Cloud, clique no Menu de navegação ou digite o nome do serviço ou produto no campo Pesquisar.

Ativar o Cloud Shell

O Cloud Shell é uma máquina virtual com várias ferramentas de desenvolvimento. Ele tem um diretório principal permanente de 5 GB e é executado no Google Cloud. O Cloud Shell oferece acesso de linha de comando aos recursos do Google Cloud.

-

Clique em Ativar o Cloud Shell  na parte de cima do console do Google Cloud.

na parte de cima do console do Google Cloud.

-

Clique nas seguintes janelas:

- Continue na janela de informações do Cloud Shell.

- Autorize o Cloud Shell a usar suas credenciais para fazer chamadas de APIs do Google Cloud.

Depois de se conectar, você verá que sua conta já está autenticada e que o projeto está configurado com seu Project_ID, . A saída contém uma linha que declara o projeto PROJECT_ID para esta sessão:

Your Cloud Platform project in this session is set to {{{project_0.project_id | "PROJECT_ID"}}}

A gcloud é a ferramenta de linha de comando do Google Cloud. Ela vem pré-instalada no Cloud Shell e aceita preenchimento com tabulação.

- (Opcional) É possível listar o nome da conta ativa usando este comando:

gcloud auth list

- Clique em Autorizar.

Saída:

ACTIVE: *

ACCOUNT: {{{user_0.username | "ACCOUNT"}}}

To set the active account, run:

$ gcloud config set account `ACCOUNT`

- (Opcional) É possível listar o ID do projeto usando este comando:

gcloud config list project

Saída:

[core]

project = {{{project_0.project_id | "PROJECT_ID"}}}

Observação: consulte a documentação completa da gcloud no Google Cloud no guia de visão geral da gcloud CLI.

Ativar a API Dataproc

-

Na barra de título do console do Google Cloud, digite API Cloud Dataproc no campo Pesquisar e clique em API Cloud Dataproc nos resultados da pesquisa.

-

Clique em Ativar se ainda não estiver ativado.

Tarefa 1: criar um data lake, uma zona e um recurso no Dataplex

Para definir e executar tarefas de qualidade de dados, você precisa de alguns recursos do Dataplex Universal Catalog.

Nesta tarefa, você vai criar um data lake do Dataplex Universal Catalog para armazenar informações de um cliente de e-commerce, adicionar uma zona de originais ao data lake e, depois, anexar um conjunto de dados pré-criado do BigQuery como um novo recurso na zona.

Criar um lake

- No console do Google Cloud, no Menu de navegação (

)> Ver todos os produtos, acesse Analytics > Dataplex Universal Catalog.

)> Ver todos os produtos, acesse Analytics > Dataplex Universal Catalog.

Se a mensagem Welcome to the new Dataplex Universal Catalog experience aparecer, clique em Fechar.

-

Em Gerenciar lakes, clique em Gerenciar.

-

Clique em Criar lake.

-

Insira as informações necessárias para criar um lake, conforme descrito abaixo. Mantenha os valores padrão em todos os outros campos.

| Propriedade |

Valor |

| Nome de exibição |

Lake de e-commerce |

| Região |

|

- Clique em Criar.

A criação do lake pode levar até três minutos.

Adicionar uma zona ao lake

-

Na guia Gerenciar, clique no nome do seu lake.

-

Clique em ADICIONAR ZONA.

-

Insira as informações necessárias para criar uma nova zona, conforme descrito abaixo. Mantenha os valores padrão em todos os outros campos.

| Propriedade |

Valor |

| Nome de exibição |

Zona de originais de contato do cliente |

| Tipo |

Zona de originais |

| Locais dos dados |

Regional |

- Clique em Criar.

Pode levar até 2 minutos para a criação da zona.

Observação: quando o status da zona mudar para Ativo, prossiga para a próxima tarefa.

Anexar um recurso a uma zona

-

Na guia Zonas, clique em Zona de originais de contato do cliente.

-

Na guia Recursos, clique em Adicionar recurso.

-

Clique em Adicionar um recurso.

-

Insira as informações necessárias para anexar um novo recurso, conforme especificado abaixo. Deixe os outros campos com os valores padrão.

| Propriedade |

Valor |

| Tipo |

Conjunto de dados do BigQuery |

| Nome de exibição |

Dados de contato |

| Conjunto de dados |

.customers |

-

Clique em Concluído.

-

Clique em Continuar.

-

Em Configurações de descoberta, selecione Herdar para herdar as configurações de descoberta no nível da zona e clique em Continuar.

-

Clique em Enviar.

Clique em Verificar meu progresso para conferir o objetivo.

Criar um lake, uma zona e um recurso no Dataplex Universal Catalog

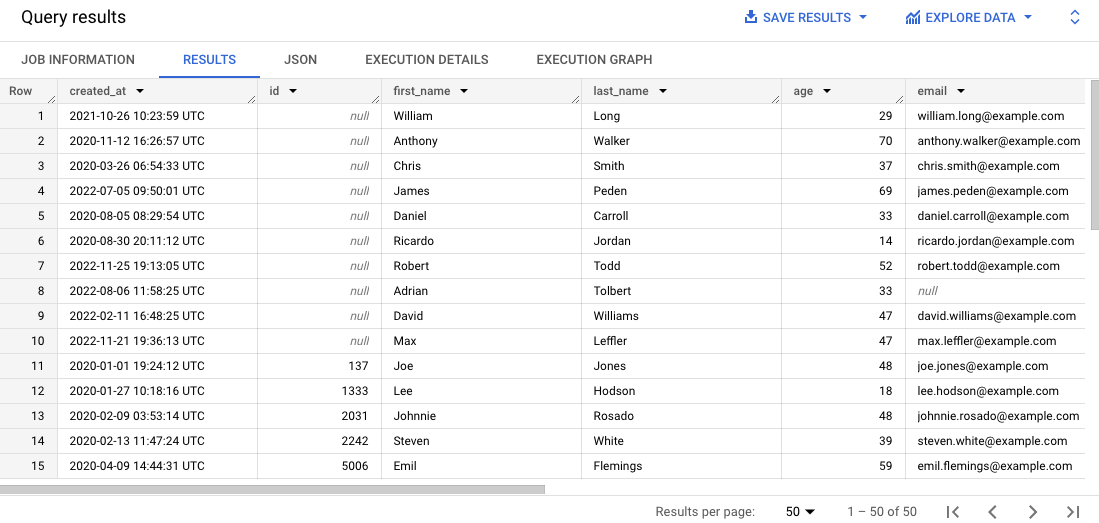

Tarefa 2: consultar uma tabela do BigQuery para analisar a qualidade de dados

Este laboratório usa dois conjuntos de dados do BigQuery pré-criados:

-

customers: contém uma tabela chamada contact_info, que inclui dados de contato de clientes, como ID, nome, e-mail e muito mais. É essa tabela que você vai analisar em busca de problemas de qualidade de dados neste laboratório.

-

customers_dq_dataset: não contém nenhuma tabela. Em uma próxima tarefa, você vai criar um job de qualidade de dados e vai usar esse conjunto como destino para uma nova tabela contendo os resultados do job.

Nesta tarefa, você vai consultar o conjunto de dados customers para identificar problemas de qualidade de dados que podem ser incluídos como verificações em um job desse tipo. Você também vai especificar o conjunto de dados customers_dq_dataset para armazenar os resultados do job de qualidade de dados em uma tarefa posterior.

Abrir o console do BigQuery

- No Console do Google Cloud, selecione o menu de navegação > BigQuery:

Você verá a caixa de mensagem Olá! Este é o BigQuery no Console do Cloud. Ela tem um link para o guia de início rápido e as notas de lançamento.

- Clique em OK.

O console do BigQuery vai abrir.

Consultar a tabela contact_info

- No painel Explorer, clique na seta de expansão ao lado do ID do projeto () para listar o conteúdo.

Três conjuntos de dados vão aparecer:

- customer_contact_raw_zone

- customers

- customers_dq_dataset

- No Editor SQL, clique em Consulta SQL (+). Cole a consulta a seguir e clique em Executar:

SELECT * FROM `{{{project_0.project_id}}}.customers.contact_info`

ORDER BY id

LIMIT 50

Essa consulta seleciona 50 registros da tabela original, ordenados por ID do cliente nos resultados.

-

Veja as descobertas no painel Resultados.

Alguns registros não têm IDs de clientes ou estão com os e-mails incorretos, o que pode dificultar a ordenação.

Clique em Verificar meu progresso para conferir o objetivo.

Consultar uma tabela do BigQuery para analisar a qualidade de dados

Tarefa 3: criar e fazer o upload de um arquivo de especificação de qualidade de dados

Os requisitos de verificação de qualidade de dados do Dataplex são definidos nos arquivos de especificação YAML do CloudDQ. Depois de criado, esse arquivo é enviado para um bucket do Cloud Storage que fica acessível ao job de qualidade de dados.

O arquivo YAML tem quatro seções principais:

- Uma lista de regras a serem executadas (regras predefinidas ou personalizadas)

- Filtros de linha para selecionar um subconjunto de dados para validação

- Vinculações para aplicar às regras definidas das tabelas

- Dimensões opcionais para especificar os tipos de regras que o arquivo YAML pode incluir

Nessa tarefa, você vai definir um novo arquivo de especificação YAML para verificações de qualidade de dados que detectam IDs de cliente e e-mails nulos na tabela especificada do BigQuery. Você também vai especificar um conjunto de dados pré-criado do BigQuery chamado customer_dq_dataset para armazenar os resultados da qualidade de dados em uma tabela chamada dq_results.

Depois de escolher o arquivo, faça o upload dele em um bucket pré-criado do Cloud Storage. Ele será usado em uma tarefa posterior de análise de qualidade de dados.

Criar o arquivo de especificação de qualidade de dados

- No Cloud Shell, execute o seguinte comando para criar um novo arquivo vazio de especificação de qualidade de dados:

nano dq-customer-raw-data.yaml

- Cole o código a seguir no arquivo:

rules:

- nonNullExpectation: {}

column: id

dimension: COMPLETENESS

threshold: 1

- regexExpectation:

regex: '^[^@]+[@]{1}[^@]+$'

column: email

dimension: CONFORMANCE

ignoreNull: true

threshold: .85

postScanActions:

bigqueryExport:

resultsTable: projects/{{{project_0.project_id | Project ID}}}/datasets/customers_dq_dataset/tables/dq_results

- Revise o código para identificar as duas regras primárias de qualidade de dados definidas no arquivo.

O arquivo dq-customer-raw-data.yaml especifica duas regras:

- A primeira se refere à dimensão de integridade, como valores nulos.

- A segunda se refere à dimensão de conformidade, como valores inválidos.

Nesse arquivo, as duas regras estão vinculadas a colunas específicas da tabela:

- A primeira vinculação associa uma regra notNullExpectation à coluna id da tabela contact_info com um limite de 100%, que valida se essa coluna tem algum valor NULL.

- A segunda vinculação associa a regra regexExpectation à coluna e-mail da tabela contact_info com um limite de 85%, que verifica se há e-mails válidos.

- Pressione

Ctrl+X e Y para salvar e fechar o arquivo.

Fazer upload do arquivo no Cloud Storage

- No Cloud Shell, execute o seguinte comando para fazer o upload do arquivo em um bucket do Cloud Storage:

gsutil cp dq-customer-raw-data.yaml gs://{{{project_0.project_id | Project ID}}}-bucket

Clique em Verificar meu progresso para conferir o objetivo.

Criar e fazer o upload de um arquivo de especificação de qualidade de dados

Tarefa 4: definir e executar um job de qualidade de dados automático no Dataplex

O processo de qualidade de dados usa um arquivo YAML de especificação de qualidade de dados para executar um job desse tipo e gera métricas que são gravadas em um conjunto de dados do BigQuery.

Nesta tarefa, você vai definir e executar um job de qualidade de dados automático usando o arquivo YAML de especificação de qualidade de dados no Cloud Storage. Na configuração do job, você também precisa especificar o conjunto de dados customer_dq_dataset para armazenar os resultados.

- No Cloud Shell, execute o seguinte comando para criar uma verificação de qualidade de dados:

gcloud dataplex datascans create data-quality customer-orders-data-quality-job \

--project={{{project_0.project_id | Project ID}}} \

--location={{{project_0.default_region | Region}}} \

--data-source-resource="//bigquery.googleapis.com/projects/{{{project_0.project_id | Project ID}}}/datasets/customers/tables/contact_info" \

--data-quality-spec-file="gs://{{{project_0.project_id | Project ID}}}-bucket/dq-customer-raw-data.yaml"

Observação: neste laboratório, a conta de serviço padrão do Compute Engine já foi pré-configurada com os papéis e permissões do IAM apropriados. Para mais informações, revise a documentação do Dataplex Universal Catalog Criar uma conta de serviço.

-

Volte para o console. Você ainda deve estar no Dataplex Universal Catalog.

-

Em Governar, clique em Qualidade e criação de perfil de dados.

-

Clique em customer-orders-data-quality-job.

-

Clique em Executar agora.

Observação: pode levar alguns muitos para a conclusão do job.

Quando o job for concluído, o status dele será 1 dimension 1 rule failed.

- Clique em Ver resultados.

Você vai notar que a regra de qualidade de dados para a coluna e-mail será Aprovada, mas para a coluna id, será Reprovada. Isso é esperado porque:

-

A regra para a coluna id é uma Null Check com um limite de 100%. Isso significa que, para a regra ser aprovada, todas as linhas precisam ter um valor para o ID. Nesse caso, 10% das linhas da coluna id da tabela contact_info têm valores null. Portanto, essa regra resulta em falha.

-

A regra para a coluna e-mail é uma Regex Check com um limite de 85%. Isso significa que a regra vai falhar se 15% dos registros tiverem um formato de e-mail inválido. Nesse caso, ~10,5% das linhas da coluna e-mail da tabela contact_info têm e-mails inválidos. Portanto, essa regra foi Aprovada.

Clique em Verificar meu progresso para conferir o objetivo.

Definir e executar um job de qualidade de dados no Dataplex Universal Catalog

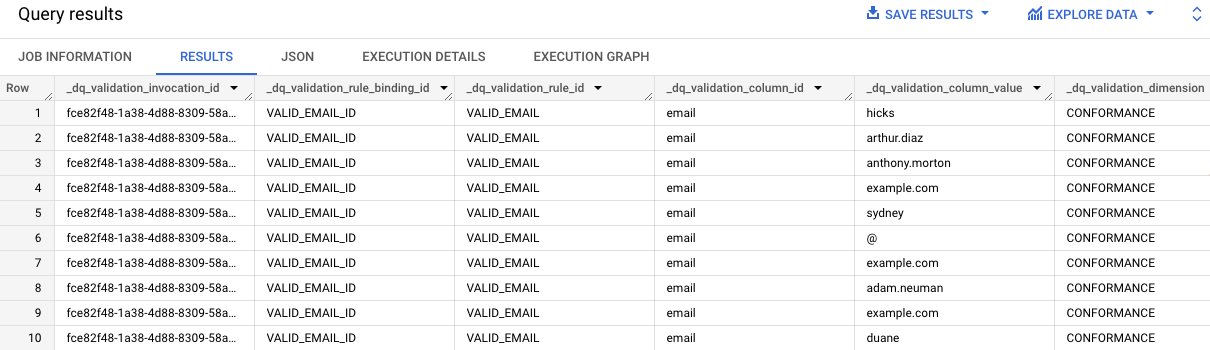

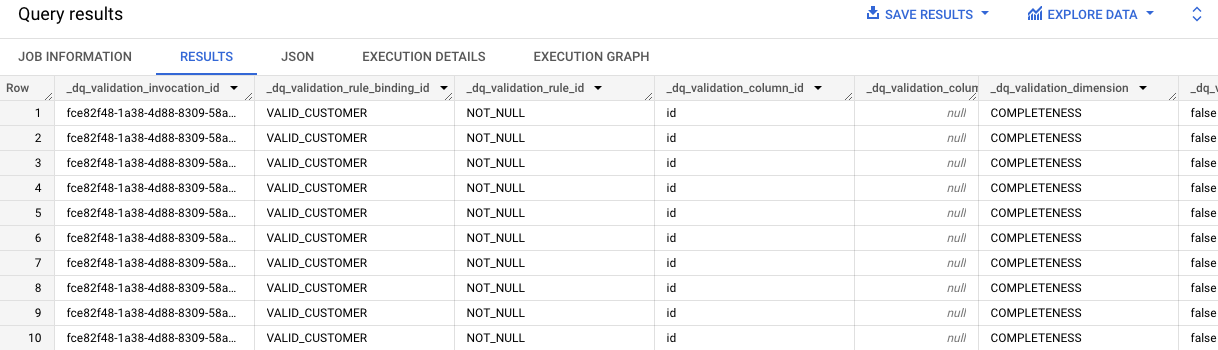

Tarefa 5: analisar os resultados de qualidade de dados no BigQuery

Nessa tarefa, você vai revisar as tabelas em clients_dq_dataset para identificar os registros que não têm IDs de clientes ou que têm valores de e-mails incorretos.

-

Volte ao BigQuery e, no painel Explorer, abra a seta ao lado do ID do projeto para listar o conteúdo:

-

Clique na seta de expansão ao lado do conjunto de dados customer_dq_dataset.

-

Clique na tabela dq_results.

-

Clique na guia Visualização para conferir os resultados.

-

Role até a coluna chamada rule_failed_records_query.

-

Copie a consulta, que começa com WITH.

-

Clique em Consulta SQL (+). Copie e cole a consulta no Editor SQL e clique em Executar.

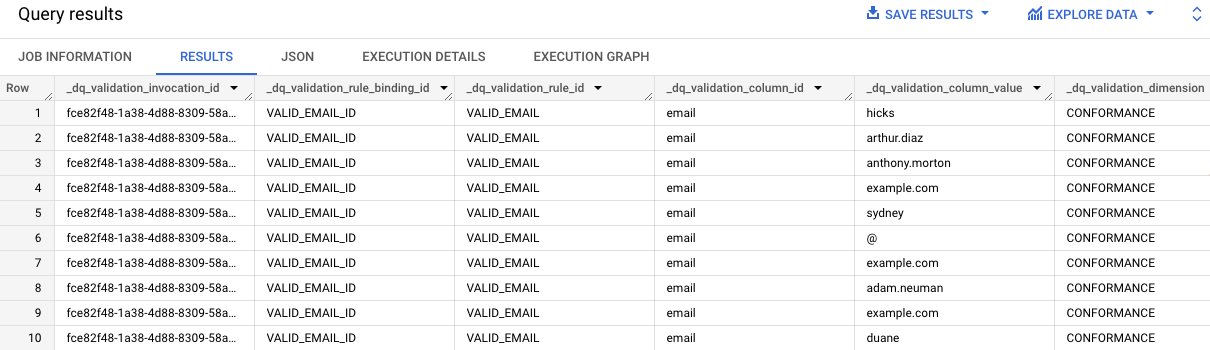

Os resultados da consulta mostram os valores de e-mail inválidos no campo contact_info. Você vai ver "e-mail" em cada entrada na coluna dq_validation_column_id.

-

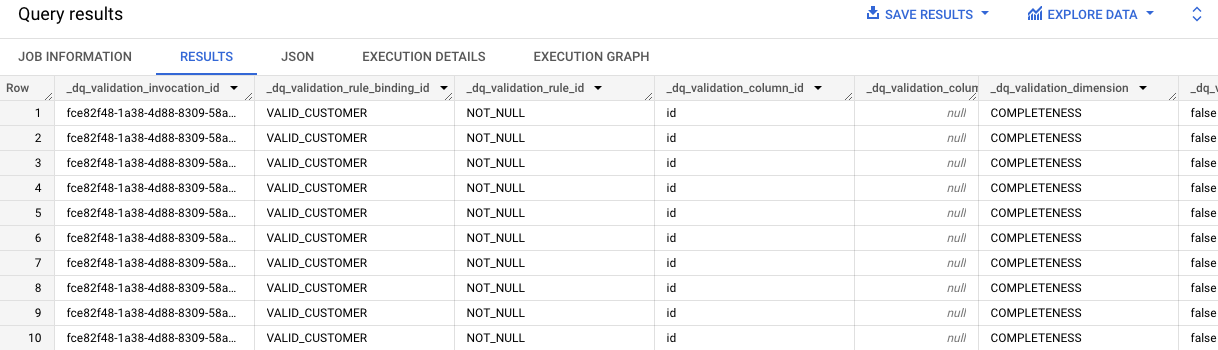

Repita as etapas 7 a 8 para a segunda célula que contém a consulta referente aos resultados da regra VALID_CUSTOMER.

Na consulta, identificamos que existem 10 registros na tabela contact_info sem valores de ID.

Você verá "id" em cada entrada da coluna dq_validation_column_id.

Clique em Verificar meu progresso para conferir o objetivo.

Analisar os resultados de qualidade de dados na tabela do BigQuery

Parabéns!

Você aprendeu a analisar a qualidade de dados com o Dataplex Universal Catalog, criando um arquivo personalizado de especificação de qualidade para executar um job de verificação dos dados em uma tabela do BigQuery.

Treinamento e certificação do Google Cloud

Esses treinamentos ajudam você a aproveitar as tecnologias do Google Cloud ao máximo. Nossas aulas incluem habilidades técnicas e práticas recomendadas para ajudar você a alcançar rapidamente o nível esperado e continuar sua jornada de aprendizado. Oferecemos treinamentos que vão do nível básico ao avançado, com opções de aulas virtuais, sob demanda e por meio de transmissões ao vivo para que você possa encaixá-las na correria do seu dia a dia. As certificações validam sua experiência e comprovam suas habilidades com as tecnologias do Google Cloud.

Manual atualizado em 2 de setembro de 2025.

Laboratório testado em 2 de setembro de 2025.

Copyright 2025 Google LLC. Todos os direitos reservados. Google e o logotipo do Google são marcas registradas da Google LLC. Todos os outros nomes de produtos e empresas podem ser marcas registradas das respectivas empresas a que estão associados.

na parte de cima do console do Google Cloud.

na parte de cima do console do Google Cloud. )> Ver todos os produtos, acesse Analytics > Dataplex Universal Catalog.

)> Ver todos os produtos, acesse Analytics > Dataplex Universal Catalog.