GSP1158

Ringkasan

Dataplex Universal Catalog adalah data fabric cerdas yang memungkinkan organisasi menemukan, mengelola, memantau, dan menata kelola data secara terpusat di seluruh data lake, data warehouse, dan data mart untuk mendukung analisis dalam skala besar.

Salah satu fitur Dataplex Universal Catalog yang sangat bermanfaat adalah kemampuannya untuk menetapkan dan menjalankan pemeriksaan kualitas data pada aset Dataplex Universal Catalog seperti tabel BigQuery dan file Cloud Storage. Dengan menggunakan tugas kualitas data Dataplex, Anda dapat mengintegrasikan pemeriksaan kualitas data ke alur kerja sehari-hari dengan cara memvalidasi data yang menjadi bagian dari pipeline produksi data, memantau kualitas data secara reguler mengikuti sejumlah kriteria, dan membuat laporan kualitas data untuk memenuhi persyaratan peraturan.

Di lab ini, Anda akan mempelajari cara menilai kualitas data menggunakan Dataplex Universal Catalog dengan membuat file spesifikasi kualitas data khusus serta menggunakannya untuk menetapkan dan menjalankan tugas kualitas data di data BigQuery.

Yang akan Anda lakukan

- Membuat data lake, zona, dan aset di Dataplex Universal Catalog.

- Mengkueri tabel BigQuery untuk meninjau kualitas data.

- Membuat dan mengupload file spesifikasi kualitas data.

- Menetapkan dan menjalankan tugas kualitas data.

- Meninjau hasil tugas kualitas data.

Penyiapan dan persyaratan

Sebelum mengklik tombol Start Lab

Baca petunjuk ini. Lab memiliki timer dan Anda tidak dapat menjedanya. Timer yang dimulai saat Anda mengklik Start Lab akan menampilkan durasi ketersediaan resource Google Cloud untuk Anda.

Lab interaktif ini dapat Anda gunakan untuk melakukan aktivitas lab di lingkungan cloud sungguhan, bukan di lingkungan demo atau simulasi. Untuk mengakses lab ini, Anda akan diberi kredensial baru yang bersifat sementara dan dapat digunakan untuk login serta mengakses Google Cloud selama durasi lab.

Untuk menyelesaikan lab ini, Anda memerlukan:

- Akses ke browser internet standar (disarankan browser Chrome).

Catatan: Gunakan jendela Samaran (direkomendasikan) atau browser pribadi untuk menjalankan lab ini. Hal ini akan mencegah konflik antara akun pribadi Anda dan akun siswa yang dapat menyebabkan tagihan ekstra pada akun pribadi Anda.

- Waktu untuk menyelesaikan lab. Ingat, setelah dimulai, lab tidak dapat dijeda.

Catatan: Hanya gunakan akun siswa untuk lab ini. Jika Anda menggunakan akun Google Cloud yang berbeda, Anda mungkin akan dikenai tagihan ke akun tersebut.

Cara memulai lab dan login ke Google Cloud Console

-

Klik tombol Start Lab. Jika Anda perlu membayar lab, dialog akan terbuka untuk memilih metode pembayaran.

Di sebelah kiri ada panel Lab Details yang berisi hal-hal berikut:

- Tombol Open Google Cloud console

- Waktu tersisa

- Kredensial sementara yang harus Anda gunakan untuk lab ini

- Informasi lain, jika diperlukan, untuk menyelesaikan lab ini

-

Klik Open Google Cloud console (atau klik kanan dan pilih Open Link in Incognito Window jika Anda menjalankan browser Chrome).

Lab akan menjalankan resource, lalu membuka tab lain yang menampilkan halaman Sign in.

Tips: Atur tab di jendela terpisah secara berdampingan.

Catatan: Jika Anda melihat dialog Choose an account, klik Use Another Account.

-

Jika perlu, salin Username di bawah dan tempel ke dialog Sign in.

{{{user_0.username | "Username"}}}

Anda juga dapat menemukan Username di panel Lab Details.

-

Klik Next.

-

Salin Password di bawah dan tempel ke dialog Welcome.

{{{user_0.password | "Password"}}}

Anda juga dapat menemukan Password di panel Lab Details.

-

Klik Next.

Penting: Anda harus menggunakan kredensial yang diberikan lab. Jangan menggunakan kredensial akun Google Cloud Anda.

Catatan: Menggunakan akun Google Cloud sendiri untuk lab ini dapat dikenai biaya tambahan.

-

Klik halaman berikutnya:

- Setujui persyaratan dan ketentuan.

- Jangan tambahkan opsi pemulihan atau autentikasi 2 langkah (karena ini akun sementara).

- Jangan mendaftar uji coba gratis.

Setelah beberapa saat, Konsol Google Cloud akan terbuka di tab ini.

Catatan: Untuk mengakses produk dan layanan Google Cloud, klik Navigation menu atau ketik nama layanan atau produk di kolom Search.

Mengaktifkan Cloud Shell

Cloud Shell adalah mesin virtual yang dilengkapi dengan berbagai alat pengembangan. Mesin virtual ini menawarkan direktori beranda persisten berkapasitas 5 GB dan berjalan di Google Cloud. Cloud Shell menyediakan akses command-line untuk resource Google Cloud Anda.

-

Klik Activate Cloud Shell  di bagian atas Konsol Google Cloud.

di bagian atas Konsol Google Cloud.

-

Klik jendela berikut:

- Lanjutkan melalui jendela informasi Cloud Shell.

- Beri otorisasi ke Cloud Shell untuk menggunakan kredensial Anda guna melakukan panggilan Google Cloud API.

Setelah terhubung, Anda sudah diautentikasi, dan project ditetapkan ke Project_ID, . Output berisi baris yang mendeklarasikan Project_ID untuk sesi ini:

Project Cloud Platform Anda dalam sesi ini disetel ke {{{project_0.project_id | "PROJECT_ID"}}}

gcloud adalah alat command line untuk Google Cloud. Alat ini sudah terinstal di Cloud Shell dan mendukung pelengkapan command line.

- (Opsional) Anda dapat menampilkan daftar nama akun yang aktif dengan perintah ini:

gcloud auth list

- Klik Authorize.

Output:

ACTIVE: *

ACCOUNT: {{{user_0.username | "ACCOUNT"}}}

Untuk menetapkan akun aktif, jalankan:

$ gcloud config set account `ACCOUNT`

- (Opsional) Anda dapat menampilkan daftar ID project dengan perintah ini:

gcloud config list project

Output:

[core]

project = {{{project_0.project_id | "PROJECT_ID"}}}

Catatan: Untuk mendapatkan dokumentasi gcloud yang lengkap di Google Cloud, baca panduan ringkasan gcloud CLI.

Mengaktifkan Dataproc API

-

Di kolom judul Konsol Google Cloud, ketikkan Cloud Dataproc API di kolom Search, lalu klik Cloud Dataproc API dari hasil penelusuran.

-

Klik Enable jika belum diaktifkan.

Tugas 1. Membuat data lake, zona, dan aset di Dataplex

Untuk menetapkan dan menjalankan tugas kualitas data, Anda memerlukan beberapa resource Dataplex Universal Catalog.

Dalam tugas ini, Anda akan membuat data lake Dataplex Universal Catalog baru untuk menyimpan informasi pelanggan e-commerce, menambahkan zona mentah ke data lake tersebut, lalu menghubungkan set data BigQuery yang telah dibuat sebelumnya sebagai aset baru di zona tersebut.

Membuat data lake

- Di Konsol Google Cloud, pada Navigation menu (

)> View All Products, buka Analytics > Dataplex Universal Catalog.

)> View All Products, buka Analytics > Dataplex Universal Catalog.

Jika muncul dialog Welcome to the new Dataplex Universal Catalog experience, klik Close.

-

Di bagian Manage lakes, klik Manage.

-

Klik Create lake.

-

Masukkan informasi yang diperlukan di bawah ini untuk membuat data lake baru: Biarkan semua kolom lain tetap pada nilai defaultnya:

| Properti |

Nilai |

| Display Name |

Ecommerce Lake |

| Region |

|

- Klik Create.

Diperlukan waktu hingga 3 menit untuk membuat data lake.

Menambahkan zona ke data lake

-

Di tab Manage, klik nama data lake Anda.

-

Klik ADD ZONE.

-

Masukkan informasi yang diperlukan di bawah ini untuk membuat zona baru: Biarkan semua kolom lain tetap pada nilai defaultnya:

| Properti |

Nilai |

| Display Name |

Customer Contact Raw Zone |

| Type |

Raw zone |

| Data locations |

Regional |

- Klik Create.

Diperlukan waktu hingga 2 menit untuk membuat zona.

Catatan: Anda dapat melakukan tugas berikutnya setelah status zona ini Active.

Menghubungkan aset ke zona

-

Di tab Zones, klik Customer Contact Raw Zone.

-

Di tab Assets, klik Add Asset.

-

Klik Add an asset.

-

Masukkan informasi yang diperlukan di bawah ini untuk menghubungkan aset baru: Biarkan kolom lain tetap pada nilai defaultnya.

| Properti |

Nilai |

| Type |

BigQuery dataset |

| Display Name |

Contact Info |

| Dataset |

.customers |

-

Klik Done.

-

Klik Continue.

-

Untuk Discovery settings, pilih Inherit untuk mewarisi setelan Discovery dari level zona, lalu klik Continue.

-

Klik Submit.

Klik Periksa progres saya untuk memverifikasi tujuan.

Membuat data lake, zona, dan aset di Dataplex Universal Catalog

Tugas 2. Mengkueri Tabel BigQuery untuk meninjau kualitas data

Lab ini menggunakan dua set data BigQuery yang telah dibuat sebelumnya:

-

customers: Berisi satu tabel bernama contact_info, yang berisi informasi kontak pelanggan seperti ID pelanggan, nama, email, dan informasi lainnya. Ini adalah tabel yang akan Anda jelajahi untuk memeriksa adanya masalah kualitas data dalam lab ini.

-

customers_dq_dataset: Tidak berisi tabel apa pun. Ketika menetapkan tugas kualitas data di tugas berikutnya, Anda akan menggunakan set data ini sebagai tujuan untuk tabel baru yang berisi hasil tugas kualitas data.

Dalam tugas ini, Anda akan mengkueri set data customers untuk mengidentifikasi masalah kualitas data yang akan disertakan sebagai bagian dari pemeriksaan dalam tugas kualitas data. Anda juga akan menentukan set data customers_dq_dataset untuk menyimpan hasil tugas kualitas data di tugas berikutnya.

Membuka konsol BigQuery

- Di Konsol Google Cloud, pilih Navigation menu > BigQuery.

Kotak pesan Welcome to BigQuery in the Cloud Console akan terbuka. Kotak pesan ini menyediakan link ke panduan memulai dan catatan rilis.

- Klik Done.

Konsol BigQuery terbuka.

Membuat kueri tabel contact_info

- Di panel Explorer, klik panah perluasan di samping ID project Anda, (), untuk mencantumkan konten.

Anda akan melihat tiga set data berikut:

- customer_contact_raw_zone

- customers

- customers_dq_dataset

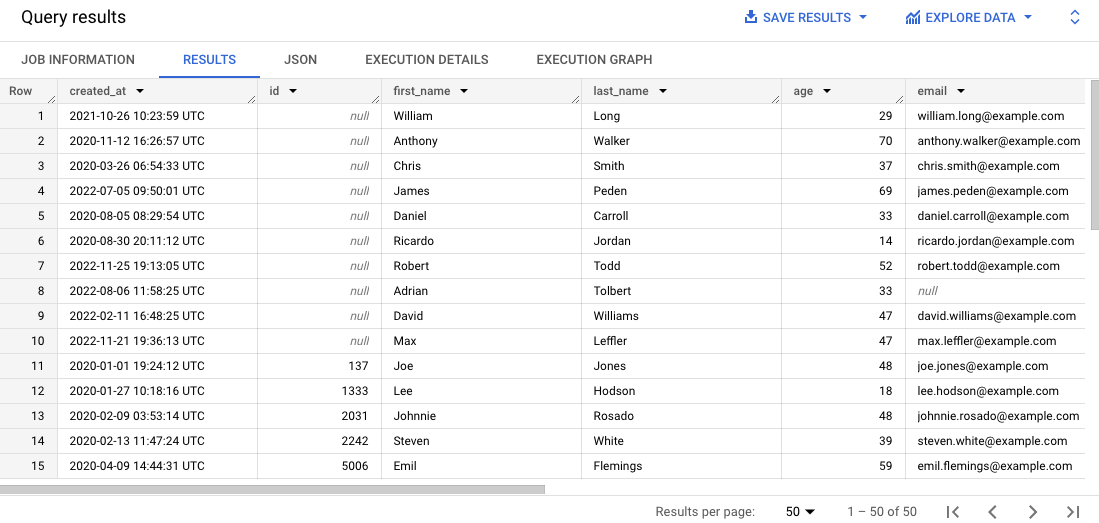

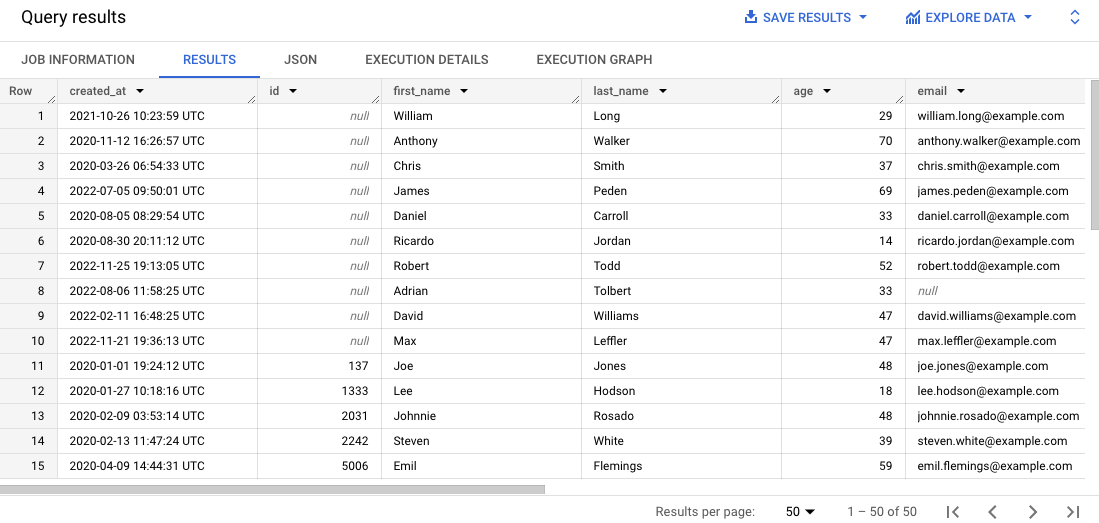

- Di Editor SQL, klik SQL query (+). Tempel kueri berikut, lalu klik Run:

SELECT * FROM `{{{project_0.project_id}}}.customers.contact_info`

ORDER BY id

LIMIT 50

Kueri ini memilih 50 kumpulan data dari tabel asal dan mengurutkannya berdasarkan id pelanggan di hasil kueri.

-

Scroll untuk melihat sekilas semua hasil di panel Results.

Perhatikan bahwa beberapa kumpulan data tidak memiliki ID pelanggan atau memiliki email yang salah, yang dapat mempersulit pengelolaan pesanan pelanggan.

Klik Periksa progres saya untuk memverifikasi tujuan.

Mengkueri Tabel BigQuery untuk meninjau kualitas data

Tugas 3. Membuat dan mengupload file spesifikasi kualitas data

Persyaratan pemeriksaan kualitas data Dataplex ditentukan menggunakan file spesifikasi YAML CloudDQ. Setelah dibuat, file spesifikasi YAML diupload ke bucket Cloud Storage yang dapat diakses oleh tugas kualitas data.

File YAML memiliki empat bagian penting:

- Daftar aturan untuk dijalankan (baik aturan yang sudah dibuat sebelumnya atau aturan khusus)

- Filter baris untuk memilih subset data untuk validasi

- Pengikatan aturan untuk menerapkan aturan yang ditetapkan ke tabel

- Dimensi aturan opsional untuk menentukan jenis aturan yang dapat dimuat dalam file YAML

Dalam tugas ini, Anda akan menentukan file spesifikasi YAML baru untuk pemeriksaan kualitas data yang mengidentifikasi email dan ID pelanggan dengan nilai null di Tabel BigQuery yang ditentukan. Anda juga akan menentukan set data BigQuery yang dibuat sebelumnya bernama customer_dq_dataset untuk menyimpan hasil kualitas data dalam tabel bernama dq_results.

Setelah menentukan file, Anda akan mengupload file tersebut ke bucket Cloud Storage yang dibuat sebelumnya untuk digunakan di tugas berikutnya guna menjalankan tugas kualitas data.

Membuat file spesifikasi kualitas data

- Di Cloud Shell, jalankan perintah berikut untuk membuat file kosong baru untuk spesifikasi kualitas data:

nano dq-customer-raw-data.yaml

- Tempelkan kode berikut ke dalam file:

rules:

- nonNullExpectation: {}

column: id

dimension: COMPLETENESS

threshold: 1

- regexExpectation:

regex: '^[^@]+[@]{1}[^@]+$'

column: email

dimension: CONFORMANCE

ignoreNull: true

threshold: .85

postScanActions:

bigqueryExport:

resultsTable: projects/{{{project_0.project_id | Project ID}}}/datasets/customers_dq_dataset/tables/dq_results

- Tinjau kode untuk mengidentifikasi dua aturan kualitas data utama yang ditentukan di file ini.

dq-customer-raw-data.yaml menentukan dua aturan:

- Aturan pertama mengacu pada dimensi kelengkapan seperti nilai null.

- Aturan kedua mengacu pada dimensi kepatuhan seperti nilai tidak valid.

Dalam file ini, kedua aturan terikat pada kolom tabel tertentu:

- Pengikatan aturan pertama mengikat aturan notNullExpectation ke kolom id dari tabel contact_info dengan batas 100%, yang memvalidasi apakah kolom ID memiliki nilai NULL.

- Pengikatan aturan kedua mengikat aturan regexExpectation ke kolom email dari tabel contact_info dengan batas 85%, yang memeriksa email yang valid.

- Tekan

CTRL+X, lalu Y, untuk menyimpan dan menutup file.

Mengupload file ke Cloud Storage

- Di Cloud Shell, jalankan perintah berikut untuk mengupload file ke bucket Cloud Storage:

gsutil cp dq-customer-raw-data.yaml gs://{{{project_0.project_id | Project ID}}}-bucket

Klik Periksa progres saya untuk memverifikasi tujuan.

Membuat dan mengupload file spesifikasi kualitas data

Tugas 4. Menetapkan dan menjalankan tugas kualitas data otomatis di Dataplex

Proses kualitas data menggunakan file YAML spesifikasi kualitas data untuk menjalankan tugas kualitas data dan membuat metrik kualitas data yang ditulis ke set data BigQuery.

Dalam tugas ini, Anda akan menentukan dan menjalankan tugas kualitas data otomatis menggunakan file YAML spesifikasi kualitas data di Cloud Storage. Saat menetapkan tugas, Anda juga akan menentukan set data customer_dq_dataset untuk menyimpan hasil kualitas data.

- Di Cloud Shell, jalankan perintah berikut untuk membuat pemindaian kualitas data:

gcloud dataplex datascans create data-quality customer-orders-data-quality-job \

--project={{{project_0.project_id | Project ID}}} \

--location={{{project_0.default_region | Region}}} \

--data-source-resource="//bigquery.googleapis.com/projects/{{{project_0.project_id | Project ID}}}/datasets/customers/tables/contact_info" \

--data-quality-spec-file="gs://{{{project_0.project_id | Project ID}}}-bucket/dq-customer-raw-data.yaml"

Catatan: Di lab ini, akun layanan default Compute Engine telah dikonfigurasi sebelumnya agar memiliki peran dan izin IAM yang sesuai. Untuk mengetahui informasi selengkapnya, tinjau dokumentasi Dataplex Universal Catalog dengan judul Membuat akun layanan.

-

Kembali ke konsol. Anda seharusnya masih berada di Dataplex Universal Catalog.

-

Di bagian Govern, klik Data profiling & quality.

-

Klik customer-orders-data-quality-job.

-

Klik Run Now.

Catatan: Tugas dapat membutuhkan waktu beberapa menit untuk dijalankan.

Setelah tugas selesai, perhatikan bahwa statusnya adalah 1 dimension 1 rule failed.

- Klik View results.

Perhatikan bahwa aturan kualitas data untuk kolom email adalah Passed, tetapi untuk kolom id, adalah Failed. Hal ini sudah diperkirakan karena:

-

Aturan untuk kolom id adalah Null Check dengan batas 100%. Artinya, agar aturan dapat lolos, semua baris harus memiliki nilai untuk ID. Dalam kasus ini, 10% baris kolom id dari tabel contact_info memiliki nilai null. Oleh karena itu, aturan ini Failed atau gagal.

-

Aturan untuk kolom email adalah Regex Check dengan batas 85%. Artinya, aturan akan gagal jika 15% dari kumpulan data memiliki format email yang tidak valid. Dalam kasus ini, ~10,5% baris kolom email dari tabel contact_info memiliki email yang tidak valid. Oleh karena itu, aturan ini Passed atau lulus.

Klik Periksa progres saya untuk memverifikasi tujuan.

Menetapkan dan menjalankan tugas kualitas data di Dataplex Universal Catalog

Tugas 5. Meninjau hasil kualitas data di BigQuery

Dalam tugas ini, Anda akan meninjau tabel di customers_dq_dataset untuk mengidentifikasi kumpulan data yang tidak memiliki nilai ID pelanggan atau memiliki nilai tidak valid untuk email.

-

Kembali ke BigQuery, dan di panel Explorer, perluas panah di samping project ID Anda untuk mencantumkan konten:

-

Klik panah peluas di samping set data customer_dq_dataset.

-

Klik tabel dq_results.

-

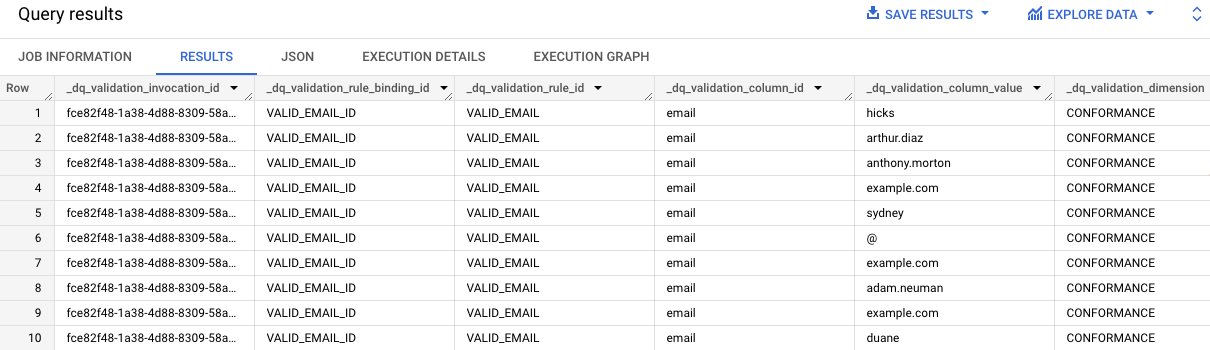

Klik tab Preview untuk melihat hasil.

-

Scroll ke kolom bernama rule_failed_records_query.

-

Salin kueri, yang dimulai dengan WITH.

-

Klik SQL query (+). Salin dan tempel kueri ke dalam Editor SQL, lalu klik Run.

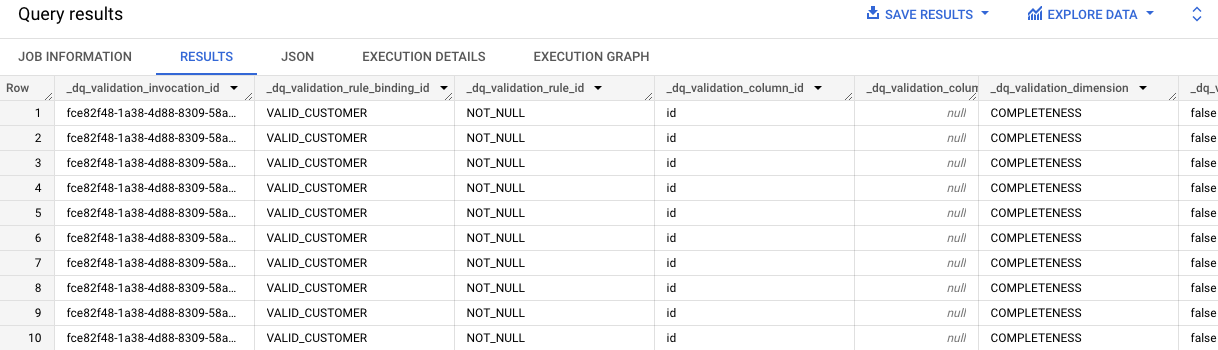

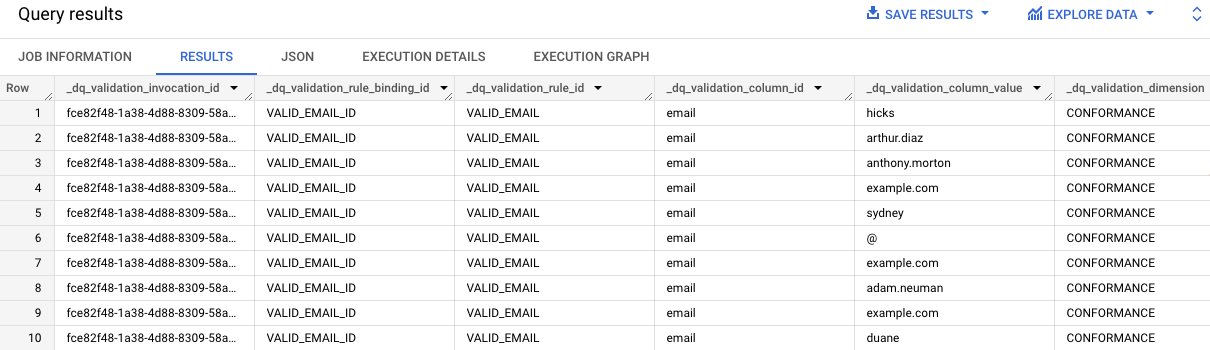

Hasil kueri akan memberikan nilai email di tabel contact_info yang tidak valid. Perhatikan "email" di setiap entri pada kolom dq_validation_column_id.

-

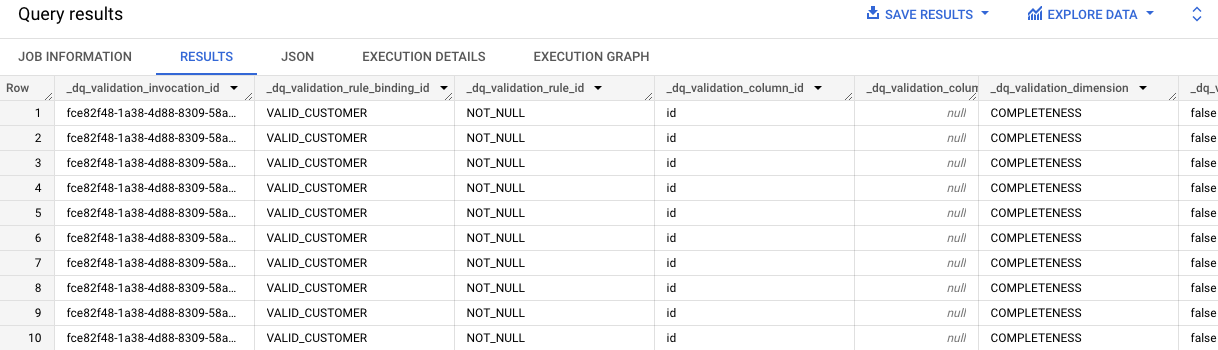

Ulangi langkah 7-8 untuk sel kedua yang berisi kueri untuk hasil aturan VALID_CUSTOMER.

Hasil kueri mengidentifikasi ada 10 kumpulan data di tabel contact_info yang tidak memiliki nilai ID.

Perhatikan "id" di setiap entri pada kolom dq_validation_column_id.

Klik Periksa progres saya untuk memverifikasi tujuan.

Meninjau hasil kualitas data di Tabel BigQuery

Selamat!

Anda telah melakukan penilaian kualitas data menggunakan Dataplex Universal Catalog dengan membuat file spesifikasi kualitas data khusus dan menggunakannya untuk menjalankan tugas kualitas data di Tabel BigQuery.

Sertifikasi dan pelatihan Google Cloud

...membantu Anda mengoptimalkan teknologi Google Cloud. Kelas kami mencakup keterampilan teknis dan praktik terbaik untuk membantu Anda memahami dengan cepat dan melanjutkan proses pembelajaran. Kami menawarkan pelatihan tingkat dasar hingga lanjutan dengan opsi on demand, live, dan virtual untuk menyesuaikan dengan jadwal Anda yang sibuk. Sertifikasi membantu Anda memvalidasi dan membuktikan keterampilan serta keahlian Anda dalam teknologi Google Cloud.

Manual Terakhir Diperbarui pada 2 September 2025

Lab Terakhir Diuji pada 2 September 2025

Hak cipta 2025 Google LLC. Semua hak dilindungi undang-undang. Google dan logo Google adalah merek dagang dari Google LLC. Semua nama perusahaan dan produk lain mungkin adalah merek dagang masing-masing perusahaan yang bersangkutan.

di bagian atas Konsol Google Cloud.

di bagian atas Konsol Google Cloud. )> View All Products, buka Analytics > Dataplex Universal Catalog.

)> View All Products, buka Analytics > Dataplex Universal Catalog.