GSP1158

Présentation

Dataplex Universal Catalog est une data fabric intelligente qui permet aux organisations de découvrir, de gérer, de surveiller et de gouverner leurs données de façon centralisée sur des lacs, des entrepôts et des magasins de données pour optimiser les analyses à grande échelle.

Une fonctionnalité intéressante de Dataplex Universal Catalog est sa capacité à définir et exécuter des vérifications de la qualité des données sur des éléments Dataplex Universal Catalog tels que des tables BigQuery et des fichiers Cloud Storage. À l'aide des tâches Dataplex liées à la qualité des données, vous pouvez intégrer des vérifications de la qualité dans vos workflows quotidiens en validant les données générées par un pipeline de production, en surveillant régulièrement la qualité de vos données par rapport à un ensemble de critères, et en créant des rapports afin de répondre aux exigences réglementaires.

Dans cet atelier, vous allez découvrir comment évaluer la qualité des données en créant un fichier de spécification dont vous vous servirez pour définir et exécuter un job d'évaluation de la qualité sur un ensemble de données BigQuery.

Objectifs de l'atelier

- Créer un lac, une zone et un élément Dataplex Universal Catalog

- Interroger une table BigQuery pour examiner la qualité des données

- Créer et importer un fichier de spécification de la qualité des données

- Définir et exécuter un job d'évaluation de la qualité des données

- Examiner les résultats d'un job d'évaluation de la qualité des données

Préparation

Avant de cliquer sur le bouton "Démarrer l'atelier"

Lisez ces instructions. Les ateliers sont minutés, et vous ne pouvez pas les mettre en pause. Le minuteur, qui démarre lorsque vous cliquez sur Démarrer l'atelier, indique combien de temps les ressources Google Cloud resteront accessibles.

Cet atelier pratique vous permet de suivre les activités dans un véritable environnement cloud, et non dans un environnement de simulation ou de démonstration. Des identifiants temporaires vous sont fournis pour vous permettre de vous connecter à Google Cloud le temps de l'atelier.

Pour réaliser cet atelier :

- Vous devez avoir accès à un navigateur Internet standard (nous vous recommandons d'utiliser Chrome).

Remarque : Ouvrez une fenêtre de navigateur en mode incognito (recommandé) ou de navigation privée pour effectuer cet atelier. Vous éviterez ainsi les conflits entre votre compte personnel et le compte temporaire de participant, qui pourraient entraîner des frais supplémentaires facturés sur votre compte personnel.

- Vous disposez d'un temps limité. N'oubliez pas qu'une fois l'atelier commencé, vous ne pouvez pas le mettre en pause.

Remarque : Utilisez uniquement le compte de participant pour cet atelier. Si vous utilisez un autre compte Google Cloud, des frais peuvent être facturés à ce compte.

Démarrer l'atelier et se connecter à la console Google Cloud

-

Cliquez sur le bouton Démarrer l'atelier. Si l'atelier est payant, une boîte de dialogue s'affiche pour vous permettre de sélectionner un mode de paiement.

Sur la gauche, vous trouverez le panneau "Détails concernant l'atelier", qui contient les éléments suivants :

- Le bouton "Ouvrir la console Google Cloud"

- Le temps restant

- Les identifiants temporaires que vous devez utiliser pour cet atelier

- Des informations complémentaires vous permettant d'effectuer l'atelier

-

Cliquez sur Ouvrir la console Google Cloud (ou effectuez un clic droit et sélectionnez Ouvrir le lien dans la fenêtre de navigation privée si vous utilisez le navigateur Chrome).

L'atelier lance les ressources, puis ouvre la page "Se connecter" dans un nouvel onglet.

Conseil : Réorganisez les onglets dans des fenêtres distinctes, placées côte à côte.

Remarque : Si la boîte de dialogue Sélectionner un compte s'affiche, cliquez sur Utiliser un autre compte.

-

Si nécessaire, copiez le nom d'utilisateur ci-dessous et collez-le dans la boîte de dialogue Se connecter.

{{{user_0.username | "Username"}}}

Vous trouverez également le nom d'utilisateur dans le panneau "Détails concernant l'atelier".

-

Cliquez sur Suivant.

-

Copiez le mot de passe ci-dessous et collez-le dans la boîte de dialogue Bienvenue.

{{{user_0.password | "Password"}}}

Vous trouverez également le mot de passe dans le panneau "Détails concernant l'atelier".

-

Cliquez sur Suivant.

Important : Vous devez utiliser les identifiants fournis pour l'atelier. Ne saisissez pas ceux de votre compte Google Cloud.

Remarque : Si vous utilisez votre propre compte Google Cloud pour cet atelier, des frais supplémentaires peuvent vous être facturés.

-

Accédez aux pages suivantes :

- Acceptez les conditions d'utilisation.

- N'ajoutez pas d'options de récupération ni d'authentification à deux facteurs (ce compte est temporaire).

- Ne vous inscrivez pas à des essais sans frais.

Après quelques instants, la console Cloud s'ouvre dans cet onglet.

Remarque : Pour accéder aux produits et services Google Cloud, cliquez sur le menu de navigation ou saisissez le nom du service ou du produit dans le champ Recherche.

Activer Cloud Shell

Cloud Shell est une machine virtuelle qui contient de nombreux outils pour les développeurs. Elle comprend un répertoire d'accueil persistant de 5 Go et s'exécute sur Google Cloud. Cloud Shell vous permet d'accéder via une ligne de commande à vos ressources Google Cloud.

-

Cliquez sur Activer Cloud Shell  en haut de la console Google Cloud.

en haut de la console Google Cloud.

-

Passez les fenêtres suivantes :

- Accédez à la fenêtre d'informations de Cloud Shell.

- Autorisez Cloud Shell à utiliser vos identifiants pour effectuer des appels d'API Google Cloud.

Une fois connecté, vous êtes en principe authentifié et le projet est défini sur votre ID_PROJET : . Le résultat contient une ligne qui déclare l'ID_PROJET pour cette session :

Your Cloud Platform project in this session is set to {{{project_0.project_id | "PROJECT_ID"}}}

gcloud est l'outil de ligne de commande pour Google Cloud. Il est préinstallé sur Cloud Shell et permet la complétion par tabulation.

- (Facultatif) Vous pouvez lister les noms des comptes actifs à l'aide de cette commande :

gcloud auth list

- Cliquez sur Autoriser.

Résultat :

ACTIVE: *

ACCOUNT: {{{user_0.username | "ACCOUNT"}}}

To set the active account, run:

$ gcloud config set account `ACCOUNT`

- (Facultatif) Vous pouvez lister les ID de projet à l'aide de cette commande :

gcloud config list project

Résultat :

[core]

project = {{{project_0.project_id | "PROJECT_ID"}}}

Remarque : Pour consulter la documentation complète sur gcloud, dans Google Cloud, accédez au guide de présentation de la gcloud CLI.

Activer l'API Dataproc

-

Dans la barre de titre de la console Google Cloud, saisissez API Cloud Dataproc dans le champ Recherche, puis cliquez sur API Cloud Dataproc dans les résultats de recherche.

-

Si ce n'est pas déjà fait, cliquez sur Activer.

Tâche 1 : Créer un lac, une zone et un élément dans Dataplex

Pour pouvoir définir et exécuter des tâches liées à la qualité des données, vous avez besoin de certaines ressources Dataplex Universal Catalog.

Dans cette tâche, vous allez créer un lac Dataplex Universal Catalog pour stocker les informations sur les clients d'un site d'e-commerce, ajouter une zone brute au lac, puis associer un ensemble de données BigQuery précréé en tant que nouvel élément de la zone.

Créer un lac

- Dans la console Google Cloud, accédez au menu de navigation (

) > Afficher tous les produits, puis à Analyse > Dataplex Universal Catalog.

) > Afficher tous les produits, puis à Analyse > Dataplex Universal Catalog.

Si la fenêtre Bienvenue dans la nouvelle interface de Dataplex Universal Catalog apparaît, cliquez sur Fermer.

-

Sous Gérer les lacs, cliquez sur Gérer.

-

Cliquez sur Créer un lac de données.

-

Saisissez les informations requises pour créer un lac de données : Conservez les valeurs par défaut dans tous les autres champs :

| Propriété |

Valeur |

| Nom à afficher |

Ecommerce Lake |

| Région |

|

- Cliquez sur Créer.

La création d'un lac peut prendre jusqu'à trois minutes.

Ajouter une zone au lac

-

Dans l'onglet Gérer, cliquez sur le nom de votre lac.

-

Cliquez sur AJOUTER UNE ZONE.

-

Saisissez les informations requises pour créer une zone : Conservez les valeurs par défaut dans tous les autres champs :

| Propriété |

Valeur |

| Nom à afficher |

Customer Contact Raw Zone |

| Type |

Zone brute |

| Emplacements des données |

Régional |

- Cliquez sur Créer.

La création de la zone peut prendre jusqu'à deux minutes.

Remarque : Vous pouvez passer à l'étape suivante lorsque l'état de la zone bascule sur Actif.

Associer un élément à une zone

-

Dans l'onglet Zones, cliquez sur Customer Contact Raw Zone.

-

Dans l'onglet Éléments, cliquez sur Ajouter un élément.

-

Cliquez sur Ajouter un élément.

-

Saisissez les informations requises pour associer un élément : Conservez les valeurs par défaut dans les autres champs.

| Propriété |

Valeur |

| Type |

Ensemble de données BigQuery |

| Nom à afficher |

Contact Info |

| Ensemble de données |

.customers |

-

Cliquez sur OK.

-

Cliquez sur Continuer.

-

Dans les paramètres de découverte, sélectionnez Hériter pour hériter des paramètres de découverte configurés au niveau de la zone, puis cliquez sur Continuer.

-

Cliquez sur Envoyer.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Créer un lac, une zone et un élément dans Dataplex Universal Catalog

Tâche 2 : Interroger une table BigQuery pour examiner la qualité des données

Cet atelier utilise deux ensembles de données BigQuery précréés :

-

customers : contient une table nommée contact_info, qui contient les coordonnées des clients, comme leurs ID client, nom, adresse e-mail, etc. Il s'agit de la table que vous allez explorer afin d'identifier les problèmes de qualité des données tout au long de cet atelier.

-

customers_dq_dataset : ne contient aucune table. Lorsque vous définirez un job d'évaluation de la qualité des données, lors d'une tâche ultérieure, vous utiliserez cet ensemble de données comme destination pour héberger une table contenant les résultats de ce job.

Dans cette tâche, vous allez interroger l'ensemble de données customers afin d'identifier les problèmes de qualité des données à inclure dans les vérifications d'un job d'évaluation de la qualité des données. Dans une tâche ultérieure, vous spécifierez l'ensemble de données customers_dq_dataset où stocker les résultats du job d'évaluation de la qualité des données.

Ouvrir la console BigQuery

- Dans la console Google Cloud, sélectionnez le menu de navigation > BigQuery.

Le message Bienvenue sur BigQuery dans Cloud Console s'affiche. Il contient un lien vers le guide de démarrage rapide et les notes de version.

- Cliquez sur OK.

La console BigQuery s'ouvre.

Interroger la table contact_info

- Dans le volet Explorateur, cliquez sur la flèche de développement () située à côté de l'ID de votre projet pour en afficher le contenu.

Vous devriez voir les trois ensembles de données suivants :

- Customer Contact Raw Zone

- customers

- customers_dq_dataset

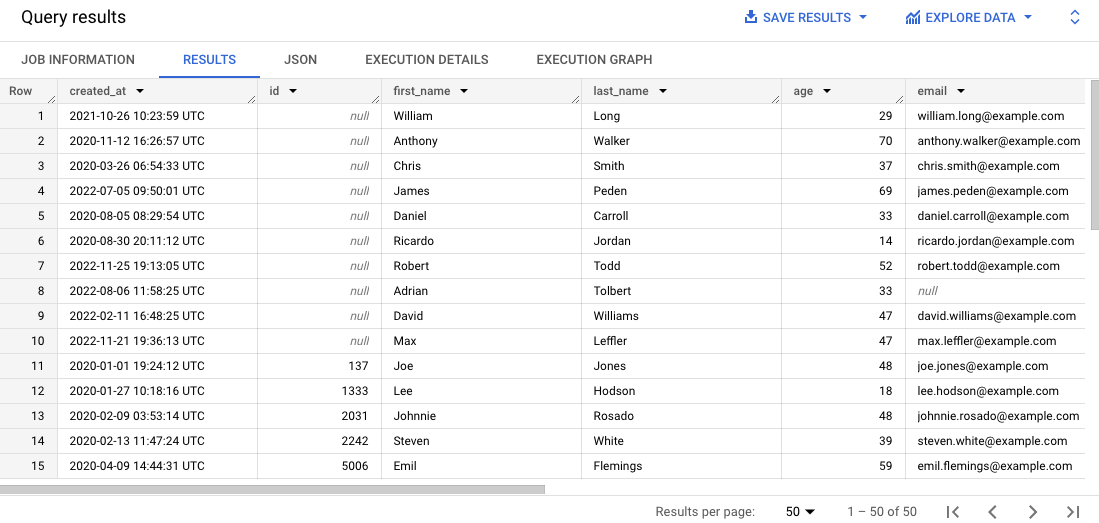

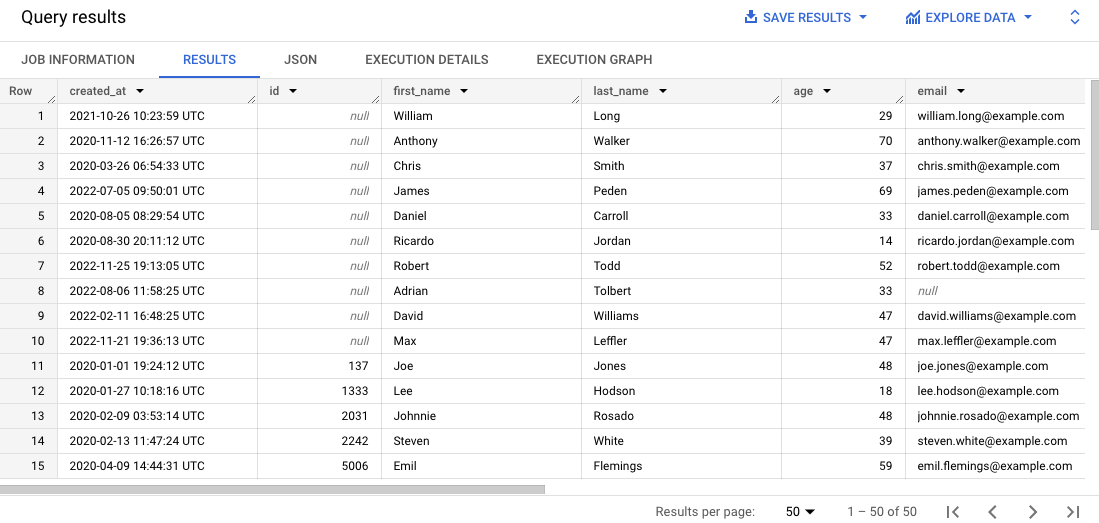

- Dans l'éditeur SQL, cliquez sur Requête SQL (+). Collez la requête ci-dessous, puis cliquez sur Exécuter :

SELECT * FROM `{{{project_0.project_id}}}.customers.contact_info`

ORDER BY id

LIMIT 50

Cette requête sélectionne 50 enregistrements de la table d'origine et les classe par ID client dans les résultats.

-

Passez en revue les résultats dans le volet Résultats.

Notez que pour certains enregistrements, il manque l'ID client ou l'adresse e-mail n'est pas valide, ce qui peut compliquer la gestion des commandes client.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Interroger une table BigQuery pour examiner la qualité des données

Tâche 3 : Créer et importer un fichier de spécification de la qualité des données

Les exigences des vérifications de la qualité des données de Dataplex sont définies à l'aide des fichiers de spécification YAML de CloudDQ. Une fois le fichier de spécification YAML crée, il est importé dans un bucket Cloud Storage auquel le job d'évaluation de la qualité des données a accès.

Le fichier YAML comporte quatre sections principales :

- Une liste de règles (prédéfinies ou personnalisées) à exécuter

- Des filtres de lignes permettant de sélectionner un sous-ensemble de données à valider

- Des liaisons de règles permettant d'appliquer les règles définies aux tables

- Des dimensions de règle facultatives permettant de spécifier les types de règles que le fichier YAML peut contenir

Dans cette tâche, vous allez définir un nouveau fichier de spécification YAML pour les vérifications de la qualité des données visant à identifier les ID client et adresses e-mail de valeur nulle dans la table BigQuery spécifiée. Vous allez également spécifier un ensemble de données BigQuery précréé, nommé customer_dq_dataset, qui servira à stocker les résultats de l'évaluation de la qualité des données dans une table nommée dq_results.

Une fois le fichier défini, vous l'importerez dans un bucket Cloud Storage précréé afin de pouvoir l'utiliser lors d'une tâche ultérieure pour exécuter le job d'évaluation de la qualité des données.

Créer le fichier de spécification de la qualité des données

- Dans Cloud Shell, exécutez la commande suivante pour créer un fichier de spécification de la qualité des données vide :

nano dq-customer-raw-data.yaml

- Collez le code suivant dans le fichier :

rules:

- nonNullExpectation: {}

column: id

dimension: COMPLETENESS

threshold: 1

- regexExpectation:

regex: '^[^@]+[@]{1}[^@]+$'

column: email

dimension: CONFORMANCE

ignoreNull: true

threshold: .85

postScanActions:

bigqueryExport:

resultsTable: projects/{{{project_0.project_id | Project ID}}}/datasets/customers_dq_dataset/tables/dq_results

- Examinez le code pour identifier les deux principales règles de qualité des données qui sont définies dans ce fichier.

Le fichier dq-customer-raw-data.yaml spécifie deux règles :

- La première fait référence à la dimension d'exhaustivité, pour identifier les valeurs nulles.

- La seconde fait référence à la dimension de conformité, pour détecter les valeurs non valides.

Dans ce fichier, les deux règles sont liées à des colonnes de table spécifiques :

- La première liaison de règle lie une règle notNullExpectation à la colonne id de la table contact_info avec un seuil de 100 %. Elle vise à vérifier si la colonne "ID" contient des valeurs nulles (NULL).

- La deuxième liaison de règle lie une règle regexExpectation à la colonne email de la table contact_info avec un seuil de 85 %. Elle vise à vérifier la validité des adresses e-mail.

- Appuyez sur les touches

Ctrl+X, puis Y pour enregistrer et fermer le fichier.

Importer le fichier dans Cloud Storage

- Dans Cloud Shell, exécutez la commande suivante pour importer le fichier dans un bucket Cloud Storage :

gsutil cp dq-customer-raw-data.yaml gs://{{{project_0.project_id | Project ID}}}-bucket

Cliquez sur Vérifier ma progression pour valider l'objectif.

Créer et importer un fichier de spécification de la qualité des données

Tâche 4 : Définir et exécuter un job d'évaluation automatique de la qualité des données dans Dataplex

Le processus de contrôle de la qualité des données utilise un fichier YAML de spécification de la qualité des données pour exécuter un job d'évaluation, et génère des métriques associées qui sont écrites dans un ensemble de données BigQuery.

Dans cette tâche, vous allez définir et exécuter un job d'évaluation automatique de la qualité des données en utilisant le fichier YAML de spécification de la qualité des données dans Cloud Storage. Lorsque vous définirez le job, vous spécifierez également l'ensemble de données customer_dq_dataset où stocker les résultats de l'évaluation de la qualité des données.

- Dans Cloud Shell, exécutez la commande suivante pour créer une analyse de la qualité des données :

gcloud dataplex datascans create data-quality customer-orders-data-quality-job \

--project={{{project_0.project_id | Project ID}}} \

--location={{{project_0.default_region | Region}}} \

--data-source-resource="//bigquery.googleapis.com/projects/{{{project_0.project_id | Project ID}}}/datasets/customers/tables/contact_info" \

--data-quality-spec-file="gs://{{{project_0.project_id | Project ID}}}-bucket/dq-customer-raw-data.yaml"

Remarque : Dans cet atelier, le compte de service Compute Engine par défaut a été préconfiguré avec les rôles et autorisations IAM appropriés. Pour plus d'informations, consultez la documentation Dataplex Universal Catalog intitulée Créer un compte de service.

-

Revenez à la console. Vous devriez toujours vous trouver dans Dataplex Universal Catalog.

-

Sous Gouvernance, cliquez sur Qualité et profilage des données.

-

Cliquez sur customer-orders-data-quality-job.

-

Cliquez sur Exécuter maintenant.

Remarque : L'exécution du job peut prendre plusieurs minutes.

Une fois le job terminé, notez que son état est 1 dimension 1 règle en échec/

- Cliquez sur Afficher les résultats.

Notez que la règle de vérification de la qualité des données indique Réussite pour la colonne email, mais Échec pour la colonne id. Ce résultat est normal pour les raisons suivantes :

-

La règle pour la colonne id est un Null Check (contrôle des valeurs NULL) avec un seuil de 100 %. Cela signifie que pour que la règle soit validée, toutes les lignes doivent comporter une valeur pour l'ID. Dans cet exemple, 10 % des lignes de la colonne id de la table contact_info comportent une valeur null. D'où l'échec de la règle.

-

La règle pour la colonne email est un Regex Check (vérification de l'expression régulière) avec un seuil de 85 %. Cela signifie que la règle échouera si 15 % des enregistrements ont un format d'adresse e-mail non valide. Dans cet exemple, environ 10,5 % des lignes de la colonne email de la table contact_info contiennent des adresses e-mail non valides. D'où la réussite de la règle.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Définir et exécuter un job d'évaluation de la qualité des données dans Dataplex Universal Catalog

Tâche 5 : Examiner les résultats d'évaluation de la qualité des données dans BigQuery

Dans cette tâche, vous allez examiner les tables de customers_dq_dataset afin d'identifier les enregistrements pour lesquels la valeur "ID client" est manquante et/ou l'adresse e-mail n'est pas valide.

-

Revenez à BigQuery, puis dans le volet Explorateur, cliquez sur la flèche située à côté de l'ID de votre projet pour en afficher le contenu :

-

Cliquez sur la flèche située à côté de l'ensemble de données customer_dq_dataset.

-

Cliquez sur la table dq_results.

-

Cliquez sur l'onglet Aperçu pour consulter les résultats.

-

Faites défiler l'affichage jusqu'à la colonne nommée rule_failed_records_query.

-

Copiez la requête, qui commence par WITH.

-

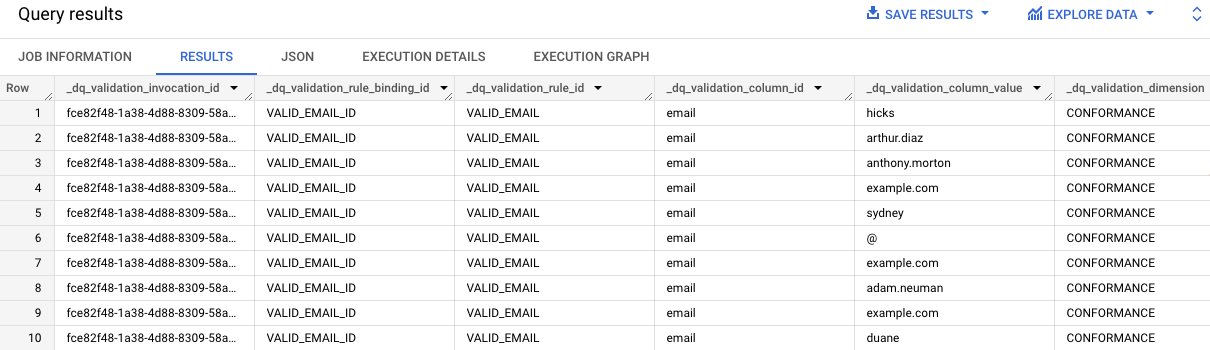

Cliquez sur Requête SQL (+). Copiez la requête et collez-la dans l'éditeur SQL, puis cliquez sur Exécuter.

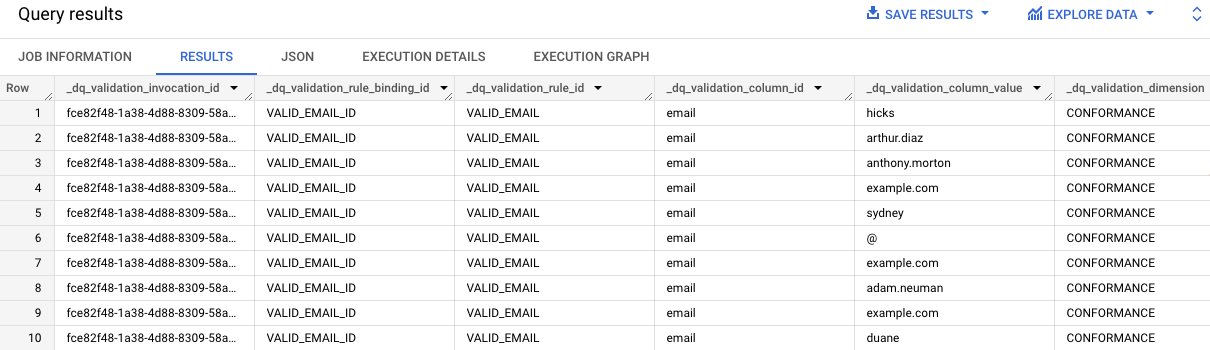

Les résultats de la requête indiquent les valeurs d'adresse e-mail de la table contact_info qui ne sont pas valides. Notez que chaque entrée de la colonne dq_validation_column_id contient "email".

-

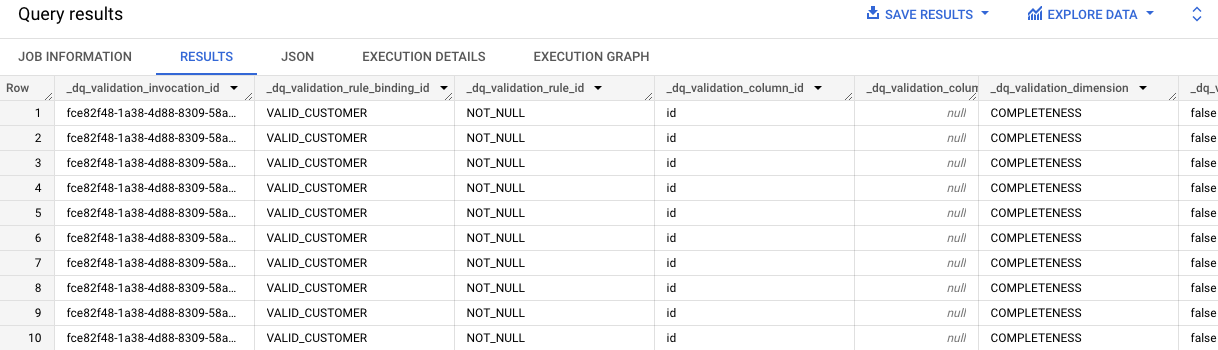

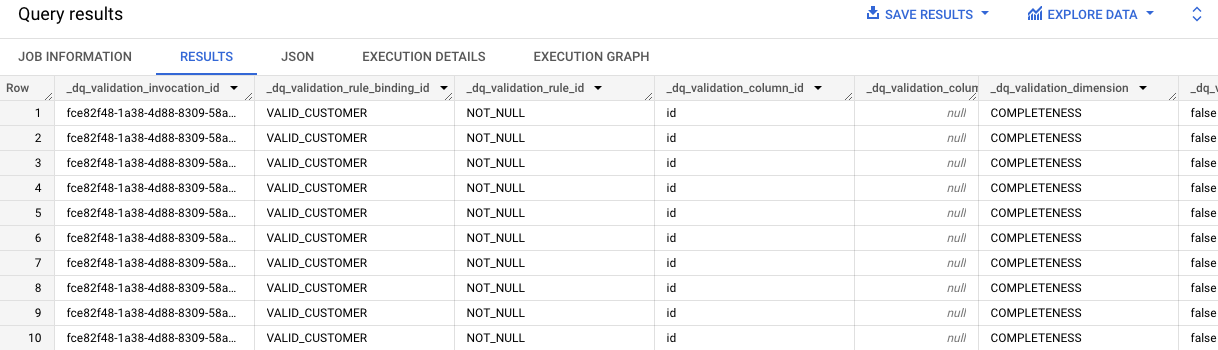

Répétez les étapes 7 et 8 pour la deuxième cellule, qui contient la requête permettant d'obtenir les résultats pour la règle VALID_CUSTOMER.

Les résultats de la requête indiquent que pour 10 enregistrements de la table contact_info, la valeur d'ID est manquante.

Notez que chaque entrée de la colonne dq_validation_column_id contient "id".

Cliquez sur Vérifier ma progression pour valider l'objectif.

Examiner les résultats d'évaluation de la qualité des données d'une table BigQuery

Félicitations !

Vous avez appris à évaluer la qualité des données à l'aide de Dataplex Universal Catalog en créant un fichier de spécification de la qualité des données personnalisé et en l'utilisant pour exécuter un job d'évaluation de la qualité des données sur une table BigQuery.

Formations et certifications Google Cloud

Les formations et certifications Google Cloud vous aident à tirer pleinement parti des technologies Google Cloud. Nos cours portent sur les compétences techniques et les bonnes pratiques à suivre pour être rapidement opérationnel et poursuivre votre apprentissage. Nous proposons des formations pour tous les niveaux, à la demande, en salle et à distance, pour nous adapter aux emplois du temps de chacun. Les certifications vous permettent de valider et de démontrer vos compétences et votre expérience en matière de technologies Google Cloud.

Dernière mise à jour du manuel : 02 septembre 2025

Dernier test de l'atelier : 02 septembre 2025

Copyright 2025 Google LLC. Tous droits réservés. Google et le logo Google sont des marques de Google LLC. Tous les autres noms d'entreprises et de produits peuvent être des marques des entreprises auxquelles ils sont associés.

en haut de la console Google Cloud.

en haut de la console Google Cloud. ) > Afficher tous les produits, puis à Analyse > Dataplex Universal Catalog.

) > Afficher tous les produits, puis à Analyse > Dataplex Universal Catalog.