GSP1158

Übersicht

Dataplex Universal Catalog ist eine intelligente Datenstruktur, mit der Organisationen ihre Daten in Data Lakes, Data Warehouses und Data-Marts zentral erfassen, verwalten, überwachen und steuern können. Sie unterstützt Analysen großer Datenbestände.

Eine besonders nützliche Funktion von Dataplex Universal Catalog ist die Möglichkeit, Datenqualitätsprüfungen für Dataplex Universal Catalog-Assets wie BigQuery-Tabellen und Cloud Storage-Dateien zu definieren und auszuführen. Mit Dataplex-Datenqualitätsaufgaben können Sie Datenqualitätsprüfungen in alltägliche Workflows einbinden. So lassen sich Daten validieren, die Teil einer Datenproduktionspipeline sind. Die Qualität Ihrer Daten wird dabei regelmäßig anhand einer Reihe von Kriterien überwacht und es werden die jeweils gesetzlich vorgeschriebenen Datenqualitätsberichte erstellt.

In diesem Lab erfahren Sie, wie Sie die Datenqualität mit Dataplex Universal Catalog bewerten, indem Sie eine benutzerdefinierte Datei mit Datenqualitätsspezifikationen erstellen und diese verwenden, um einen Datenqualitätsjob für BigQuery-Daten zu definieren und auszuführen.

Aufgaben

- Dataplex Universal Catalog-Lake, ‑Zone und ‑Asset erstellen

- BigQuery-Tabelle abfragen, um die Datenqualität zu prüfen

- Datei mit Datenqualitätsspezifikationen erstellen und hochladen

- Datenqualitätsjob definieren und ausführen

- Ergebnisse eines Datenqualitätsjobs prüfen

Einrichtung und Anforderungen

Vor dem Klick auf „Start Lab“ (Lab starten)

Lesen Sie diese Anleitung. Labs sind zeitlich begrenzt und können nicht pausiert werden. Der Timer beginnt zu laufen, wenn Sie auf Lab starten klicken, und zeigt Ihnen, wie lange Google Cloud-Ressourcen für das Lab verfügbar sind.

In diesem praxisorientierten Lab können Sie die Lab-Aktivitäten in einer echten Cloud-Umgebung durchführen – nicht in einer Simulations- oder Demo-Umgebung. Dazu erhalten Sie neue, temporäre Anmeldedaten, mit denen Sie für die Dauer des Labs auf Google Cloud zugreifen können.

Für dieses Lab benötigen Sie Folgendes:

- Einen Standardbrowser (empfohlen wird Chrome)

Hinweis: Nutzen Sie den privaten oder Inkognitomodus (empfohlen), um dieses Lab durchzuführen. So wird verhindert, dass es zu Konflikten zwischen Ihrem persönlichen Konto und dem Teilnehmerkonto kommt und zusätzliche Gebühren für Ihr persönliches Konto erhoben werden.

- Zeit für die Durchführung des Labs – denken Sie daran, dass Sie ein begonnenes Lab nicht unterbrechen können.

Hinweis: Verwenden Sie für dieses Lab nur das Teilnehmerkonto. Wenn Sie ein anderes Google Cloud-Konto verwenden, fallen dafür möglicherweise Kosten an.

Lab starten und bei der Google Cloud Console anmelden

-

Klicken Sie auf Lab starten. Wenn Sie für das Lab bezahlen müssen, wird ein Dialogfeld geöffnet, in dem Sie Ihre Zahlungsmethode auswählen können.

Auf der linken Seite befindet sich der Bereich „Details zum Lab“ mit diesen Informationen:

- Schaltfläche „Google Cloud Console öffnen“

- Restzeit

- Temporäre Anmeldedaten für das Lab

- Ggf. weitere Informationen für dieses Lab

-

Klicken Sie auf Google Cloud Console öffnen (oder klicken Sie mit der rechten Maustaste und wählen Sie Link in Inkognitofenster öffnen aus, wenn Sie Chrome verwenden).

Im Lab werden Ressourcen aktiviert. Anschließend wird ein weiterer Tab mit der Seite „Anmelden“ geöffnet.

Tipp: Ordnen Sie die Tabs nebeneinander in separaten Fenstern an.

Hinweis: Wird das Dialogfeld Konto auswählen angezeigt, klicken Sie auf Anderes Konto verwenden.

-

Kopieren Sie bei Bedarf den folgenden Nutzernamen und fügen Sie ihn in das Dialogfeld Anmelden ein.

{{{user_0.username | "Username"}}}

Sie finden den Nutzernamen auch im Bereich „Details zum Lab“.

-

Klicken Sie auf Weiter.

-

Kopieren Sie das folgende Passwort und fügen Sie es in das Dialogfeld Willkommen ein.

{{{user_0.password | "Password"}}}

Sie finden das Passwort auch im Bereich „Details zum Lab“.

-

Klicken Sie auf Weiter.

Wichtig: Sie müssen die für das Lab bereitgestellten Anmeldedaten verwenden. Nutzen Sie nicht die Anmeldedaten Ihres Google Cloud-Kontos.

Hinweis: Wenn Sie Ihr eigenes Google Cloud-Konto für dieses Lab nutzen, können zusätzliche Kosten anfallen.

-

Klicken Sie sich durch die nachfolgenden Seiten:

- Akzeptieren Sie die Nutzungsbedingungen.

- Fügen Sie keine Wiederherstellungsoptionen oder Zwei-Faktor-Authentifizierung hinzu (da dies nur ein temporäres Konto ist).

- Melden Sie sich nicht für kostenlose Testversionen an.

Nach wenigen Augenblicken wird die Google Cloud Console in diesem Tab geöffnet.

Hinweis: Wenn Sie auf Google Cloud-Produkte und ‑Dienste zugreifen möchten, klicken Sie auf das Navigationsmenü oder geben Sie den Namen des Produkts oder Dienstes in das Feld Suchen ein.

Cloud Shell aktivieren

Cloud Shell ist eine virtuelle Maschine, auf der Entwicklertools installiert sind. Sie bietet ein Basisverzeichnis mit 5 GB nichtflüchtigem Speicher und läuft auf Google Cloud. Mit Cloud Shell erhalten Sie Befehlszeilenzugriff auf Ihre Google Cloud-Ressourcen.

-

Klicken Sie oben in der Google Cloud Console auf Cloud Shell aktivieren  .

.

-

Klicken Sie sich durch die folgenden Fenster:

- Fahren Sie mit dem Informationsfenster zu Cloud Shell fort.

- Autorisieren Sie Cloud Shell, Ihre Anmeldedaten für Google Cloud API-Aufrufe zu verwenden.

Wenn eine Verbindung besteht, sind Sie bereits authentifiziert und das Projekt ist auf Project_ID, eingestellt. Die Ausgabe enthält eine Zeile, in der die Project_ID für diese Sitzung angegeben ist:

Ihr Cloud-Projekt in dieser Sitzung ist festgelegt als {{{project_0.project_id | "PROJECT_ID"}}}

gcloud ist das Befehlszeilentool für Google Cloud. Das Tool ist in Cloud Shell vorinstalliert und unterstützt die Tab-Vervollständigung.

- (Optional) Sie können den aktiven Kontonamen mit diesem Befehl auflisten:

gcloud auth list

- Klicken Sie auf Autorisieren.

Ausgabe:

ACTIVE: *

ACCOUNT: {{{user_0.username | "ACCOUNT"}}}

Um das aktive Konto festzulegen, führen Sie diesen Befehl aus:

$ gcloud config set account `ACCOUNT`

- (Optional) Sie können die Projekt-ID mit diesem Befehl auflisten:

gcloud config list project

Ausgabe:

[core]

project = {{{project_0.project_id | "PROJECT_ID"}}}

Hinweis: Die vollständige Dokumentation für gcloud finden Sie in Google Cloud in der Übersicht zur gcloud CLI.

Dataproc API aktivieren

-

Geben Sie in das Suchfeld der Titelleiste der Google Cloud Console Cloud Dataproc API ein und klicken Sie dann in den Suchergebnissen auf Cloud Dataproc API.

-

Klicken Sie auf Aktivieren, wenn die API noch nicht aktiviert wurde.

Aufgabe 1: Lake, Zone und Asset in Dataplex erstellen

Damit Sie Datenqualitätsaufgaben definieren und ausführen können, benötigen Sie einige Dataplex Universal Catalog-Ressourcen.

In dieser Aufgabe erstellen Sie einen neuen Dataplex Universal Catalog-Lake zum Speichern von E‑Commerce-Kundendaten, fügen dem Lake eine Rohdatenzone hinzu und hängen dann ein bereits erstelltes BigQuery-Dataset als neues Asset in der Zone an.

Lake erstellen

- Klicken Sie in der Google Cloud Console im Navigationsmenü (

) auf „Alle Produkte ansehen“ und gehen Sie zu Analyse > Dataplex Universal Catalog.

) auf „Alle Produkte ansehen“ und gehen Sie zu Analyse > Dataplex Universal Catalog.

Wenn die Meldung Willkommen bei der neuen Dataplex Universal Catalog-Umgebung angezeigt wird, klicken Sie auf Schließen.

-

Klicken Sie unter Lakes verwalten auf Verwalten.

-

Klicken Sie auf Lake erstellen.

-

Geben Sie die erforderlichen Informationen ein, um einen neuen Data Lake zu erstellen: Übernehmen Sie die Standardwerte der restlichen Felder.

| Attribut |

Wert |

| Anzeigename |

Ecommerce Lake |

| Region |

|

- Klicken Sie auf Erstellen.

Es kann bis zu drei Minuten dauern, bis der Data Lake erstellt ist.

Zone zum Lake hinzufügen

-

Klicken Sie auf dem Tab Verwalten auf den Namen Ihres Lakes.

-

Klicken Sie auf + Zone hinzufügen.

-

Geben Sie die erforderlichen Informationen ein, um eine neue Zone zu erstellen. Übernehmen Sie die Standardwerte der restlichen Felder.

| Attribut |

Wert |

| Anzeigename |

Customer Contact Raw Zone |

| Typ |

Rohdatenzone |

| Datenstandorte |

Regional |

- Klicken Sie auf Erstellen.

Es kann bis zu zwei Minuten dauern, bis die Zone erstellt ist.

Hinweis: Sie können mit der nächsten Aufgabe fortfahren, sobald der Status der Zone Aktiv lautet.

Asset an eine Zone anhängen

-

Klicken Sie auf dem Tab Zonen auf Customer Contact Raw Zone.

-

Klicken Sie auf dem Tab Assets auf + ASSET HINZUFÜGEN.

-

Klicken Sie auf Asset hinzufügen.

-

Geben Sie die erforderlichen Informationen ein, um ein neues Asset anzuhängen: Übernehmen Sie für die restlichen Felder die Standardwerte.

| Attribut |

Wert |

| Typ |

BigQuery-Dataset |

| Anzeigename |

Kontaktdaten |

| Dataset |

.customers |

-

Klicken Sie auf Fertig.

-

Klicken Sie auf Weiter.

-

Wählen Sie unter Erkennungseinstellungen die Option Übernehmen aus, um die Erkennungseinstellungen auf Zonenebene zu übernehmen. Klicken Sie dann auf Weiter.

-

Klicken Sie auf Senden.

Klicken Sie auf Fortschritt prüfen.

Lake, Zone und Asset in Dataplex Universal Catalog erstellen

Aufgabe 2: BigQuery-Tabelle abfragen, um die Datenqualität zu prüfen

In diesem Lab werden zwei vordefinierte BigQuery-Datasets verwendet:

-

customers: Enthält eine Tabelle mit dem Namen contact_info, die Kontaktdaten von Kunden wie Kundennummer, Name und E‑Mail-Adresse enthält. Diese Tabelle untersuchen Sie in diesem Lab auf Probleme mit der Datenqualität.

-

customers_dq_dataset: Enthält keine Tabellen. Wenn Sie in einer späteren Aufgabe einen Datenqualitätsjob definieren, verwenden Sie dieses Dataset als Ziel für eine neue Tabelle, in der die Ergebnisse des Datenqualitätsjobs gespeichert werden.

In dieser Aufgabe fragen Sie das Dataset customers ab, um Probleme mit der Datenqualität zu identifizieren, für die Sie Prüfungen in einen Datenqualitätsjob aufnehmen können. Außerdem geben Sie das Dataset customers_dq_dataset an, in dem die Ergebnisse des Datenqualitätsjobs in einer späteren Aufgabe gespeichert werden sollen.

Die BigQuery Console öffnen

- Klicken Sie in der Google Cloud Console im Navigationsmenü auf BigQuery.

Zuerst wird das Fenster Willkommen bei BigQuery in der Cloud Console geöffnet, das neben allgemeinen Informationen auch einen Link zur Kurzanleitung und zu den Versionshinweisen enthält.

- Klicken Sie auf Fertig.

Die BigQuery Console wird geöffnet.

Tabelle contact_info abfragen

- Klicken Sie im Bereich Explorer auf den Pfeil neben Ihrer Projekt-ID (), um den Inhalt aufzulisten.

Sie sollten folgende drei Datasets sehen:

- customer_contact_raw_zone

- customers

- customers_dq_dataset

- Klicken Sie im SQL-Editor auf SQL-Abfrage (+). Fügen Sie die folgende Abfrage ein und klicken Sie auf Ausführen:

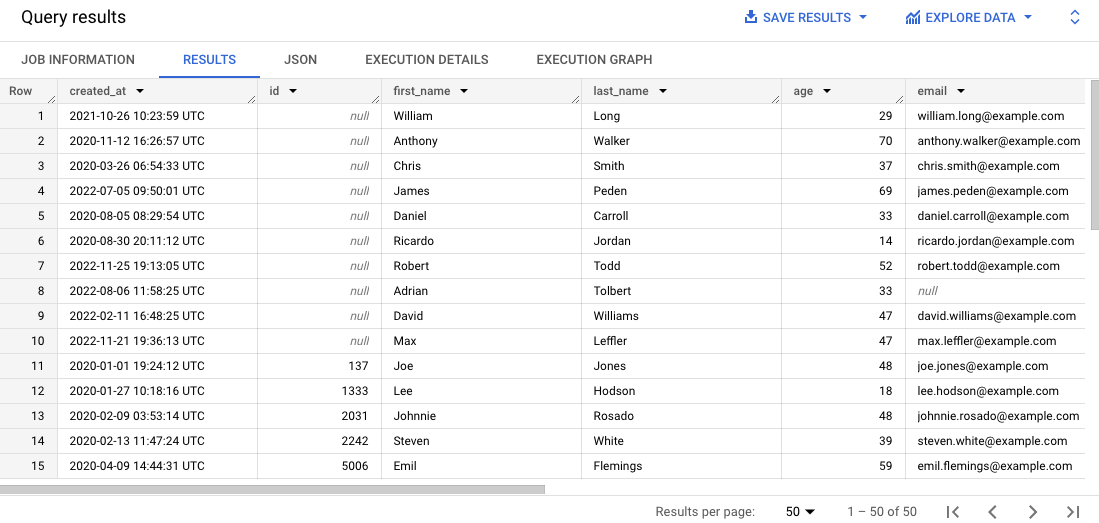

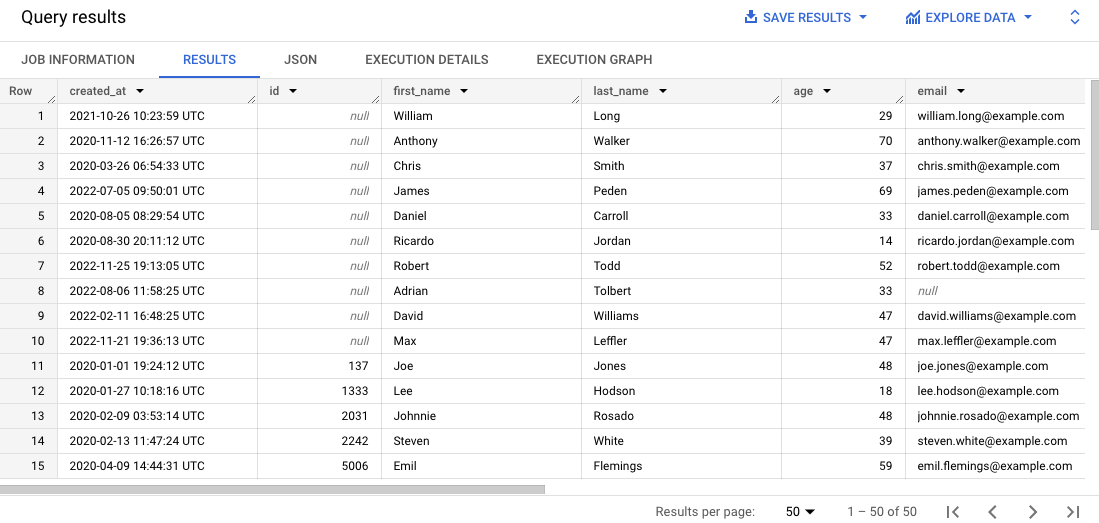

SELECT * FROM `{{{project_0.project_id}}}.customers.contact_info`

ORDER BY id

LIMIT 50

Durch diese Abfrage werden 50 Einträge aus der Originaltabelle ausgewählt und in den Ergebnissen nach der Kundennummer sortiert.

-

Scrollen Sie durch die Ergebnisse im Bereich Ergebnisse.

Bei einigen Einträgen fehlt die Kundennummer, oder die E‑Mail-Adresse ist ungültig. Dies kann die Verwaltung der Kundenbestellungen erschweren.

Klicken Sie auf Fortschritt prüfen.

BigQuery-Tabelle abfragen, um die Datenqualität zu prüfen

Aufgabe 3: Datei mit Datenqualitätsspezifikationen erstellen und hochladen

Die Anforderungen an die Dataplex-Datenqualitätsprüfung werden mithilfe von CloudDQ-YAML-Spezifikationsdateien definiert. Nachdem die YAML-Spezifikationsdatei erstellt wurde, wird sie in einen Cloud Storage-Bucket hochgeladen, auf den der Datenqualitätsjob Zugriff erhält.

Die YAML-Datei hat vier wichtige Abschnitte:

- Eine Liste der auszuführenden Regeln (vordefinierte oder benutzerdefinierte Regeln)

- Zeilenfilter, um eine Teilmenge der Daten zur Prüfung auszuwählen

- Regelbindungen, um die definierten Regeln auf die Tabelle(n) anzuwenden

- Optionale Regeldimensionen, um die Arten von Regeln anzugeben, die die YAML-Datei enthalten darf

In dieser Aufgabe definieren Sie eine neue YAML-Spezifikationsdatei für Datenqualitätsprüfungen, um fehlende Kundennummern und ungültige E‑Mail-Adressen in der angegebenen BigQuery-Tabelle zu identifizieren. Sie geben auch das vorab erstellte BigQuery-Dataset customer_dq_dataset an, in dem die Ergebnisse der Datenqualitätsprüfung in einer Tabelle namens dq_results gespeichert werden sollen.

Nachdem Sie die Datei definiert haben, laden Sie sie in einen bereits erstellten Cloud Storage-Bucket hoch. Sie verwenden sie dann in einer späteren Aufgabe zum Ausführen des Datenqualitätsjobs.

Datei mit Datenqualitätsspezifikationen erstellen

- Führen Sie in Cloud Shell den folgenden Befehl aus, um eine neue leere Datei für die Datenqualitätsspezifikationen zu erstellen:

nano dq-customer-raw-data.yaml

- Fügen Sie folgenden Code in die Datei ein:

rules:

- nonNullExpectation: {}

column: id

dimension: COMPLETENESS

threshold: 1

- regexExpectation:

regex: '^[^@]+[@]{1}[^@]+$'

column: email

dimension: CONFORMANCE

ignoreNull: true

threshold: .85

postScanActions:

bigqueryExport:

resultsTable: projects/{{{project_0.project_id | Project ID}}}/datasets/customers_dq_dataset/tables/dq_results

- Sehen Sie sich den Code an. Darin finden Sie die beiden wichtigsten Datenqualitätsregeln, die in dieser Datei definiert sind.

Die Datei dq-customer-raw-data.yaml enthält zwei Regeln:

- Die erste Regel bezieht sich auf die Vollständigkeit. Damit lassen sich zum Beispiel Nullwerte finden.

- Die zweite Regel bezieht sich auf die Konformität. Damit lassen sich ungültige Werte finden.

In dieser Datei sind die beiden Regeln an bestimmte Tabellenspalten gebunden:

- Die erste Regelbindung bindet eine notNullExpectation-Regel an die Spalte id der Tabelle contact_info mit einem Schwellenwert von 100 %. Dadurch wird geprüft, ob diese Spalte NULL-Werte enthält.

- Die zweite Regelbindung bindet eine regexExpectation-Regel mit einem Schwellenwert von 85 % an die Spalte email der Tabelle contact_info, um nach gültigen E‑Mail-Adressen zu suchen.

- Drücken Sie

Strg + X und dann Y, um die Datei zu speichern und zu schließen.

Die Datei in Cloud Storage hochladen

- Führen Sie in Cloud Shell den folgenden Befehl aus, um die Datei in einen Cloud Storage-Bucket hochzuladen:

gsutil cp dq-customer-raw-data.yaml gs://{{{project_0.project_id | Project ID}}}-bucket

Klicken Sie auf Fortschritt prüfen.

Datei mit Datenqualitätsspezifikationen erstellen und hochladen

Aufgabe 4: Automatischen Datenqualitätsjob in Dataplex definieren und ausführen

Im Datenqualitätsprozess wird eine YAML-Datei mit Datenqualitätsspezifikationen verwendet, um einen Datenqualitätsjob auszuführen und Messwerte zu generieren, die in ein BigQuery-Dataset geschrieben werden.

In dieser Aufgabe definieren Sie mit der YAML-Datei mit Datenqualitätsspezifikationen in Cloud Storage einen automatischen Datenqualitätsjob und führen ihn aus. Beim Definieren des Jobs geben Sie auch das Dataset customer_dq_dataset an, in dem die Ergebnisse der Datenqualitätsprüfung gespeichert werden sollen.

- Führen Sie in Cloud Shell den folgenden Befehl aus, um einen Datenqualitäts-Scan zu erstellen:

gcloud dataplex datascans create data-quality customer-orders-data-quality-job \

--project={{{project_0.project_id | Project ID}}} \

--location={{{project_0.default_region | Region}}} \

--data-source-resource="//bigquery.googleapis.com/projects/{{{project_0.project_id | Project ID}}}/datasets/customers/tables/contact_info" \

--data-quality-spec-file="gs://{{{project_0.project_id | Project ID}}}-bucket/dq-customer-raw-data.yaml"

Hinweis: In diesem Lab wurde das Compute Engine-Standarddienstkonto vorkonfiguriert, sodass es die entsprechenden IAM-Rollen und ‑Berechtigungen hat. Weitere Informationen finden Sie in der Dataplex Universal Catalog-Dokumentation unter Dienstkonto erstellen.

-

Kehren Sie zur Konsole zurück. Sie sollten sich noch in Dataplex Universal Catalog befinden.

-

Klicken Sie unter Verwalten auf Datenprofilerstellung und ‑qualität.

-

Klicken Sie auf customer-orders-data-quality-job.

-

Klicken Sie auf Jetzt ausführen.

Hinweis: Das Ausführen des Jobs kann einige Minuten dauern.

Nach Abschluss des Jobs wird der Status 1 Dimension, 1 Regel fehlgeschlagen angezeigt.

- Klicken Sie auf Ergebnisse anzeigen.

Die Datenqualitätsregel für die Spalte email ist Bestanden, für die Spalte id jedoch Fehlgeschlagen. Das ist zu erwarten, weil:

-

Die Regel für die Spalte id ist ein Null-Check mit einem Schwellenwert von 100%. Das bedeutet, dass alle Zeilen einen Wert für die ID haben müssen, damit die Regel erfüllt ist. In diesem Fall haben 10% der Zeilen der Spalte id der Tabelle contact_info Null-Werte. Daher wird diese Regel als Fehlgeschlagen eingestuft.

-

Die Regel für die Spalte email ist eine Regex-Prüfung mit einem Schwellenwert von 85%. Das bedeutet, dass die Regel fehlschlägt, wenn 15% der Datensätze ein ungültiges E‑Mail-Format haben. In diesem Fall haben ~10,5 % der Zeilen in der Spalte email der Tabelle contact_info eine ungültige E‑Mail-Adresse. Daher ist diese Regel bestanden.

Klicken Sie auf Fortschritt prüfen.

Datenqualitätsjob in Dataplex Universal Catalog definieren und ausführen

Aufgabe 5: Ergebnisse der Datenqualitätsprüfung in BigQuery ansehen

In dieser Aufgabe prüfen Sie die Tabellen im Dataset customers_dq_dataset auf Einträge, bei denen die Kundennummer fehlt oder die E‑Mail-Adresse ungültig ist.

-

Kehren Sie zu BigQuery zurück und klicken Sie im Bereich Explorer auf den Pfeil neben Ihrer Projekt-ID, um den Inhalt aufzulisten:

-

Klicken Sie auf den Pfeil neben dem Dataset customer_dq_dataset.

-

Klicken Sie auf die Tabelle dq_results.

-

Klicken Sie auf den Tab Vorschau, um die Ergebnisse zu sehen.

-

Scrollen Sie zur Spalte rule_failed_records_query.

-

Kopieren Sie die Abfrage, die mit WITH beginnt.

-

Klicken Sie auf SQL-Abfrage (+). Kopieren Sie die Abfrage in den SQL-Editor und klicken Sie auf Ausführen.

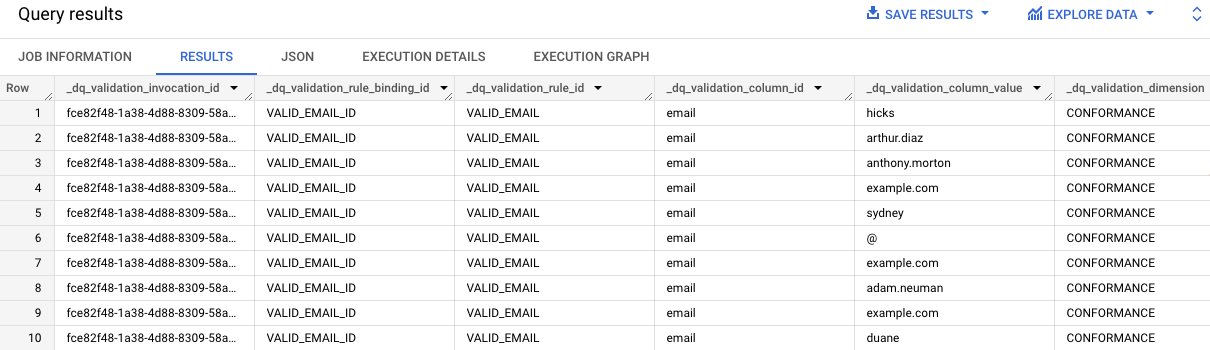

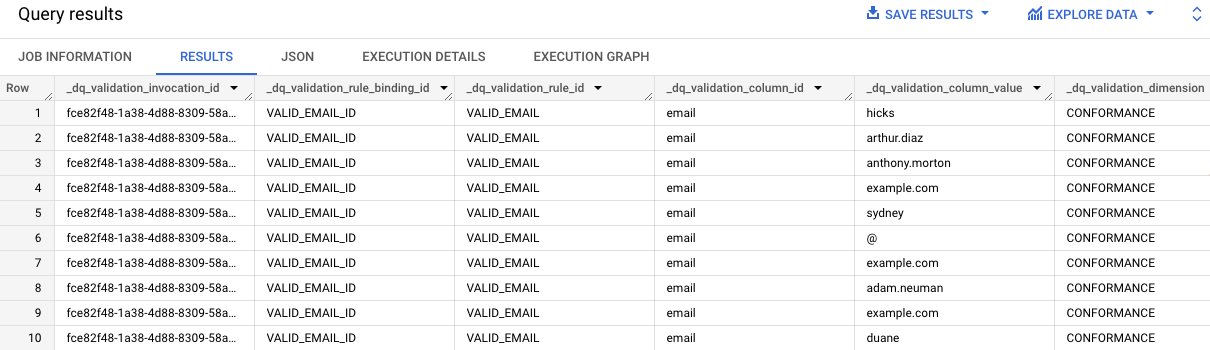

Die Ergebnisse der Abfrage enthalten die E‑Mail-Werte in der Tabelle contact_info, die nicht gültig sind. In der Spalte dq_validation_column_id ist in jedem Eintrag „email“ zu sehen.

-

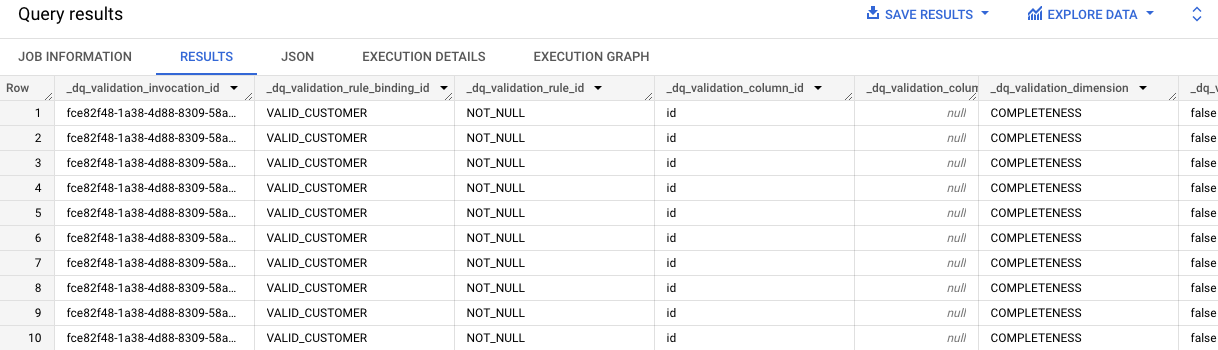

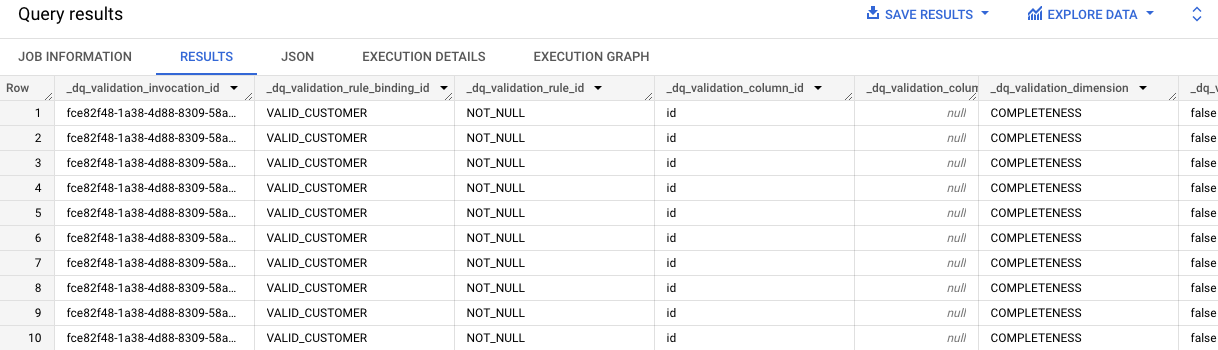

Wiederholen Sie die Schritte 7 und 8 für die zweite Zelle, die die Abfrage für die Ergebnisse der Regel VALID_CUSTOMER enthält.

Die Ergebnisse der Abfrage zeigen, dass in der Tabelle contact_info zehn Einträge keine Kundennummer haben.

Beachten Sie die „id“ in jedem Eintrag in der Spalte dq_validation_column_id.

Klicken Sie auf Fortschritt prüfen.

Ergebnisse der Datenqualitätsprüfung in der BigQuery-Tabelle ansehen

Das wars! Sie haben das Lab erfolgreich abgeschlossen.

Sie haben gelernt, Datenqualität mit Dataplex Universal Catalog zu bewerten, indem Sie eine benutzerdefinierte Datei mit Datenqualitätsspezifikationen erstellt und damit einen Datenqualitätsjob für eine BigQuery-Tabelle ausgeführt haben.

Google Cloud-Schulungen und -Zertifizierungen

In unseren Schulungen erfahren Sie alles zum optimalen Einsatz unserer Google Cloud-Technologien und können sich entsprechend zertifizieren lassen. Unsere Kurse vermitteln technische Fähigkeiten und Best Practices, damit Sie möglichst schnell mit Google Cloud loslegen und Ihr Wissen fortlaufend erweitern können. Wir bieten On-Demand-, Präsenz- und virtuelle Schulungen für Anfänger wie Fortgeschrittene an, die Sie individuell in Ihrem eigenen Zeitplan absolvieren können. Mit unseren Zertifizierungen weisen Sie nach, dass Sie Experte im Bereich Google Cloud-Technologien sind.

Anleitung zuletzt am 2. September 2025 aktualisiert

Lab zuletzt am 2. September 2025 getestet

© 2025 Google LLC. Alle Rechte vorbehalten. Google und das Google-Logo sind Marken von Google LLC. Alle anderen Unternehmens- und Produktnamen können Marken der jeweils mit ihnen verbundenen Unternehmen sein.

.

. ) auf „Alle Produkte ansehen“ und gehen Sie zu Analyse > Dataplex Universal Catalog.

) auf „Alle Produkte ansehen“ und gehen Sie zu Analyse > Dataplex Universal Catalog.