Prüfpunkte

Create a Dataset

/ 20

Create a sink

/ 20

Run example queries

/ 30

Viewing the logs in BigQuery

/ 30

Mit BigQuery und Cloud Logging die BigQuery-Nutzung analysieren

- GSP617

- Übersicht

- Einrichtung und Anforderungen

- Aufgabe 1: BigQuery öffnen

- Aufgabe 2: Dataset erstellen

- Aufgabe 3: Abfrage ausführen

- Aufgabe 4: Logexport aus Cloud Logging einrichten

- Aufgabe 5: Beispielabfragen ausführen

- Aufgabe 6: Logs in BigQuery ansehen

- Das wars! Sie haben das Lab erfolgreich abgeschlossen.

GSP617

Übersicht

Cloud Logging dient als zentrales Repository für Logs aus verschiedenen Google Cloud-Diensten, einschließlich BigQuery, und eignet sich hervorragend für die kurz‑ bis mittelfristige Logspeicherung. In vielen Branchen müssen Logs längere Zeit aufbewahrt werden. Wenn Sie Logs für eine umfangreichere Verlaufsanalyse oder komplexe Audits speichern möchten, können Sie eine Senke einrichten, um bestimmte Logs nach BigQuery zu exportieren.

In diesem Lab sehen Sie sich die BigQuery-Logs in Cloud Logging an, richten eine Senke ein, um sie nach BigQuery zu exportieren, und nutzen SQL, um die Logs zu analysieren.

Einrichtung und Anforderungen

Vor dem Klick auf „Start Lab“ (Lab starten)

Lesen Sie diese Anleitung. Labs sind zeitlich begrenzt und können nicht pausiert werden. Der Timer beginnt zu laufen, wenn Sie auf Lab starten klicken, und zeigt Ihnen, wie lange die Ressourcen für das Lab verfügbar sind.

In diesem praxisorientierten Lab können Sie die Lab-Aktivitäten in einer echten Cloud-Umgebung selbst durchführen – nicht in einer Simulations- oder Demo-Umgebung. Dazu erhalten Sie neue, temporäre Anmeldedaten, mit denen Sie für die Dauer des Labs auf Google Cloud zugreifen können.

Für dieses Lab benötigen Sie Folgendes:

- Einen Standardbrowser (empfohlen wird Chrome)

- Zeit für die Durchführung des Labs – denken Sie daran, dass Sie ein begonnenes Lab nicht unterbrechen können.

Lab starten und bei der Google Cloud Console anmelden

-

Klicken Sie auf Lab starten. Wenn Sie für das Lab bezahlen müssen, wird ein Pop-up-Fenster geöffnet, in dem Sie Ihre Zahlungsmethode auswählen können. Auf der linken Seite befindet sich der Bereich Details zum Lab mit diesen Informationen:

- Schaltfläche Google Cloud Console öffnen

- Restzeit

- Temporäre Anmeldedaten für das Lab

- Ggf. weitere Informationen für dieses Lab

-

Klicken Sie auf Google Cloud Console öffnen (oder klicken Sie mit der rechten Maustaste und wählen Sie Link in Inkognitofenster öffnen aus, wenn Sie Chrome verwenden).

Im Lab werden Ressourcen aktiviert. Anschließend wird ein weiterer Tab mit der Seite Anmelden geöffnet.

Tipp: Ordnen Sie die Tabs nebeneinander in separaten Fenstern an.

Hinweis: Wird das Dialogfeld Konto auswählen angezeigt, klicken Sie auf Anderes Konto verwenden. -

Kopieren Sie bei Bedarf den folgenden Nutzernamen und fügen Sie ihn in das Dialogfeld Anmelden ein.

{{{user_0.username | "Username"}}} Sie finden den Nutzernamen auch im Bereich Details zum Lab.

-

Klicken Sie auf Weiter.

-

Kopieren Sie das folgende Passwort und fügen Sie es in das Dialogfeld Willkommen ein.

{{{user_0.password | "Password"}}} Sie finden das Passwort auch im Bereich Details zum Lab.

-

Klicken Sie auf Weiter.

Wichtig: Sie müssen die für das Lab bereitgestellten Anmeldedaten verwenden. Nutzen Sie nicht die Anmeldedaten Ihres Google Cloud-Kontos. Hinweis: Wenn Sie Ihr eigenes Google Cloud-Konto für dieses Lab nutzen, können zusätzliche Kosten anfallen. -

Klicken Sie sich durch die nachfolgenden Seiten:

- Akzeptieren Sie die Nutzungsbedingungen.

- Fügen Sie keine Wiederherstellungsoptionen oder Zwei-Faktor-Authentifizierung hinzu (da dies nur ein temporäres Konto ist).

- Melden Sie sich nicht für kostenlose Testversionen an.

Nach wenigen Augenblicken wird die Google Cloud Console in diesem Tab geöffnet.

Cloud Shell aktivieren

Cloud Shell ist eine virtuelle Maschine, auf der Entwicklertools installiert sind. Sie bietet ein Basisverzeichnis mit 5 GB nichtflüchtigem Speicher und läuft auf Google Cloud. Mit Cloud Shell erhalten Sie Befehlszeilenzugriff auf Ihre Google Cloud-Ressourcen.

- Klicken Sie oben in der Google Cloud Console auf Cloud Shell aktivieren

.

Wenn Sie verbunden sind, sind Sie bereits authentifiziert und das Projekt ist auf Ihre Project_ID,

gcloud ist das Befehlszeilentool für Google Cloud. Das Tool ist in Cloud Shell vorinstalliert und unterstützt die Tab-Vervollständigung.

- (Optional) Sie können den aktiven Kontonamen mit diesem Befehl auflisten:

- Klicken Sie auf Autorisieren.

Ausgabe:

- (Optional) Sie können die Projekt-ID mit diesem Befehl auflisten:

Ausgabe:

gcloud finden Sie in Google Cloud in der Übersicht zur gcloud CLI.

Aufgabe 1: BigQuery öffnen

Die BigQuery Console öffnen

- Klicken Sie in der Google Cloud Console im Navigationsmenü auf BigQuery.

Zuerst wird das Fenster Willkommen bei BigQuery in der Cloud Console geöffnet, das neben allgemeinen Informationen auch einen Link zur Kurzanleitung und zu den Versionshinweisen enthält.

- Klicken Sie auf Fertig.

Die BigQuery Console wird geöffnet.

Aufgabe 2: Dataset erstellen

-

Klicken Sie unter Explorer auf das Dreipunkt-Menü neben dem Projekt, das mit

qwiklabs-gcp-beginnt. -

Klicken Sie auf Dataset erstellen.

-

Legen Sie als Dataset-ID den Namen bq_logs fest.

-

Klicken Sie auf DATASET ERSTELLEN.

Klicken Sie auf Fortschritt prüfen.

Aufgabe 3: Abfrage ausführen

Führen Sie als Erstes eine einfache Abfrage aus, durch die ein Log erstellt wird. Später verwenden Sie dieses Log, um den Export nach BigQuery einzurichten.

- Kopieren Sie die folgende Abfrage und fügen Sie sie in den BigQuery-Abfrageeditor ein:

- Klicken Sie auf AUSFÜHREN.

Aufgabe 4: Logexport aus Cloud Logging einrichten

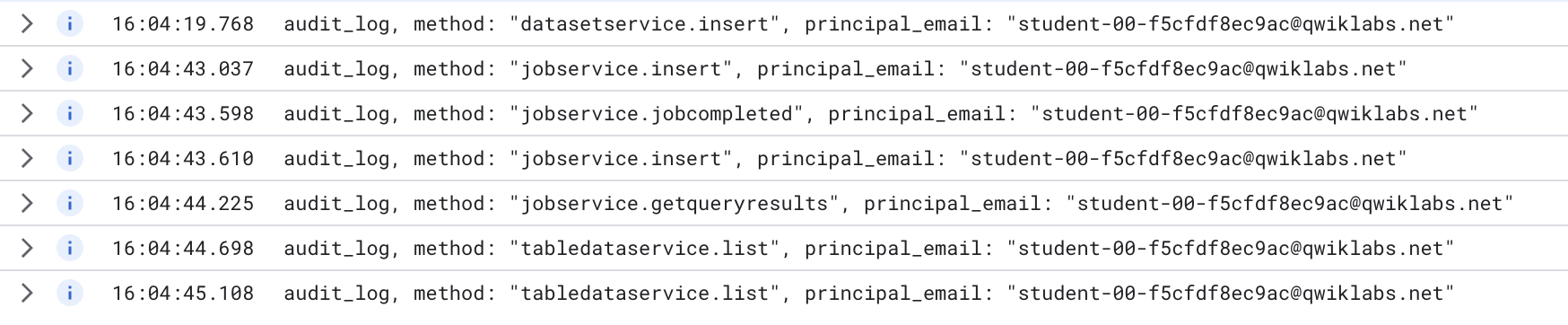

- Klicken Sie in der Cloud Console auf Navigationsmenü > Logging > Log-Explorer.

-

Wählen Sie unter Ressource die Option BigQuery aus und klicken Sie auf Anwenden.

-

Klicken Sie jetzt oben rechts auf die Schaltfläche Abfrage ausführen.

Die Abfrage sollte einige Logeinträge liefern.

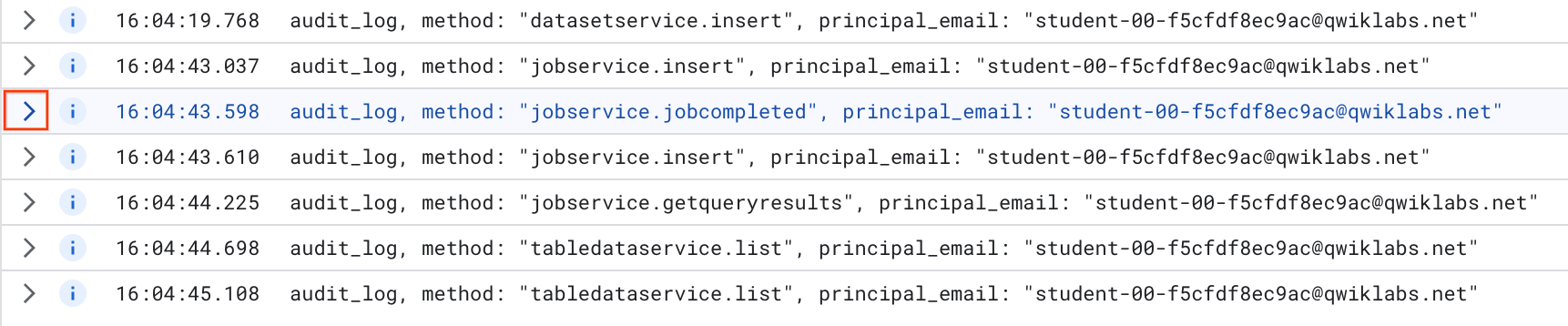

Suchen Sie den Eintrag, der den Ausdruck „jobcompleted“ enthält.

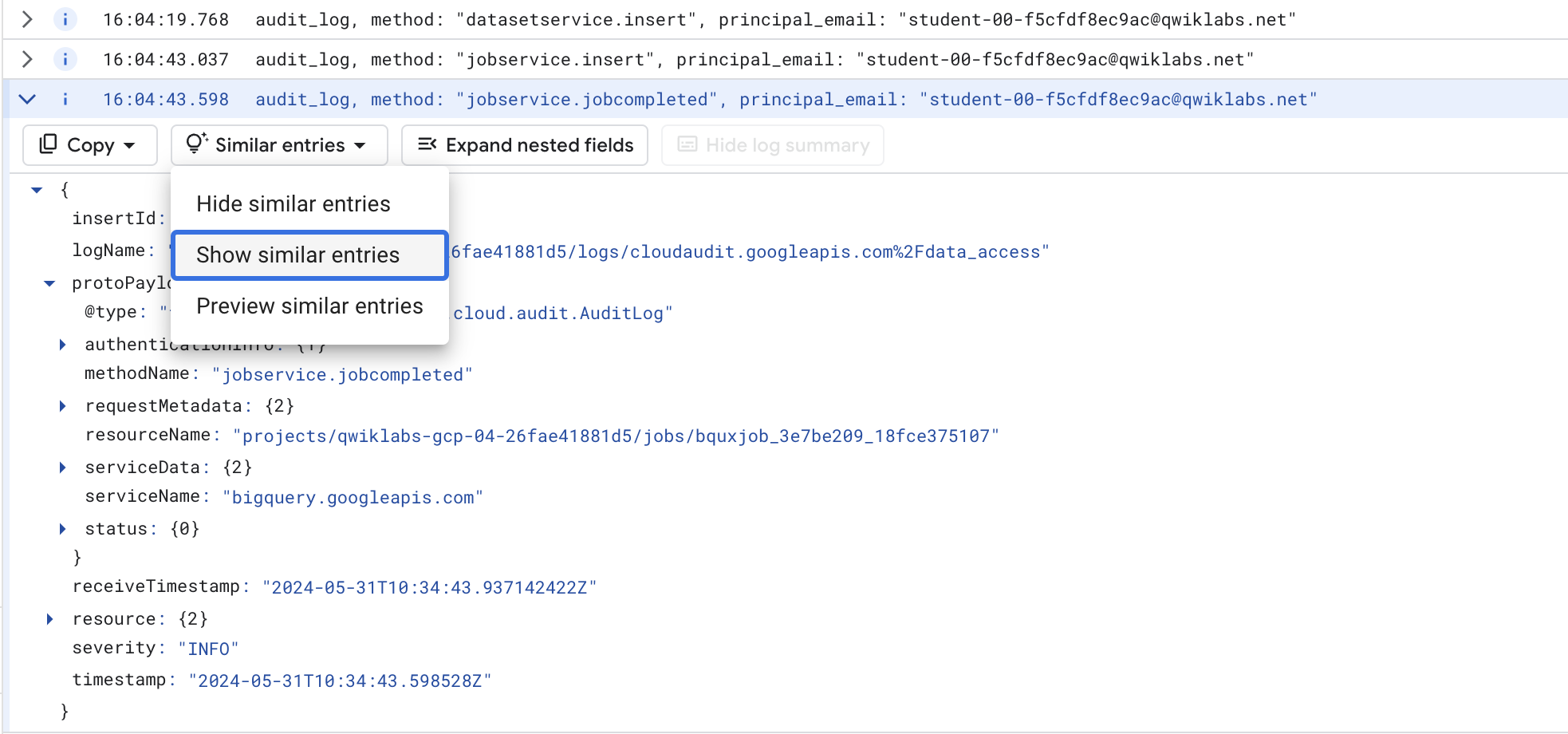

- Klicken Sie links davon auf den Pfeil, um den Eintrag zu maximieren.

Klicken Sie jetzt rechts auf die Schaltfläche Verschachtelte Felder maximieren.

Dadurch wird der vollständige JSON-Logeintrag angezeigt. Scrollen Sie nach unten und sehen Sie sich die unterschiedlichen Felder an.

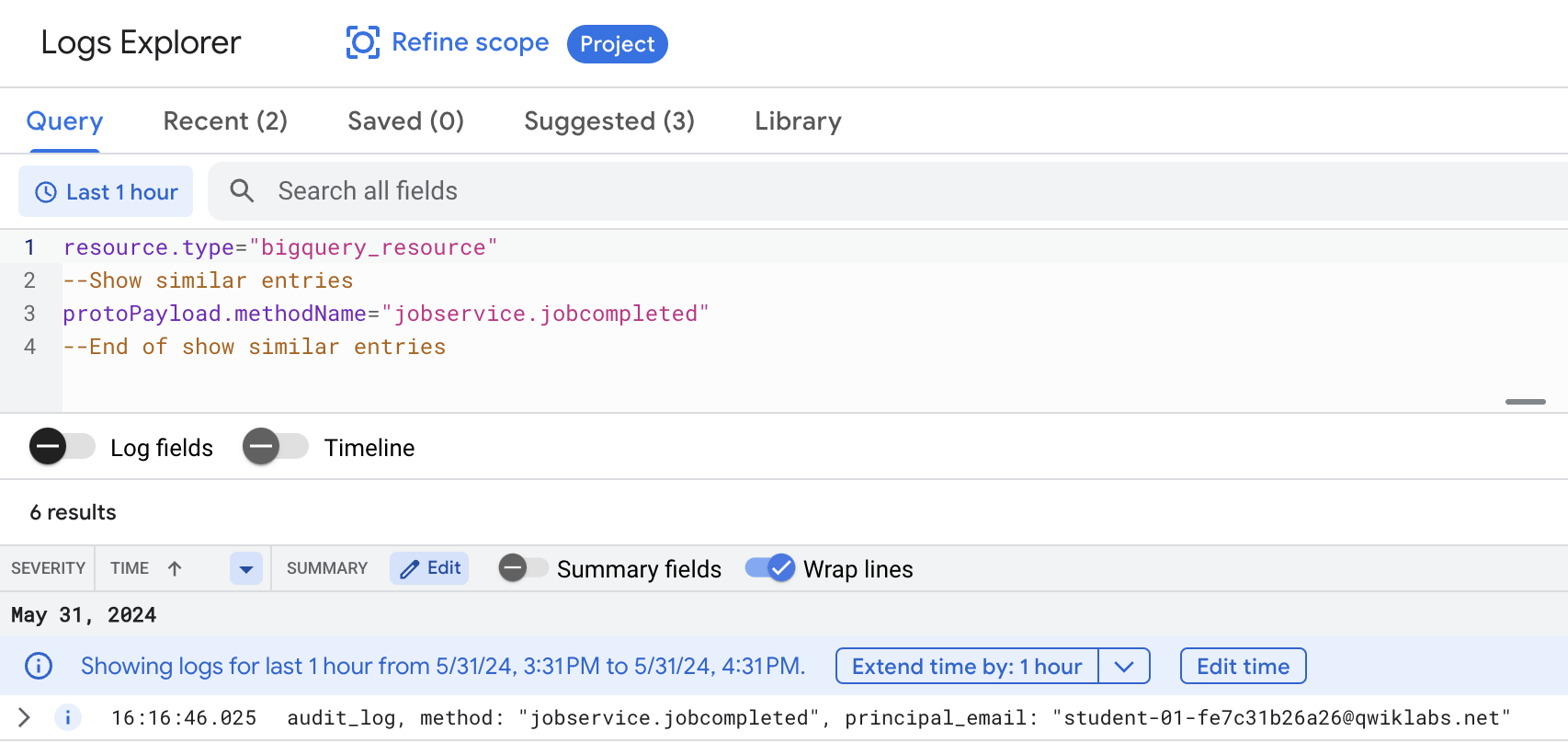

- Scrollen Sie wieder nach oben zum Header des Eintrags, klicken Sie auf jobcompleted und wählen Sie Übereinstimmende Einträge anzeigen aus.

Dadurch wird die Suche mit den korrekten Begriffen durchgeführt. Möglicherweise müssen Sie sie über die Schaltfläche Suchanfrage anzeigen einblenden.

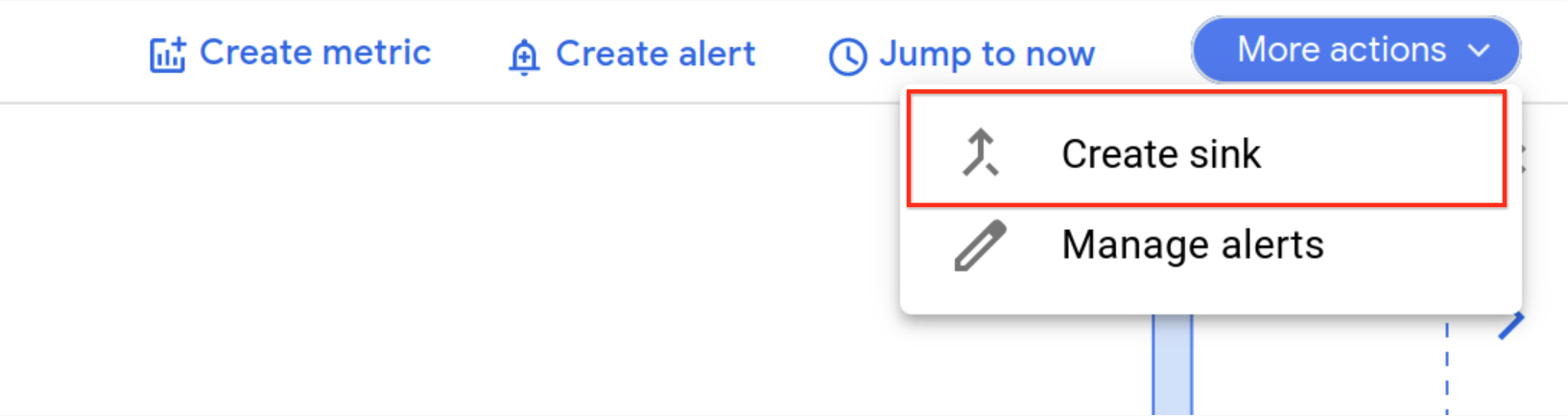

Senke erstellen

Nachdem Sie nun die benötigten Logs haben, können Sie eine Senke einrichten.

- Klicken Sie im Drop-down-Menü Weitere Aktionen auf Senke erstellen.

- Füllen Sie die Felder so aus:

- Name der Senke: JobComplete. Klicken Sie auf WEITER.

- Senkendienst auswählen: BigQuery dataset.

- BigQuery-Dataset auswählen (Ziel): bq_logs (das zuvor eingerichtete Dataset).

- Behalten Sie in allen anderen Feldern die Standardwerte bei.

- Klicken Sie auf SENKE ERSTELLEN.

Neue Logeinträge aus BigQuery werden nun in eine Tabelle im Dataset bq_logs exportiert.

Klicken Sie auf Fortschritt prüfen.

Aufgabe 5: Beispielabfragen ausführen

Führen Sie Beispielabfragen aus, um Logs in die neue Tabelle zu laden.

- Rufen Sie Cloud Shell auf und fügen Sie die folgenden BigQuery-Befehle ein:

Jede Abfrage sollte Ergebnisse liefern.

Klicken Sie auf Fortschritt prüfen.

Aufgabe 6: Logs in BigQuery ansehen

-

Kehren Sie zu BigQuery zurück (Navigationsmenü > BigQuery).

-

Maximieren Sie die Ressource, deren Name mit qwiklabs-gcp- beginnt, sowie das Dataset bq_logs.

Ihnen sollte eine Tabelle angezeigt werden, deren Name in etwa „cloudaudit_googleapis_com_data_access“ lautet.

- Klicken Sie auf den Namen der Tabelle und sehen Sie sich deren Schema an. Sie werden feststellen, dass sie eine große Anzahl an Feldern umfasst.

Wenn Sie auf Vorschau geklickt haben, aber keine Logs zu den vor Kurzem ausgeführten Abfragen angezeigt werden, liegt dies daran, dass die Logs in die Tabelle gestreamt werden. Dies bedeutet, dass die neuen Daten zwar abgefragt werden können, es aber einige Zeit dauert, bis sie in der Vorschau zu sehen sind.

Sie können die Tabelle besser nutzbar machen, indem Sie eine ANSICHT erstellen. Dafür wird dann eine Teilmenge der Felder abgerufen und einige Berechnungen werden durchgeführt, um einen Messwert für die Abfragezeit zu erhalten.

- Klicken Sie auf Neue Abfrage erstellen. Führen Sie im BigQuery-Abfrageeditor den folgenden SQL-Code aus, wobei Sie durch den Namen Ihres Projekts ersetzen. Die Projekt-ID können Sie ganz einfach aus dem Bereich Details zum Lab auf der linken Seite kopieren:

Klicken Sie auf Fortschritt prüfen.

- Fragen Sie nun die ANSICHT ab. Erstellen Sie eine neue Abfrage und führen Sie den folgenden Befehl aus:

- Scrollen Sie durch die Ergebnisse der ausgeführten Abfragen.

Das wars! Sie haben das Lab erfolgreich abgeschlossen.

Sie haben BigQuery-Logs aus Cloud Logging in eine BigQuery-Tabelle exportiert und sie dann mit SQL analysiert.

Weitere Informationen

Google Cloud-Schulungen und -Zertifizierungen

In unseren Schulungen erfahren Sie alles zum optimalen Einsatz unserer Google Cloud-Technologien und können sich entsprechend zertifizieren lassen. Unsere Kurse vermitteln technische Fähigkeiten und Best Practices, damit Sie möglichst schnell mit Google Cloud loslegen und Ihr Wissen fortlaufend erweitern können. Wir bieten On-Demand-, Präsenz- und virtuelle Schulungen für Anfänger wie Fortgeschrittene an, die Sie individuell in Ihrem eigenen Zeitplan absolvieren können. Mit unseren Zertifizierungen weisen Sie nach, dass Sie Experte im Bereich Google Cloud-Technologien sind.

Anleitung zuletzt am 5. Februar 2024 aktualisiert

Lab zuletzt am 27. September 2023 getestet

© 2024 Google LLC. Alle Rechte vorbehalten. Google und das Google-Logo sind Marken von Google LLC. Alle anderen Unternehmens- und Produktnamen können Marken der jeweils mit ihnen verbundenen Unternehmen sein.