En tant qu'ingénieur cloud, votre principal objectif est de créer des systèmes tolérants aux pannes, fiables, hautement disponibles et économiques dans le cloud. Vous souhaitez concevoir des solutions offrant une évolutivité automatique pour répondre aux pics de demande. Vous vous assurez que votre conception d'architecture n'est pas surprovisionnée et vous aide à optimiser les coûts. En général, vous tenez compte des éléments suivants lorsque vous réalisez vos conceptions :

- Comment ajouter la haute disponibilité à vos charges de travail ?

- Comment allouer dynamiquement des ressources pour répondre aux fluctuations des exigences de capacité ?

- Comment répartir le trafic entre différentes machines virtuelles (VM) ?

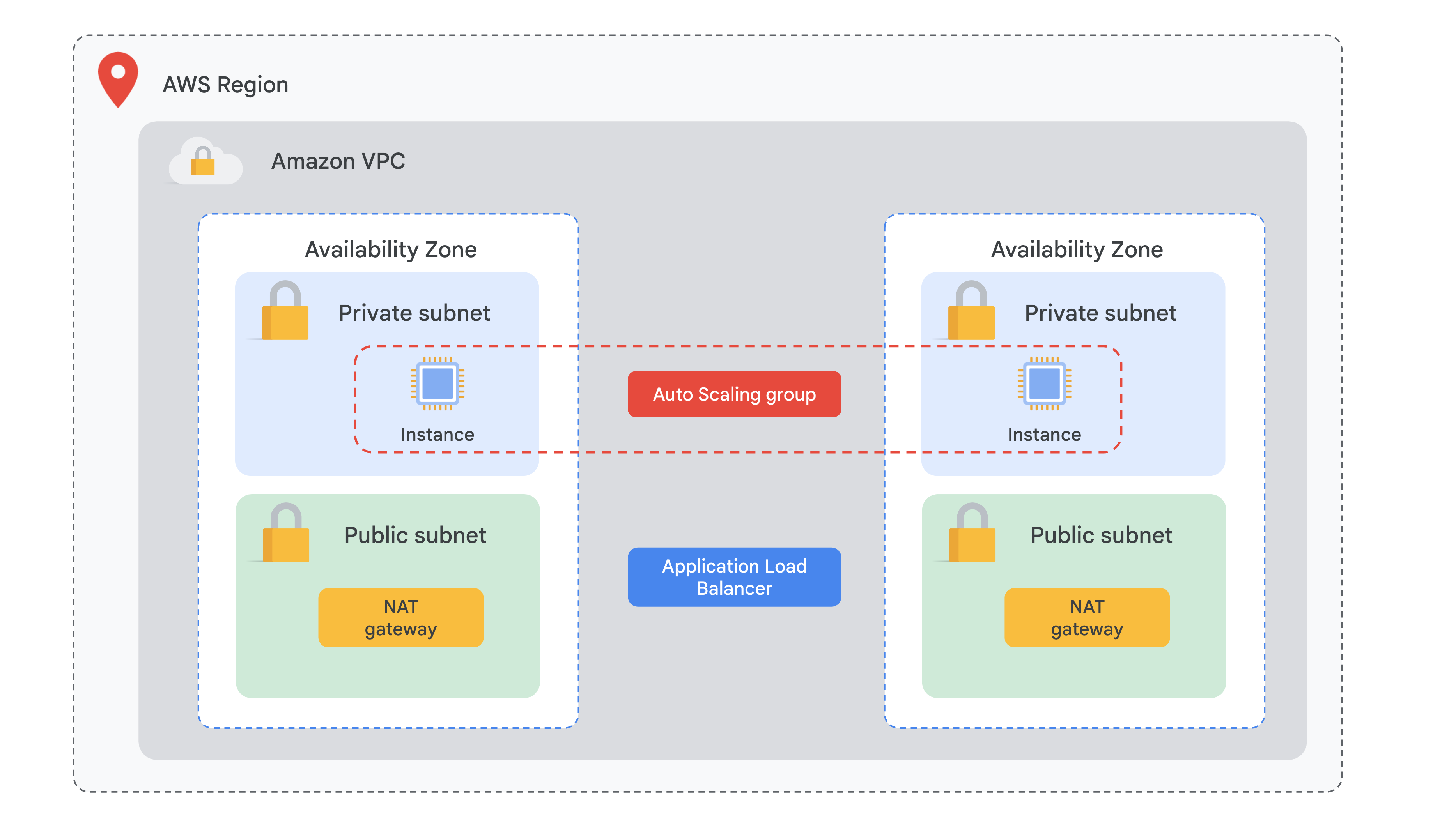

Dans AWS, vous avez créé des plans de scaling qui automatisent la façon dont des groupes de différentes ressources Elastic Compute Cloud (EC2) répondent aux fluctuations de la demande. Pour ce faire, vous avez utilisé les éléments suivants :

- Un équilibreur de charge ELB (Elastic Load Balancer) qui permet de répartir le trafic entre plusieurs cibles dans différentes zones de disponibilité et d'effectuer régulièrement des vérifications de l'état

- Des images AMI (Amazon Machine Images) personnalisées qui contiennent le système d'exploitation de vos instances EC2, ainsi que différentes configurations et applications nécessaires à vos opérations. Ces images permettent de démarrer des VM sans installer manuellement tous les services nécessaires

- Des modèles de lancement EC2 pour définir les paramètres requis pour lancer les instances EC2 dans les groupes Auto Scaling, tels que l'ID AMI, le type d'instance, le groupe de sécurité et les données utilisateur

- Des groupes Auto Scaling permettant d'augmenter et de réduire de manière dynamique la capacité de vos cibles afin de répondre à la demande en fonction de vos propres règles de scaling, de remplacer les instances non opérationnelles et d'optimiser les coûts

Vous allez maintenant explorer différents services de Google Cloud qui vous aideront à créer une solution évolutive et à disponibilité élevée.

Présentation

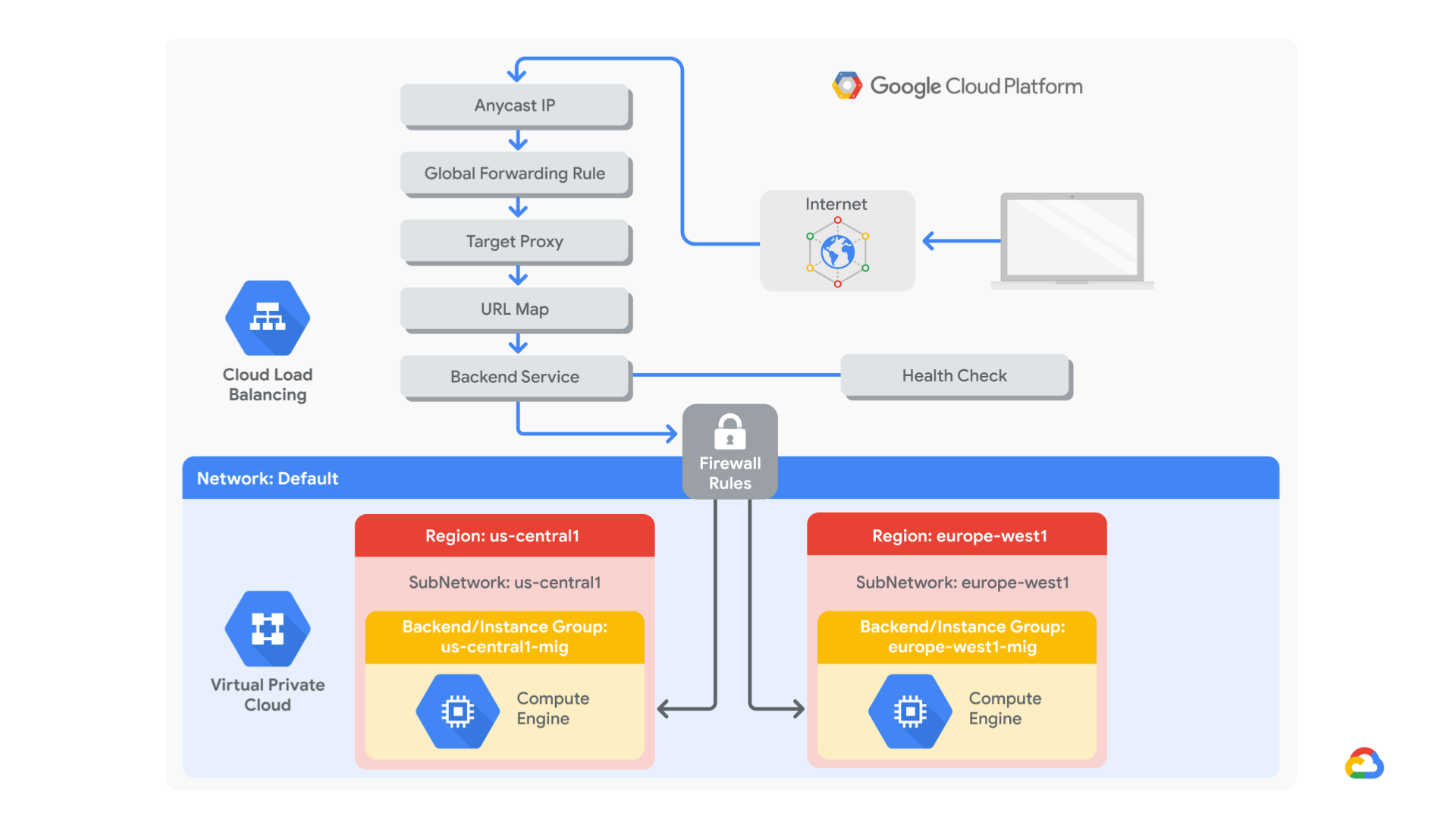

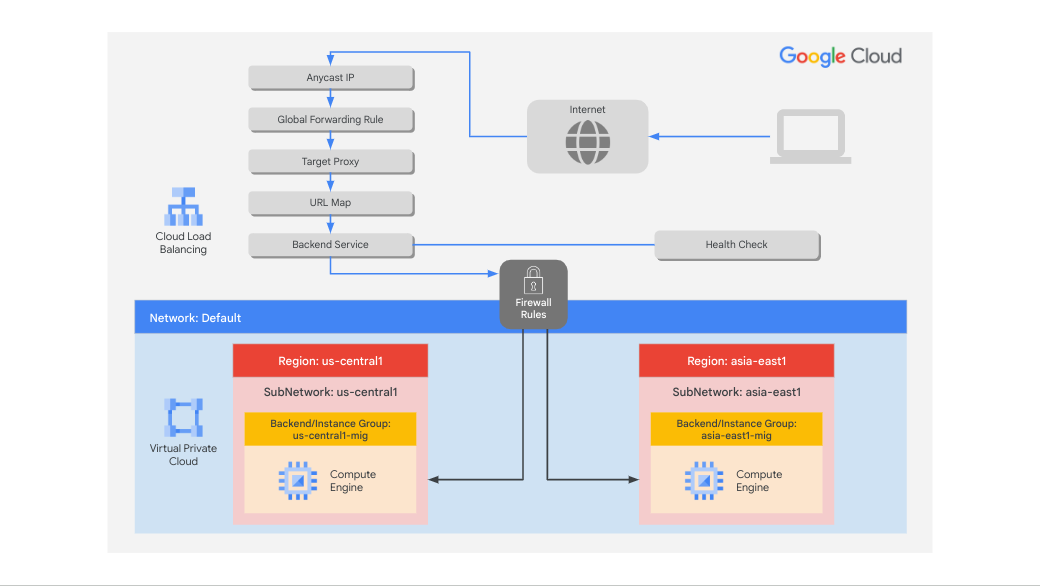

L'équilibrage de charge d'application (HTTP/HTTPS) est implémenté à la périphérie du réseau Google dans les points de présence (POP) de Google à travers le monde. Le trafic utilisateur dirigé vers un équilibreur de charge d'application (HTTP/HTTPS) entre dans le POP le plus proche de l'utilisateur. Ensuite, l'équilibrage de la charge sur le réseau mondial de Google permet d'acheminer le trafic jusqu'au backend le plus proche disposant d'une capacité suffisante.

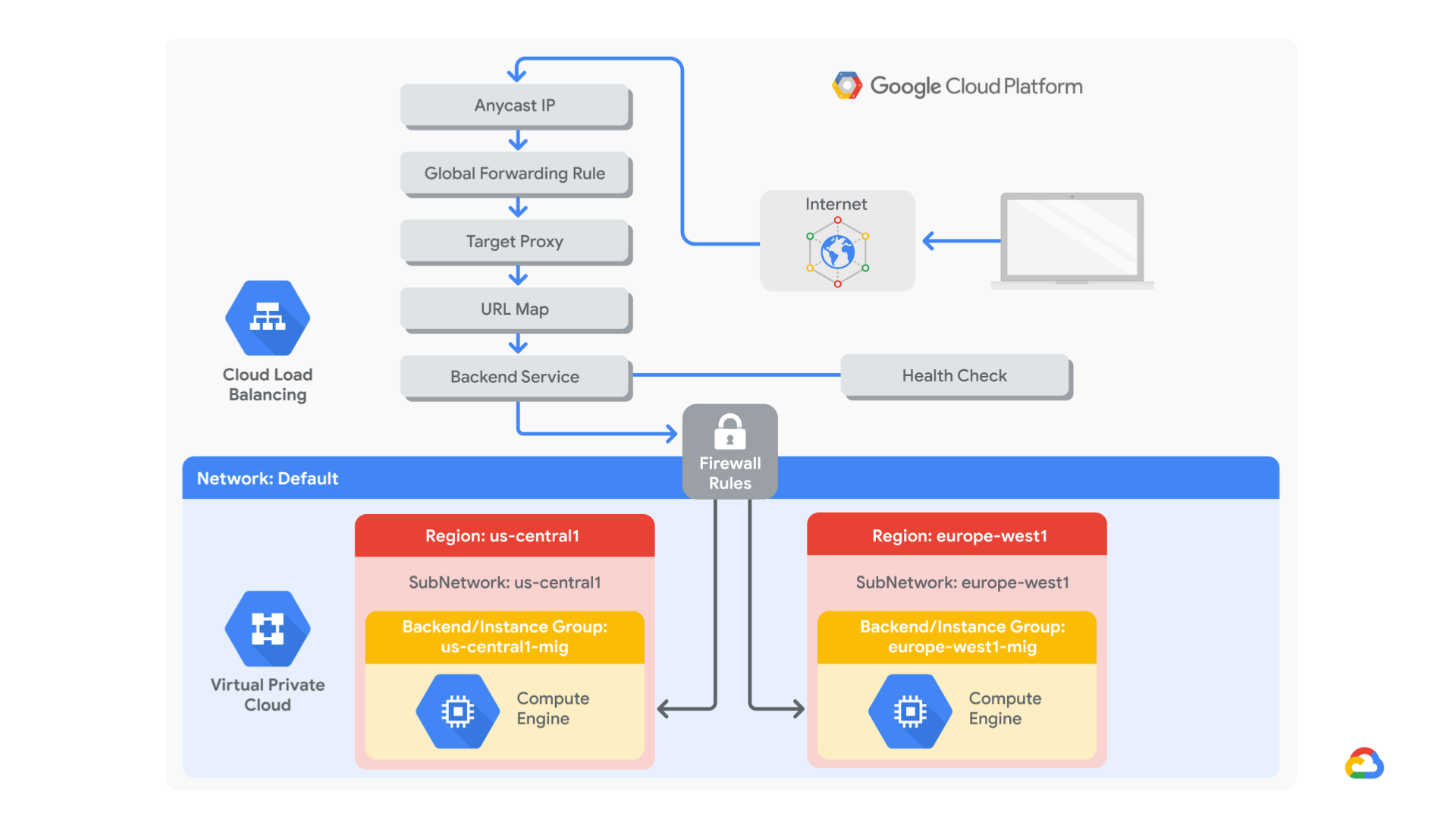

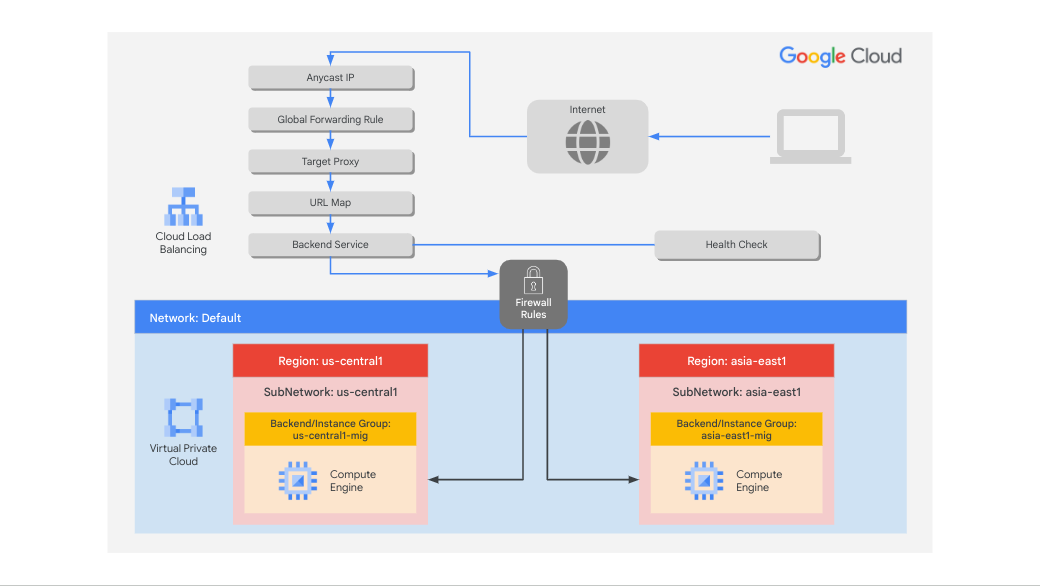

Dans cet atelier, vous allez configurer un équilibreur de charge d'application (HTTP), comme illustré dans le schéma ci-dessous. Vous effectuerez ensuite un test de contrainte sur l'équilibreur de charge pour vérifier que l'équilibrage de charge global et l'autoscaling fonctionnent.

Objectifs

Dans cet atelier, vous allez apprendre à effectuer les tâches suivantes :

- Créer une règle de pare-feu de vérification de l'état

- Créer une configuration NAT à l'aide de Cloud Router

- Créer une image personnalisée pour un serveur Web

- Créer un modèle d'instance basé sur l'image personnalisée

- Créer deux groupes d'instances gérés

- Configurer un équilibreur de charge d'application (HTTP) avec IPv4 et IPv6

- Effectuer un test de contrainte sur un équilibreur de charge d'application (HTTP)

Pour chaque atelier, nous vous attribuons un nouveau projet Google Cloud et un nouvel ensemble de ressources pour une durée déterminée, sans frais.

-

Cliquez sur le bouton Démarrer l'atelier. Si l'atelier est payant, un pop-up s'affiche pour vous permettre de sélectionner un mode de paiement.

Sur la gauche, vous trouverez le panneau Détails concernant l'atelier, qui contient les éléments suivants :

- Le bouton Ouvrir la console Google Cloud

- Le temps restant

- Les identifiants temporaires que vous devez utiliser pour cet atelier

- Des informations complémentaires vous permettant d'effectuer l'atelier

-

Cliquez sur Ouvrir la console Google Cloud (ou effectuez un clic droit et sélectionnez Ouvrir le lien dans la fenêtre de navigation privée si vous utilisez le navigateur Chrome).

L'atelier lance les ressources, puis ouvre la page Se connecter dans un nouvel onglet.

Conseil : Réorganisez les onglets dans des fenêtres distinctes, placées côte à côte.

Remarque : Si la boîte de dialogue Sélectionner un compte s'affiche, cliquez sur Utiliser un autre compte.

-

Si nécessaire, copiez le nom d'utilisateur ci-dessous et collez-le dans la boîte de dialogue Se connecter.

{{{user_0.username | "Username"}}}

Vous trouverez également le nom d'utilisateur dans le panneau Détails concernant l'atelier.

-

Cliquez sur Suivant.

-

Copiez le mot de passe ci-dessous et collez-le dans la boîte de dialogue Bienvenue.

{{{user_0.password | "Password"}}}

Vous trouverez également le mot de passe dans le panneau Détails concernant l'atelier.

-

Cliquez sur Suivant.

Important : Vous devez utiliser les identifiants fournis pour l'atelier. Ne saisissez pas ceux de votre compte Google Cloud.

Remarque : Si vous utilisez votre propre compte Google Cloud pour cet atelier, des frais supplémentaires peuvent vous être facturés.

-

Accédez aux pages suivantes :

- Acceptez les conditions d'utilisation.

- N'ajoutez pas d'options de récupération ni d'authentification à deux facteurs (ce compte est temporaire).

- Ne vous inscrivez pas à des essais gratuits.

Après quelques instants, la console Cloud s'ouvre dans cet onglet.

Remarque : Pour afficher un menu contenant la liste des produits et services Google Cloud, cliquez sur le menu de navigation en haut à gauche.

Tâche 1 : Configurer une règle de pare-feu de vérification de l'état

Dans cette tâche, vous allez configurer une règle de pare-feu pour autoriser le trafic de vérification de l'état vers vos instances.

Les vérifications de l'état déterminent les instances d'un équilibreur de charge d'application (HTTP) qui peuvent recevoir de nouvelles connexions. Les tests de vérification de l'état de vos instances à équilibrage de charge proviennent d'adresses comprises dans les plages 130.211.0.0/22 et 35.191.0.0/16. Vos règles de pare-feu doivent autoriser ces connexions.

Créer la règle de vérification de l'état

Créez une règle de pare-feu pour autoriser les vérifications de l'état.

-

Dans la console Cloud, accédez au menu de navigation  , puis cliquez sur Réseau VPC > Pare-feu.

, puis cliquez sur Réseau VPC > Pare-feu.

Examinez les règles de pare-feu ICMP, internes, RDP et SSH existantes.

Chaque projet Google Cloud débute avec le réseau par défaut et ces règles de pare-feu.

-

Cliquez sur Créer une règle de pare-feu.

-

Spécifiez les paramètres suivants et conservez les valeurs par défaut des autres paramètres :

| Propriété |

Valeur (saisissez la valeur ou sélectionnez l'option spécifiée) |

| Nom |

fw-allow-health-checks |

| Réseau |

par défaut |

| Cibles |

Tags cibles spécifiés |

| Tags cibles |

allow-health-checks |

| Filtre source |

Plages IPv4 |

| Plages IPv4 sources |

130.211.0.0/22 et 35.191.0.0/16 |

| Protocoles et ports |

Protocoles et ports spécifiés |

Remarque : Pensez à ajouter /22 et /16 dans les plages d'adresses IP sources.

- Sélectionnez tcp, puis spécifiez le port 80.

- Cliquez sur Créer.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Configurer la règle de pare-feu de vérification de l'état

Tâche 2 : Créer une configuration NAT à l'aide de Cloud Router

Dans cette tâche, vous allez créer une instance Cloud Router et configurer une passerelle Cloud NAT pour activer la connectivité Internet sortante pour vos instances de VM.

Les instances backend de VM Google Cloud que vous configurerez lors de la tâche 3 n'utiliseront pas des adresses IP externes.

À la place, vous allez configurer le service Cloud NAT pour permettre à ces instances de VM d'envoyer le trafic sortant uniquement via Cloud NAT et de recevoir le trafic entrant via l'équilibreur de charge.

Créer l'instance Cloud Router

-

Dans la barre de titre de la console Google Cloud, saisissez Services réseau dans le champ de recherche, puis cliquez sur Services réseau dans la section Outils de gestion du réseau.

-

Sur la page Service réseau, cliquez sur Épingler à côté de "Services réseau".

-

Cliquez sur Cloud NAT.

-

Cliquez sur Commencer pour configurer une passerelle NAT.

-

Spécifiez les paramètres suivants et conservez les valeurs par défaut des autres paramètres :

| Propriété |

Valeur (saisissez la valeur ou sélectionnez l'option spécifiée) |

| Nom de la passerelle |

nat-config |

| Réseau |

par défaut |

| Région |

|

-

Cliquez sur Cloud Router, puis sélectionnez Créer un routeur.

-

Dans le champ Nom, saisissez nat-router-us1.

-

Cliquez sur Créer.

-

Dans "Créer une passerelle Cloud NAT", cliquez sur Créer.

Remarque : Attendez que la valeur du champ "État de la passerelle NAT" passe à "Exécution" avant de basculer sur la tâche suivante.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Créer une configuration NAT à l'aide de Cloud Router

Tâche 3 : Créer une image personnalisée pour un serveur Web

Dans cette tâche, vous allez créer une image de serveur Web personnalisée pour le backend de l'équilibreur de charge.

Créer une VM

-

Dans la console Cloud, accédez au menu de navigation  , puis cliquez sur Compute Engine > Instances de VM.

, puis cliquez sur Compute Engine > Instances de VM.

-

Cliquez sur Créer une instance.

-

Spécifiez les paramètres suivants et conservez les valeurs par défaut des autres paramètres :

| Propriété |

Valeur (saisissez la valeur ou sélectionnez l'option spécifiée) |

| Nom |

webserver |

| Région |

|

| Zone |

|

-

Cliquez sur OS et stockage, puis sur Modifier.

-

Cliquez sur Afficher les options de configuration avancées.

-

Sous le paramètre Règle de suppression, sélectionnez Conserver le disque de démarrage.

-

Cliquez sur Sélectionner.

-

Cliquez sur Mise en réseau.

- Dans le champ Tags réseau, saisissez allow-health-checks.

- Dans la section Interfaces réseau, cliquez sur Par défaut.

- Dans le menu déroulant Adresse IPv4 externe, sélectionnez Aucune.

-

Cliquez sur OK.

-

Cliquez sur Créer.

Personnaliser la VM

- Pour webserver, cliquez sur SSH pour lancer un terminal et vous connecter.

- Si vous y êtes invité, autorisez la fonctionnalité SSH dans le navigateur à se connecter à la VM en cliquant sur Autoriser.

- Pour installer Apache2, exécutez les commandes suivantes :

sudo apt-get update

sudo apt-get install -y apache2

- Pour démarrer le serveur Apache, exécutez la commande suivante :

sudo service apache2 start

- Pour tester la page par défaut du serveur Apache2, exécutez la commande suivante :

curl localhost

La page par défaut du serveur Apache2 devrait alors s'ouvrir.

Activer le démarrage du service Apache au lancement de la VM

Le logiciel a bien été installé. Toutefois, lorsqu'une VM est créée à l'aide de cette image et qu'elle vient juste de démarrer, elle n'exécute pas le serveur Web Apache. Utilisez la commande suivante afin d'activer le démarrage automatique du service Apache au lancement de la VM. Effectuez un test pour vous assurer que tout fonctionne correctement.

- Dans le terminal SSH webserver, activez le démarrage du service au lancement de la VM :

sudo update-rc.d apache2 enable

-

Dans la console Cloud, sélectionnez webserver, puis cliquez sur Autres actions  .

.

-

Cliquez sur Réinitialiser.

-

Dans la boîte de dialogue de confirmation, cliquez sur Réinitialiser.

Remarque : La réinitialisation arrête la machine, puis la redémarre. Les adresses IP sont conservées, tout comme le disque de démarrage persistant, mais la mémoire est effacée. Par conséquent, si le service Apache est disponible après la réinitialisation, cela signifie que la commande update-rc a bien été exécutée.

- Vérifiez l'état du serveur en vous connectant à la VM via SSH et en saisissant la commande suivante :

sudo service apache2 status

Remarque : Si le message Échec de la connexion via Cloud Identity-Aware Proxy s'affiche, cliquez sur Réessayer.

- Le résultat suivant devrait s'afficher : Started The Apache HTTP Server (Serveur HTTP Apache démarré).

Préparer le disque pour créer une image personnalisée

Assurez-vous de conserver le disque de démarrage lors de la suppression de l'instance.

- Sur la page des instances de VM, cliquez sur webserver pour afficher les informations sur l'instance de VM.

- Sous Stockage > Disque de démarrage, vérifiez que l'option Lors de la suppression d'une instance est définie sur Conserver le disque.

- Revenez sur la page des instances de VM, sélectionnez webserver, puis cliquez sur Autres actions (

).

).

- Cliquez sur Supprimer.

- Dans la boîte de dialogue de confirmation, cliquez sur Supprimer.

- Dans le volet de gauche, cliquez sur Disques et vérifiez que le disque webserver existe bien.

Créer l'image personnalisée

-

Dans le volet de gauche, cliquez sur Images.

-

Cliquez sur Créer une image.

-

Spécifiez les paramètres suivants et conservez les valeurs par défaut des autres paramètres :

| Propriété |

Valeur (saisissez la valeur ou sélectionnez l'option spécifiée) |

| Nom |

mywebserver |

| Source |

Disque |

| Disque source |

webserver |

-

Cliquez sur Créer.

Remarque : Vous avez créé une image personnalisée à partir de laquelle plusieurs serveurs Web ("webserver") identiques peuvent être démarrés. À ce stade, vous pourriez supprimer le disque webserver.

L'étape suivante consiste à définir un modèle d'instance utilisable dans un groupe d'instances géré à partir de cette image.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Créer une image personnalisée pour un serveur Web

Tâche 4 : Configurer un modèle d'instance et créer des groupes d'instances

Dans cette tâche, vous allez configurer des modèles d'instance et créer des groupes d'instances gérés pour votre serveur Web avec équilibrage de charge.

Un groupe d'instances géré crée un groupe d'instances identiques à l'aide d'un modèle d'instance. Utilisez ces instances pour créer les backends de l'équilibreur de charge d'application (HTTP).

Configurer le modèle d'instance

Un modèle d'instance est une ressource API qui vous permet de créer des instances de VM et des groupes d'instances gérés. Les modèles d'instance définissent le type de machine, l'image disque de démarrage, le sous-réseau, les étiquettes et d'autres propriétés d'instance.

- Dans la console Google Cloud, accédez au menu de navigation

, puis cliquez sur Compute Engine > Modèles d'instances.

, puis cliquez sur Compute Engine > Modèles d'instances.

- Cliquez sur Créer un modèle d'instance.

- Dans Nom, saisissez mywebserver-template.

- Dans Emplacement, sélectionnez Mondial.

- Dans le champ Série, sélectionnez E2.

- Dans Type de machine > Cœur partagé, sélectionnez e2-micro (2 vCPU, 1 cœur, 1 Go de mémoire).

- Dans Disque de démarrage, cliquez sur Modifier.

- Cliquez sur Images personnalisées et assurez-vous que l'ID du projet Qwiklabs est sélectionné dans Projet source pour les images.

- Pour le champ Image, sélectionnez mywebserver.

- Cliquez sur Sélectionner.

- Cliquez sur Options avancées.

- Cliquez sur Mise en réseau.

- Dans le champ Tags réseau, saisissez allow-health-checks.

- Sous Interfaces réseau, cliquez sur par défaut.

- Dans le menu déroulant Adresse IPv4 externe, sélectionnez Aucune.

- Cliquez sur OK.

- Cliquez sur Créer.

Créer une vérification de l'état pour les groupes d'instances gérés

-

Dans le menu de navigation, cliquez sur Compute Engine > Vérifications de l'état.

-

Cliquez sur Créer une vérification de l'état.

-

Spécifiez les paramètres suivants et conservez les valeurs par défaut des autres paramètres :

| Propriété |

Valeur (sélectionnez l'option spécifiée) |

| Nom |

http-health-check |

| Protocole |

TCP |

| Port |

80 |

-

Cliquez sur Créer.

Les vérifications de l'état des groupes d'instances gérés signalent de manière proactive que des instances doivent être supprimées et recréées lorsqu'elles sont non opérationnelles.

Créer des groupes d'instances gérés

Créez un groupe d'instances géré dans et un autre dans .

-

Dans le menu de navigation, cliquez sur Compute Engine > Groupes d'instances.

-

Cliquez sur Créer un groupe d'instances.

-

Spécifiez les paramètres suivants et conservez les valeurs par défaut des autres paramètres :

| Propriété |

Valeur (saisissez la valeur ou sélectionnez l'option spécifiée) |

| Nom |

us-1-mig |

| Modèle d'instance |

mywebserver-template |

| Emplacement |

Plusieurs zones |

| Région |

|

-

Pour Autoscaling, définissez le nombre minimal d'instances sur 1 et le nombre maximal sur 2.

-

Pour Signaux d'autoscaling, cliquez sur Utilisation du processeur.

-

Pour Type de signal, sélectionnez Utilisation de l'équilibrage de charge HTTP.

-

Définissez la valeur "Utilisation de l'équilibrage de charge HTTP" sur 80.

-

Cliquez sur OK.

-

Cliquez sur Période d'initialisation et définissez la valeur sur 60 secondes.

Remarque : Les groupes d'instances gérés proposent des fonctionnalités d'autoscaling qui vous permettent d'ajouter ou de supprimer automatiquement des instances dans un groupe géré en fonction de l'augmentation ou de la réduction de la charge. Avec l'autoscaling, vos applications peuvent gérer de façon optimale les hausses de trafic et réduire vos coûts lorsque les besoins en ressources sont moins importants. Il vous suffit de définir des règles d'autoscaling pour que l'autoscaler procède automatiquement aux ajustements nécessaires en fonction de la charge mesurée.

-

Sous Autoréparation, pour Vérification de l'état, saisissez http-health-check.

-

Sélectionnez http-health-check (TCP).

-

Dans Délai initial, saisissez 60.

Il s'agit de la durée d'attente entre l'initialisation du démarrage de la VM et la tentative de vérification de l'état par le groupe d'instances. Il n'est pas nécessaire de patienter cinq minutes pour cet atelier. Vous pouvez donc définir une durée d'une minute.

-

Cliquez sur Créer.

-

Cliquez sur Confirmer dans la boîte de dialogue.

Remarque : Attendez que le groupe d'instances soit créé (ce qui peut prendre quelques minutes) avant de répéter la même opération pour asia-1-mig dans la région . Cliquez sur Actualiser jusqu'à ce que l'état passe à En cours de transformation .

Remarque : Vous pourriez voir apparaître un point d'exclamation rouge à gauche du groupe d'instances créé, ou une fenêtre d'avertissement avec le message Aucun service de backend n'est associé au groupe d'instances. Vous pouvez l'ignorer, car vous configurerez un service de backend pour l'équilibreur de charge dans la prochaine section de l'atelier.

-

Cliquez sur Créer un groupe d'instances.

-

Spécifiez les paramètres suivants et conservez les valeurs par défaut des autres paramètres :

| Propriété |

Valeur (saisissez la valeur ou sélectionnez l'option spécifiée) |

| Nom |

notus-1-mig |

| Modèle d'instance |

mywebserver-template |

| Emplacement |

Plusieurs zones |

| Région |

|

| Autoscaling > Nombre minimal d'instances |

1 |

| Autoscaling > Nombre maximal d'instances |

2 |

| Signaux d'autoscaling > Type de signal |

Utilisation de l'équilibrage de charge HTTP |

| Utilisation cible de l'équilibrage de charge HTTP |

80 |

| Période d'initialisation |

60 |

-

Dans Vérification de l'état, sélectionnez http-health-check (TCP).

-

Dans Délai initial, saisissez 60.

-

Cliquez sur Créer.

-

Cliquez sur Confirmer dans la boîte de dialogue.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Configurer un modèle d'instance et créer des groupes d'instances

Vérifier les backends

Vérifiez que les instances de VM sont créées dans les deux régions.

- Dans le menu de navigation, cliquez sur Compute Engine > Instances de VM.

Examinez les instances qui commencent par us-1-mig et notus-1-mig. Ces instances appartiennent aux groupes d'instances gérés.

Tâche 5 : Configurer l'équilibreur de charge d'application (HTTP)

Dans cette tâche, vous allez configurer l'équilibreur de charge d'application (HTTP) pour qu'il équilibre le trafic entre les deux backends (us-1-mig dans et notus-1-mig dans ), comme illustré dans le schéma réseau suivant :

Démarrer la configuration

- Dans le menu de navigation, cliquez sur Services réseau > Équilibrage de charge.

- Cliquez sur Créer un équilibreur de charge.

- Pour Type d'équilibreur de charge, sélectionnez Équilibreur de charge d'application (HTTP/HTTPS), puis cliquez sur Suivant.

- Pour Public ou interne, sélectionnez Public (externe), puis cliquez sur Suivant.

- Pour Déploiement mondial ou dans une seule région, sélectionnez Recommandé pour les charges de travail à l'échelle mondiale, puis cliquez sur Suivant.

- Pour Génération de l'équilibreur de charge, sélectionnez Équilibreur de charge d'application externe global, puis cliquez sur Suivant.

- Pour Créer un équilibreur de charge, cliquez sur Configurer.

- Pour Nom de l'équilibreur de charge, saisissez http-lb.

Configurer l'interface

Les règles d'hôte et de chemin d'accès déterminent la manière dont le trafic est dirigé. Par exemple, vous pouvez diriger le trafic vidéo vers un backend et le trafic statique vers un autre backend. Dans le cadre de cet atelier, vous n'aurez pas à configurer de règles d'hôte et de chemin d'accès.

-

Cliquez sur Configuration de l'interface.

-

Spécifiez les paramètres suivants et conservez les valeurs par défaut des autres paramètres :

| Propriété |

Valeur (saisissez la valeur ou sélectionnez l'option spécifiée) |

| Protocole |

HTTP |

| Version IP |

IPv4 |

| Adresse IP |

Éphémère |

| Port |

80 |

-

Cliquez sur OK.

-

Cliquez sur Ajouter un IP et port frontend.

-

Spécifiez les paramètres suivants et conservez les valeurs par défaut des autres paramètres :

| Propriété |

Valeur (saisissez la valeur ou sélectionnez l'option spécifiée) |

| Protocole |

HTTP |

| Version IP |

IPv6 |

| Adresse IP |

Attribuer automatiquement |

| Port |

80 |

-

Cliquez sur OK.

L'équilibrage de charge d'application (HTTP/HTTPS) accepte le trafic client provenant d'adresses IPv4 et IPv6. Les requêtes client IPv6 sont interrompues au niveau de la couche d'équilibrage de charge globale, puis transmises par le biais d'un serveur proxy, via IPv4, à vos backends.

Configurer le backend

Les services de backend dirigent le trafic entrant vers un ou plusieurs backends associés. Chaque backend est composé d'un groupe d'instances et de métadonnées sur sa capacité de livraison supplémentaire.

-

Cliquez sur Configuration du backend.

-

Cliquez sur Services de backend et buckets backend > Créer un service de backend.

-

Spécifiez les paramètres suivants et conservez les valeurs par défaut des autres paramètres :

| Propriété |

Valeur (sélectionnez l'option spécifiée) |

| Nom |

http-backend |

| Type de backend |

Groupe d'instances |

| Groupe d'instances |

us-1-mig |

| Numéros de ports |

80 |

| Mode d'équilibrage |

Fréquence |

| Nombre maximal de RPS |

50 |

| Capacité |

100 |

Remarque : Avec cette configuration, l'équilibreur de charge tente de maintenir chaque instance de us-1-mig à 50 requêtes par seconde (RPS) ou moins.

-

Cliquez sur OK.

-

Cliquez sur Ajouter un backend.

-

Spécifiez les paramètres suivants et conservez les valeurs par défaut des autres paramètres :

| Propriété |

Valeur (sélectionnez l'option spécifiée) |

| Groupe d'instances |

notus-1-mig |

| Numéros de ports |

80 |

| Mode d'équilibrage |

Utilisation |

| Utilisation maximale du backend |

80 |

| Capacité |

100 |

Remarque : Avec cette configuration, l'équilibreur de charge tente de maintenir chaque instance de notus-1-mig à 80 % d'utilisation du processeur ou moins.

- Cliquez sur OK.

- Dans Vérification de l'état, sélectionnez http-health-check.

- Cochez la case Activer la journalisation.

- Indiquez la valeur

1 pour le Taux d'échantillonnage.

- Cliquez sur Créer.

- Cliquez sur OK.

Vérifier et créer un équilibreur de charge HTTP

- Cliquez sur Vérifier et finaliser.

- Vérifiez les services de backend et l'interface.

- Cliquez sur Créer. Attendez jusqu'à ce que l'équilibreur de charge soit créé.

- Cliquez sur le nom de l'équilibreur de charge (http-lb).

- Notez les adresses IPv4 et IPv6 de l'équilibreur de charge pour la prochaine tâche. Elles seront appelées respectivement

[LB_IP_v4] et [LB_IP_v6].

Remarque : L'adresse IPv6 est au format hexadécimal.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Configurer l'équilibreur de charge d'application (HTTP)

Tâche 6 : Effectuer un test de contrainte sur l'équilibreur de charge d'application (HTTP)

Dans cette tâche, vous allez effectuer un test de contrainte sur votre équilibreur de charge d'application (HTTP) pour vérifier que le trafic est bien transféré vers le service de backend.

Accéder à l'équilibreur de charge HTTP

- Dans la barre de titre de la console Google Cloud, cliquez sur Activer Cloud Shell (

).

).

- Cliquez sur Continuer si vous y êtes invité.

- Pour vérifier l'état de l'équilibreur de charge, exécutez la commande suivante, en remplaçant [LB_IP_v4] par l'adresse IPv4 de l'équilibreur de charge :

LB_IP=[LB_IP_v4]

while [ -z "$RESULT" ] ;

do

echo "Waiting for Load Balancer";

sleep 5;

RESULT=$(curl -m1 -s $LB_IP | grep Apache);

done

Remarque : Une fois que l'équilibreur de charge est prêt, la commande se ferme.

- Ouvrez un nouvel onglet dans votre navigateur et accédez à

http://[LB_IP_v4]. Veillez à remplacer [LB_IP_v4] par l'adresse IPv4 de l'équilibreur de charge.

Effectuer un test de contrainte sur l'équilibreur de charge d'application (HTTP)

Créez une VM pour simuler une charge sur l'équilibreur de charge d'application (HTTP). Déterminez ensuite si le trafic est équilibré sur les deux backends lorsque la charge est élevée.

-

Dans la console Cloud, accédez au menu de navigation ( ), puis cliquez sur Compute Engine > Instances de VM.

), puis cliquez sur Compute Engine > Instances de VM.

-

Cliquez sur Créer une instance.

-

Spécifiez les paramètres suivants et conservez les valeurs par défaut des autres paramètres :

| Propriété |

Valeur (saisissez la valeur ou sélectionnez l'option spécifiée) |

| Nom |

stress-test |

| Région |

Une région différente, mais plus proche de

|

| Zone |

Une zone de la région |

-

Dans le champ Série, sélectionnez E2.

-

Dans le champ Type de machine, sélectionnez e2-micro (2 vCPU, 1 cœur, 1 Go de mémoire).

Remarque : Une région aux États-Unis étant plus proche de que de notus-1, le trafic devrait uniquement être dirigé vers us-1-mig (sauf si la charge est trop élevée).

- Cliquez sur OS et stockage, puis sur Modifier.

- Cliquez sur Images personnalisées.

- Cliquez sur Images personnalisées, puis assurez-vous que l'ID du projet Qwiklabs est sélectionné dans Projet source pour les images.

- Dans le champ Image, sélectionnez mywebserver.

- Cliquez sur Sélectionner.

- Cliquez sur Créer.

- Attendez que l'instance stress-test soit créée.

- Dans stress-test, cliquez sur SSH pour lancer un terminal et vous y connecter.

- Si vous y êtes invité, autorisez la fonctionnalité SSH dans le navigateur à se connecter à la VM en cliquant sur Autoriser.

- Pour créer une variable d'environnement destinée à l'adresse IP de l'équilibreur de charge, exécutez la commande suivante :

export LB_IP=<Enter your [LB_IP_v4] here>

- Effectuez une vérification à l'aide de la commande "echo" :

echo $LB_IP

- Pour placer une charge sur l'équilibreur de charge, exécutez la commande suivante :

ab -n 500000 -c 1000 http://$LB_IP/

Cliquez sur Vérifier ma progression pour valider l'objectif.

Effectuer un test de contrainte sur l'équilibreur de charge d'application (HTTP)

- Dans la console Cloud, accédez au menu de navigation

, puis cliquez sur Services réseau > Équilibrage de charge.

, puis cliquez sur Services réseau > Équilibrage de charge.

- Cliquez sur http-lb.

- Cliquez sur Surveillance.

- Observez le champ Emplacement de l'interface (Total du trafic entrant) entre l'Amérique du Nord et les deux backends pendant quelques minutes.

Remarque : Dans un premier temps, le trafic devrait être dirigé vers us-1-mig, mais, à mesure que les RPS augmentent, il sera progressivement dirigé également vers notus-1-mig. Cela démontre que le trafic est transmis par défaut au backend le plus proche, mais qu'il peut être réparti entre les backends si la charge est très élevée.

- Dans la console Cloud, accédez au menu de navigation (

), puis cliquez sur Compute Engine > Groupes d'instances.

), puis cliquez sur Compute Engine > Groupes d'instances.

- Cliquez sur us-1-mig pour ouvrir la page du groupe d'instances.

- Cliquez sur Surveillance pour contrôler le nombre d'instances et la capacité de l'équilibreur de charge.

- Répétez ces opérations pour le groupe d'instances notus-1-mig.

Remarque : Le cas échéant, vous pourrez voir les backends s'adapter en fonction de l'importance de la charge.

Tâche 7 : Récapitulatif

Dans cet atelier, vous avez configuré un équilibreur de charge d'application (HTTP) avec des backends dans et . Vous avez ensuite effectué un test de contrainte sur l'équilibreur de charge avec une VM, pour vérifier que l'équilibrage de charge global et l'autoscaling fonctionnent.

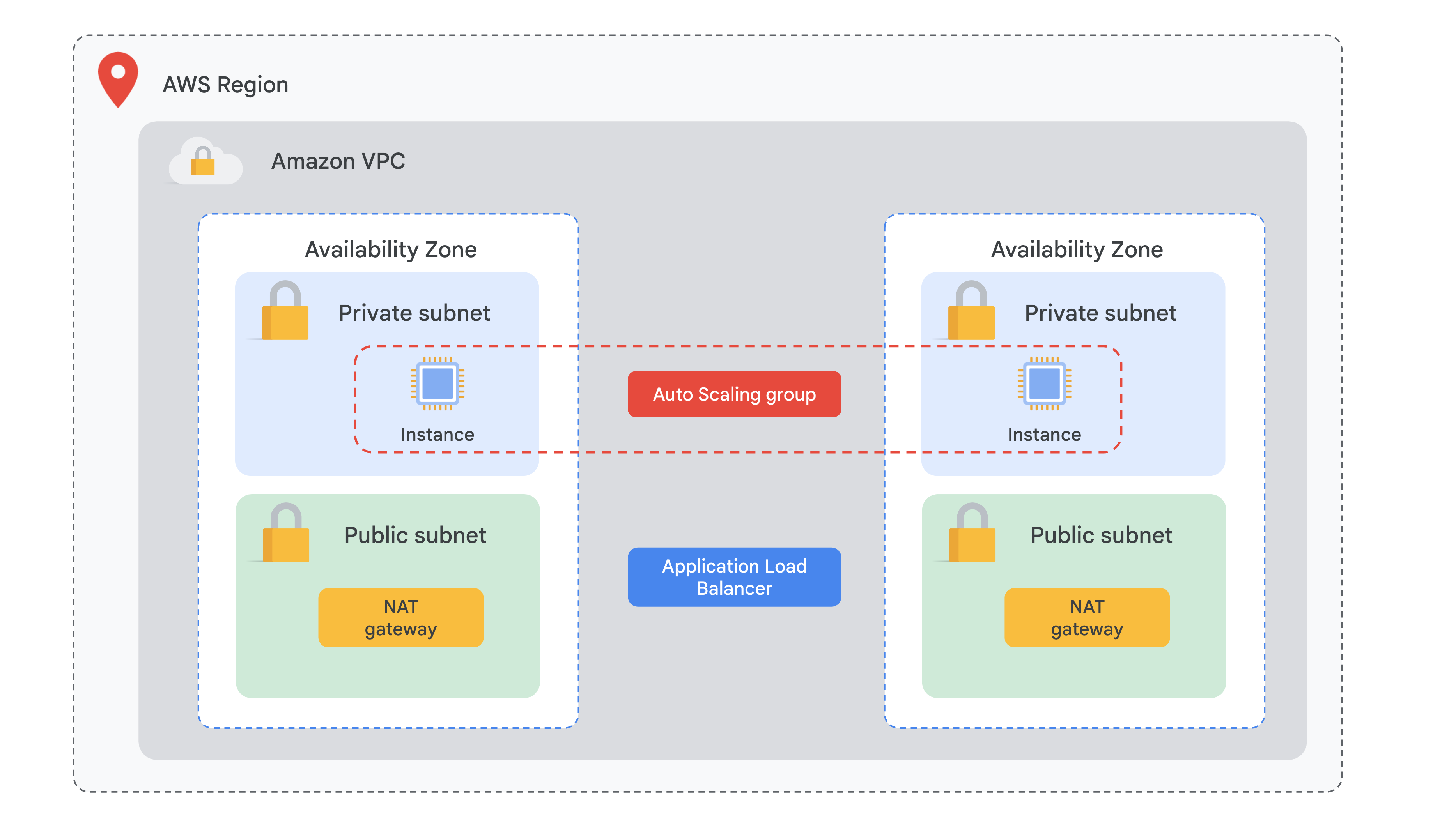

Dans AWS, un modèle courant d'architecture à disponibilité élevée inclut les éléments suivants :

- Des groupes Auto Scaling qui lancent de nouvelles instances EC2 (Elastic Compute Cloud) en fonction de vérifications de l'état et de règles de scaling, augmentant ou réduisant le nombre d'instances selon les besoins, et qui remplacent les instances non opérationnelles

- Des images AMI (Amazon Machine Images) personnalisées et des modèles de lancement qui définissent les paramètres des instances EC2 lancées dans un groupe Auto Scaling, par exemple :

- Système d'exploitation

- Applications préconfigurées

- Type d'instance

- Données utilisateur

- Type de stockage installé

- Sécurité

- Des équilibreurs de charge ELB (Elastic Load Balancer) pouvant répartir le trafic entre des groupes cibles dans différentes zones de disponibilité

Dans Google Cloud, vous pouvez utiliser les services suivants pour atteindre une haute disponibilité pour vos charges de travail :

- Des images de système d'exploitation personnalisées pour Compute Engine : il s'agit d'images d'OS réutilisables que vous créez à partir du disque de démarrage de votre VM ou d'autres images. Elles sont préconfigurées avec les applications dont votre organisation a besoin. Ces images d'OS peuvent être utilisées pour lancer de nouvelles instances.

- Un MIG (groupe d'instances géré) : ensemble de VM que vous pouvez gérer comme une seule entité et que vous pouvez adapter automatiquement à la demande en augmentant le nombre d'instances dans le groupe. Lorsque les ressources ne sont plus nécessaires, les MIG avec autoscaling peuvent se débarrasser des instances en trop pour réduire les coûts.

Une autre fonctionnalité des MIG permet d'effectuer des vérifications de l'état qui signalent de manière proactive que les instances dont l'état est "non opérationnel" doivent être remplacées.

- Un équilibreur de charge Google Cloud : répartit le trafic entrant sur plusieurs instances, ce qui réduit le risque de problèmes de performances et améliore la disponibilité.

Dans Google Cloud, vous trouverez deux principaux types d'équilibreurs de charge :

- Interne : répartit le trafic vers les instances à l'intérieur de Google Cloud

- Externe : distribue le trafic provenant de l'Internet public vers votre réseau cloud privé virtuel (VPC) Google Cloud

Vous avez également le choix entre un équilibrage de charge régional ou, dans le cas d'un équilibreur de charge externe, un équilibrage de charge mondial.

Un autre aspect à prendre en compte lors de la sélection d'un équilibreur de charge approprié est le type de trafic, par exemple TCP/UDP, HTTP et HTTPS, ou SSL.

Terminer l'atelier

Une fois l'atelier terminé, cliquez sur End Lab (Terminer l'atelier). Qwiklabs supprime les ressources que vous avez utilisées, puis efface le compte.

Si vous le souhaitez, vous pouvez noter l'atelier. Sélectionnez le nombre d'étoiles correspondant à votre note, saisissez un commentaire, puis cliquez sur Submit (Envoyer).

Le nombre d'étoiles que vous pouvez attribuer à un atelier correspond à votre degré de satisfaction :

- 1 étoile = très mécontent(e)

- 2 étoiles = insatisfait(e)

- 3 étoiles = ni insatisfait(e), ni satisfait(e)

- 4 étoiles = satisfait(e)

- 5 étoiles = très satisfait(e)

Si vous ne souhaitez pas donner votre avis, vous pouvez fermer la boîte de dialogue.

Pour soumettre des commentaires, suggestions ou corrections, veuillez utiliser l'onglet Support (Assistance).

Copyright 2020 Google LLC Tous droits réservés. Google et le logo Google sont des marques de Google LLC. Tous les autres noms d'entreprises et de produits peuvent être des marques des entreprises auxquelles ils sont associés.

, puis cliquez sur Réseau VPC > Pare-feu.

, puis cliquez sur Réseau VPC > Pare-feu. .

.

).

).