Checkpoints

Deploy application

/ 50

Create a Log bucket

/ 25

create the log sink

/ 25

Análise de dados de registros no Google Cloud

GSP1088

Informações gerais

Neste laboratório, você vai conhecer os recursos e ferramentas que o Cloud Logging oferece para gerar insights sobre seus aplicativos.

Neste curso, você vai:

- Aprender a usar o Cloud Logging de forma eficaz e aproveitar os insights sobre os aplicativos em execução no GKE

- Aprender a criar e executar consultas de forma eficaz usando a Análise de dados de registros

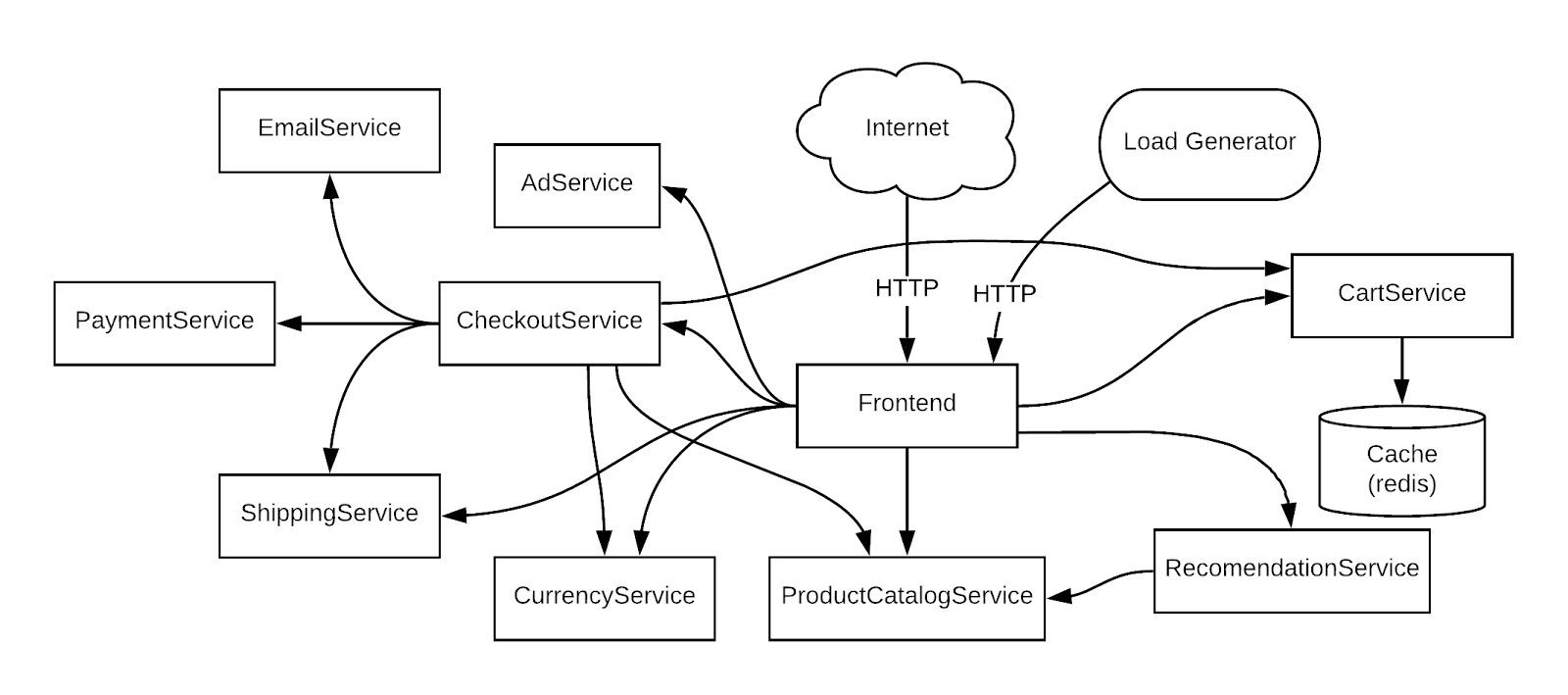

O aplicativo de demonstração usado no laboratório

Para usar um exemplo concreto, vamos simular um cenário com base em um app de exemplo de demonstração de microsserviços implantado em um cluster do GKE. Nesse app, há diversos microsserviços com dependências entre eles.

Configuração e requisitos

Antes de clicar no botão Start Lab

Leia estas instruções. Os laboratórios são cronometrados e não podem ser pausados. O timer é iniciado quando você clica em Começar o laboratório e mostra por quanto tempo os recursos do Google Cloud vão ficar disponíveis.

Este laboratório prático permite que você realize as atividades em um ambiente real de nuvem, não em uma simulação ou demonstração. Você vai receber novas credenciais temporárias para fazer login e acessar o Google Cloud durante o laboratório.

Confira os requisitos para concluir o laboratório:

- Acesso a um navegador de Internet padrão (recomendamos o Chrome).

- Tempo para concluir o laboratório---não se esqueça: depois de começar, não será possível pausar o laboratório.

Como iniciar seu laboratório e fazer login no console do Google Cloud

-

Clique no botão Começar o laboratório. Se for preciso pagar, você verá um pop-up para selecionar a forma de pagamento. No painel Detalhes do laboratório à esquerda, você verá o seguinte:

- O botão Abrir Console do Cloud

- Tempo restante

- As credenciais temporárias que você vai usar neste laboratório

- Outras informações se forem necessárias

-

Clique em Abrir Console do Google. O laboratório ativa recursos e depois abre outra guia com a página Fazer login.

Dica: coloque as guias em janelas separadas lado a lado.

Observação: se aparecer a caixa de diálogo Escolher uma conta, clique em Usar outra conta. -

Caso seja preciso, copie o Nome de usuário no painel Detalhes do laboratório e cole esse nome na caixa de diálogo Fazer login. Clique em Avançar.

-

Copie a Senha no painel Detalhes do laboratório e a cole na caixa de diálogo Olá. Clique em Avançar.

Importante: você precisa usar as credenciais do painel à esquerda. Não use suas credenciais do Google Cloud Ensina. Observação: se você usar sua própria conta do Google Cloud neste laboratório, é possível que receba cobranças adicionais. -

Acesse as próximas páginas:

- Aceite os Termos e Condições.

- Não adicione opções de recuperação nem autenticação de dois fatores (porque essa é uma conta temporária).

- Não se inscreva em testes gratuitos.

Depois de alguns instantes, o console do GCP vai ser aberto nesta guia.

Ativar o Cloud Shell

O Cloud Shell é uma máquina virtual com várias ferramentas de desenvolvimento. Ele tem um diretório principal permanente de 5 GB e é executado no Google Cloud. O Cloud Shell oferece acesso de linha de comando aos recursos do Google Cloud.

- Clique em Ativar o Cloud Shell

na parte de cima do console do Google Cloud.

Depois de se conectar, vai notar que sua conta já está autenticada, e que o projeto está configurado com seu PROJECT_ID. A saída contém uma linha que declara o projeto PROJECT_ID para esta sessão:

gcloud é a ferramenta de linha de comando do Google Cloud. Ela vem pré-instalada no Cloud Shell e aceita preenchimento com tabulação.

- (Opcional) É possível listar o nome da conta ativa usando este comando:

-

Clique em Autorizar.

-

A saída será parecida com esta:

Saída:

- (Opcional) É possível listar o ID do projeto usando este comando:

Saída:

Exemplo de saída:

gcloud, acesse o guia com informações gerais sobre a gcloud CLI no Google Cloud.

Tarefa 1: configuração da infraestrutura

Verifique o cluster do GKE

Conecte a um cluster do Google Kubernetes Engine e confirme se ele foi criado corretamente.

No Cloud Shell, defina a zona na gcloud:

- Use o comando abaixo para conferir o status do cluster:

Um status semelhante a este vai aparecer:

O status do cluster será EM EXECUÇÃO. Se ele ainda for EM PROVISIONAMENTO, aguarde um pouco e execute o comando acima outra vez. Repita esse processo até que o status mude para EM EXECUÇÃO.

Também é possível conferir o progresso no console do Cloud, em Menu de navegação > Kubernetes Engine > Clusters.

- Quando o status mudar para EM EXECUÇÃO, consulte as credenciais do cluster:

(Saída)

- Verifique se os nós foram criados:

A saída será parecida com esta:

Tarefa 2: implantar o aplicativo

Em seguida, você vai implantar um aplicativo de microsserviços chamado Online Boutique no seu cluster para criar um fluxo de trabalho que pode ser monitorado.

- Execute o seguinte comando para clonar o repositório:

- Mude para o diretório

microservices-demo:

- Instale o app usando

kubectl:

- Verifique se tudo está funcionando corretamente:

A saída será parecida com o exemplo a seguir. Antes de prosseguir para a próxima etapa, execute o comando até que todos os pods estejam com o status "Em execução".

- Execute o código a seguir para exibir o IP externo do aplicativo. Um endereço IP só é retornado quando o serviço é implantado. Logo, pode ser necessário repetir os comandos até que um endereço IP externo seja atribuído:

(Exemplo de saída)

- Por fim, verifique se o app está em execução:

A confirmação será parecida com esta:

Depois que o aplicativo for implantado, acesse o console do Cloud e confira o status.

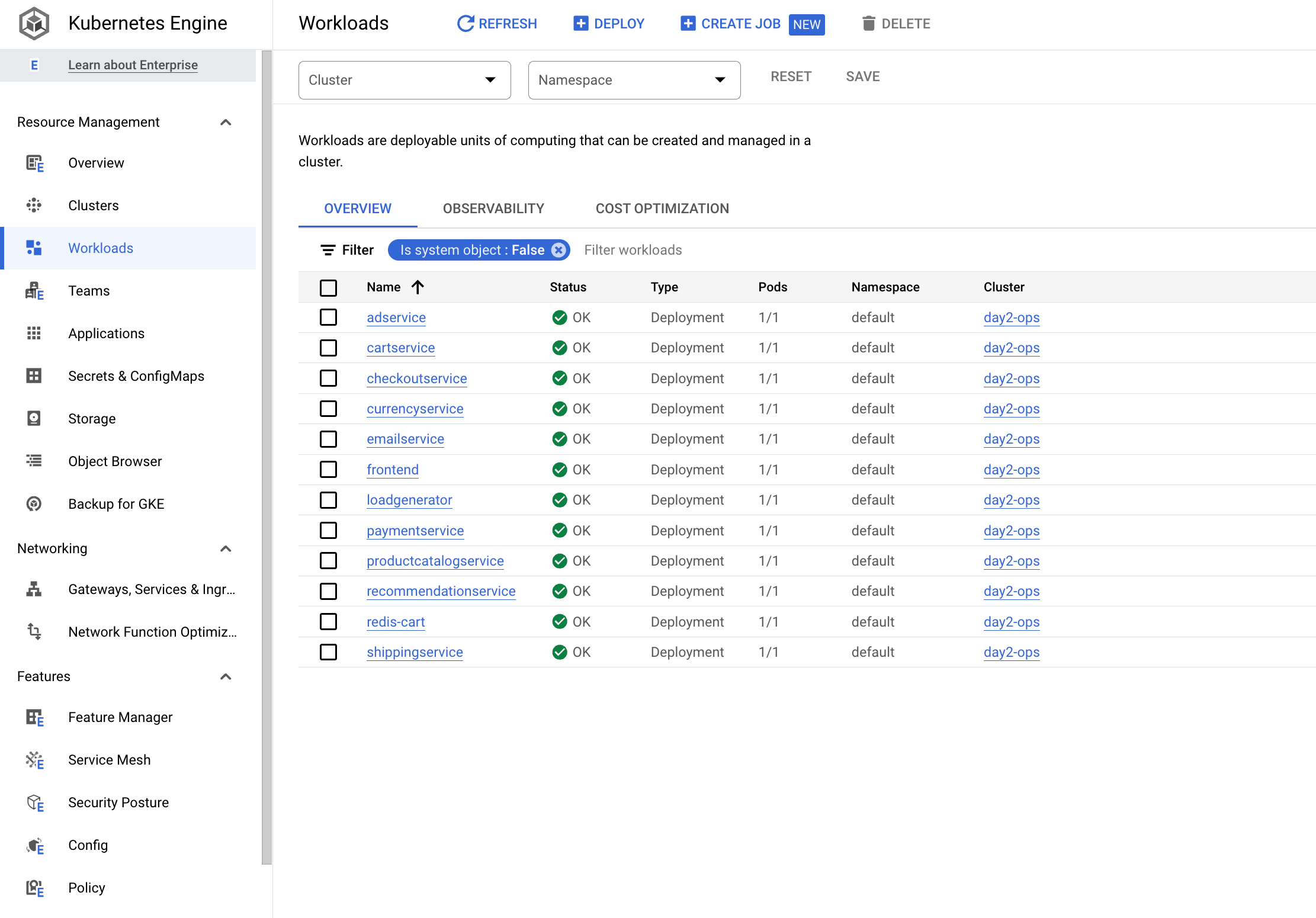

- Na página Kubernetes Engine > Cargas de trabalho, todos os pods vão aparecer corretamente.

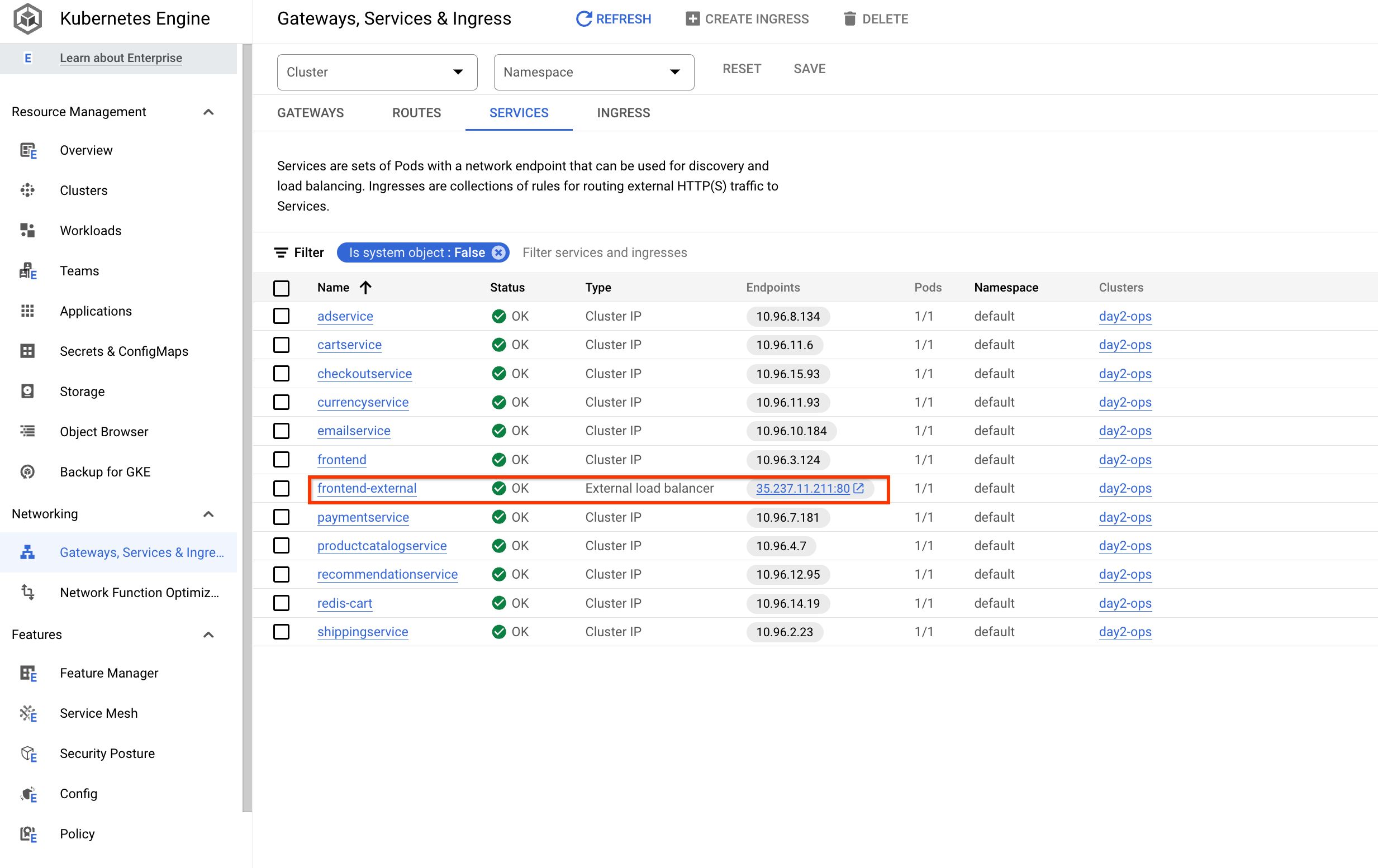

- Agora clique em Serviços e entrada e verifique se todos os serviços estão OK.

Abra o aplicativo

Em Serviço e entrada, clique no IP do Endpoint do serviço frontend-external:

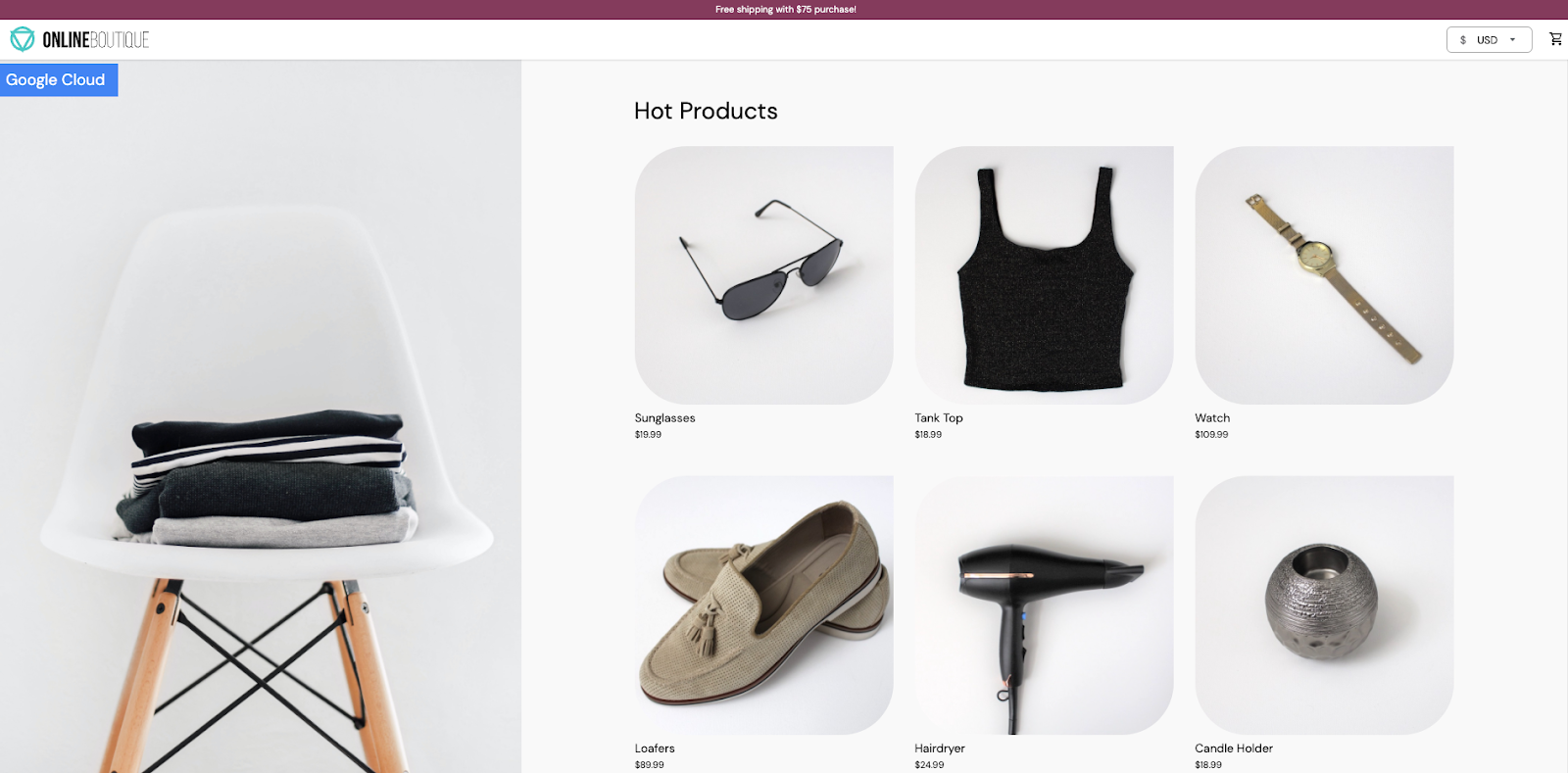

Isso vai abrir o aplicativo e exibir uma página como esta:

Selecione Verificar meu progresso para conferir o objetivo.

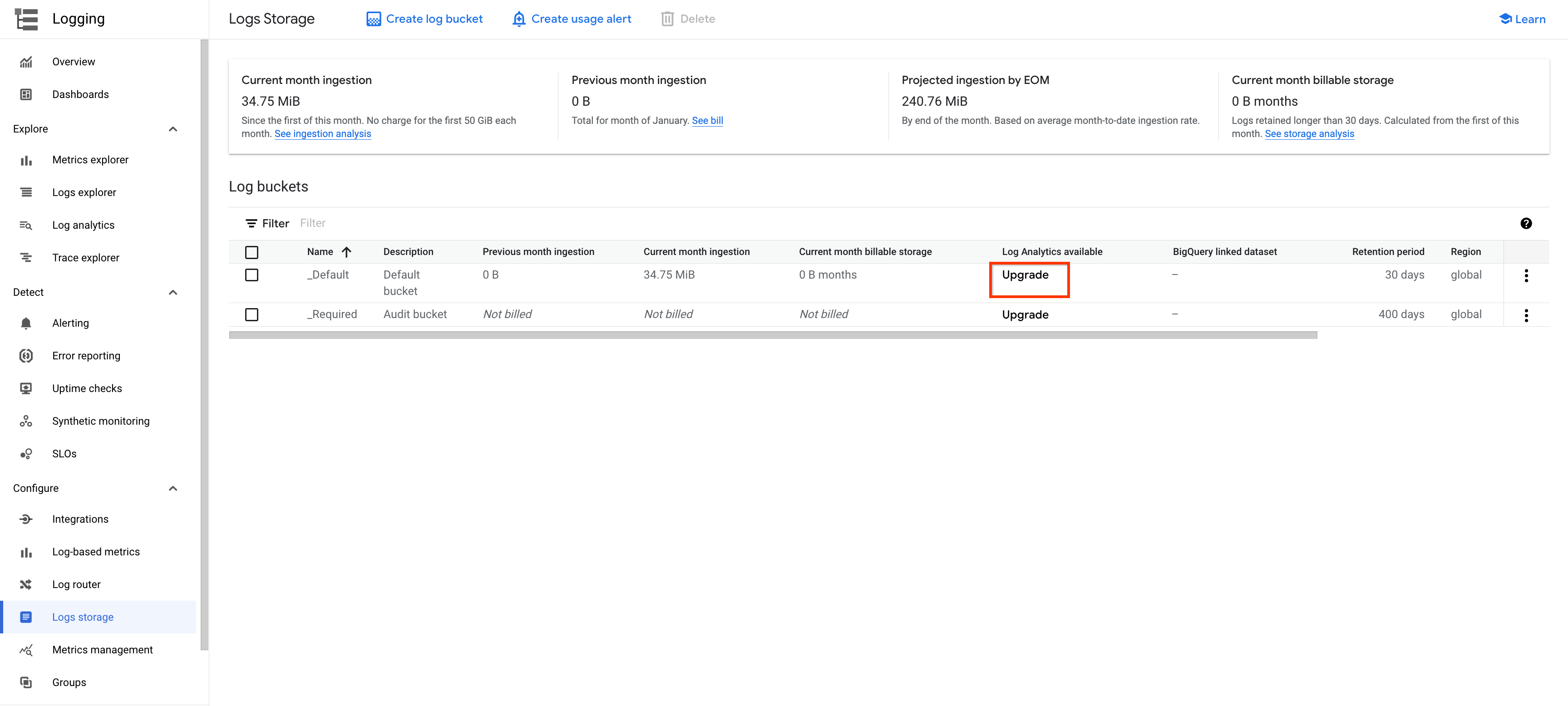

Tarefa 4: gerenciar bucket de registros

Há duas formas de ativar a Análise de dados de registros. Uma delas é fazer o upgrade de um bucket que já foi criado, e a outra é criar um novo bucket de registros com a Análise de dados de registros ativada.

Faça o upgrade de um bucket

As etapas a seguir podem ser usadas para fazer o upgrade de um bucket de registros que já foi criado.

-

No menu à esquerda, clique em Logging e depois em Armazenamento de registros.

-

Clique em FAZER UPGRADE de um bucket atual, por exemplo,

_Default.

-

Clique em FAZER UPGRADE na janela pop-up.

-

Aguarde a conclusão do upgrade. Inicialmente, o status vai mudar para Inelegível para upgrade e depois vai mudar para Com upgrade.

-

Clique no botão ABRIR do menu suspenso.

-

Clique na visualização

_AllLogspara abrir a página de Análise de dados de registros.

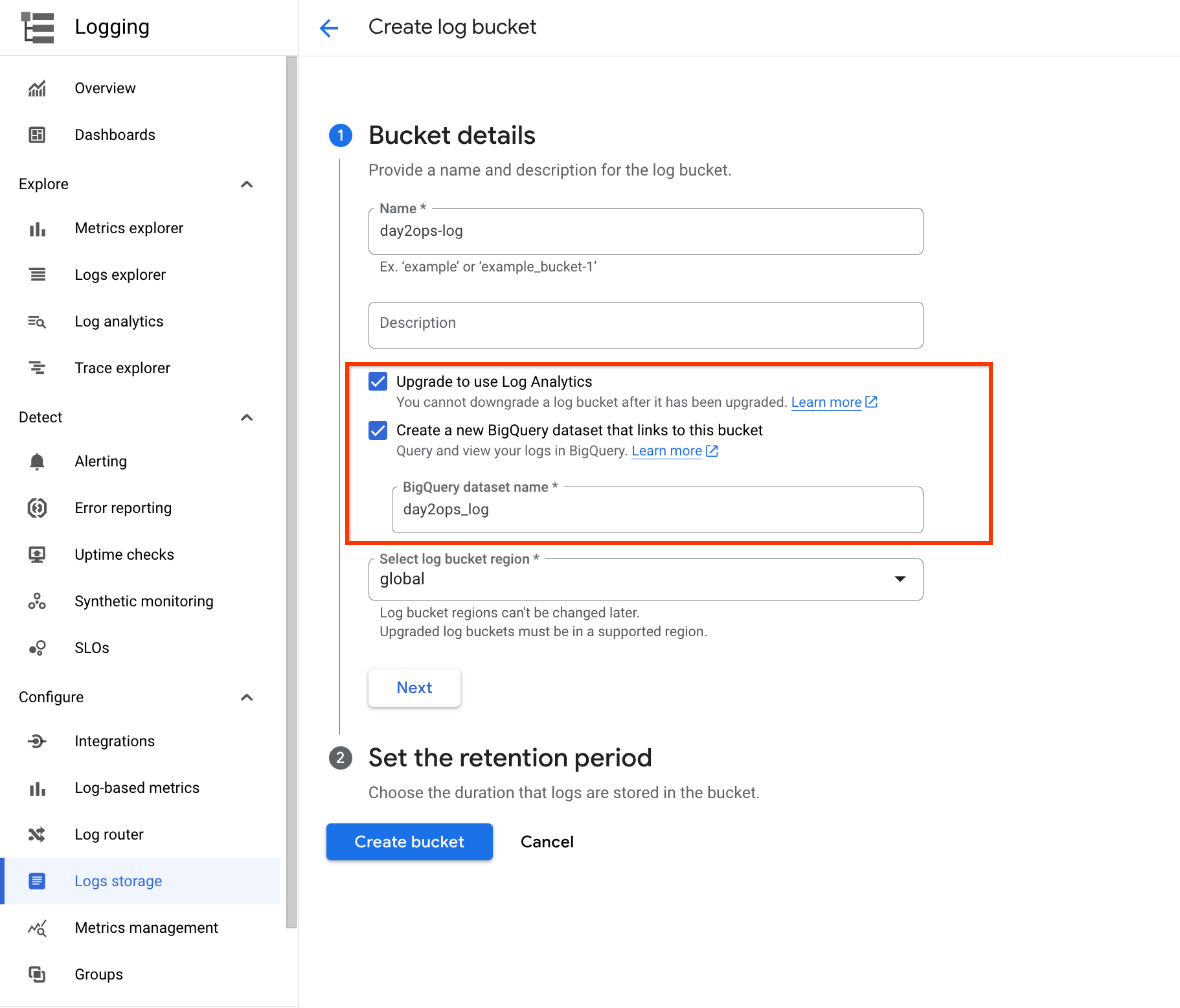

Crie um novo bucket de registros

Alternativamente, é possível configurar o Cloud Logging para criar um novo bucket de registros com a Análise de dados de registros ativada.

-

No menu à esquerda, clique em Logging e depois em Armazenamento de registros.

-

Clique em CRIAR BUCKET DE REGISTROS na parte de cima.

-

Dê um nome ao bucket, como day2ops-log.

-

Marque Fazer upgrade para usar a Análise de dados de registros e Criar um conjunto de dados vinculado no BigQuery.

-

Digite um nome para o conjunto de dados, como: day2ops_log

Selecionar Criar um conjunto de dados vinculado no BigQuery vai criar um conjunto de dados para você no BigQuery, se nenhum existir. Dessa forma, você pode executar consultas no BigQuery.

- Por fim, clique em Criar bucket para criar o bucket de registros.

Selecione Verificar meu progresso para conferir o objetivo.

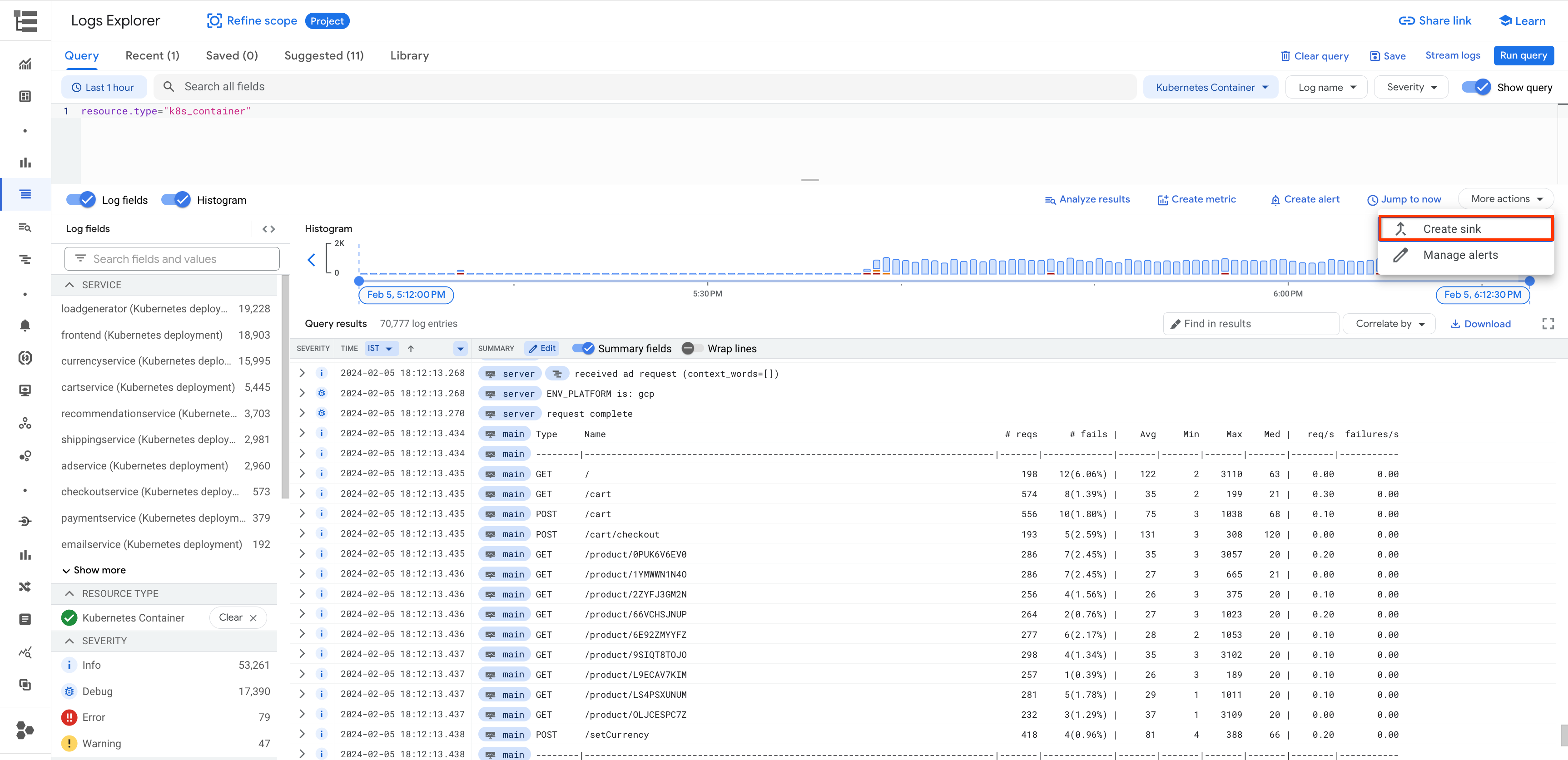

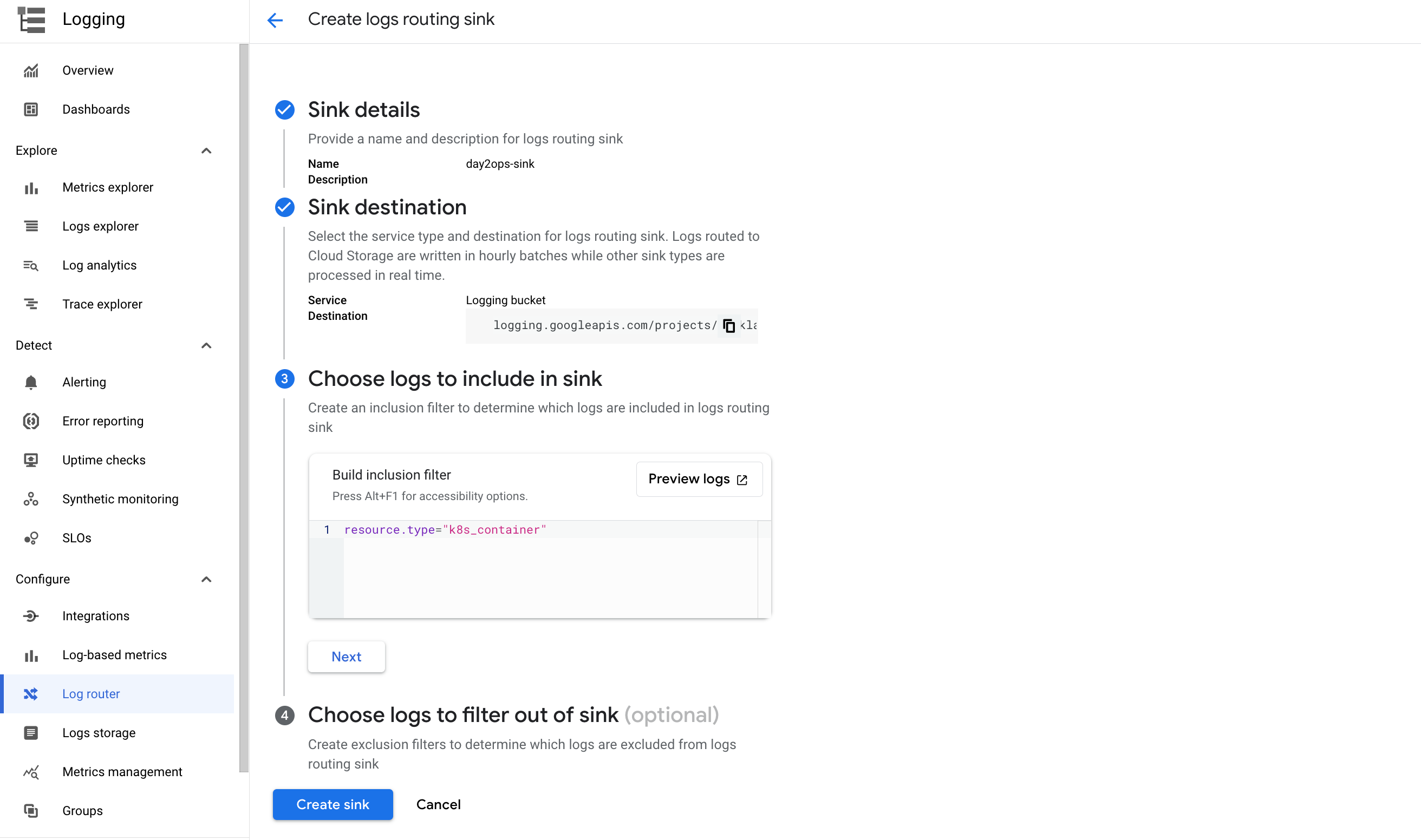

Faça gravações no novo bucket de registros

É possível criar um coletor de registros para usar o novo bucket de registros. Faça isso diretamente pelo Roteador de registros. Outro jeito fácil de fazer isso é pela Análise de registros. É possível executar consultas para selecionar e filtrar os registros que você quiser e criar um coletor em seguida. Uma coisa boa dessa abordagem é que a consulta de registros é automaticamente copiada como o filtro para a configuração do coletor.

- No canto superior direito da Análise de registros, ative a opção Exibir consulta e execute a seguinte consulta no campo de consulta:

- Clique em Criar coletor.

-

Dê um nome ao coletor, como day2ops-sink.

-

Clique em PRÓXIMA.

-

Selecione bucket do Cloud Logging na lista suspensa do serviço de coletor.

-

Selecione o novo bucket de registros que você acabou de criar.

-

Clique em PRÓXIMA.

A consulta do tipo de recurso já estará visível no filtro.

- Clique em CRIAR COLETOR.

Espere um pouco até o seu coletor ser criado.

Selecione Verificar meu progresso para conferir o objetivo.

Faça leituras do novo bucket de registros

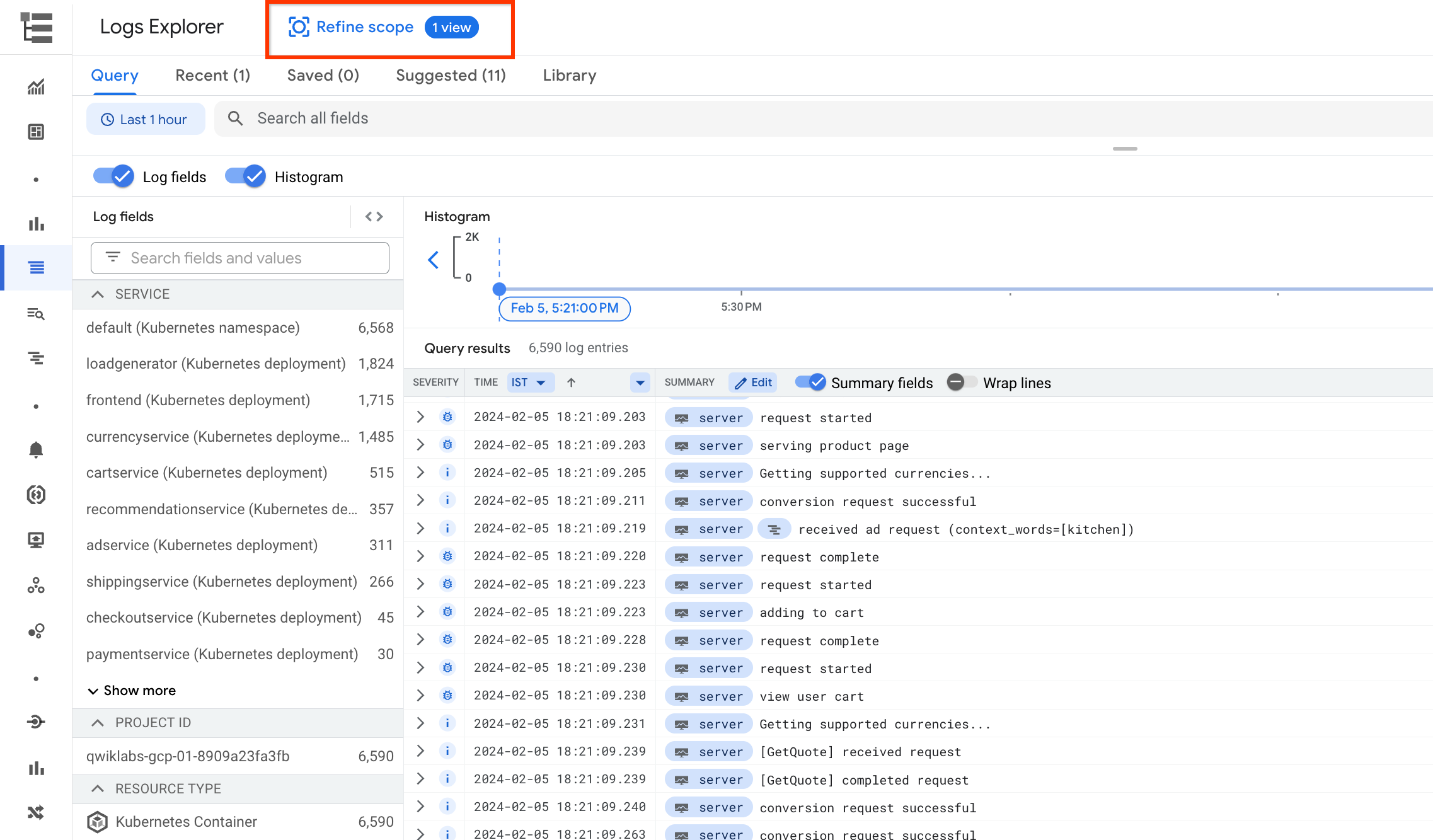

Volte para a Análise de registros. Há diversos tipos de recurso diferentes para os registros, como destacado na captura de tela a seguir.

-

Para conferir os registros no novo bucket de registros, clique em REFINAR ESCOPO na parte de cima da página.

-

Selecione Escopo por armazenamento e o novo bucket de registros que você criou.

-

Clique em APLICAR.

Você vai perceber que contêineres Kubernetes são o único tipo de recurso restante e que há bem menos entradas de registro agora. Isso ocorre porque apenas os registros filtrados serão enviados para o bucket.

Tarefa 5: análise de registros

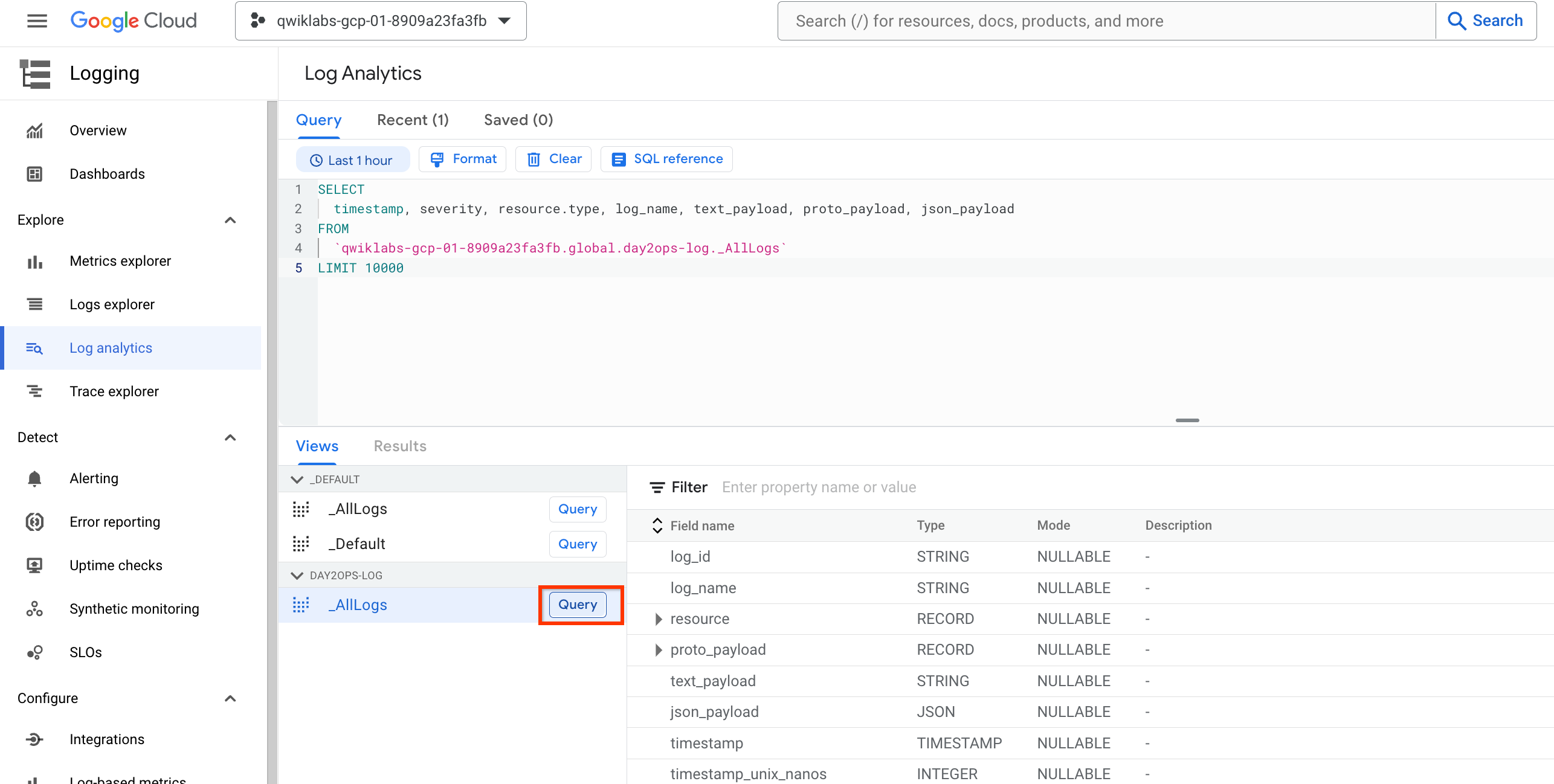

- No lado esquerdo, em Logging, clique em Análise de dados de registros para acessar o recurso. Será exibido um resultado parecido com este:

Se o campo da consulta ficar em branco ou se você esquecer a tabela que quer usar, clique no botão Consulta para retomar a consulta de amostra.

Agora é possível executar suas próprias consultas no campo de consulta. Confira alguns exemplos a seguir.

Importante: o nome da visualização de registro na cláusula FROM é diferente para os buckets de registros. É necessário confirmar se o nome de visualização correto está sendo usado. A etapa anterior pode ser usada para verificação.

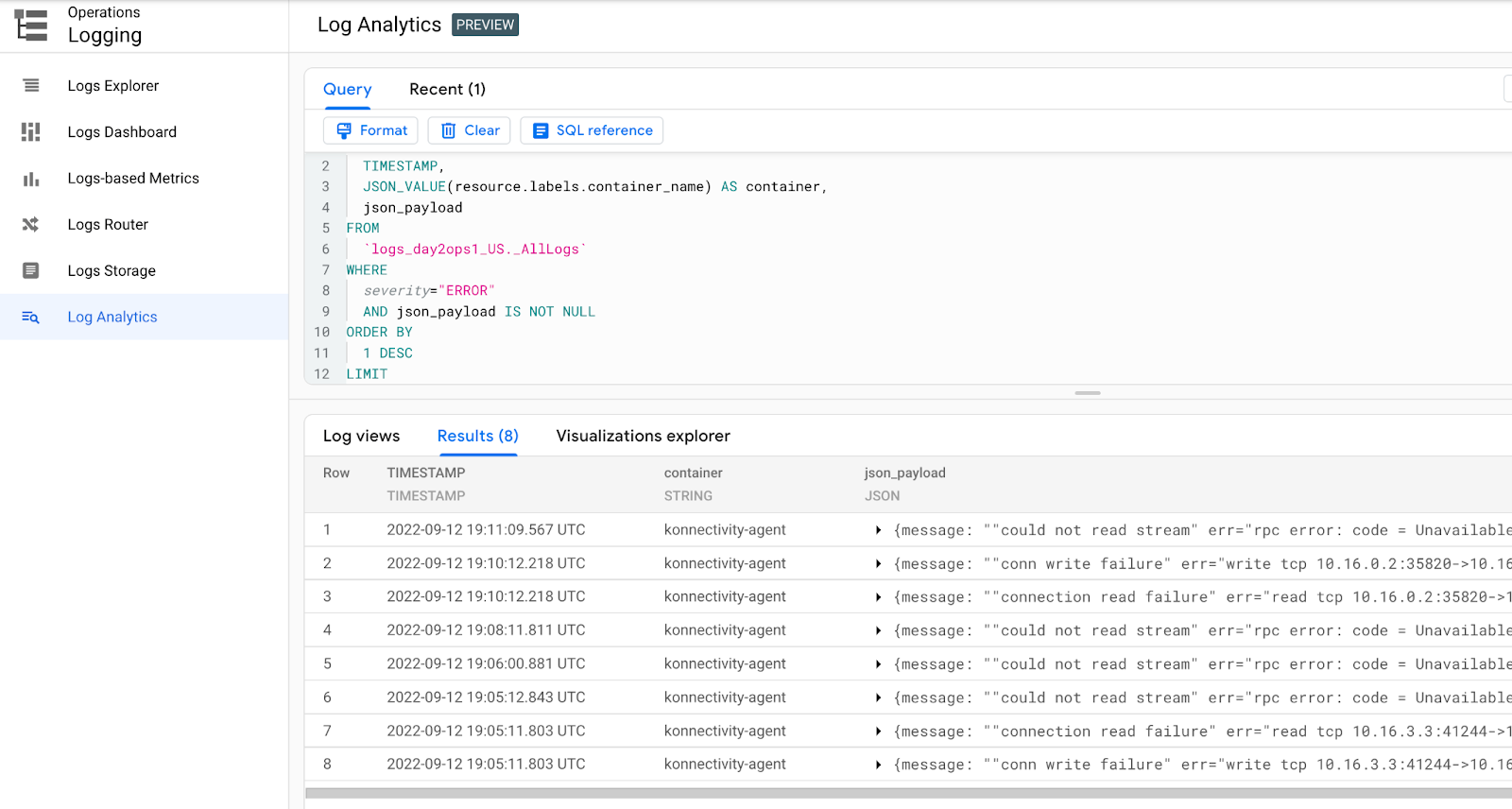

Para encontrar os erros mais recentes:

Encontre os erros mais recentes dos contêineres:

Depois de executar a consulta, será exibida uma saída semelhante a:

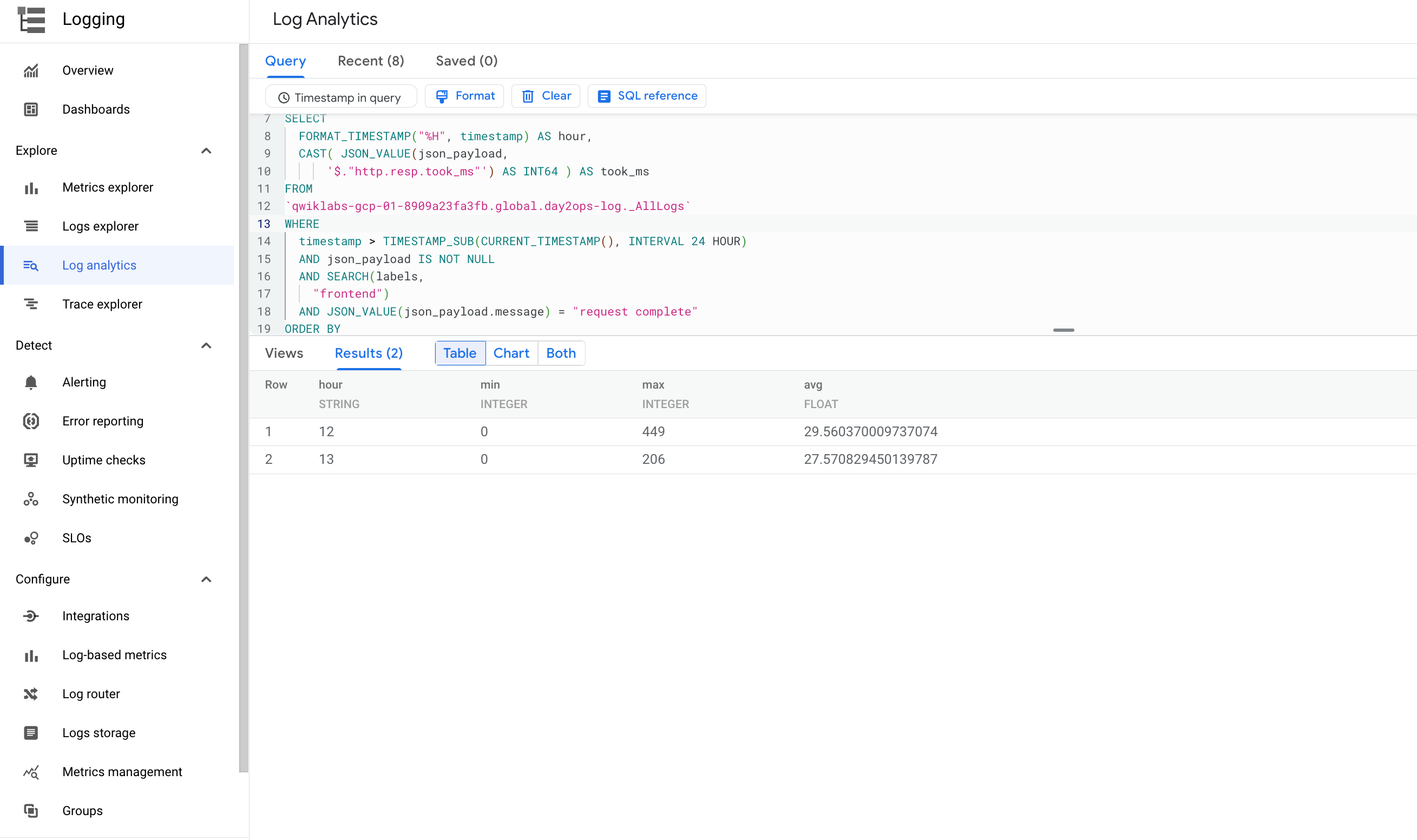

Para descobrir as latências mínima, máxima e média:

É possível consultar as latências mínima, máxima e média em um prazo para o serviço de front-end:

Depois de executar a consulta, será exibida uma saída semelhante a:

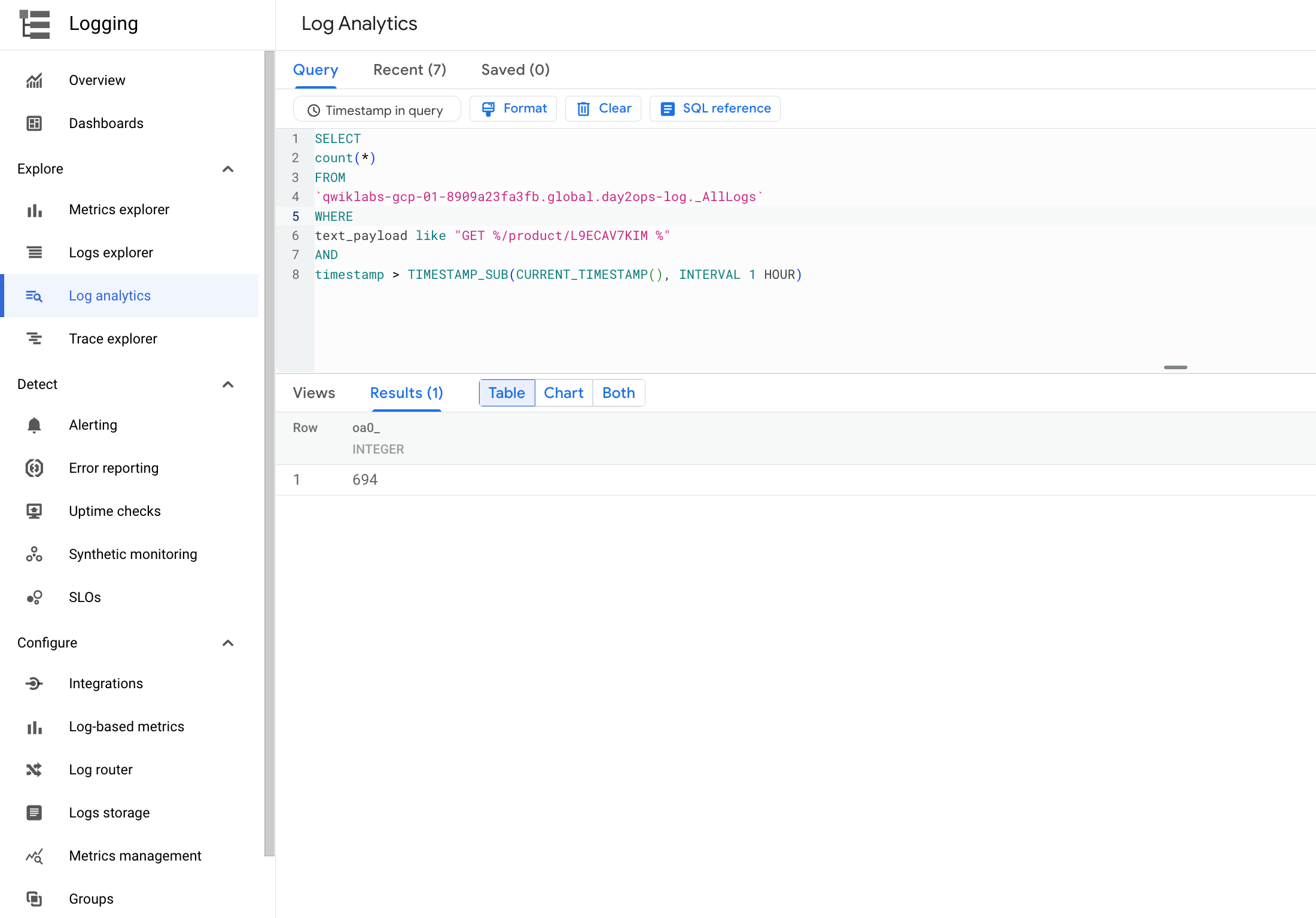

Número da visita à página do produto

Você quer saber quantas vezes os usuários acessaram uma determinada página de produto na última hora:

Depois de executar a consulta, será exibida uma saída semelhante a:

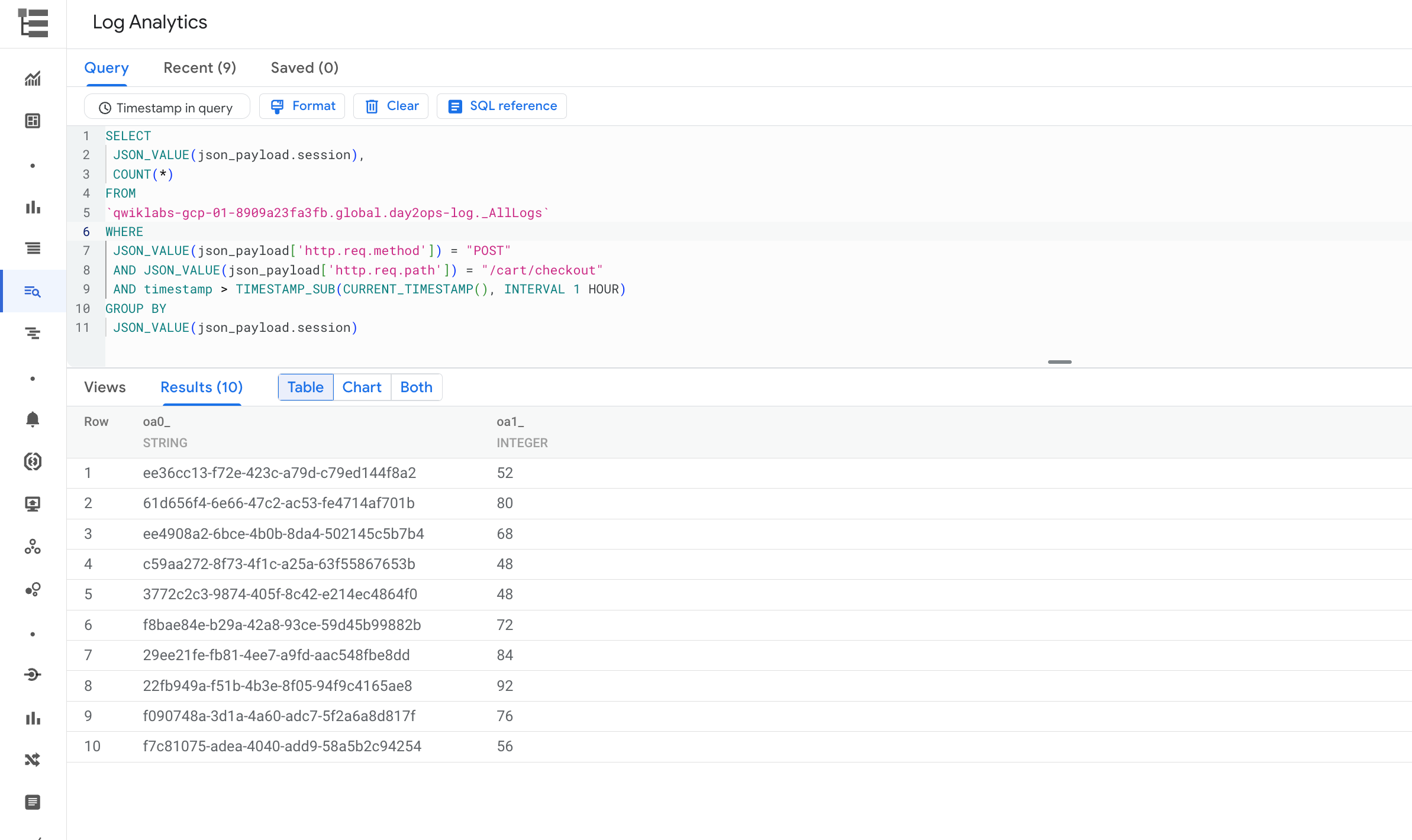

Sessões com pagamento de carrinho de compras

Execute a consulta abaixo para conferir quantas sessões terminam em finalização de compra (chamada POST para o serviço de finalização/carrinho de compra):

Depois de executar a consulta, será exibida uma saída semelhante a:

Parabéns!

Agora você tem experiência no uso do Cloud Logging para receber insights sobre os aplicativos em execução no GKE, além de criar e executar consultas usando a Análise de dados de registros.

Treinamento e certificação do Google Cloud

Esses treinamentos ajudam você a aproveitar as tecnologias do Google Cloud ao máximo. Nossas aulas incluem habilidades técnicas e práticas recomendadas para ajudar você a alcançar rapidamente o nível esperado e continuar sua jornada de aprendizado. Oferecemos treinamentos que vão do nível básico ao avançado, com opções de aulas virtuais, sob demanda e por meio de transmissões ao vivo para que você possa encaixá-las na correria do seu dia a dia. As certificações validam sua experiência e comprovam suas habilidades com as tecnologias do Google Cloud.

Manual atualizado em 26 de setembro de 2022

Laboratório testado em 26 de setembro de 2022

Copyright 2024 Google LLC. Todos os direitos reservados. Google e o logotipo do Google são marcas registradas da Google LLC. Todos os outros nomes de produtos e empresas podem ser marcas registradas das respectivas empresas a que estão associados.