Points de contrôle

Create the vertex AI notebook instance

/ 20

Download the challenge Notebook

/ 20

Import dataset

/ 20

Build and train model

/ 10

Create artifact registry for custom container images

/ 20

Define a pipeline using the KFP SDK

/ 10

Build and Deploy Machine Learning Solutions with Vertex AI : atelier challenge

- GSP354

- Présentation

- Prérequis

- Scénario du challenge

- Tâche 1 : Créer une instance de notebook Vertex

- Tâche 2 : Télécharger le notebook du challenge

- Tâche 3 : Créer et entraîner un modèle en local dans un notebook Vertex

- Tâche 4 : Créer un conteneur pour votre modèle et le transférer vers Google Cloud Artifact Registry avec Cloud Build

- Tâche 5 : Définir un pipeline à l'aide du SDK KFP

- Tâche 6 : Interroger le modèle déployé sur un point de terminaison Vertex pour obtenir des prédictions en ligne

- Félicitations !

GSP354

Présentation

Dans un atelier challenge, vous devez suivre un scénario et effectuer une série de tâches. Aucune instruction détaillée n'est fournie : vous devez utiliser les compétences acquises au cours des ateliers de la quête correspondante pour déterminer comment procéder par vous-même. Vous saurez si vous avez exécuté correctement les différentes tâches grâce au score calculé automatiquement (affiché sur cette page).

Lorsque vous participez à un atelier challenge, vous n'étudiez pas de nouveaux concepts Google Cloud. Vous allez approfondir les compétences précédemment acquises. Par exemple, vous devrez modifier les valeurs par défaut ou encore examiner des messages d'erreur pour corriger vous-même les problèmes.

Pour atteindre le score de 100 %, vous devez mener à bien l'ensemble des tâches dans le délai imparti.

Cet atelier est recommandé aux participants inscrits à la quête Building Machine Learning Solutions with Vertex AI. Êtes-vous prêt pour le challenge ?

Prérequis

Avant de cliquer sur le bouton "Démarrer l'atelier"

Lisez ces instructions. Les ateliers sont minutés, et vous ne pouvez pas les mettre en pause. Le minuteur, qui démarre lorsque vous cliquez sur Démarrer l'atelier, indique combien de temps les ressources Google Cloud resteront accessibles.

Cet atelier pratique vous permet de suivre vous-même les activités dans un véritable environnement cloud, et non dans un environnement de simulation ou de démonstration. Nous vous fournissons des identifiants temporaires pour vous connecter à Google Cloud le temps de l'atelier.

Pour réaliser cet atelier :

- vous devez avoir accès à un navigateur Internet standard (nous vous recommandons d'utiliser Chrome) ;

- vous disposez d'un temps limité ; une fois l'atelier commencé, vous ne pouvez pas le mettre en pause.

Scénario du challenge

Une start-up spécialisée dans les critiques de films vous a récemment embauché comme ingénieur en machine learning pour son site Web. Votre responsable vous a demandé de créer un modèle de machine learning pour classer les critiques des spectateurs comme positives ou négatives. Les systèmes de notation des films en aval utiliseront ces prédictions comme données d'entrée pour afficher la critique la plus favorable et celle la plus défavorable sur l'application de la start-up. Votre défi consiste à faire passer en production en six semaines seulement un modèle avec un taux de précision supérieur à 75 %, pour améliorer une solution déjà lancée. Par ailleurs, après avoir examiné l'entrepôt de données de la start-up, vous avez constaté que vous ne disposiez que d'un petit ensemble de données de 50 000 critiques écrites pour créer une solution plus performante.

Votre challenge

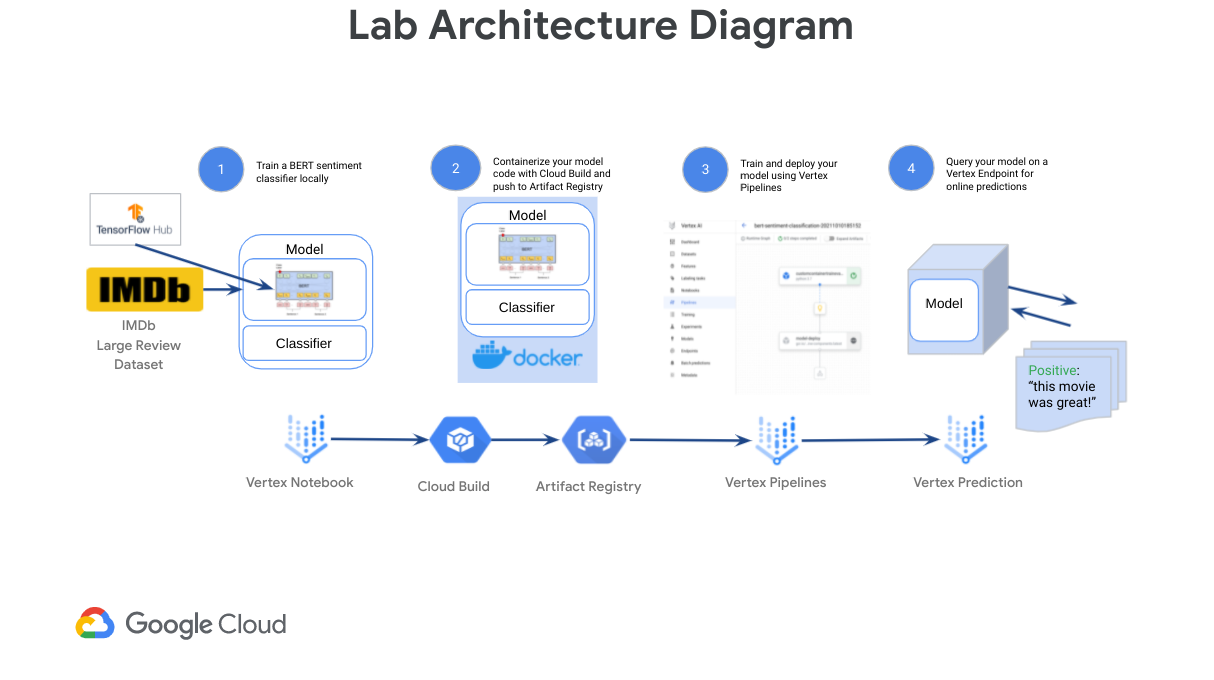

Pour créer et déployer rapidement un modèle de machine learning hautes performances avec une quantité limitée de données, vous allez apprendre à entraîner et à déployer un classificateur de sentiments personnalisé TensorFlow BERT sur Vertex AI pour générer des prédictions en ligne. Vertex AI est la plate-forme de développement de machine learning nouvelle génération de Google Cloud. Elle vous permet d'exploiter les derniers composants de ML prédéfinis ainsi qu'AutoML pour améliorer de façon significative votre productivité lors du développement, faire évoluer votre workflow et les prises de décision basées sur vos données, mais aussi accélérer le retour sur investissement.

Tout d'abord, vous allez suivre un workflow d'expérimentation typique pour créer votre modèle à partir de composants BERT préentraînés provenant de TF-Hub et de couches de classification tf.keras, avant de l'entraîner et de l'évaluer dans un notebook Vertex. Ensuite, vous allez empaqueter le code de votre modèle dans un conteneur Docker pour l'entraîner sur Google Cloud Vertex AI. Enfin, vous allez définir et exécuter sur Vertex Pipelines un pipeline Kubeflow qui va entraîner et déployer votre modèle sur un point de terminaison Vertex pour que vous puissiez l'interroger et ainsi obtenir des prédictions en ligne.

Tâche 1 : Créer une instance de notebook Vertex

-

Accédez à Vertex AI > Workbench > Instances.

-

Étant donné qu'il s'agit d'un nouveau projet, aucune instance ne devrait apparaître. Cliquez sur le bouton Créer au milieu de l'écran. Sélectionnez les options suivantes :

-

Nom :

vertex-ai-challenge -

Région :

- Zone : conservez la valeur par défaut

-

Sous

Type de workbench, sélectionnez Instance, puis cliquez sur Continuer. -

Sélectionnez Utiliser une version antérieure. Dans le menu déroulant Version, sélectionnez

workbench-instances-v20230717-debian-11-py310 (M109). Cliquez sur Continuer. -

Sélectionnez e2-standard-4 comme type de machine. Cliquez sur Créer.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Tâche 2 : Télécharger le notebook du challenge

-

Dans votre notebook, cliquez sur le terminal.

-

Clonez le dépôt :

- Installez les packages requis pour l'atelier :

Cliquez sur Vérifier ma progression pour valider l'objectif.

-

Accédez au dossier suivant :

training-data-analyst/quests/vertex-ai/vertex-challenge-lab. -

Ouvrez le fichier notebook

vertex-challenge-lab.ipynb. Lorsque vous êtes invité à choisir un kernel, sélectionnezTensorFlow 2-11. -

Dans la section Configuration, définissez vos variables

PROJECT_ID(ID DE PROJET),GCS_BUCKET(BUCKET GCS) etUSER(UTILISATEUR).

Nous vous avons fourni le code REST pour importer et prétraiter l'ensemble de données. Les étapes restantes figurent dans le fichier notebook. Reportez-vous à ce guide pour vérifier votre progression et obtenir quelques astuces.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Tâche 3 : Créer et entraîner un modèle en local dans un notebook Vertex

Dans cette section, vous allez entraîner votre modèle en local à l'aide de TensorFlow.

Créer et compiler un classificateur de sentiments TensorFlow BERT

-

Remplissez la section

#TODOpour ajouter une couchehub.KerasLayervous permettant de prétraiter le texte avec BERT. -

Remplissez la section

#TODOpour ajouter une couchehub.KerasLayervous permettant d'encoder le texte avec BERT. -

Remplissez la section

#TODOpour enregistrer votre classificateur de sentiments BERT en local, de préférence dans le répertoire./bert-sentiment-classifier-local.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Tâche 4 : Créer un conteneur pour votre modèle et le transférer vers Google Cloud Artifact Registry avec Cloud Build

Créer un dépôt Artifact Registry pour les images de conteneurs personnalisés

- Remplissez la section

#TODOpour créer un dépôt Docker Artifact Registry à l'aide de la gcloud CLI. Pour en savoir plus, consultez la documentation gcloud artifacts repositories create.

location, repository-format et description. Créer votre image de conteneur et la transférer vers Artifact Registry avec Cloud Build

- Remplissez la section

#TODOpour créer votre conteneur de modèle personnalisé et le transférer vers Artifact Registry à l'aide de Cloud Build. Pour en savoir plus, consultez la documentation gcloud builds submit.

{MODEL_DIR}/cloudbuild.yaml (défini ci-dessus) et que vous avez inclus le répertoire de votre modèle. Cliquez sur Vérifier ma progression pour valider l'objectif.

Tâche 5 : Définir un pipeline à l'aide du SDK KFP

- Remplissez la section

#TODOpour ajouter et configurer le composantCustomContainerTrainingJobOpdéfini dans la cellule ci-dessus.

CustomContainerTrainingJob défini plus tôt. Cliquez sur Vérifier ma progression pour valider l'objectif.

Tâche 6 : Interroger le modèle déployé sur un point de terminaison Vertex pour obtenir des prédictions en ligne

- Remplissez la section

#TODOpour générer des prédictions en ligne à l'aide de votre point de terminaison Vertex.

Félicitations !

Félicitations ! Dans cet atelier, vous avez découvert comment créer et déployer un classificateur de sentiments BERT personnalisé avec Vertex AI. Vous avez également appris à utiliser Cloud Build pour créer votre conteneur de modèle personnalisé et le transférer vers Artifact Registry, ainsi qu'à définir un pipeline à l'aide du SDK KFP. Vous pouvez maintenant créer et déployer vos propres modèles personnalisés avec Vertex AI.

Gagnez un badge de compétence

Cet atelier d'auto-formation fait partie de la quête Building Machine Learning Solutions with Vertex AI. Si vous terminez cette quête, vous obtiendrez le badge de compétence ci-dessus attestant de votre réussite. Ajoutez votre badge à votre CV et partagez-le sur les réseaux sociaux en utilisant le hashtag #GoogleCloudBadge.

Cette quête, qui ouvre droit à un badge de compétence, fait partie du parcours de formation Data Scientist/Machine Learning Engineer de Google Cloud. Si vous avez déjà complété les autres quêtes de ce parcours de formation, parcourez le catalogue pour découvrir plus de vingt autres quêtes auxquelles vous pouvez vous inscrire pour gagner un badge de compétence.

Formations et certifications Google Cloud

Les formations et certifications Google Cloud vous aident à tirer pleinement parti des technologies Google Cloud. Nos cours portent sur les compétences techniques et les bonnes pratiques à suivre pour être rapidement opérationnel et poursuivre votre apprentissage. Nous proposons des formations pour tous les niveaux, à la demande, en salle et à distance, pour nous adapter aux emplois du temps de chacun. Les certifications vous permettent de valider et de démontrer vos compétences et votre expérience en matière de technologies Google Cloud.

Dernière mise à jour du manuel : 11 novembre 2023

Dernier test de l'atelier : 31 octobre 2023

Copyright 2024 Google LLC Tous droits réservés. Google et le logo Google sont des marques de Google LLC. Tous les autres noms d'entreprises et de produits peuvent être des marques des entreprises auxquelles ils sont associés.