GSP944

Présentation

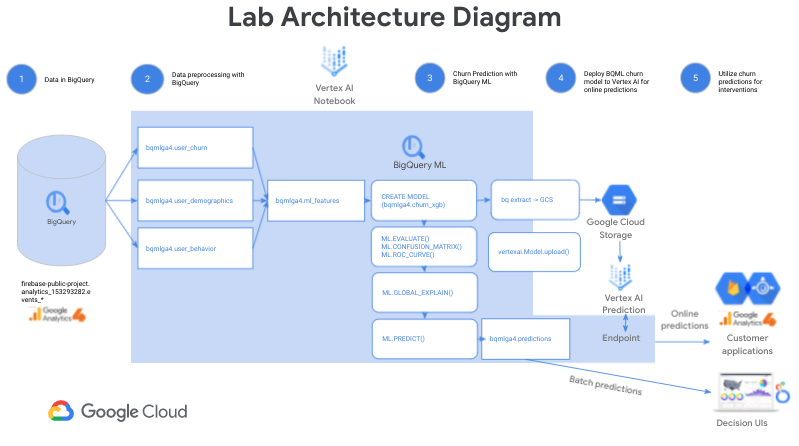

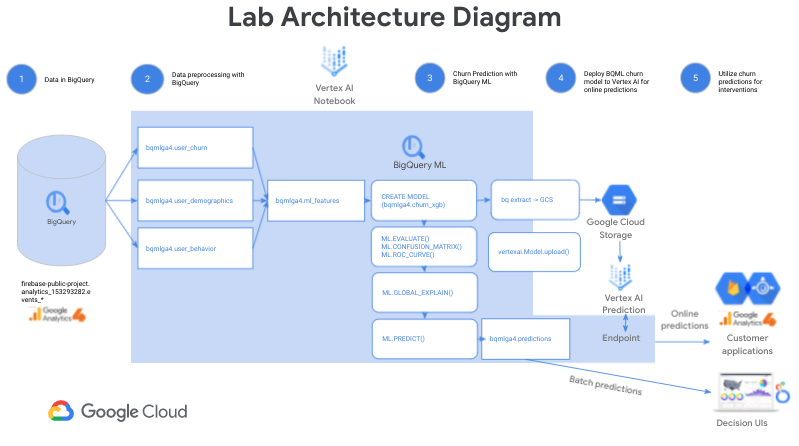

Dans cet atelier, vous allez entraîner, régler, évaluer, expliquer et générer des prédictions par lot et en ligne avec un modèle BigQuery ML XGBoost. Vous allez vous servir de l'ensemble de données Google Analytics 4 de Flood-It!, une vraie application mobile (disponible sur Android et iOS), pour déterminer la probabilité que ses utilisateurs y reviennent. Vous allez générer des prédictions par lot à l'aide de votre modèle BigQuery ML avant de l'exporter vers Vertex AI et de le déployer afin d'obtenir des prédictions en ligne avec le SDK Vertex AI pour Python.

BigQuery ML vous permet d'entraîner des modèles de machine learning et d'exécuter des inférences par lot dans BigQuery plus rapidement à l'aide de requêtes SQL standards comportant moins de lignes de code, sans avoir à déplacer les données.

Vertex AI est la plate-forme nouvelle génération unifiée et sans frais de Google Cloud pour le développement du machine learning. En développant et en déployant des solutions de machine learning BigQuery ML sur Vertex AI, vous pourrez exploiter un service de prédictions en ligne évolutif ainsi que des outils MLOps pour réentraîner et surveiller vos modèles. Ainsi, vous améliorerez grandement votre productivité lors du développement (soit votre capacité à faire évoluer votre workflow et votre prise de décision à l'aide de vos données), ce qui vous permettra d'accélérer le retour sur investissement.

Remarque : BQML est désormais BigQuery ML.

Remarque : BQML est désormais BigQuery ML.

Cet atelier est inspiré de l'article de blog Churn prediction for game developers using Google Analytics 4 (GA4) and BigQuery ML (Prédiction de la perte d'utilisateurs pour les développeurs de jeux vidéo à l'aide de Google Analytics 4 [GA4] et de BigQuery ML) et le complète. Lisez-le ainsi que le tutoriel associé pour en savoir plus sur ce cas d'utilisation et sur BigQuery ML.

Dans cet atelier, vous allez franchir une étape supplémentaire. En effet, vous allez découvrir en quoi Vertex AI complète les fonctionnalités de BigQuery ML grâce aux prédictions en ligne. Ainsi, vous allez pouvoir intégrer les prédictions de perte de clients dans des interfaces utilisateur facilitant la prise de décision, telles que les tableaux de bord Looker, mais aussi incorporer des prédictions en ligne directement dans des applications de clients pour permettre des interventions ciblées telles que l'affichage de programmes d'incitations.

Objectifs

Dans cet atelier, vous allez apprendre à effectuer les tâches suivantes :

Préparation

Avant de cliquer sur le bouton "Démarrer l'atelier"

Lisez ces instructions. Les ateliers sont minutés, et vous ne pouvez pas les mettre en pause. Le minuteur, qui démarre lorsque vous cliquez sur Démarrer l'atelier, indique combien de temps les ressources Google Cloud resteront accessibles.

Cet atelier pratique vous permet de suivre les activités dans un véritable environnement cloud, et non dans un environnement de simulation ou de démonstration. Des identifiants temporaires vous sont fournis pour vous permettre de vous connecter à Google Cloud le temps de l'atelier.

Pour réaliser cet atelier :

- Vous devez avoir accès à un navigateur Internet standard (nous vous recommandons d'utiliser Chrome).

Remarque : Ouvrez une fenêtre de navigateur en mode incognito (recommandé) ou de navigation privée pour effectuer cet atelier. Vous éviterez ainsi les conflits entre votre compte personnel et le compte temporaire de participant, qui pourraient entraîner des frais supplémentaires facturés sur votre compte personnel.

- Vous disposez d'un temps limité. N'oubliez pas qu'une fois l'atelier commencé, vous ne pouvez pas le mettre en pause.

Remarque : Utilisez uniquement le compte de participant pour cet atelier. Si vous utilisez un autre compte Google Cloud, des frais peuvent être facturés à ce compte.

Activer Cloud Shell

Cloud Shell est une machine virtuelle qui contient de nombreux outils pour les développeurs. Elle comprend un répertoire d'accueil persistant de 5 Go et s'exécute sur Google Cloud. Cloud Shell vous permet d'accéder via une ligne de commande à vos ressources Google Cloud.

-

Cliquez sur Activer Cloud Shell  en haut de la console Google Cloud.

en haut de la console Google Cloud.

-

Passez les fenêtres suivantes :

- Accédez à la fenêtre d'informations de Cloud Shell.

- Autorisez Cloud Shell à utiliser vos identifiants pour effectuer des appels d'API Google Cloud.

Une fois connecté, vous êtes en principe authentifié et le projet est défini sur votre ID_PROJET : . Le résultat contient une ligne qui déclare l'ID_PROJET pour cette session :

Your Cloud Platform project in this session is set to {{{project_0.project_id | "PROJECT_ID"}}}

gcloud est l'outil de ligne de commande pour Google Cloud. Il est préinstallé sur Cloud Shell et permet la complétion par tabulation.

- (Facultatif) Vous pouvez lister les noms des comptes actifs à l'aide de cette commande :

gcloud auth list

- Cliquez sur Autoriser.

Résultat :

ACTIVE: *

ACCOUNT: {{{user_0.username | "ACCOUNT"}}}

To set the active account, run:

$ gcloud config set account `ACCOUNT`

- (Facultatif) Vous pouvez lister les ID de projet à l'aide de cette commande :

gcloud config list project

Résultat :

[core]

project = {{{project_0.project_id | "PROJECT_ID"}}}

Remarque : Pour consulter la documentation complète sur gcloud, dans Google Cloud, accédez au guide de présentation de la gcloud CLI.

Tâche 1 : Créer une instance Vertex AI Workbench

-

Dans le menu de navigation ( ) de la console Google Cloud, sélectionnez Vertex AI.

) de la console Google Cloud, sélectionnez Vertex AI.

-

Cliquez sur Activer toutes les API recommandées.

-

Sur la gauche, cliquez sur Workbench.

-

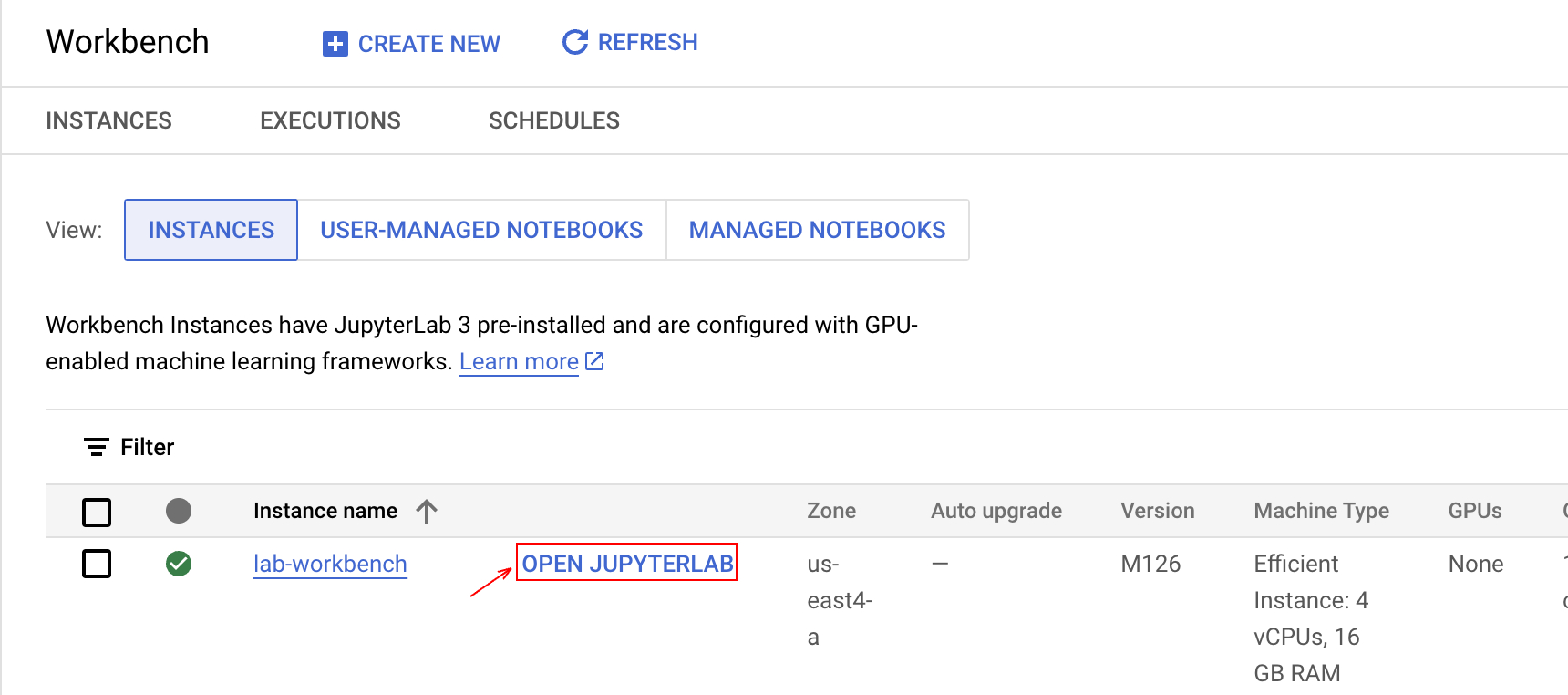

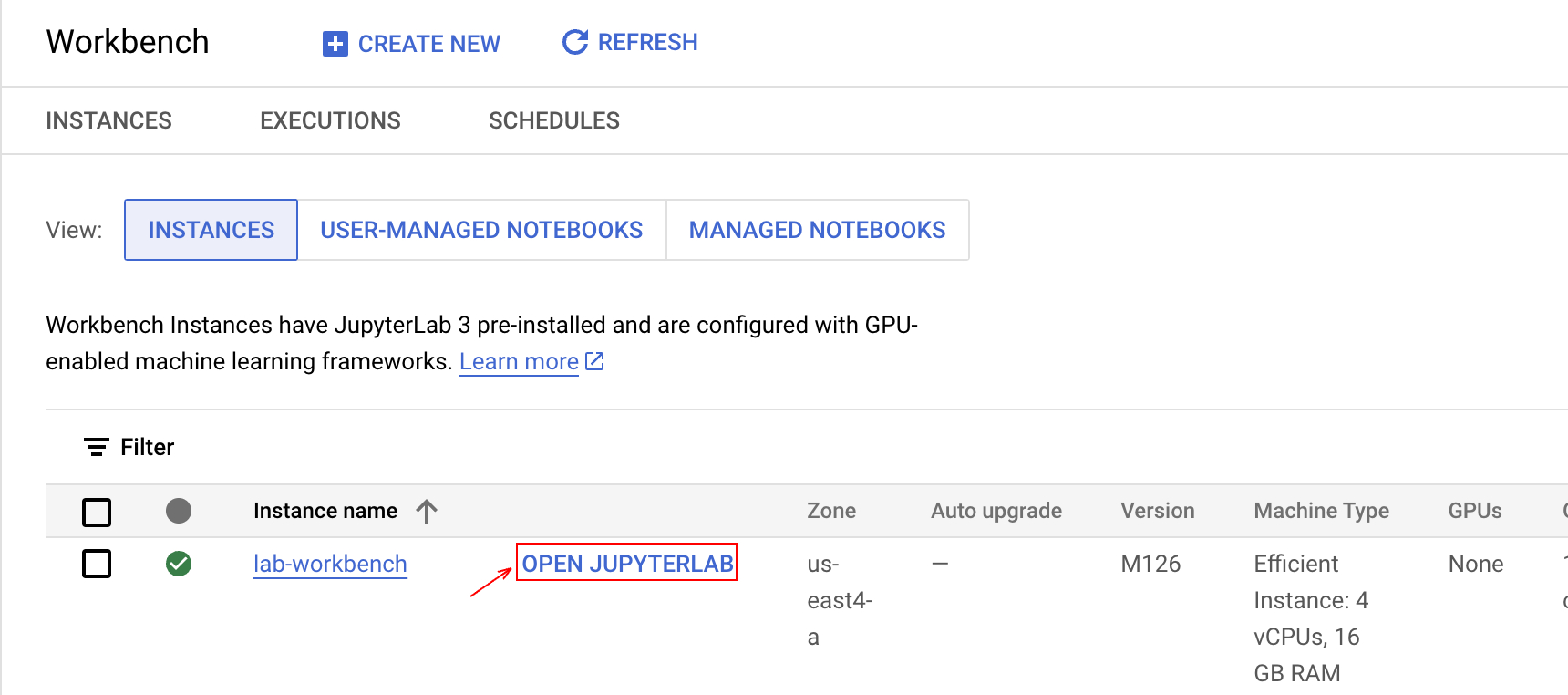

En haut de la page "Workbench", vérifiez que vous vous trouvez dans la vue Instances.

-

Cliquez sur  Créer.

Créer.

-

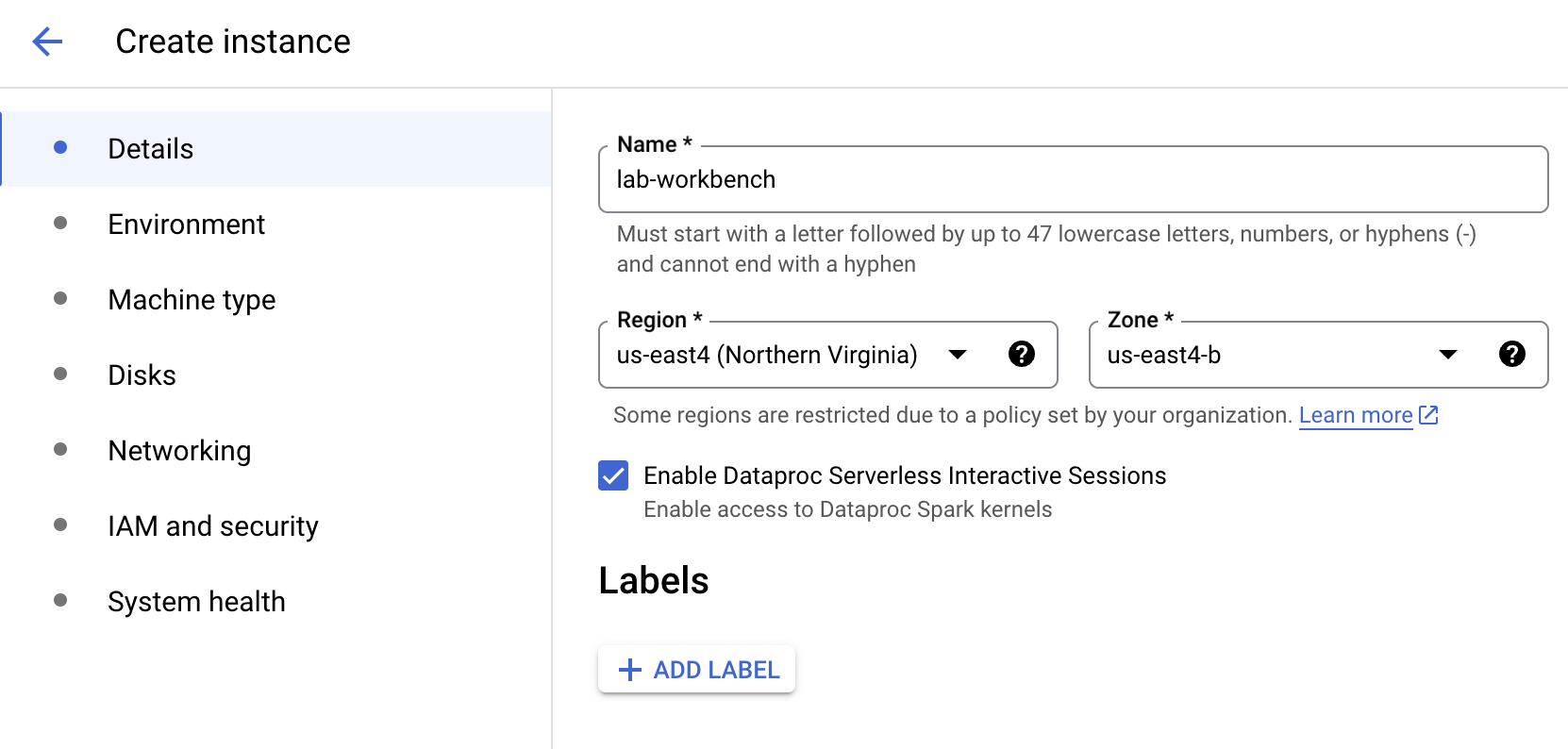

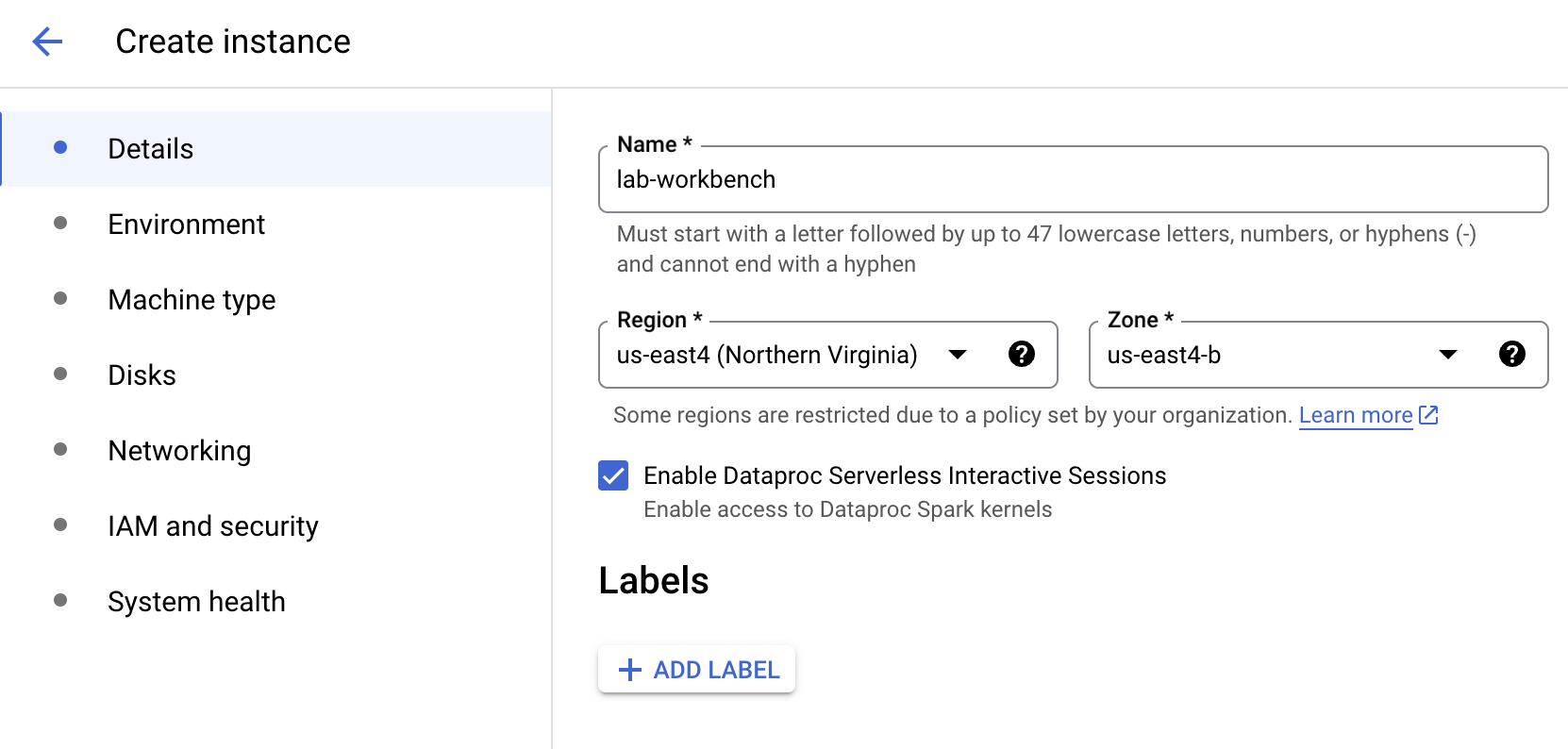

Configurez l'instance :

-

Nom : lab-workbench

-

Région : définissez la région sur

-

Zone : définissez la zone sur

-

Options avancées (facultatif) : si nécessaire, cliquez sur "Options avancées" pour une personnalisation plus avancée (par exemple, type de machine, taille du disque)

- Cliquez sur Créer.

Remarque : La création de l'instance peut prendre quelques minutes. Une coche verte apparaît à côté de son nom quand elle est prête.

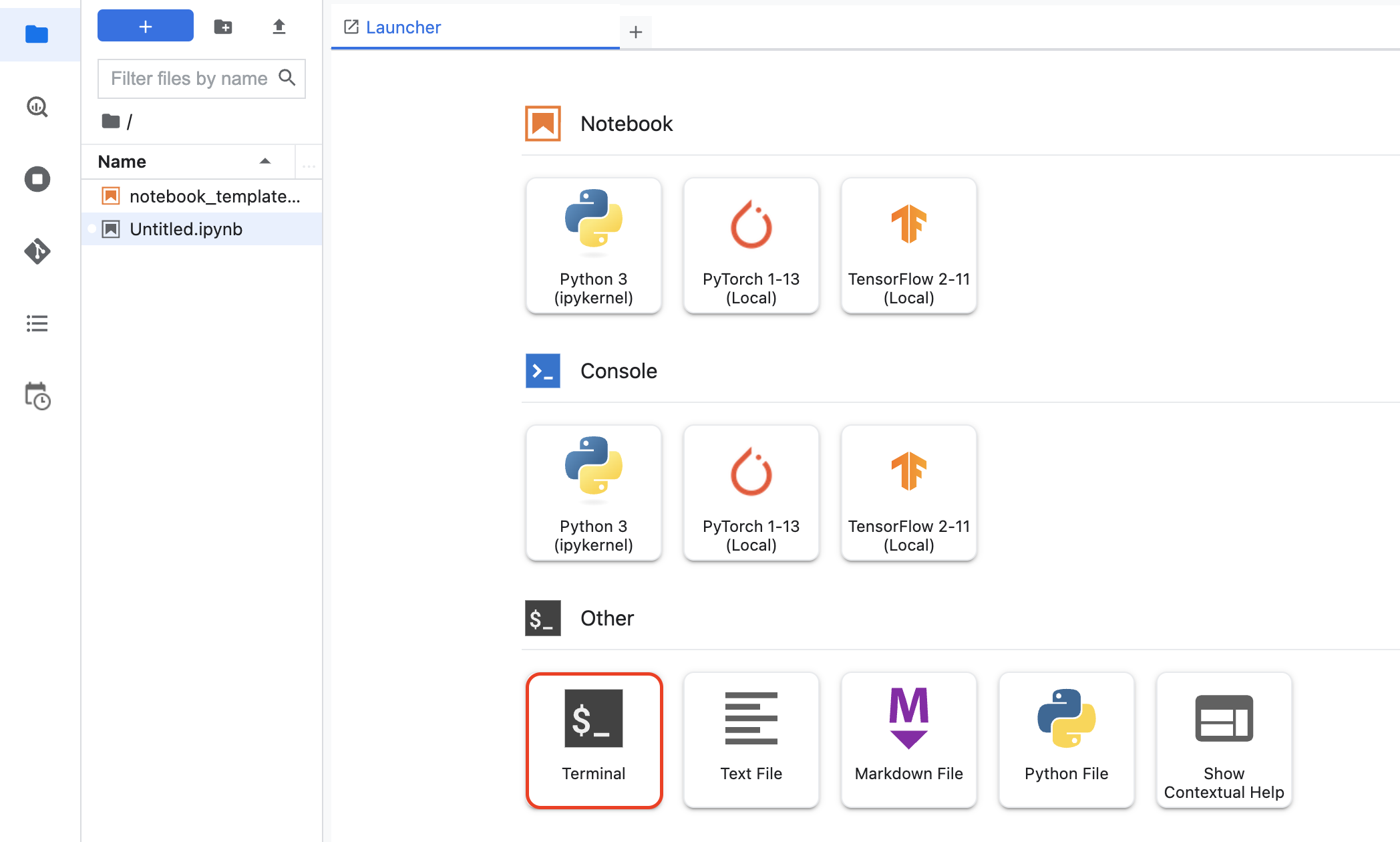

- Cliquez sur Ouvrir JupyterLab à côté du nom de l'instance pour lancer l'interface JupyterLab. Un nouvel onglet s'ouvre alors dans votre navigateur.

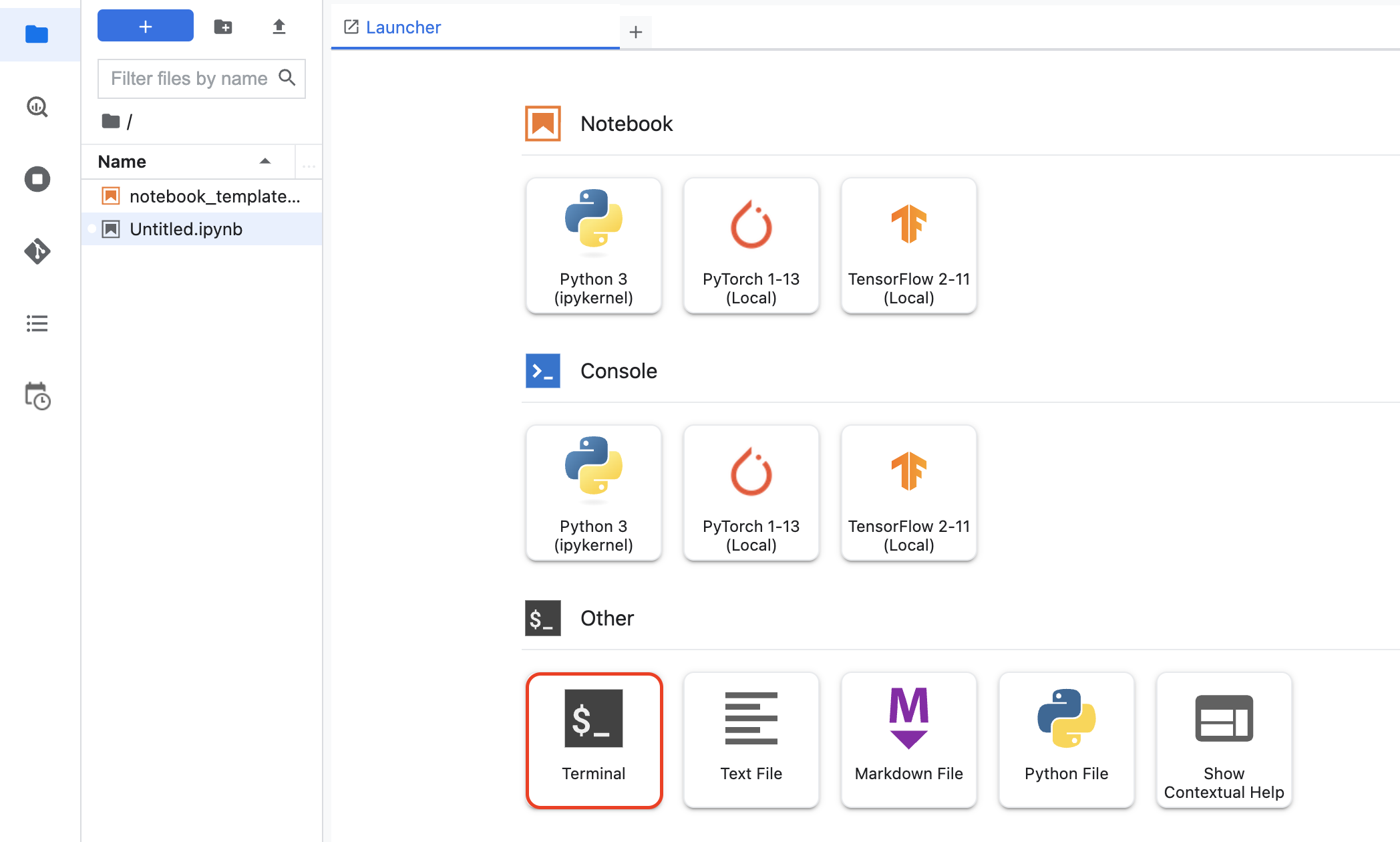

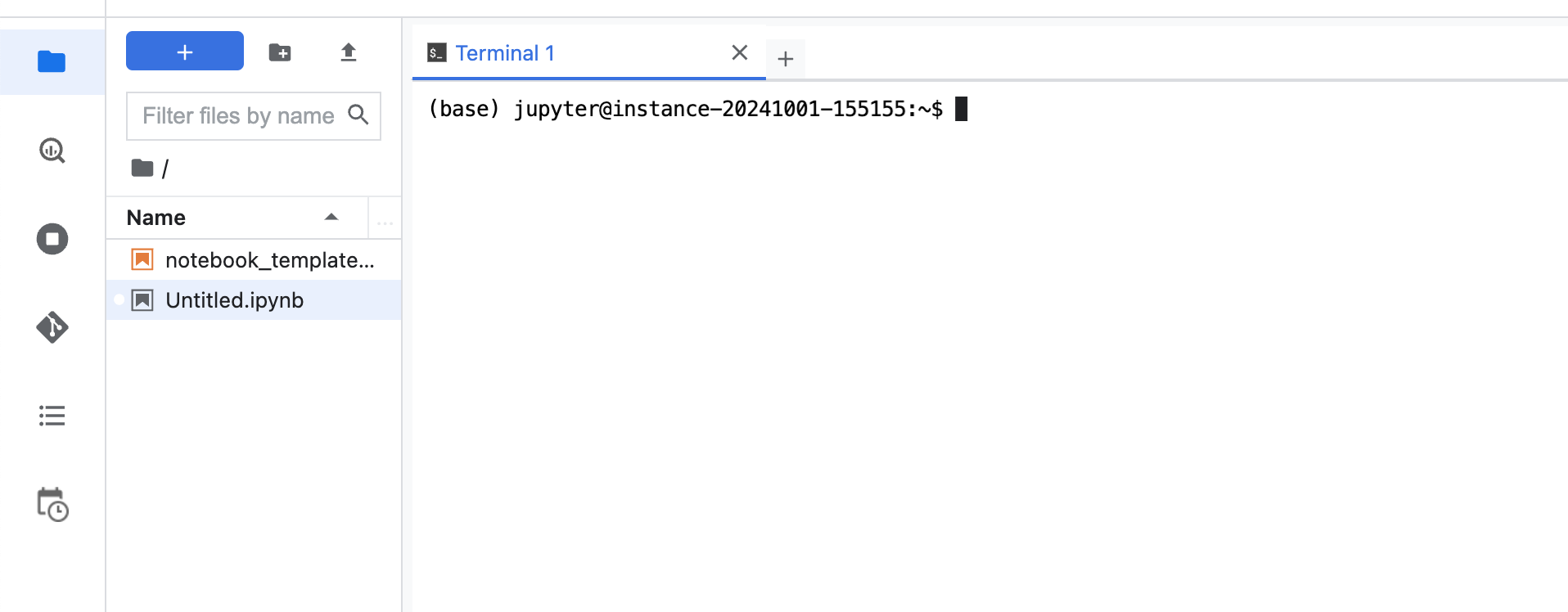

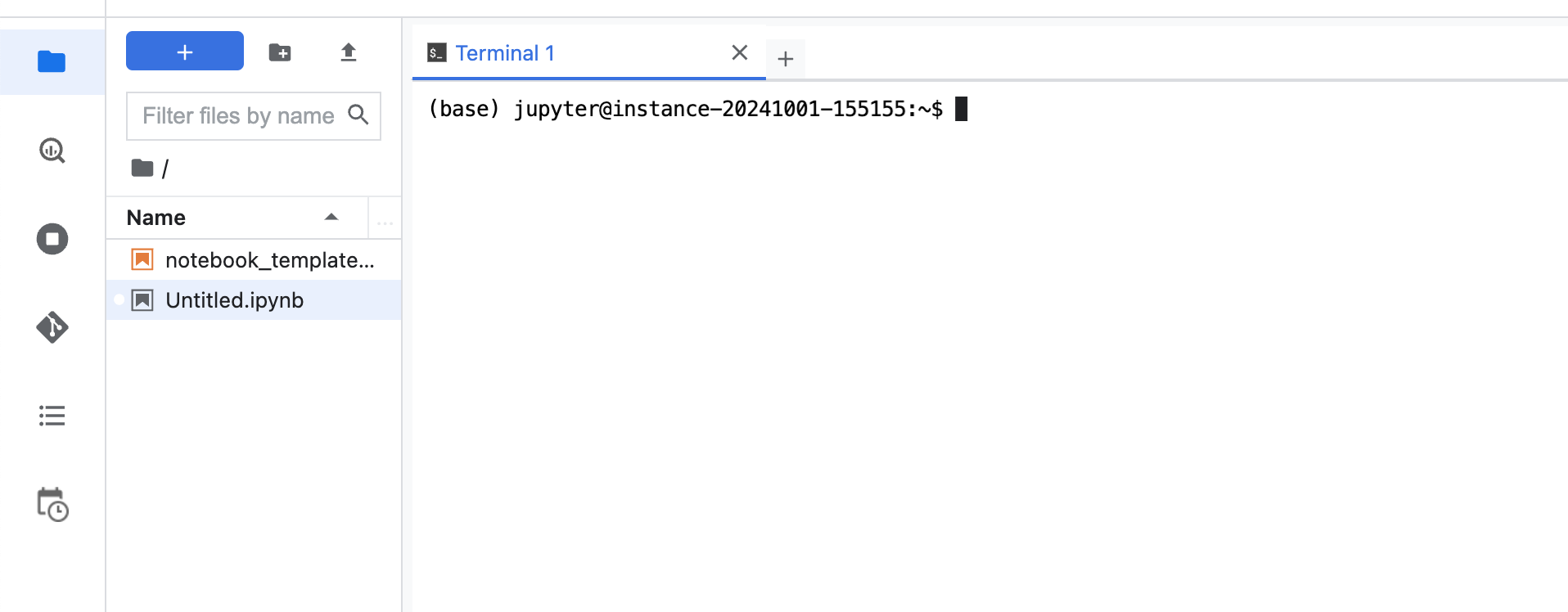

- Cliquez sur l'icône Terminal pour ouvrir une fenêtre de terminal.

La fenêtre de terminal s'ouvre dans un nouvel onglet. Vous pouvez maintenant exécuter des commandes dans le terminal pour interagir avec votre instance Workbench.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Créer une instance Vertex AI Workbench

Tâche 2 : Copier le notebook à partir d'un bucket Cloud Storage

- Dans votre notebook, copiez le chemin d'accès ci-dessous.

gcloud storage cp {{{project_0.startup_script.gcs_path | "GCS PATH"}}}

Cliquez sur Vérifier ma progression pour valider l'objectif.

Copier le notebook à partir d'un bucket Cloud Storage

-

Ouvrez le fichier notebook lab_exercise.ipynb.

-

Dans la boîte de dialogue Sélectionner le kernel, sélectionnez TensorFlow 2-11 dans la liste des kernels disponibles.

-

Dans la section Définir des constantes, remplacez la variable REGION par .

-

Continuez l'atelier dans le notebook et exécutez chaque cellule en cliquant sur l'icône Exécuter  en haut de l'écran. Vous pouvez aussi exécuter le code d'une cellule en appuyant sur MAJ+ENTRÉE.

en haut de l'écran. Vous pouvez aussi exécuter le code d'une cellule en appuyant sur MAJ+ENTRÉE.

Lisez les explications et assurez-vous de bien comprendre ce qui se passe dans chaque cellule. À mesure que vous parcourez le notebook de l'atelier, reportez votre avancement ici pour valider les exercices notés.

Tâche 3 : Créer un ensemble de données BigQuery

Cliquez sur Vérifier ma progression pour valider l'objectif.

Créer un ensemble de données BigQuery

Tâche 4 : Créer un modèle BigQuery ML XGBoost de prédiction de perte d'utilisateurs

Cliquez sur Vérifier ma progression pour valider l'objectif.

Créer un modèle BigQuery ML XGBoost de prédiction de perte d'utilisateurs

Tâche 5 : Évaluer votre modèle BigQuery ML

Cliquez sur Vérifier ma progression pour valider l'objectif.

Évaluer votre modèle BigQuery ML

Tâche 6 : Générer des prédictions de perte d'utilisateurs par lot à l'aide de votre modèle BigQuery ML

Cliquez sur Vérifier ma progression pour valider l'objectif.

Générer des prédictions de perte d'utilisateurs par lot à l'aide de votre modèle BigQuery ML

Félicitations !

Dans cet atelier, vous avez entraîné, réglé, expliqué et déployé sur Vertex AI un modèle BigQuery ML pour générer des prédictions de perte d'utilisateurs par lot et en ligne critiques. Ensuite, vous avez ciblé les clients susceptibles de se désengager avec des interventions telles que l'affichage de récompenses dans le jeu et l'envoi de notifications de rappel.

Étapes suivantes et informations supplémentaires

Pour en savoir plus sur Vertex AI, consultez la documentation Vertex AI.

Formations et certifications Google Cloud

Les formations et certifications Google Cloud vous aident à tirer pleinement parti des technologies Google Cloud. Nos cours portent sur les compétences techniques et les bonnes pratiques à suivre pour être rapidement opérationnel et poursuivre votre apprentissage. Nous proposons des formations pour tous les niveaux, à la demande, en salle et à distance, pour nous adapter aux emplois du temps de chacun. Les certifications vous permettent de valider et de démontrer vos compétences et votre expérience en matière de technologies Google Cloud.

Dernière mise à jour du manuel : 14 mai 2025

Dernier test de l'atelier : 14 mai 2025

Copyright 2025 Google LLC. Tous droits réservés. Google et le logo Google sont des marques de Google LLC. Tous les autres noms d'entreprises et de produits peuvent être des marques des entreprises auxquelles ils sont associés.

Remarque : BQML est désormais BigQuery ML.

Remarque : BQML est désormais BigQuery ML. en haut de la console Google Cloud.

en haut de la console Google Cloud. ) de la console Google Cloud, sélectionnez Vertex AI.

) de la console Google Cloud, sélectionnez Vertex AI. Créer.

Créer.

en haut de l'écran. Vous pouvez aussi exécuter le code d'une cellule en appuyant sur MAJ+ENTRÉE.

en haut de l'écran. Vous pouvez aussi exécuter le code d'une cellule en appuyant sur MAJ+ENTRÉE.