Présentation

Dans cet atelier, vous allez créer un cluster GKE, puis déployer des pods pour les utiliser avec Kubernetes Engine Monitoring. Vous allez créer des graphiques et un tableau de bord personnalisé, utiliser des métriques personnalisées, et créer des alertes et y répondre.

Remarque : Pour cet atelier, vous allez utiliser le mode GKE Standard. Cet atelier présente la journalisation et la surveillance du système, qui sont activées par défaut dans GKE Autopilot.

Objectifs

Dans cet atelier, vous allez apprendre à effectuer les tâches suivantes :

- Utiliser Kubernetes Engine Monitoring pour afficher les métriques des clusters et des charges de travail

- Utiliser le système d'alerte de Cloud Monitoring pour recevoir des notifications sur l'état du cluster

Mettre en place l'atelier

Accéder à Qwiklabs

Pour chaque atelier, nous vous attribuons un nouveau projet Google Cloud et un nouvel ensemble de ressources pour une durée déterminée, sans frais.

-

Cliquez sur le bouton Démarrer l'atelier. Si l'atelier est payant, un pop-up s'affiche pour vous permettre de sélectionner un mode de paiement.

Sur la gauche, vous trouverez le panneau Détails concernant l'atelier, qui contient les éléments suivants :

- Le bouton Ouvrir la console Google Cloud

- Le temps restant

- Les identifiants temporaires que vous devez utiliser pour cet atelier

- Des informations complémentaires vous permettant d'effectuer l'atelier

-

Cliquez sur Ouvrir la console Google Cloud (ou effectuez un clic droit et sélectionnez Ouvrir le lien dans la fenêtre de navigation privée si vous utilisez le navigateur Chrome).

L'atelier lance les ressources, puis ouvre la page Se connecter dans un nouvel onglet.

Conseil : Réorganisez les onglets dans des fenêtres distinctes, placées côte à côte.

Remarque : Si la boîte de dialogue Sélectionner un compte s'affiche, cliquez sur Utiliser un autre compte.

-

Si nécessaire, copiez le nom d'utilisateur ci-dessous et collez-le dans la boîte de dialogue Se connecter.

{{{user_0.username | "Username"}}}

Vous trouverez également le nom d'utilisateur dans le panneau Détails concernant l'atelier.

-

Cliquez sur Suivant.

-

Copiez le mot de passe ci-dessous et collez-le dans la boîte de dialogue Bienvenue.

{{{user_0.password | "Password"}}}

Vous trouverez également le mot de passe dans le panneau Détails concernant l'atelier.

-

Cliquez sur Suivant.

Important : Vous devez utiliser les identifiants fournis pour l'atelier. Ne saisissez pas ceux de votre compte Google Cloud.

Remarque : Si vous utilisez votre propre compte Google Cloud pour cet atelier, des frais supplémentaires peuvent vous être facturés.

-

Accédez aux pages suivantes :

- Acceptez les conditions d'utilisation.

- N'ajoutez pas d'options de récupération ni d'authentification à deux facteurs (ce compte est temporaire).

- Ne vous inscrivez pas à des essais sans frais.

Après quelques instants, la console Cloud s'ouvre dans cet onglet.

Remarque : Pour afficher un menu contenant la liste des produits et services Google Cloud, cliquez sur le menu de navigation en haut à gauche, ou saisissez le nom du service ou du produit dans le champ Recherche.

Activer Google Cloud Shell

Google Cloud Shell est une machine virtuelle qui contient de nombreux outils pour les développeurs. Elle comprend un répertoire d'accueil persistant de 5 Go et s'exécute sur Google Cloud.

Google Cloud Shell vous permet d'accéder à vos ressources Google Cloud grâce à une ligne de commande.

-

Dans la barre d'outils située en haut à droite dans la console Cloud, cliquez sur le bouton "Ouvrir Cloud Shell".

-

Cliquez sur Continuer.

Le provisionnement et la connexion à l'environnement prennent quelques instants. Une fois connecté, vous êtes en principe authentifié et le projet est défini sur votre ID_PROJET. Par exemple :

gcloud est l'outil de ligne de commande pour Google Cloud. Il est préinstallé sur Cloud Shell et permet la complétion par tabulation.

- Vous pouvez lister les noms des comptes actifs à l'aide de cette commande :

gcloud auth list

Résultat :

Credentialed accounts:

- @.com (active)

Exemple de résultat :

Credentialed accounts:

- google1623327_student@qwiklabs.net

- Vous pouvez lister les ID de projet à l'aide de cette commande :

gcloud config list project

Résultat :

[core]

project =

Exemple de résultat :

[core]

project = qwiklabs-gcp-44776a13dea667a6

Remarque : Pour consulter la documentation complète sur gcloud, accédez au guide de présentation de la gcloud CLI.

Tâche 1 : Utiliser Kubernetes Engine Monitoring

Google Kubernetes Engine intègre la compatibilité gérée pour Monitoring.

Dans cette tâche, vous allez créer un cluster compatible avec Kubernetes Engine Monitoring, puis exécuter des tâches de surveillance courantes à l'aide de l'interface de surveillance et de journalisation de Kubernetes Engine.

Configurer un cluster GKE avec Kubernetes Engine Monitoring

Dans cette tâche, vous allez créer un cluster GKE pour lequel Kubernetes Engine Monitoring est activé. Vous déploierez ensuite des exemples de charges de travail sur votre cluster GKE afin de les utiliser ultérieurement dans cet exercice.

- Dans Cloud Shell, saisissez la commande suivante afin de créer des variables d'environnement pour la zone Google Cloud et le nom du cluster, lesquelles serviront ensuite à créer le cluster de cet atelier :

export my_zone={{{ project_0.default_zone| "Zone" }}}

export my_cluster=standard-cluster-1

- Configurez la complétion par tabulation dans l'outil de ligne de commande kubectl :

source <(kubectl completion bash)

- Créez un cluster de VPC natif Kubernetes avec la surveillance Kubernetes native activée :

gcloud container clusters create $my_cluster \

--num-nodes 3 --enable-ip-alias --zone $my_zone \

--logging=SYSTEM \

--monitoring=SYSTEM

Remarque : Le déploiement du cluster peut prendre quelques minutes.

- Configurez l'accès à votre cluster pour kubectl :

gcloud container clusters get-credentials $my_cluster --zone $my_zone

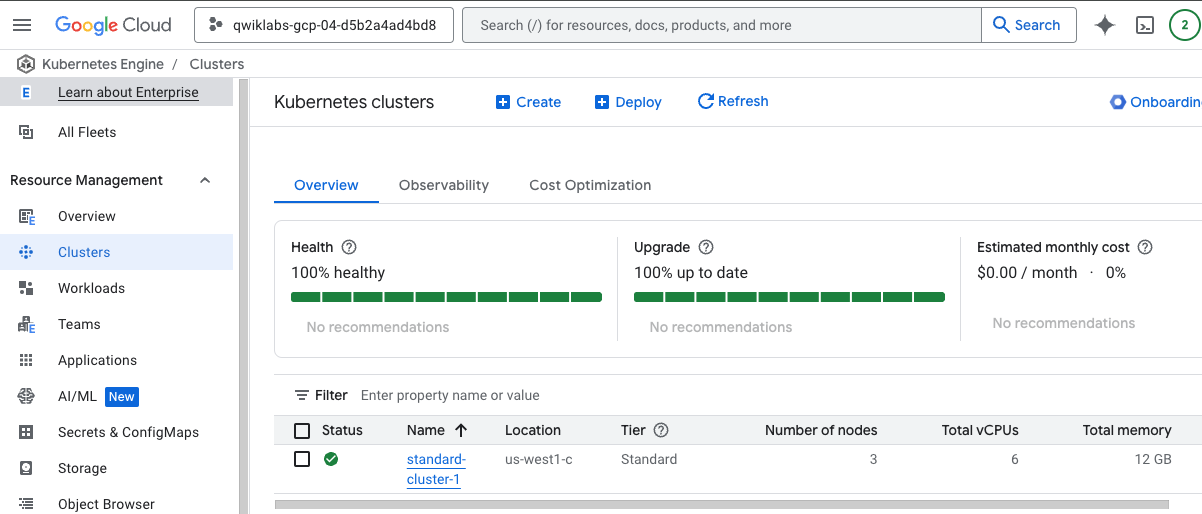

Vérifier la configuration de la surveillance à l'aide de la console Google Cloud

-

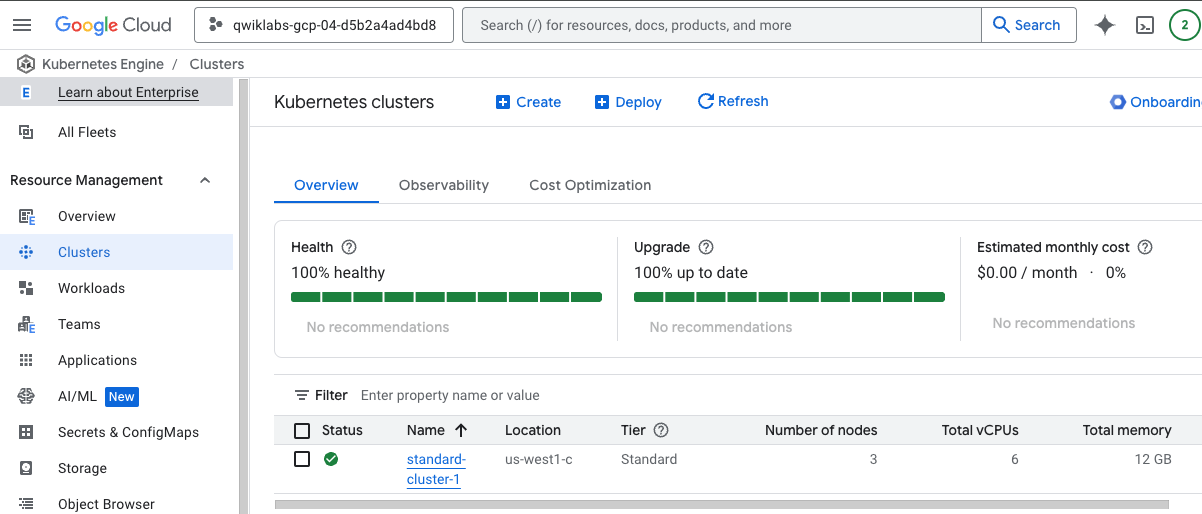

Dans le menu de navigation ( ) de la console Google Cloud, cliquez sur Kubernetes Engine > Clusters.

) de la console Google Cloud, cliquez sur Kubernetes Engine > Clusters.

-

Cliquez sur le nom du cluster standard-cluster-1 pour afficher ses informations.

Vous pouvez faire défiler la page vers le bas pour afficher plus de détails.

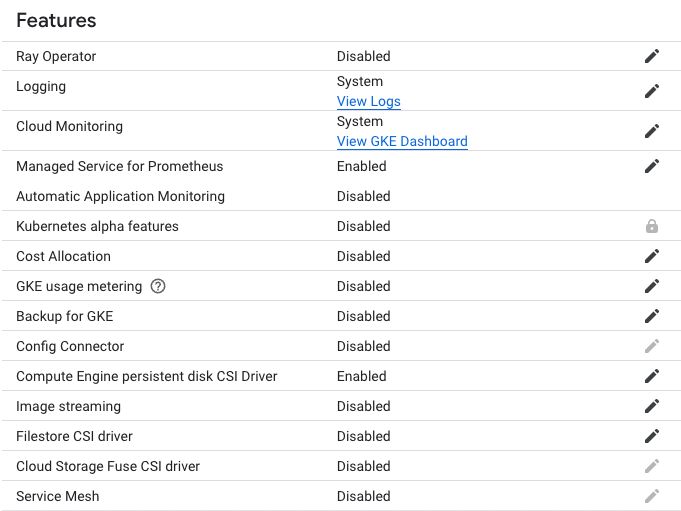

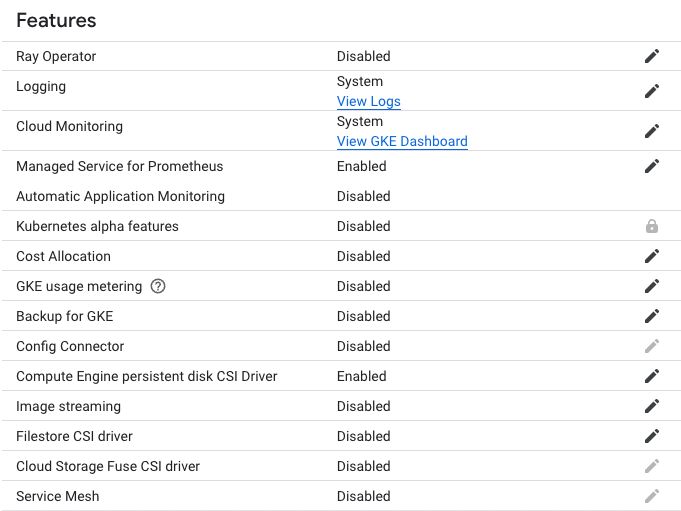

Sous le titre Fonctionnalités, vous trouverez les paramètres de Logging et de Cloud Monitoring qui permettent de définir le type de journalisation sur Système.

Déployer un exemple de charge de travail sur votre cluster GKE

Vous allez maintenant déployer un exemple de charge de travail dans l'espace de noms par défaut de votre cluster GKE. Cette charge de travail comprend un déploiement de trois pods exécutant une application de démonstration Hello World simple. Plus tard dans cet atelier, vous allez apprendre à surveiller l'état de cette charge de travail dans Monitoring.

- Dans Cloud Shell, saisissez la commande suivante pour cloner le dépôt dans l'environnement Cloud Shell de l'atelier :

git clone https://github.com/GoogleCloudPlatform/training-data-analyst

- Créez un lien symbolique qui servira de raccourci vers le répertoire de travail :

ln -s ~/training-data-analyst/courses/ak8s/v1.1 ~/ak8s

- Passez au répertoire qui contient les exemples de fichiers de l'atelier :

cd ~/ak8s/Monitoring/

- Dans Cloud Shell, exécutez la commande suivante. Elle permet de déployer un fichier manifeste afin de créer un exemple de déploiement fournissant des éléments à surveiller lorsque vous réaliserez l'exercice de surveillance à l'aide de Monitoring plus tard dans cet atelier :

kubectl create -f hello-v2.yaml

Ce fichier manifeste de déploiement crée trois pods qui exécutent une application de démonstration Hello World basique.

- Dans Cloud Shell, exécutez la commande suivante pour vérifier que le déploiement existe :

kubectl get deployments

Le résultat de cette commande indique que l'application hello-v2 est en cours d'exécution dans l'espace de noms par défaut :

NAME READY UP-TO-DATE AVAILABLE AGE

hello-v2 3/3 3 3 6s

Cliquez sur Vérifier ma progression pour valider l'objectif.

Configurer un cluster GKE avec Kubernetes Engine Monitoring et déployer un exemple de charge de travail

Déployer l'application GCP-GKE-Monitor-Test

Vous allez maintenant déployer l'application GCP-GKE-Monitor-Test dans l'espace de noms par défaut de votre cluster GKE. Cette charge de travail comprend un déploiement constitué d'un seul pod, qui est ensuite exposé à Internet via un service LoadBalancer.

- Dans Cloud Shell, exécutez la commande suivante pour stocker l'ID de projet actuel dans une variable d'environnement :

export PROJECT_ID="$(gcloud config get-value project -q)"

- Dans Cloud Shell, exécutez la commande suivante pour passer au répertoire de chargement de l'application :

cd gcp-gke-monitor-test

- Dans Cloud Shell, exécutez la commande suivante pour créer l'image Docker de l'application de test de charge, puis transférez l'image vers le registre Google gcr.io de votre projet d'atelier :

gcloud builds submit --tag=gcr.io/$PROJECT_ID/gcp-gke-monitor-test .

Vous pouvez également utiliser Docker directement pour créer une image et la transférer vers gcr.io :

docker build -t gcr.io/${PROJECT_ID}/gcp-gke-monitor-test .

- Dans Cloud Shell, exécutez la commande suivante pour revenir au répertoire de travail principal de l'atelier :

cd ..

- Dans Cloud Shell, exécutez la commande suivante pour remplacer une valeur d'espace réservé dans le fichier

gcp-gke-monitor-test.yaml par l'image Docker que vous venez de transférer vers gcr.io :

sed -i "s/\[DOCKER-IMAGE\]/gcr\.io\/${PROJECT_ID}\/gcp-gke-monitor-test\:latest/" gcp-gke-monitor-test.yaml

Remarque : Dans UNIX, la commande sed signifie éditeur de flux. Elle permet d'exécuter de nombreuses fonctions sur les fichiers (remplacer, insérer ou supprimer, par exemple). Cependant, l'utilisation la plus courante de sed est la substitution.

Grâce à cette commande sed, vous pouvez modifier des fichiers sans même les ouvrir. Cela vous permet de rechercher un élément dans un fichier et de le remplacer bien plus rapidement que s'il vous fallait d'abord ouvrir le fichier dans un éditeur, puis modifier l'élément.

- Dans Cloud Shell, saisissez la commande suivante. Elle permet de déployer le fichier manifeste que vous venez de mettre à jour pour créer le déploiement et le service dont vous avez besoin pour tester Kubernetes Engine Monitoring :

kubectl create -f gcp-gke-monitor-test.yaml

- Dans Cloud Shell, exécutez la commande suivante pour vérifier que le déploiement existe :

kubectl get deployments

Le résultat de cette commande indique que l'application hello-v2 est en cours d'exécution dans l'espace de noms par défaut :

NAME READY UP-TO-DATE AVAIL AGE

gcp-gke-monitor-test 1/1 1 0 1s

hello-v2 3/3 3 3 38s

- Dans Cloud Shell, exécutez la commande suivante pour vérifier que le service existe :

kubectl get service

Le résultat de cette commande indique que le service gcp-gke-monitor-test-service est en cours d'exécution dans l'espace de noms par défaut. Vous devrez peut-être exécuter cette commande plusieurs fois jusqu'à ce qu'une adresse IP externe soit attribuée à ce service.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Déployer l'application GCP-GKE-Monitor-Test

Tâche 2 : Utiliser l'application GCP-GKE-Monitor-Test

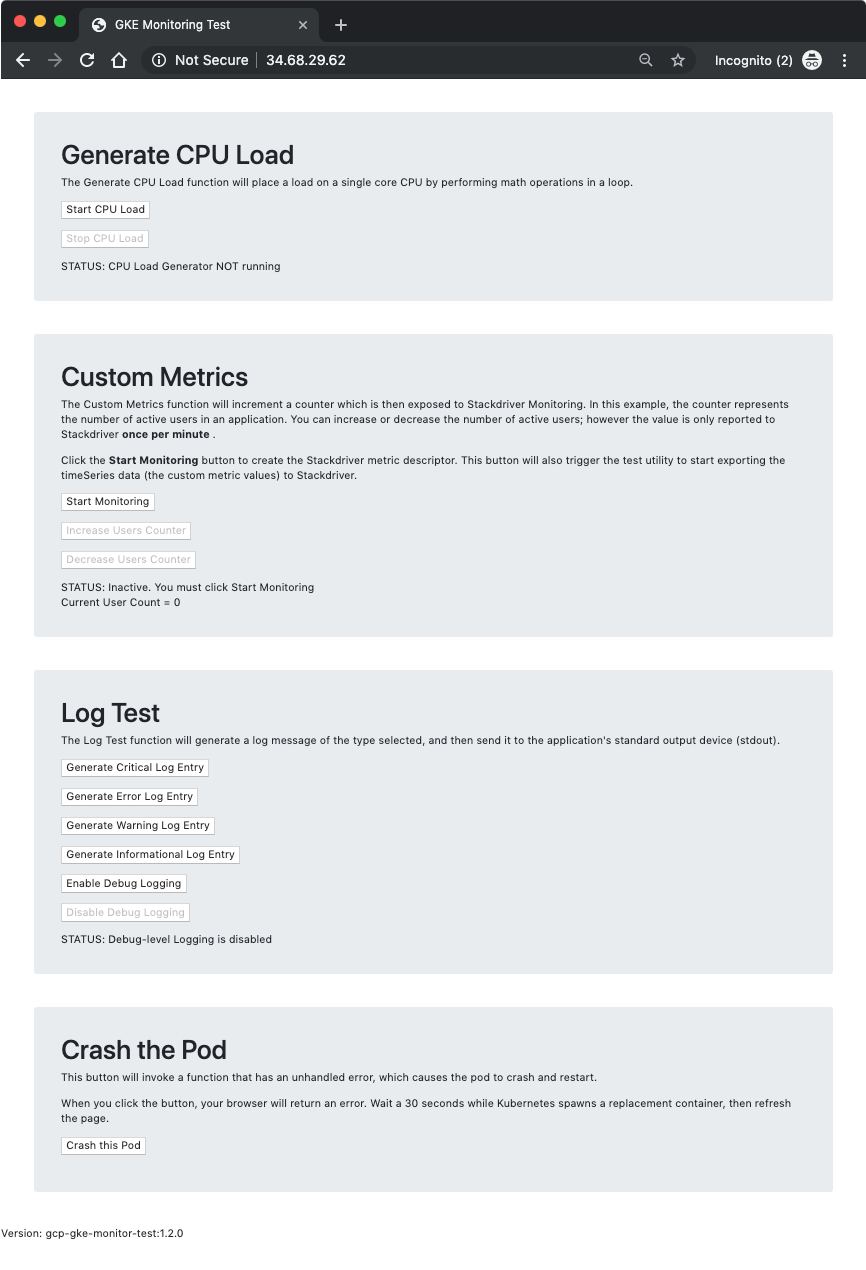

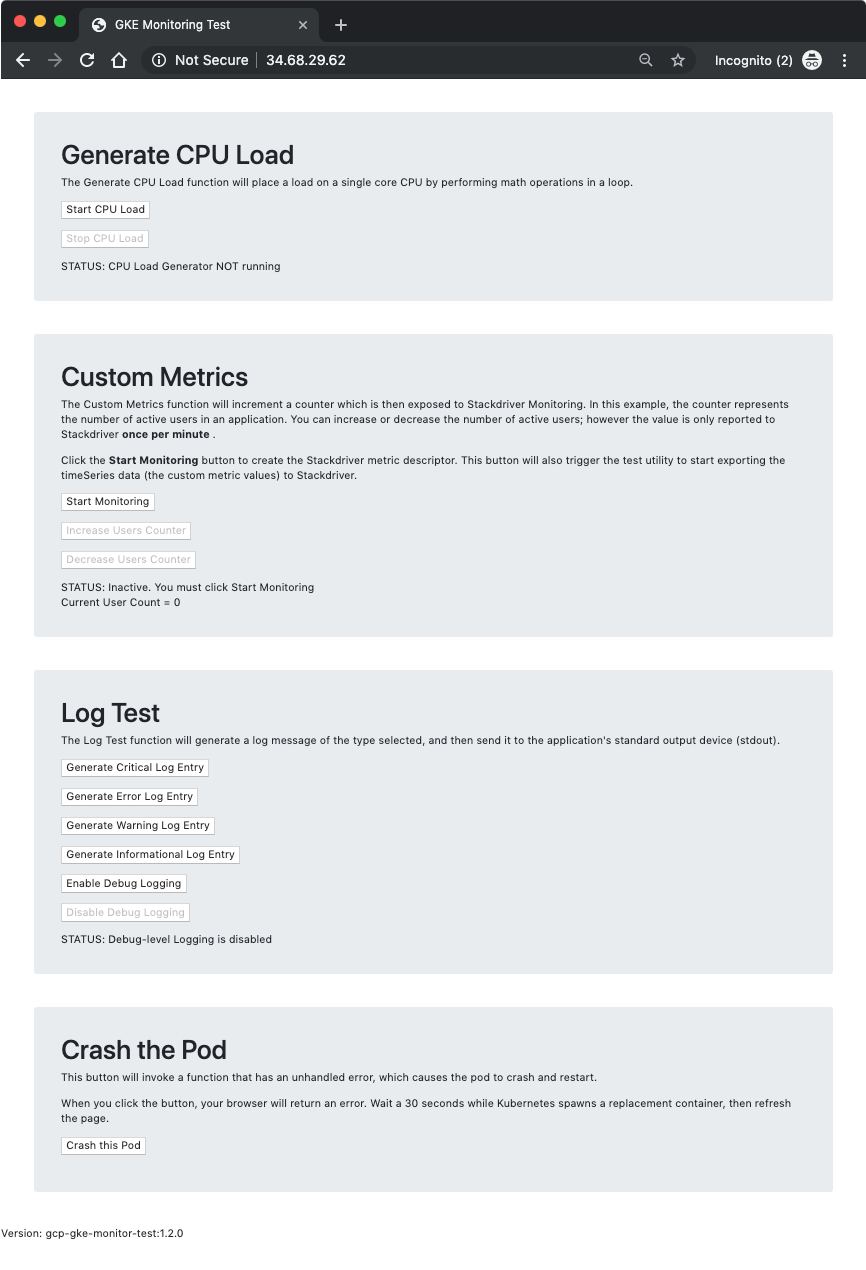

Dans cette tâche, vous allez utiliser l'application GCP-GKE-Monitor-Test pour explorer différents aspects de Kubernetes Engine Monitoring. L'outil comporte quatre sections :

- Generate CPU Load (Générer la charge du processeur)

- Custom Metrics (Métriques personnalisées)

- Log Test (Test de journal)

- Crash the Pod (Plantage du pod)

Dans la première section, Generate CPU Load (Générer une charge de processeur), vous trouverez des boutons permettant de démarrer et d'arrêter un générateur de charge de processeur. L'outil démarre une boucle d'opérations mathématiques qui consomment l'intégralité d'un cœur de processeur. Pour éviter de perdre le contrôle du pod en raison de la saturation du processeur, la boucle libère régulièrement le processeur pendant 100 nanosecondes. Cela vous permet d'arrêter rapidement le générateur de charge du processeur sans faire planter le pod.

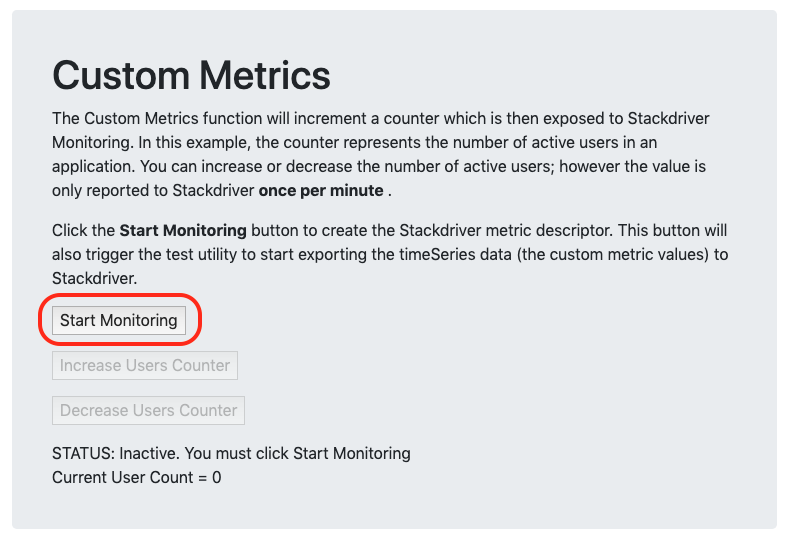

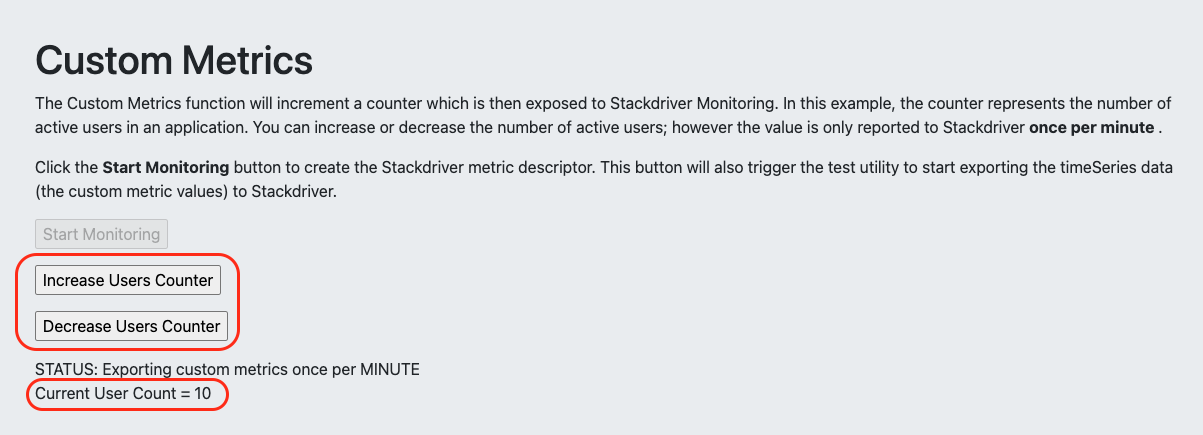

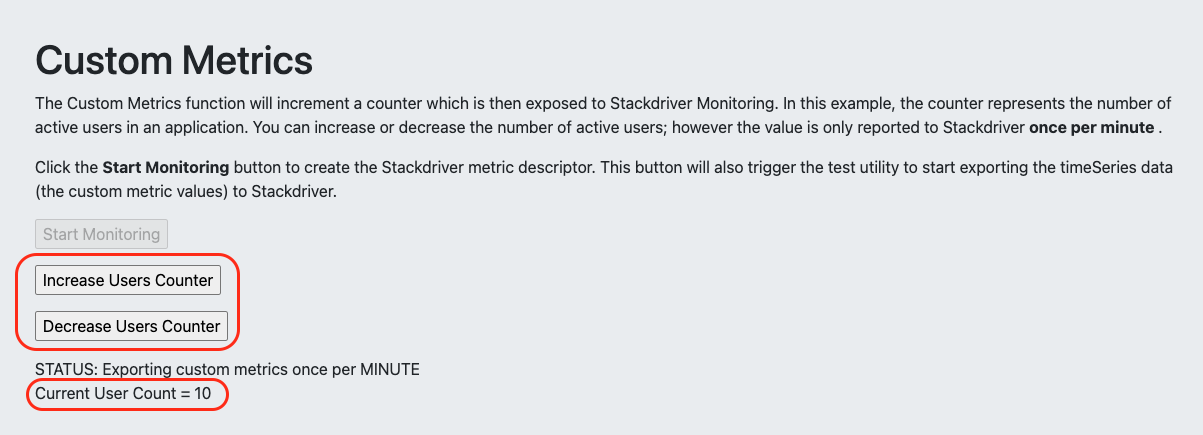

La deuxième section, Custom Metrics (Métriques personnalisées), vous permet d'explorer la surveillance des métriques personnalisées dans Cloud Monitoring. Lorsque vous cliquez sur "Start Monitoring" (Démarrer la surveillance), l'outil crée d'abord le descripteur de métrique personnalisée nécessaire, puis lance une boucle qui envoie les valeurs de la métrique personnalisée à Monitoring toutes les 60 secondes. Les métriques personnalisées codées dans cet outil sont conçues pour simuler une application capable de suivre le nombre d'utilisateurs actifs connectés, puis de communiquer ce nombre à un service externe.

Pour exploiter tout le potentiel de ces métriques personnalisées, vous devrez peut-être ajouter une instrumentation supplémentaire dans le code de votre application. Dans cet exercice, vous pouvez simuler la connexion et la déconnexion des utilisateurs en cliquant sur les boutons "Increase Users" (Augmenter le nombre d'utilisateurs) et "Decrease Users" (Diminuer le nombre d'utilisateurs).

Sachez également que, bien que l'outil Web vous permette de modifier le nombre d'utilisateurs en temps réel (de la même manière que les utilisateurs peuvent se connecter et se déconnecter en temps réel), les API Cloud Monitoring ne permettent à l'outil d'envoyer sa valeur actuelle qu'une fois par minute. Par conséquent, vos graphiques Cloud Monitoring ne reflètent pas les modifications qui se produisent entre les mises à jour par minute.

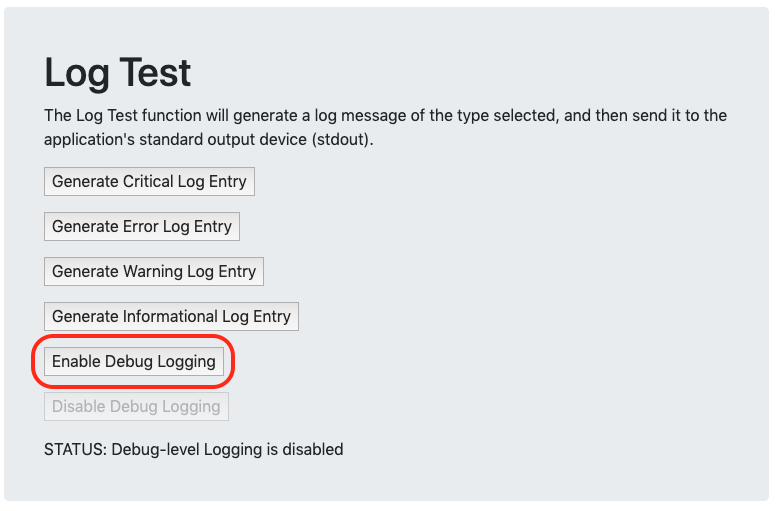

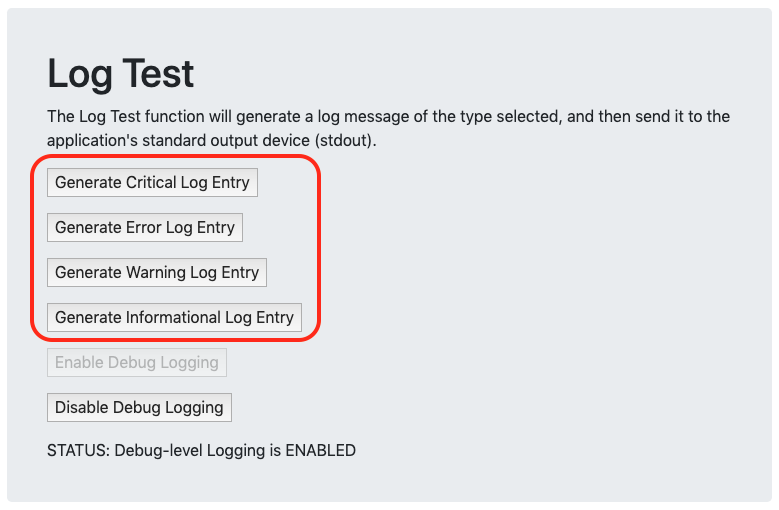

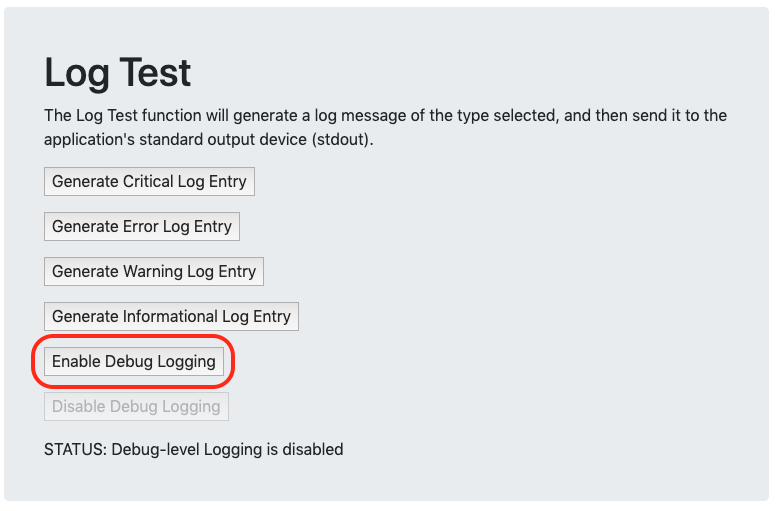

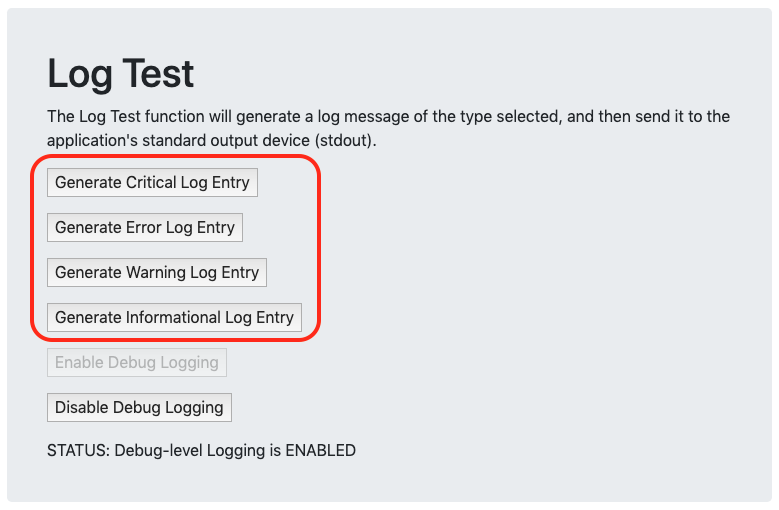

La troisième section, Log Test (Test de journal), vous permet d'envoyer différentes chaînes de texte à la sortie standard du conteneur (la console). Ces chaînes de texte sont ensuite collectées régulièrement par Cloud Monitoring et stockées sous la forme de messages de journal associés au pod et au conteneur. Vous pouvez éventuellement activer la journalisation au niveau du débogage pour afficher davantage d'entrées dans les journaux. Cela vous permet de voir les messages dans les journaux lorsque vous augmentez le nombre d'utilisateurs dans la section "Custom Metrics" (Métriques personnalisées), ou lorsque vous activez ou désactivez le générateur de charge du processeur. Notez que ces journaux sont envoyés au format texte brut afin de simuler des applications anciennes non compatibles avec les messages au format JSON. En consultant les journaux dans Logging, vous remarquerez que les journaux d'événements Kubernetes basés sur JSON de votre pod présentent des options de filtrage et de requête bien plus robustes que celles disponibles pour les journaux non structurés.

La quatrième et dernière section, Crash the pod (Plantage du pod), vous permet de faire planter le pod d'un simple clic. L'outil exécute une portion de code avec une erreur non gérée qui provoque le plantage du pod et déclenche un déploiement pour redémarrer un nouveau pod de remplacement. Vous pouvez utiliser cet outil pour connaître la vitesse de récupération après une erreur dans Kubernetes Engine. Vous pouvez par la même occasion constater la perte de l'état de session, car chaque pod gère sa propre session au lieu de la stocker dans un emplacement central. Au redémarrage du pod, tous les boutons d'activation et paramètres retrouvent leur valeur par défaut.

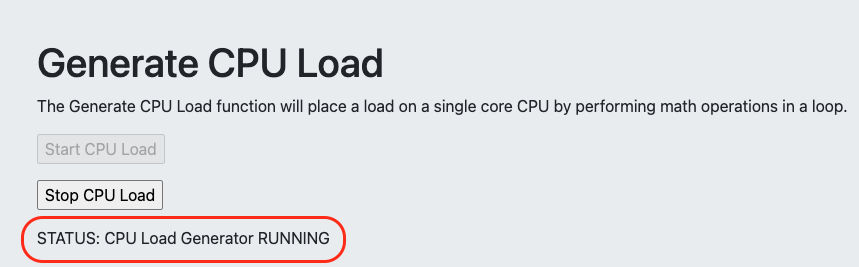

Démarrer le générateur de charge du processeur

Vous allez maintenant ouvrir un navigateur Web, vous connecter à l'outil GCP-GKE-Monitor-Test et démarrer le générateur de charge de processeur.

- Dans Cloud Shell, saisissez la commande suivante pour obtenir l'adresse IP externe du service "gcp-gke-monitor-test-service" :

kubectl get service

- Ouvrez votre navigateur Web et accédez à l'adresse EXTERNAL-IP du service.

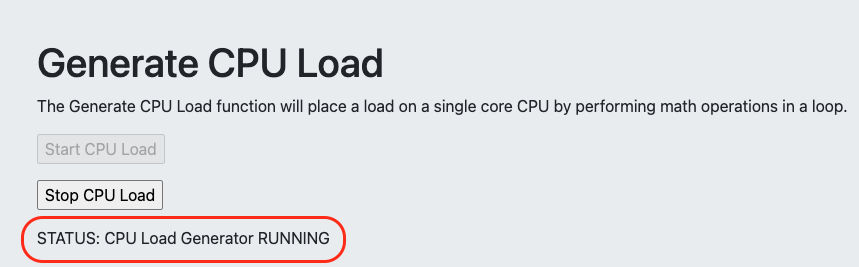

- Dans la section Generate CPU Load (Générer la charge du processeur), cliquez sur le bouton Start CPU Load (Démarrer la charge du processeur). Notez que le texte du champ STATUS (État) change lorsque le générateur de charge démarre.

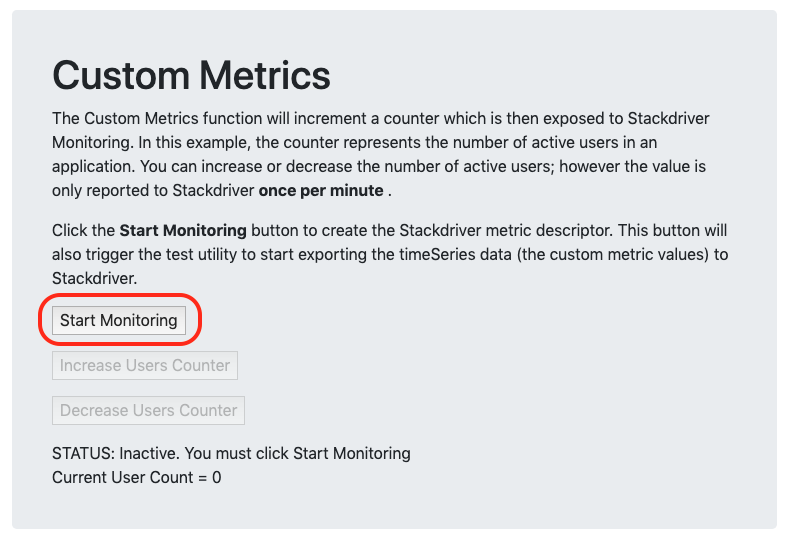

Lancer la collecte de métriques personnalisées

Vous allez maintenant lancer un processus dans l'outil GCP-GKE-Monitor-Test qui crée un descripteur de métrique personnalisée dans Cloud Monitoring. Plus tard, lorsque l'outil commencera à envoyer les données de la métrique personnalisée, Monitoring les associera à ce descripteur de métrique. Notez que Monitoring crée souvent automatiquement des descripteurs de métriques personnalisées lorsque vous envoyez les données de la métrique personnalisée. Cependant, créer le descripteur manuellement vous permet de mieux contrôler le texte qui s'affiche dans l'interface de Monitoring et ainsi de trouver vos données plus facilement dans l'explorateur de métriques.

- Dans la section Custom Metrics (Métriques personnalisées) de l'outil GCP-GKE-Monitor-Test, cliquez sur le bouton Start Monitoring (Démarrer la surveillance).

Vous pouvez maintenant cliquer sur les boutons "Increase Users" (Augmenter le nombre d'utilisateurs) et "Decrease Users" (Diminuer le nombre d'utilisateurs) pour modifier le nombre actuel d'utilisateurs affiché sous le texte STATUS (État).

- Cliquez sur Increase Users Counter (Augmenter le nombre d'utilisateurs) et répétez cette opération jusqu'à ce que la valeur du champ Current User Count (Nombre d'utilisateurs actuel) soit définie sur 10.

Vous devrez peut-être patienter deux à trois minutes pour que le premier point de données apparaisse dans Monitoring. Vous vérifierez cette métrique personnalisée dans Cloud Monitoring dans la suite de cet atelier.

Générer des messages de journal de test

Vous allez maintenant utiliser l'outil GCP-GKE-Monitor-Test pour créer des exemples de journaux texte que vous pourrez afficher ultérieurement dans Cloud Monitoring.

- Dans l'outil GCP-GKE-Monitor-Test, dans la section Log Test (Test de journal), cliquez sur le bouton Enable Debug Logging (Activer la journalisation de débogage) pour augmenter le nombre de journaux générés par l'outil.

- Cliquez sur les quatre autres boutons d'entrée de journal pour générer des exemples de messages de journal supplémentaires. Il est important de sélectionner divers niveaux de gravité afin de voir comment les différents types de messages sont affichés dans Monitoring.

Tâche 3 : Utiliser Kubernetes Engine Monitoring

Dans cette tâche, vous allez utiliser Kubernetes Engine Monitoring pour afficher l'état actuel de votre cluster GKE et des deux charges de travail qui y sont exécutées.

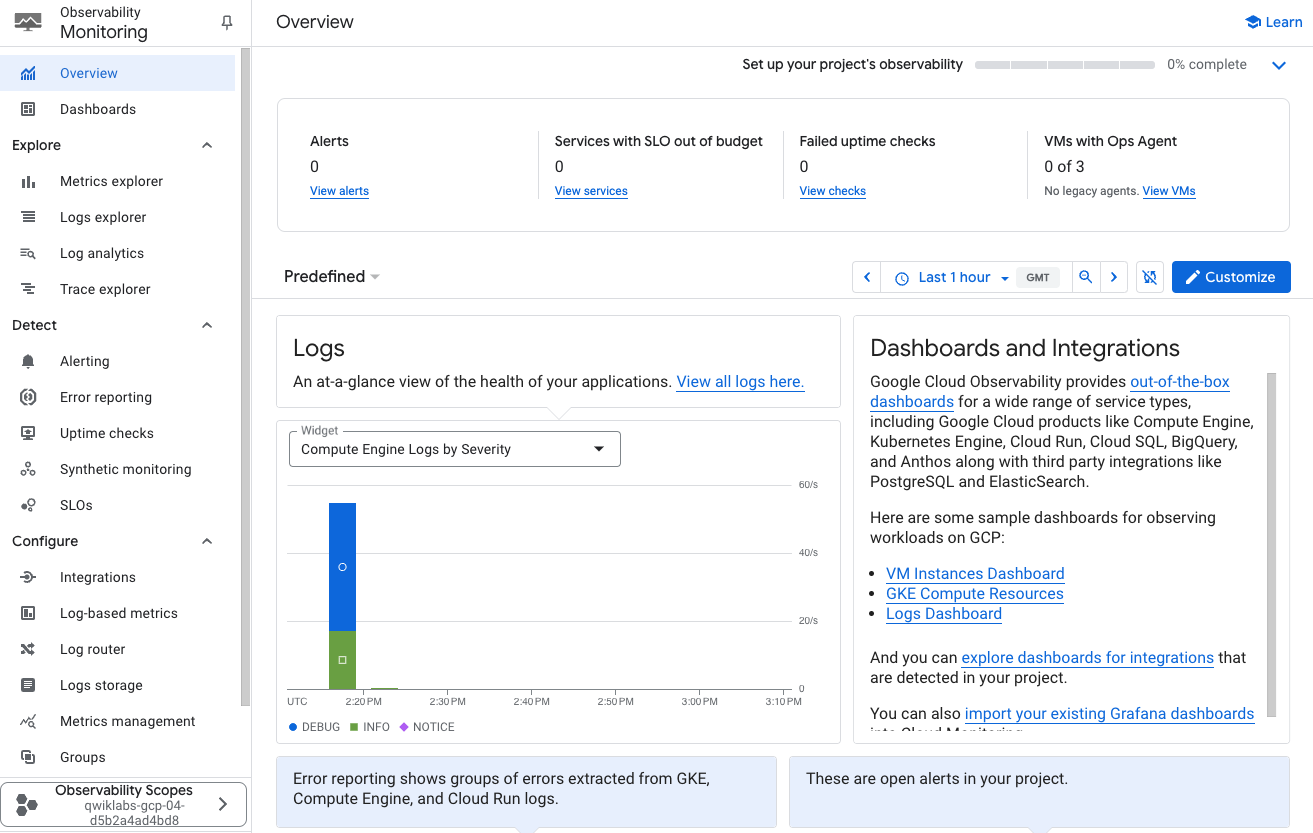

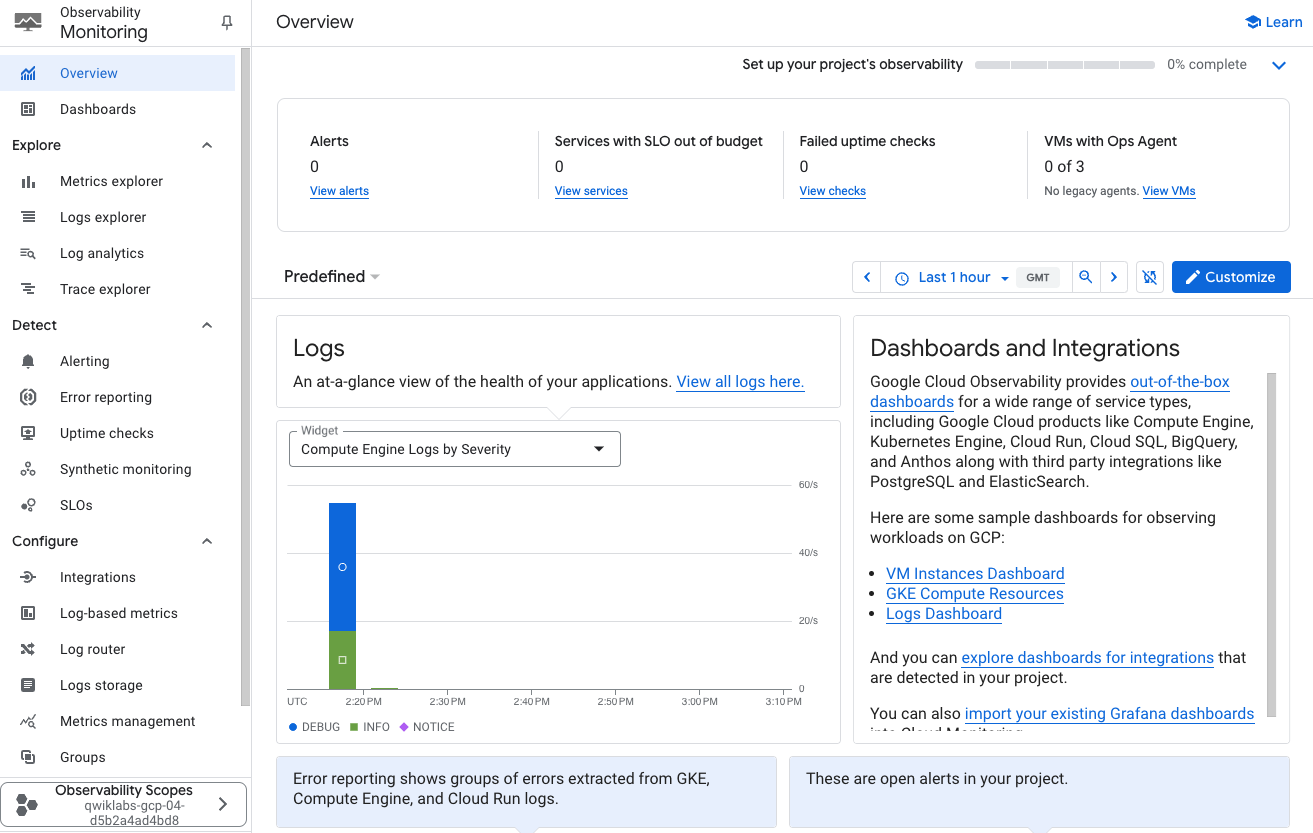

Créer un espace de travail Monitoring

Vous allez maintenant configurer un espace de travail Monitoring associé à votre projet Google Cloud. Suivez les étapes ci-dessous pour créer un compte incluant un essai sans frais de Monitoring.

-

Dans la barre de titre de la console Google Cloud, saisissez Monitoring dans le champ Recherche, puis cliquez sur Monitoring (Contrôles qualité infrastructures et applis) dans les résultats de recherche.

-

Cliquez sur Épingler à côté de Observabilité Monitoring.

-

Attendez que votre espace de travail soit provisionné.

Lorsque le tableau de bord Monitoring s'affiche, votre espace de travail est prêt.

Examiner l'interface de surveillance de Kubernetes Engine

Vous allez maintenant ouvrir et parcourir les trois sections différentes de l'interface de Kubernetes Engine Monitoring : "Infrastructure", "Charges de travail" et "Services".

Remarque : Il est possible que l'option GKE ne s'affiche pas immédiatement dans les menus "Monitoring". L'activation des nouvelles fonctionnalités au niveau du cluster peut prendre entre cinq et dix minutes. Actualisez régulièrement la page jusqu'à ce que l'option apparaisse.

-

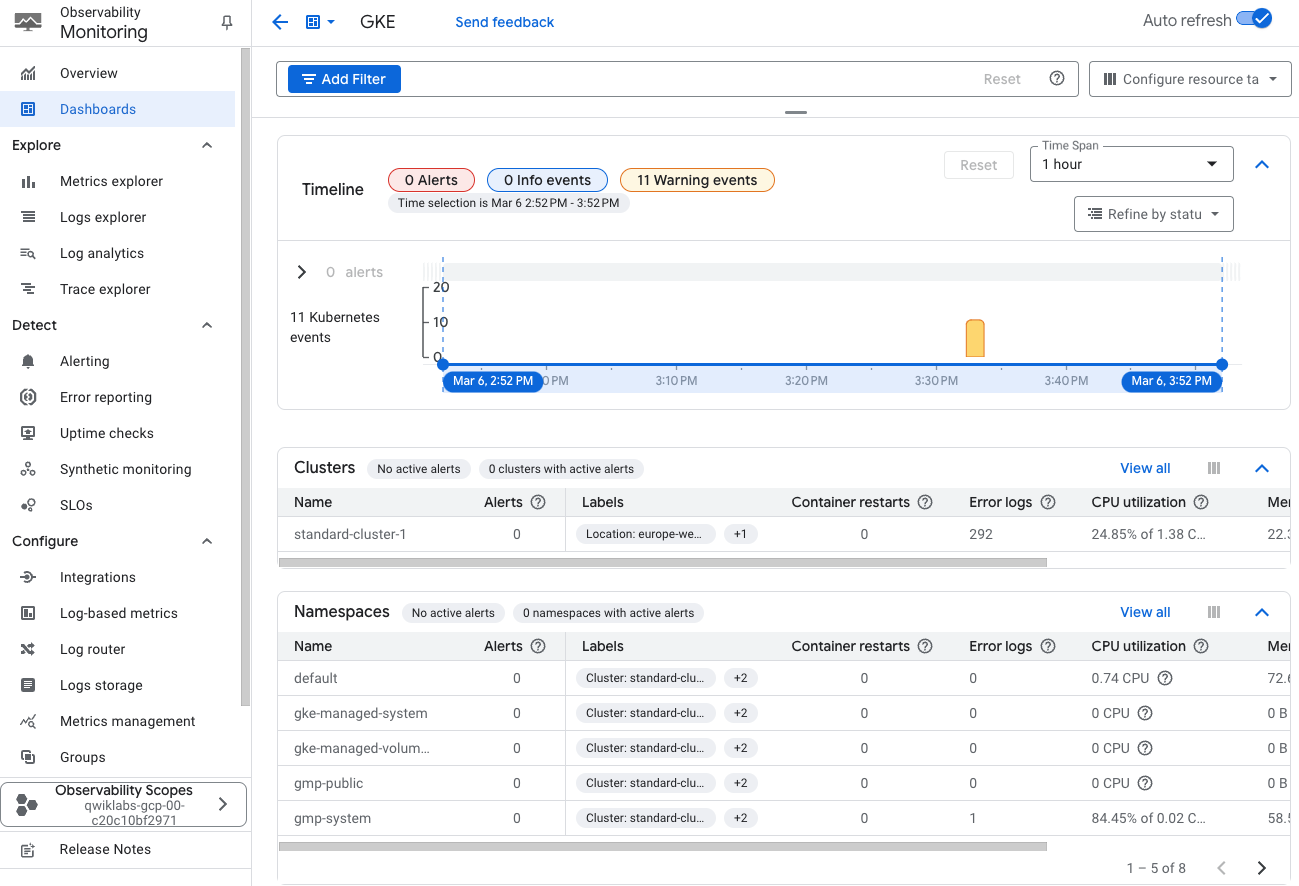

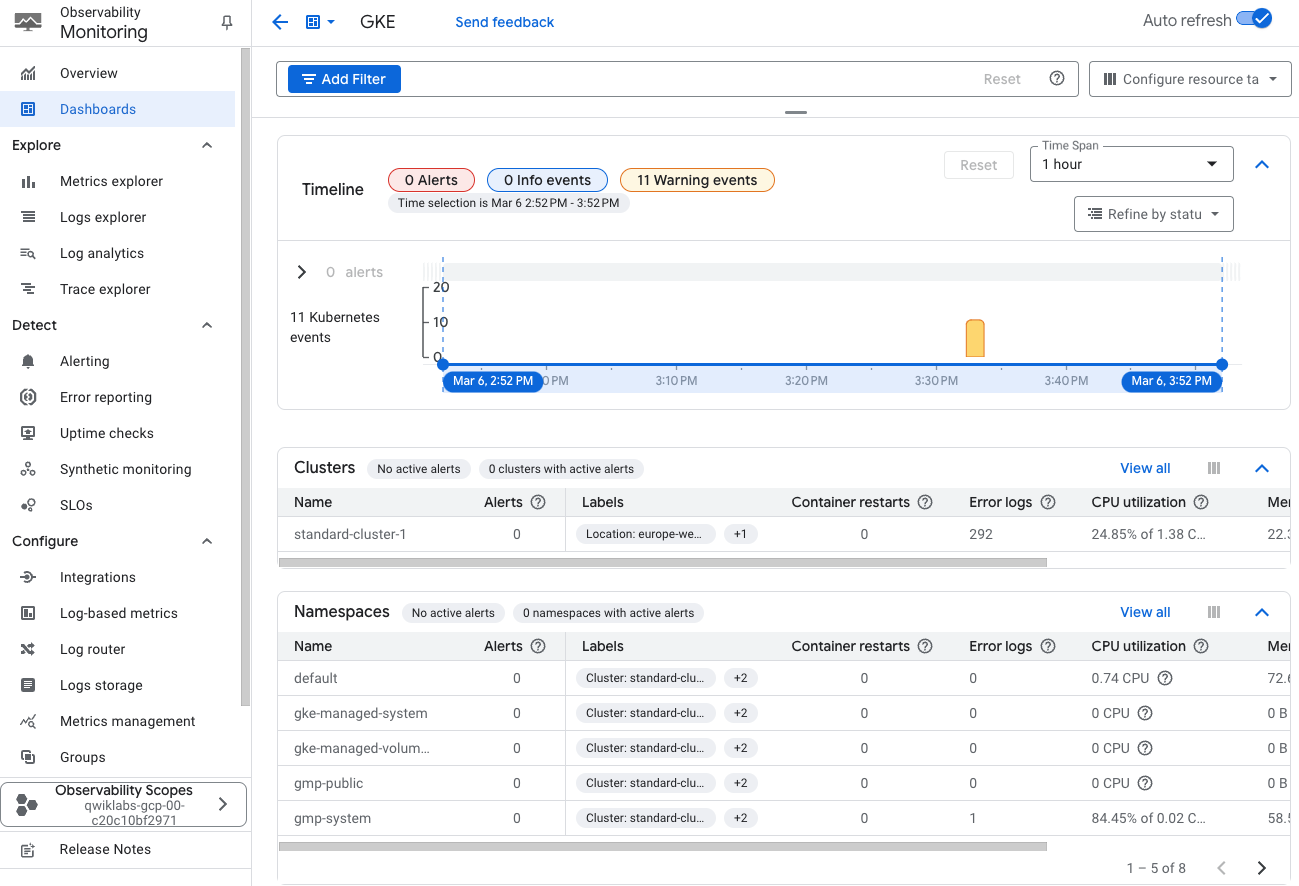

Dans la section Tableaux de bord de Monitoring, cliquez sur GKE pour afficher la nouvelle interface de surveillance.

-

Examinez l'interface de surveillance. Il s'agit d'un tableau de bord qui affiche l'état de vos clusters GKE et de leurs charges de travail. Veuillez noter les points suivants :

- La partie supérieure de l'interface comprend une frise chronologique dynamique. Si nécessaire, développez-la en cliquant sur la flèche déroulante. Vous pouvez ajuster la période en sélectionnant l'une des options situées en haut de l'écran : "1 h", "6 h", "1 j", "1 s", "1 m", "6 s" ou "Personnalisée". Cette chronologie inclut des repères indiquant les occurrences d'alertes (également appelées incidents).

- Bouton d'actualisation automatique (sur la gauche de l'écran) : cliquez sur le bouton Actualisation automatique pour autoriser la mise à jour de l'écran à mesure que de nouveaux événements sont reçus.

- La partie inférieure de ce tableau de bord contient plusieurs vues de vos clusters et de leurs charges de travail. L'interface est divisée en plusieurs sections : clusters, espaces de noms, nœuds, charges de travail, services Kubernetes, pods et conteneurs.

Examinez chaque section de l'interface :

-

Les sections Clusters, Nœuds et Pods vous permettent de vérifier l'état d'éléments spécifiques du cluster. Vous pouvez également consulter ces sections pour inspecter les pods en cours d'exécution sur un nœud particulier du cluster.

-

Pour afficher les détails de votre cluster, cliquez sur l'élément de cluster.

-

La section Charges de travail est très utile, en particulier pour les charges de travail pour lesquelles aucun service n'est exposé.

-

La section Services Kubernetes classe les services configurés dans votre environnement par cluster, puis par espace de noms (barrière administrative ou partition au sein du cluster). Elle affiche ensuite les différents services disponibles pour les utilisateurs dans cet espace de noms. Pour afficher plus de détails sur un service, cliquez sur son nom.

-

La section Espaces de noms affiche la liste des espaces de noms disponibles dans le cluster.

L'interface de surveillance peut fournir plus d'informations sur les déploiements et les pods.

- Dans la section Pods, cliquez sur le pod dont le nom commence par fluentbit-gke-xxxx (si nécessaire, cliquez sur

Tout afficher), puis sur l'onglet Métriques pour afficher d'autres métriques.

Notez la valeur correspondant à l'utilisation par votre pod des ressources de processeur demandées. Ce nombre représente la quantité de ressources de processeur consommée par le pod par rapport à la demande initiale du cluster.

-

Cliquez sur X en haut à droite de la fenêtre "Détails du pod".

-

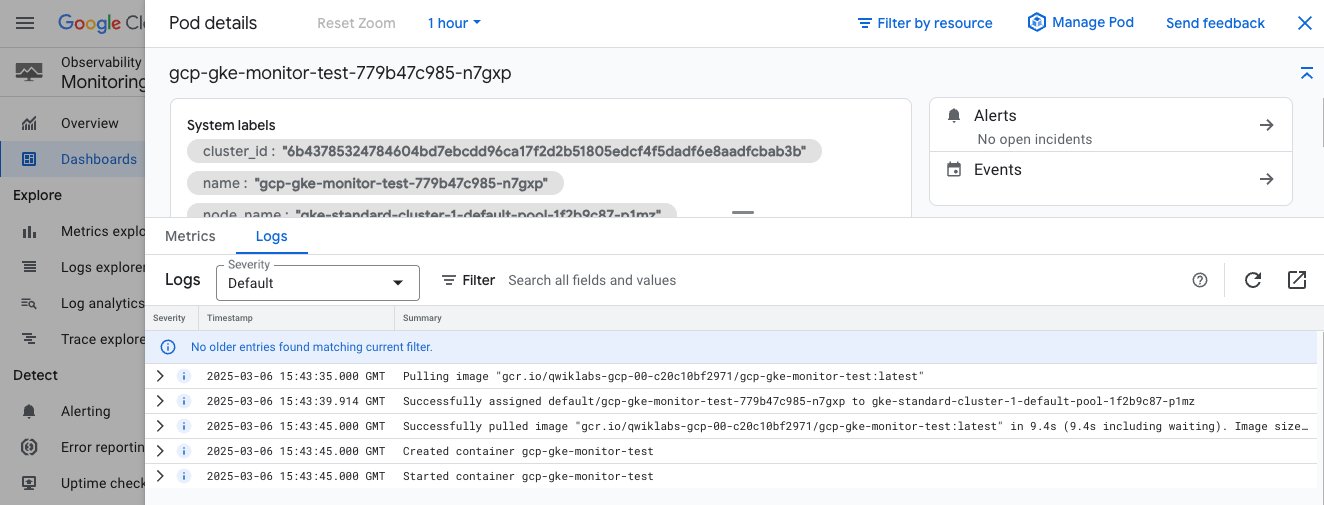

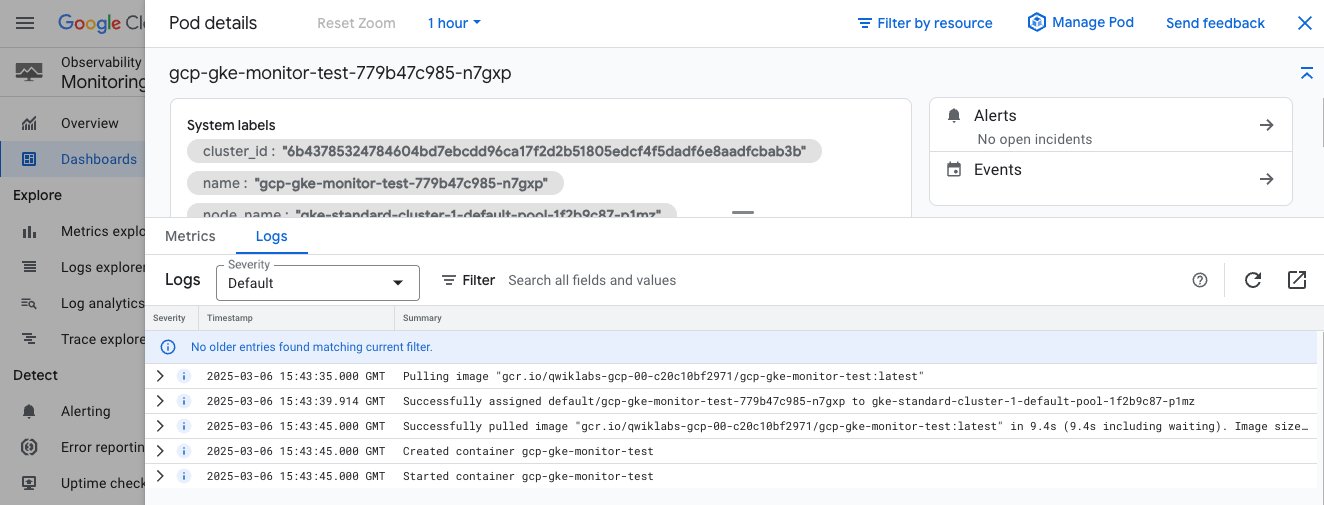

Ensuite, cliquez sur le pod dont le nom commence par gcp-gke-monitor-test pour obtenir plus d'informations sur celui-ci.

Notez que les informations affichées seront légèrement différentes si vous avez sélectionné les espaces de noms au lieu du pod.

-

Cliquez sur l'onglet Métriques pour afficher d'autres métriques telles que "Utilisation des ressources de processeur demandées" et "Durée d'utilisation du processeur".

-

Dans la fenêtre "Détails du pod", cliquez sur l'onglet Journaux afin de consulter l'activité du journal pour le pod.

Cet onglet affiche les messages de journal générés par le pod, ainsi qu'un graphique indiquant l'activité de journalisation du pod au fil du temps. Vous y trouverez quelques exemples de journaux que vous avez générés dans l'outil.

- Cliquez sur X en haut à droite de la fenêtre "Détails du pod" pour revenir à l'interface de Monitoring.

Créer un tableau de bord Monitoring personnalisé pour surveiller vos pods

Monitoring vous permet de créer des tableaux de bord personnalisés pour afficher des métriques importantes telles que l'utilisation du CPU, les redémarrages de conteneurs et notre métrique personnalisée indiquant le nombre d'utilisateurs connectés.

-

Dans la barre de navigation sur la gauche de la page "Observabilité Monitoring", cliquez sur Explorateur de métriques pour commencer à créer votre tableau de bord.

-

Cliquez sur Sélectionner une métrique.

Cette opération permet de filtrer la liste en fonction des types de ressources compatibles avec les nouveaux outils Kubernetes Engine Monitoring.

-

Sélectionnez Conteneur Kubernetes > Métriques populaires > Utilisation des ressources de processeur demandées.

-

Cliquez sur Appliquer.

Il s'agit du même graphique d'utilisation des ressources de processeur demandées que nous avons examiné précédemment pour le pod fluentbit-gke-xxxx, mais cette métrique est désormais affichée pour tous les pods.

-

Cliquez sur le bouton Enregistrer le graphique en haut à droite de l'écran.

-

Nommez le graphique (Ressources de CPU demandées pour le conteneur, par exemple), puis cliquez sur Tableau de bord.

Le nom ne doit désigner que ce graphique. Vous pourrez attribuer un nom pour l'ensemble du tableau de bord à l'étape suivante.

-

Cliquez sur Nouveau tableau de bord.

-

Nommez votre tableau de bord Tableau de bord du conteneur.

-

Cliquez sur Enregistrer le graphique.

-

Vous pouvez désormais lancer votre tableau de bord. Pour ce faire, cliquez sur Tableaux de bord dans le volet de navigation, puis sélectionnez le nom de votre nouveau tableau de bord.

Vous disposez désormais d'un tableau de bord affichant un seul graphique avec une métrique Monitoring standard. Vous allez ensuite créer un graphique pour notre métrique Monitoring personnalisée avant de l'ajouter à ce tableau de bord.

-

Cliquez sur Explorateur de métriques.

-

Cliquez sur Sélectionner une métrique.

-

Sélectionnez Pod Kubernetes > Métriques personnalisées > Application Web - Utilisateurs actifs.

-

Cliquez sur Appliquer.

-

Cliquez sur Enregistrer le graphique.

-

Attribuez un nom au nouveau graphique, Utilisateurs actifs par exemple.

-

Sélectionnez Tableau de bord du conteneur dans le menu déroulant des tableaux de bord.

-

Cliquez sur Enregistrer le graphique.

-

Accédez de nouveau au tableau de bord de votre conteneur, puis cliquez sur l'icône en forme de roue dentée pour afficher le menu des paramètres.

-

Cliquez ensuite sur Légendes > Tableau pour afficher le texte sous chaque graphique.

-

Cliquez sur les trois barres verticales à côté du terme Valeur à droite de chaque graphique.

Une pop-up s'affiche. Elle contient les différents libellés inclus dans les données timeSeries envoyées par notre serveur d'applications. Vous pouvez utiliser ces informations pour filtrer, voire agréger les données du graphique.

Tâche 4 : Créer des alertes avec Kubernetes Engine Monitoring

Dans cette tâche, vous allez configurer une alerte dans Kubernetes Engine Monitoring avant d'utiliser le tableau de bord pour identifier et traiter l'incident.

Créer une règle d'alerte

Vous allez maintenant créer une règle d'alerte permettant de détecter une utilisation élevée du processeur par les conteneurs.

- Dans le menu de navigation de Cloud Console, sélectionnez Monitoring > Alertes.

- Cliquez sur + Créer une règle.

- Déroulez le menu Sélectionner une métrique.

- Décochez l'option Active.

- Saisissez Conteneur Kubernetes dans "Filtrer par nom de ressource ou de métrique".

- Cliquez sur Conteneur Kubernetes > Conteneur.

- Sélectionnez Utilisation des ressources de processeur demandées.

- Cliquez sur Appliquer.

Remarque : Si vous ne trouvez pas le type de ressource Conteneur Kubernetes, il peut être nécessaire d'actualiser la page.

- Définissez la Fenêtre glissante sur "1 min".

- Cliquez sur Suivant.

- Définissez la position du seuil sur Au-dessus du seuil.

- Indiquez 0,99 comme valeur de seuil.

- Cliquez sur Suivant.

Configurer les notifications et finaliser la règle d'alerte

-

Cliquez sur la flèche du menu déroulant à côté de Canaux de notification, puis sur Gérer les canaux de notification. Une page Canaux de notification s'ouvre alors dans un nouvel onglet.

-

Faites défiler l'écran vers le bas, puis cliquez sur le bouton AJOUTER associé à Adresse e-mail.

-

Saisissez votre adresse e-mail personnelle dans le champ Adresse e-mail et renseignez le champ Nom à afficher.

-

Cliquez sur Save (Enregistrer).

-

Revenez à l'onglet Create alerting policy (Créer une règle d'alerte) précédent.

-

Cliquez de nouveau sur Notification Channels (Canaux de notification), puis sur l'icône Refresh (Actualiser) pour obtenir le nom à afficher que vous avez indiqué à l'étape précédente. Cliquez de nouveau sur Canaux de notification si nécessaire.

-

Sélectionnez ensuite votre nom à afficher, puis cliquez sur OK.

-

Nommez l'alerte Utilisation des ressources de processeur demandées.

-

Cliquez sur Suivant.

-

Examinez l'alerte et cliquez sur Créer une règle.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Créer des alertes avec Kubernetes Engine Monitoring

Répondre à un incident

Vous allez maintenant revenir au tableau de bord de surveillance qui signale un incident sur l'un des conteneurs.

- Sur la page "Observabilité Monitoring", sélectionnez Présentation > GKE.

Dans le tableau de bord de Kubernetes Engine Monitoring, vous devriez constater qu'un incident a été signalé sur le conteneur.

- Dans l'onglet Conteneurs, cliquez sur le nom du conteneur auquel l'alerte est associée.

L'enregistrement de l'alerte peut prendre une ou deux minutes. Vous devrez peut-être actualiser la page pour la voir.

- Accédez à la page Alertes.

- Cliquez sur le nom de l'alerte Utilisation des ressources de processeur demandées pour afficher des détails supplémentaires.

- Ouvrez l'incident et cliquez sur Résumé des incidents,

- puis sur Confirmer un incident.

L'état de l'incident indique "Confirmé", mais cela ne permet pas de résoudre le problème. Vous devez corriger la cause première du problème, autrement dit le conteneur du générateur de charge de processeur.

- Ouvrez l'interface Web de l'outil GCP-GKE-Monitor-Test.

- Dans la section Generate CPU Load (Générer une charge de processeur), cliquez sur le bouton Stop CPU Load (Arrêter la charge du processeur) pour résoudre le problème (le générateur de charge de processeur s'arrête alors).

- Vous pouvez maintenant fermer la fenêtre du navigateur Web qui affiche GCP-GKE-Monitor-Test.

Terminer l'atelier

Une fois l'atelier terminé, cliquez sur Terminer l'atelier. Google Cloud Skills Boost supprime les ressources que vous avez utilisées, puis efface le compte.

Si vous le souhaitez, vous pouvez noter l'atelier. Sélectionnez un nombre d'étoiles, saisissez un commentaire, puis cliquez sur Envoyer.

Le nombre d'étoiles correspond à votre degré de satisfaction :

- 1 étoile = très insatisfait(e)

- 2 étoiles = insatisfait(e)

- 3 étoiles = ni insatisfait(e), ni satisfait(e)

- 4 étoiles = satisfait(e)

- 5 étoiles = très satisfait(e)

Si vous ne souhaitez pas donner votre avis, vous pouvez fermer la boîte de dialogue.

Pour soumettre des commentaires, suggestions ou corrections, veuillez accéder à l'onglet Assistance.

Copyright 2020 Google LLC Tous droits réservés. Google et le logo Google sont des marques de Google LLC. Tous les autres noms d'entreprises et de produits peuvent être des marques des entreprises auxquelles ils sont associés.

) de la console Google Cloud, cliquez sur Kubernetes Engine > Clusters.

) de la console Google Cloud, cliquez sur Kubernetes Engine > Clusters.