Descripción general

En este lab, crearás un clúster de GKE y luego implementarás Pods para usarlos con Kubernetes Engine Monitoring. Crearás gráficos y un panel personalizado, trabajarás con métricas personalizadas, y crearás alertas y responderás a ellas.

Nota: En este lab, se usará el modo estándar de GKE. En el lab, se explorarán los registros y la supervisión del sistema, que están habilitados de forma predeterminada en GKE Autopilot.

Objetivos

En este lab, aprenderás a realizar las siguientes tareas:

- Usar Kubernetes Engine Monitoring para consultar las métricas de clústeres y cargas de trabajo

- Usar alertas de Cloud Monitoring para recibir notificaciones sobre el estado del clúster

Configuración del lab

Accede a Qwiklabs

En cada lab, recibirás un proyecto de Google Cloud y un conjunto de recursos nuevos por tiempo limitado y sin costo adicional.

-

Haz clic en el botón Comenzar lab. Si debes pagar por el lab, se abrirá una ventana emergente para que selecciones tu forma de pago.

A la izquierda, se encuentra el panel Detalles del lab, que tiene estos elementos:

- El botón Abrir la consola de Google Cloud

- El tiempo restante

- Las credenciales temporales que debes usar para el lab

- Otra información para completar el lab, si es necesaria

-

Haz clic en Abrir la consola de Google Cloud (o haz clic con el botón derecho y selecciona Abrir el vínculo en una ventana de incógnito si ejecutas el navegador Chrome).

El lab inicia recursos y abre otra pestaña en la que se muestra la página de acceso.

Sugerencia: Ordena las pestañas en ventanas separadas, una junto a la otra.

Nota: Si ves el diálogo Elegir una cuenta, haz clic en Usar otra cuenta.

-

De ser necesario, copia el nombre de usuario a continuación y pégalo en el diálogo Acceder.

{{{user_0.username | "Username"}}}

También puedes encontrar el nombre de usuario en el panel Detalles del lab.

-

Haz clic en Siguiente.

-

Copia la contraseña que aparece a continuación y pégala en el diálogo Te damos la bienvenida.

{{{user_0.password | "Password"}}}

También puedes encontrar la contraseña en el panel Detalles del lab.

-

Haz clic en Siguiente.

Importante: Debes usar las credenciales que te proporciona el lab. No uses las credenciales de tu cuenta de Google Cloud.

Nota: Usar tu propia cuenta de Google Cloud para este lab podría generar cargos adicionales.

-

Haga clic para avanzar por las páginas siguientes:

- Acepta los Términos y Condiciones.

- No agregues opciones de recuperación o autenticación de dos factores (esta es una cuenta temporal).

- No te registres para obtener pruebas gratuitas.

Después de un momento, se abrirá la consola de Google Cloud en esta pestaña.

Nota: Para ver un menú con una lista de productos y servicios de Google Cloud, haz clic en el menú de navegación que se encuentra en la parte superior izquierda o escribe el nombre del servicio o producto en el campo Búsqueda.

Activa Google Cloud Shell

Google Cloud Shell es una máquina virtual que cuenta con herramientas para desarrolladores. Ofrece un directorio principal persistente de 5 GB y se ejecuta en Google Cloud.

Google Cloud Shell proporciona acceso de línea de comandos a tus recursos de Google Cloud.

-

En la consola de Cloud, en la barra de herramientas superior derecha, haz clic en el botón Abrir Cloud Shell.

-

Haz clic en Continuar.

El aprovisionamiento y la conexión al entorno demorarán unos minutos. Cuando te conectes, habrás completado la autenticación, y el proyecto estará configurado con tu PROJECT_ID. Por ejemplo:

gcloud es la herramienta de línea de comandos de Google Cloud. Viene preinstalada en Cloud Shell y es compatible con el completado de línea de comando.

- Puedes solicitar el nombre de la cuenta activa con este comando:

gcloud auth list

Resultado:

Credentialed accounts:

- @.com (active)

Resultado de ejemplo:

Credentialed accounts:

- google1623327_student@qwiklabs.net

- Puedes solicitar el ID del proyecto con este comando:

gcloud config list project

Resultado:

[core]

project =

Resultado de ejemplo:

[core]

project = qwiklabs-gcp-44776a13dea667a6

Nota:

La documentación completa de gcloud está disponible en la

guía de descripción general de gcloud CLI

.

Tarea 1. Usa Kubernetes Engine Monitoring

Google Kubernetes Engine incluye asistencia administrada para Monitoring.

En esta tarea, crearás un clúster nuevo con la asistencia de Kubernetes Engine Monitoring y, luego, realizarás tareas típicas de supervisión con la interfaz de supervisión y registro de Kubernetes Engine.

Configura un clúster de GKE con Kubernetes Engine Monitoring

En esta tarea, crearás un clúster de GKE con Kubernetes Engine Monitoring habilitado. Luego, implementarás las cargas de trabajo de muestra en tu clúster de GKE para usarlas más adelante en este ejercicio.

- En Cloud Shell, escribe el siguiente comando si quieres crear variables de entorno para el nombre del clúster y la zona de Google Cloud que se usarán en la creación del clúster de este lab:

export my_zone={{{ project_0.default_zone| "Zone" }}}

export my_cluster=standard-cluster-1

- Configura el completado de línea de comando para la herramienta de línea de comandos de kubectl:

source <(kubectl completion bash)

- Crea un clúster de Kubernetes nativo de la VPC con la función nativa de supervisión para Kubernetes habilitada:

gcloud container clusters create $my_cluster \

--num-nodes 3 --enable-ip-alias --zone $my_zone \

--logging=SYSTEM \

--monitoring=SYSTEM

Nota: Deberás esperar unos minutos para que se complete la implementación del clúster.

- Configura el acceso al clúster para kubectl:

gcloud container clusters get-credentials $my_cluster --zone $my_zone

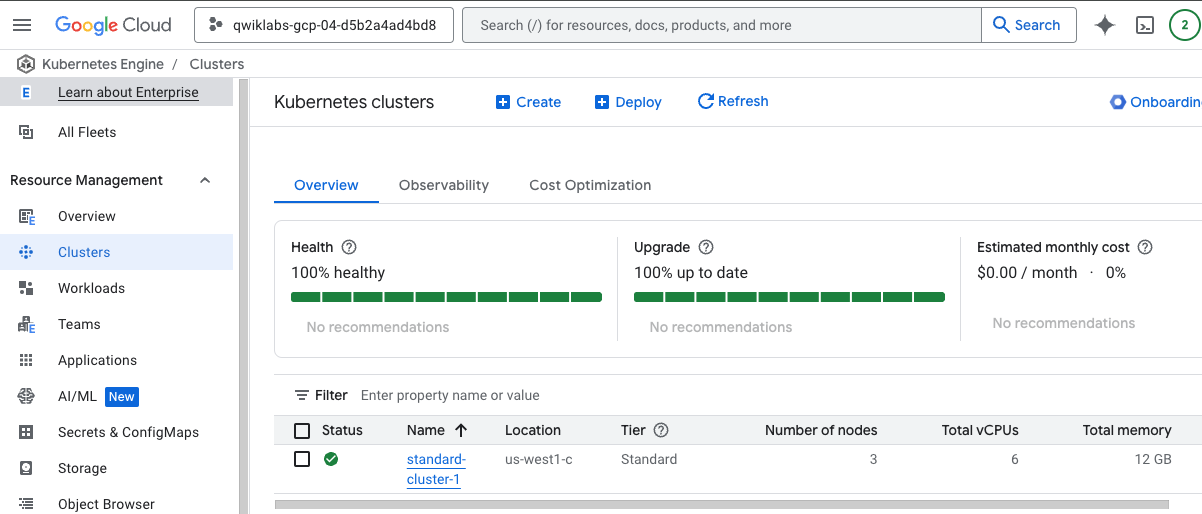

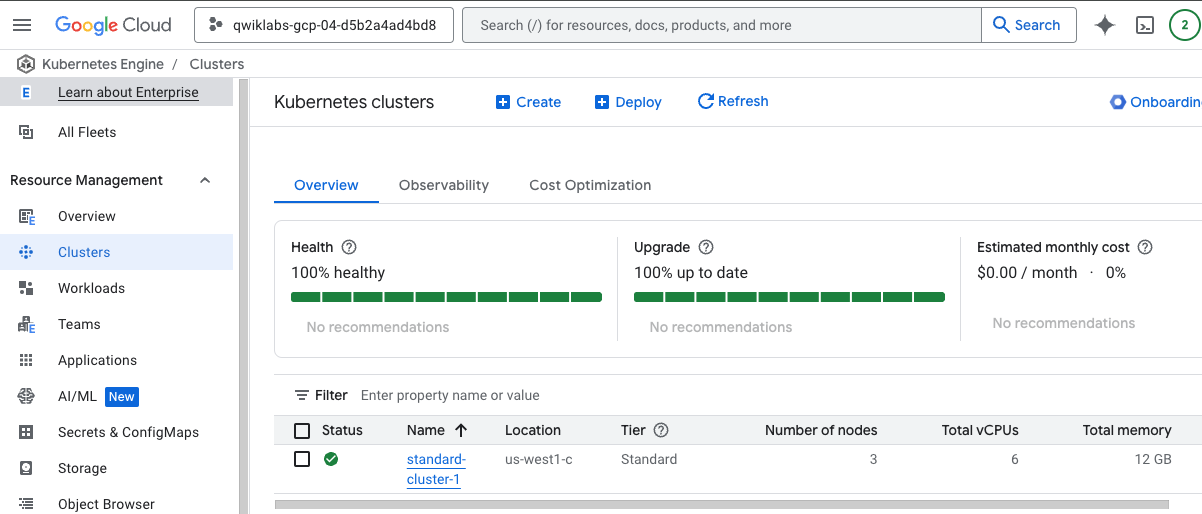

Usa la consola de Google Cloud para verificar la configuración de la supervisión

-

En la consola de Google Cloud, en el menú de navegación ( ), haz clic en Kubernetes Engine > Clústeres.

), haz clic en Kubernetes Engine > Clústeres.

-

Haz clic en el nombre del clúster standard-cluster-1 para consultar sus detalles.

Puedes desplazarte hacia abajo por la página para ver más detalles.

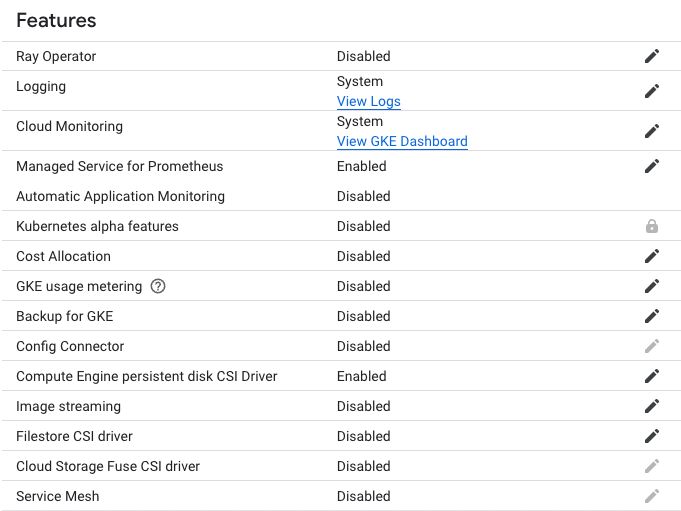

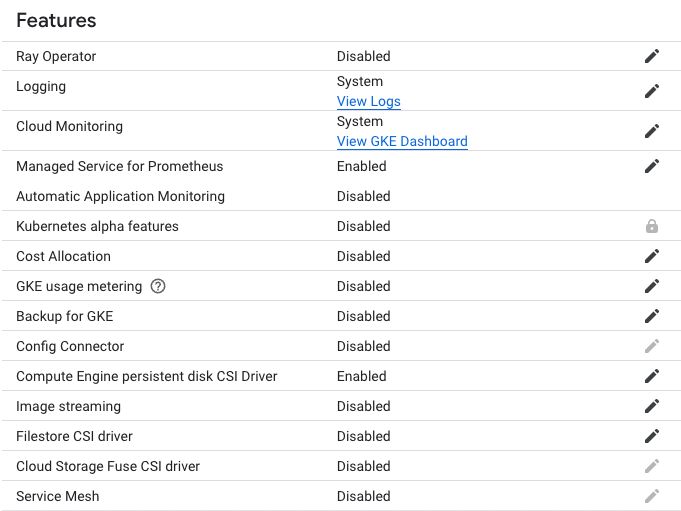

En la sección Funciones, puedes ver la configuración de Logging y Cloud Monitoring, que establece el tipo de registro en Sistema.

Implementa una carga de trabajo de muestra en tu clúster de GKE

Ahora implementarás una carga de trabajo de muestra en el espacio de nombres predeterminado de tu clúster de GKE. Esta carga de trabajo consiste en un objeto Deployment de tres Pods que ejecutan una aplicación de demostración Hello World simple. Más adelante en este ejercicio del lab, podrás supervisar el estado de esta carga de trabajo en Monitoring.

- En Cloud Shell, ingresa el siguiente comando para clonar el repositorio del lab en el entorno de Cloud Shell del lab:

git clone https://github.com/GoogleCloudPlatform/training-data-analyst

- Crea un vínculo simbólico como un acceso directo al directorio de trabajo:

ln -s ~/training-data-analyst/courses/ak8s/v1.1 ~/ak8s

- Cambia al directorio que contenga los archivos de muestra de este lab:

cd ~/ak8s/Monitoring/

- En Cloud Shell, ejecuta el siguiente comando para implementar un manifiesto que cree una implementación de muestra. Esta proporcionará algunos elementos que supervisarás más adelante en este ejercicio del lab con Monitoring:

kubectl create -f hello-v2.yaml

Este manifiesto de implementación crea tres Pods que ejecutan una aplicación de demostración Hello World simple.

- En Cloud Shell, ejecuta el siguiente comando para verificar que exista la implementación:

kubectl get deployments

El resultado de este comando mostrará que la aplicación hello-v2 se esté ejecutando en el espacio de nombres predeterminado:

NAME READY UP-TO-DATE AVAILABLE AGE

hello-v2 3/3 3 3 6s

Haz clic en Revisar mi progreso para verificar el objetivo.

Configurar un clúster de GKE con Kubernetes Engine Monitoring e implementar una carga de trabajo de muestra

Implementa la aplicación GCP-GKE-Monitor-Test

Ahora implementarás la aplicación GCP-GKE-Monitor-Test en el espacio de nombres predeterminado de tu clúster de GKE. Esta carga de trabajo tiene un Deployment que consiste en un solo Pod, que luego se expone a Internet a través de un servicio LoadBalancer.

- En Cloud Shell, ejecuta el siguiente comando para almacenar el ID del proyecto actual en una variable de entorno:

export PROJECT_ID="$(gcloud config get-value project -q)"

- En Cloud Shell, ejecuta el siguiente comando para cambiar al directorio de la aplicación de carga:

cd gcp-gke-monitor-test

- En Cloud Shell, ejecuta el siguiente comando para compilar la imagen de Docker correspondiente a la aplicación de prueba de carga y enviar la imagen al registro gcr.io de Google de tu proyecto del lab:

gcloud builds submit --tag=gcr.io/$PROJECT_ID/gcp-gke-monitor-test .

De forma alternativa, puedes usar Docker directamente para compilar y enviar una imagen a gcr.io.

docker build -t gcr.io/${PROJECT_ID}/gcp-gke-monitor-test .

- En Cloud Shell, ejecuta el siguiente comando para volver al directorio de trabajo principal del lab:

cd ..

- En Cloud Shell, ejecuta el siguiente comando para reemplazar un valor de marcador de posición en el archivo

gcp-gke-monitor-test.yaml por la imagen de Docker que acabas de enviar a gcr.io:

sed -i "s/\[DOCKER-IMAGE\]/gcr\.io\/${PROJECT_ID}\/gcp-gke-monitor-test\:latest/" gcp-gke-monitor-test.yaml

Nota:

El comando sed en UNIX significa editor de transmisiones y puede realizar muchas funciones en los archivos, como reemplazar, insertar o borrar. Sin embargo, el uso más común de sed es la función de sustitución.

Con sed, puedes editar archivos incluso sin abrirlos, que es una forma mucho más rápida de encontrar y reemplazar el contenido de un archivo en lugar de abrirlo primero en un editor y, luego, modificarlo.

- En Cloud Shell, ingresa el siguiente comando para implementar el manifiesto que acabas de actualizar y así crear los objetos Deployment y Service que usarás para probar Kubernetes Engine Monitoring:

kubectl create -f gcp-gke-monitor-test.yaml

- En Cloud Shell, ejecuta el siguiente comando para verificar que exista la implementación:

kubectl get deployments

El resultado de este comando mostrará que la aplicación hello-v2 se esté ejecutando en el espacio de nombres predeterminado:

NAME READY UP-TO-DATE AVAIL AGE

gcp-gke-monitor-test 1/1 1 0 1s

hello-v2 3/3 3 3 38s

- En Cloud Shell, ejecuta el siguiente comando para verificar que exista el servicio:

kubectl get service

El resultado de este comando mostrará que gcp-gke-monitor-test-service se está ejecutando en el espacio de nombres predeterminado. Es posible que debas ejecutar este comando varias veces hasta que se asigne una dirección IP externa a este Service.

Haz clic en Revisar mi progreso para verificar el objetivo.

Implementar la aplicación GCP-GKE-Monitor-Test

Tarea 2. Usa la aplicación GCP-GKE-Monitor-Test

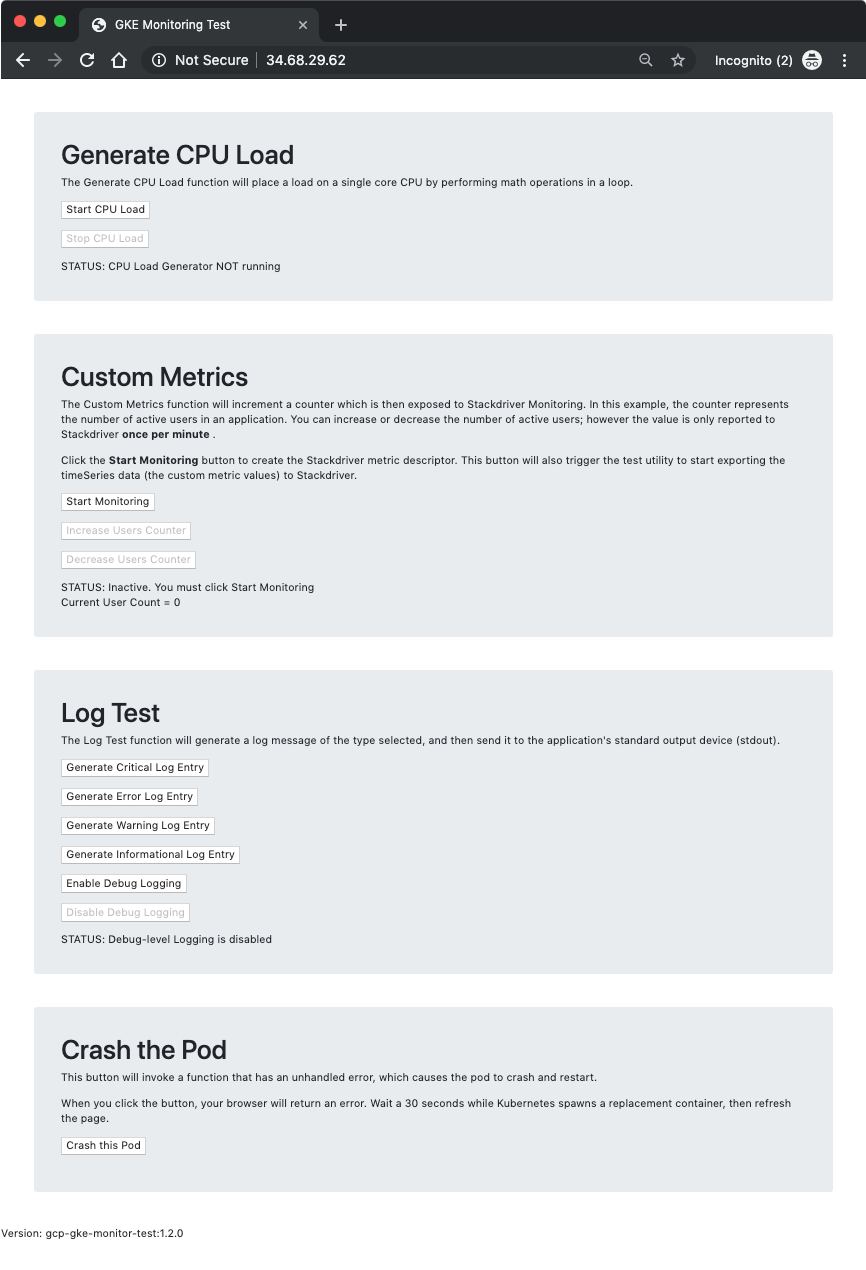

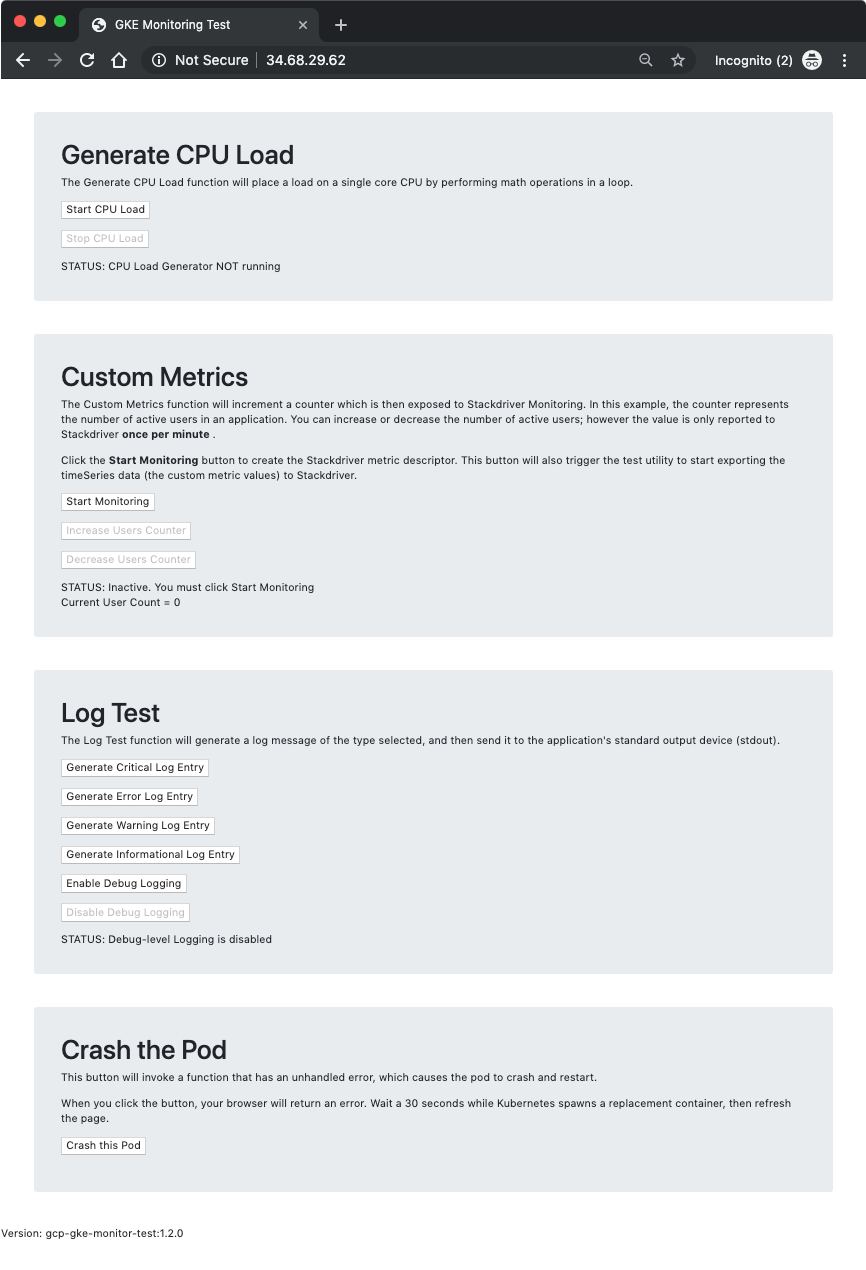

En esta tarea, usarás la aplicación GCP‑GKE‑Monitor‑Test para explorar diferentes aspectos de Kubernetes Engine Monitoring. La herramienta se compone de cuatro secciones:

- Generate CPU Load

- Custom Metrics

- Log Test

- Crash the Pod

En la primera sección, Generate CPU Load, tienes botones para iniciar y detener un generador de cargas de CPU. La herramienta inicia un bucle de operaciones matemáticas que consumirán un núcleo de CPU completo. Para evitar perder el control del Pod debido a la saturación de la CPU, el bucle suspende el procesador de forma periódica durante 100 nanosegundos. Esto te permite detener rápidamente el generador de cargas de CPU sin destruir el Pod.

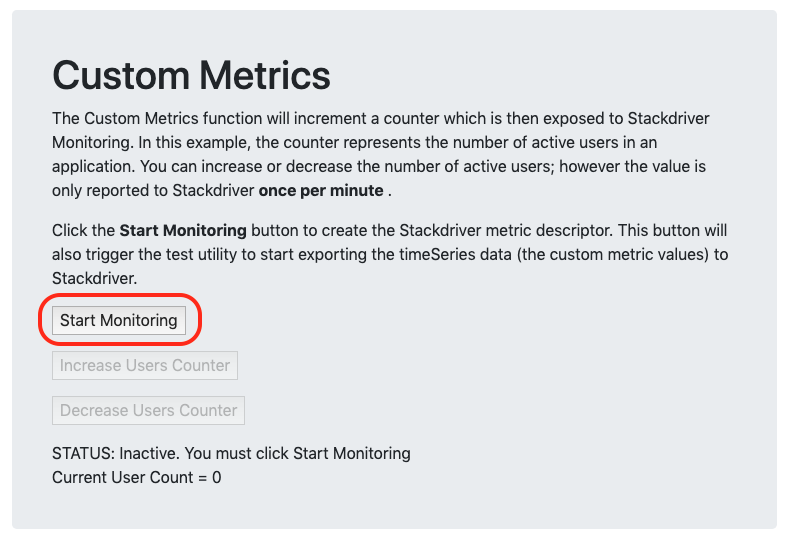

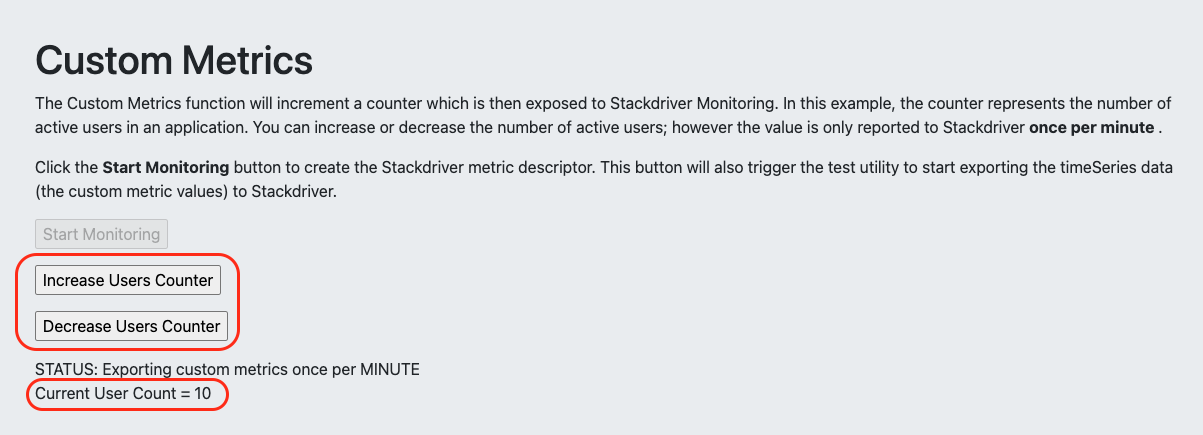

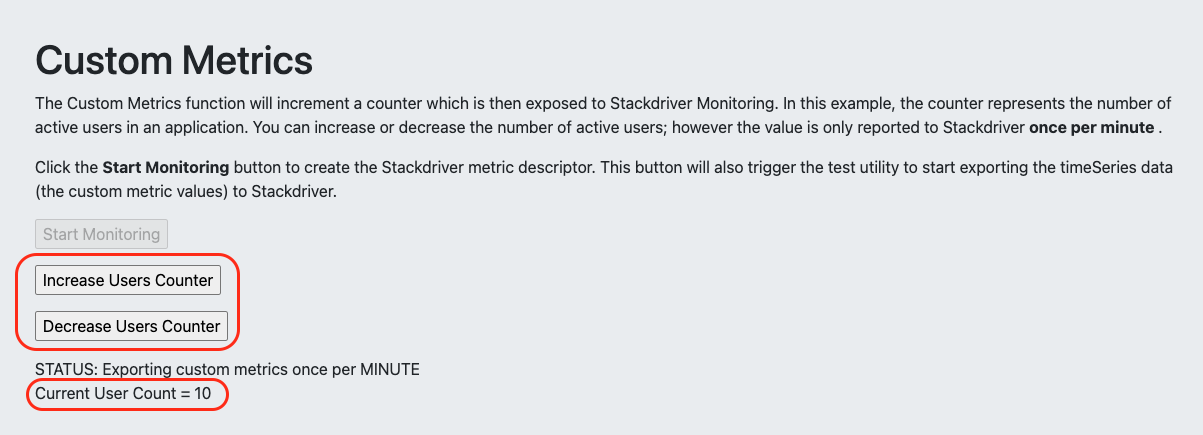

La segunda sección, Custom Metrics, te permite explorar la supervisión de métricas personalizadas en Cloud Monitoring. Cuando haces clic en Start Monitoring, la herramienta primero crea el descriptor de métrica personalizada necesario y luego inicia un bucle que envía los valores de la métrica personalizada a Monitoring cada 60 segundos. Las métricas personalizadas codificadas en esta herramienta están diseñadas para simular una aplicación que puede llevar un registro de la cantidad de usuarios activos conectados y luego informar ese número a un Service externo.

Para aprovechar estas métricas personalizadas, es posible que se requiera instrumentación adicional en el código de tu aplicación. En este ejercicio del lab, puedes hacer clic en los botones Increase Users y Decrease Users para simular que los usuarios se conectan y desconectan.

Además, ten en cuenta que, aunque la herramienta web te permitirá cambiar la cantidad de usuarios en tiempo real (tal como los usuarios pueden conectarse y desconectarse en la realidad), las API de Cloud Monitoring solo permiten que la herramienta envíe su valor actual una vez por minuto. Esto significa que tus gráficos de Cloud Monitoring no reflejarán los cambios que se produzcan entre las actualizaciones por minuto.

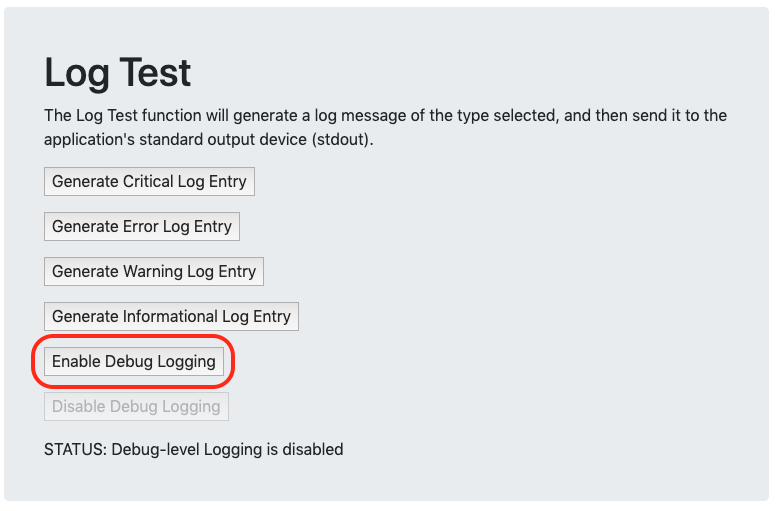

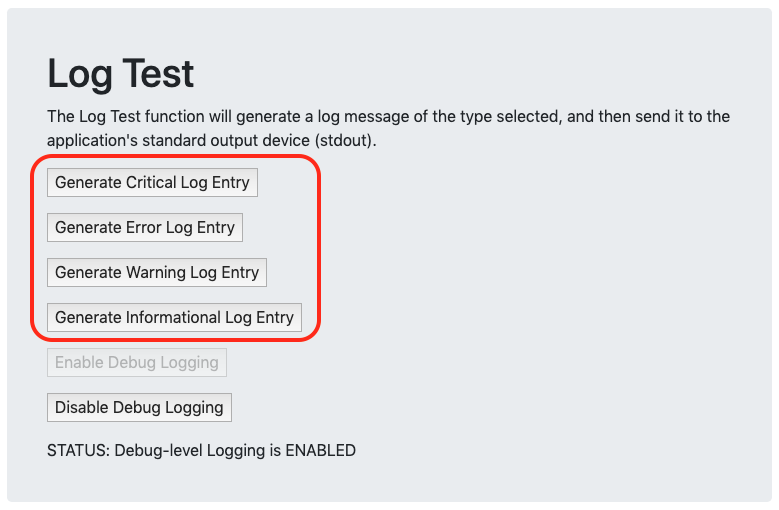

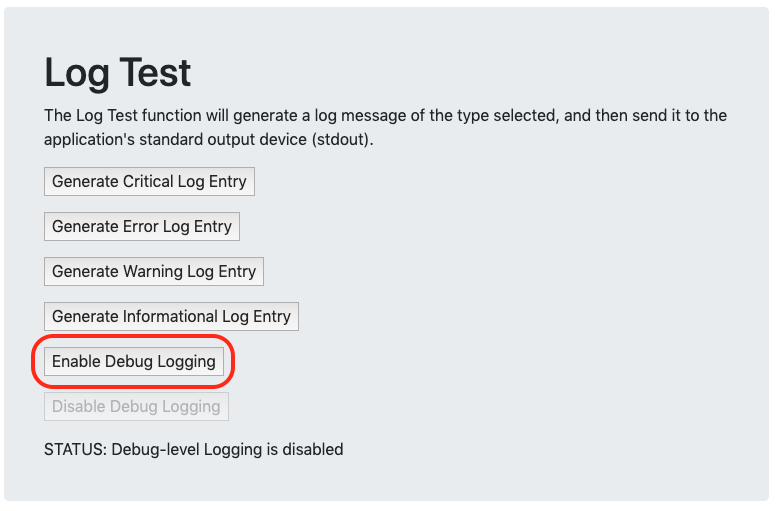

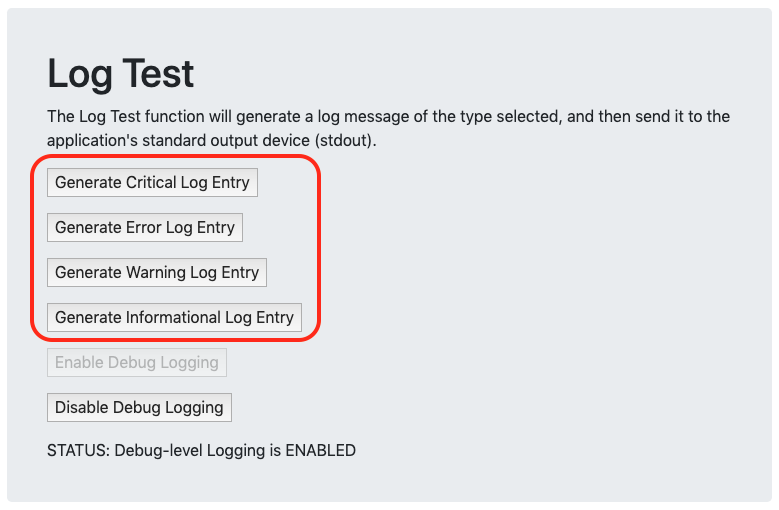

La tercera sección, Log Test, te permite enviar diferentes strings de texto a la salida estándar del contenedor (la consola), que luego recopila Cloud Monitoring de forma periódica, y se almacena como mensajes de registro asociados al Pod y al contenedor. Opcionalmente, puedes habilitar el registro de nivel de depuración para ver más entradas en los registros. Esto te permitirá ver los mensajes en los registros cuando aumentes la cantidad de usuarios en la sección Custom Metrics o cuando habilites o inhabilites el generador de cargas de CPU. Ten en cuenta que estos registros se envían en texto sin formato para simular las aplicaciones heredadas que no admiten mensajes en formato JSON. Cuando consultes los registros en Logging, notarás que los de eventos de Kubernetes basados en JSON de tu Pod tienen opciones de filtrado y consulta mucho más sólidas que las disponibles para los registros no estructurados.

La cuarta y última sección, Crash the Pod, te permite generar una falla en el Pod con solo hacer clic en un botón. La herramienta ejecuta una sección de código con un error no controlado, que genera una falla en el Pod y activa el Deployment para reiniciar un Pod nuevo en su lugar. Puedes usar esta herramienta para ver con qué rapidez se puede recuperar Kubernetes Engine de errores. También es una oportunidad para ver la pérdida del estado de la sesión en acción, ya que cada Pod mantiene su propia sesión en lugar de almacenarla en una ubicación central. Cuando se reinicia el Pod, todos sus botones de activación y parámetros de configuración vuelven a sus valores predeterminados.

Inicia el generador de cargas de CPU

Ahora abrirás un navegador web, te conectarás a la herramienta GCP‑GKE‑Monitor‑Test y, luego, iniciarás el generador de cargas de CPU.

- En Cloud Shell, ingresa el siguiente comando para obtener la dirección IP externa de gcp-gke-monitor-test-service:

kubectl get service

- Abre tu navegador web y navega a la dirección IP externa del Service.

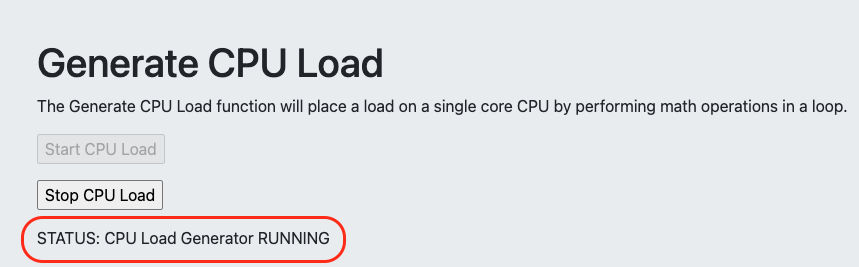

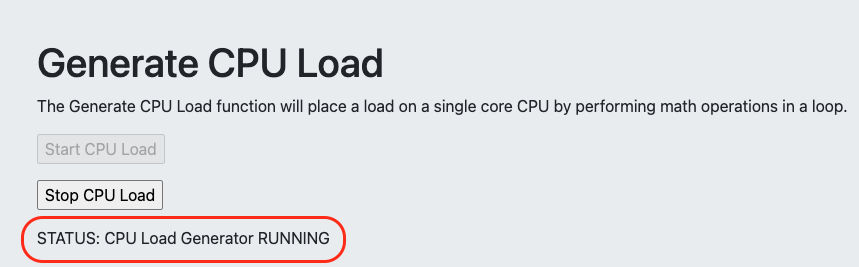

- En la sección Generate CPU Load, haz clic en el botón Start CPU Load. Ten en cuenta que el texto STATUS cambiará cuando se ejecute el generador de cargas.

Comienza a recopilar métricas personalizadas

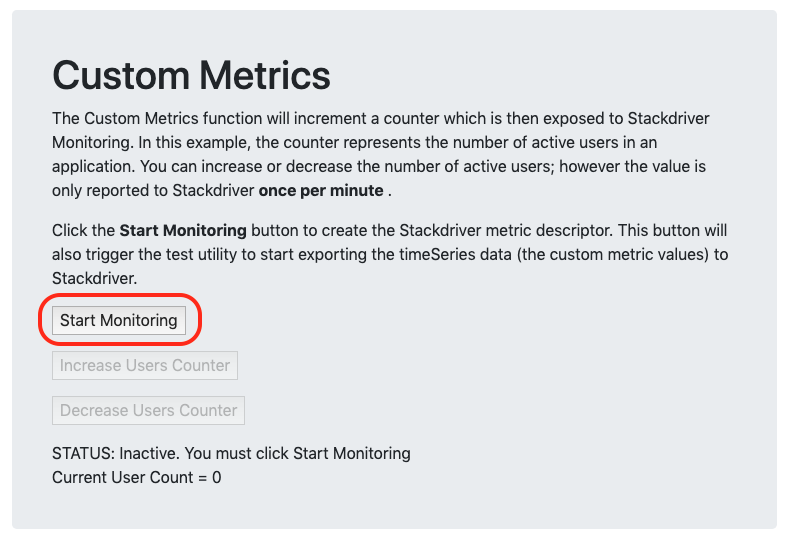

Ahora iniciarás un proceso dentro de la herramienta GCP-GKE-Monitor-Test que creará un descriptor de métrica personalizada dentro de Cloud Monitoring. Más adelante, cuando la herramienta comience a enviar datos de métricas personalizadas, Monitoring asociará los datos con este descriptor de métrica. Ten en cuenta que, a menudo, Monitoring puede crear automáticamente los descriptores de métricas personalizadas cuando recibe los datos de ese tipo de métrica. Sin embargo, si creas el descriptor de forma manual, tendrás más control sobre el texto que aparece en la interfaz de Monitoring, lo que te permitirá encontrar fácilmente tus datos en el Explorador de métricas.

- En la herramienta GCP-GKE-Monitor-Test, en la sección Custom Metrics, haz clic en el botón Start Monitoring.

Ahora puedes hacer clic en los botones Increase Users y Decrease Users para cambiar el recuento actual de usuarios que se muestra debajo del texto STATUS.

- Haz clic en Increase Users Counter y repite esta acción hasta que la opción Current User Count se establezca en 10 usuarios.

El primer dato puede tardar de 2 a 3 minutos en aparecer en Monitoring. Verificarás esta métrica personalizada en Cloud Monitoring más adelante.

Genera mensajes de registro de prueba

Ahora usarás la herramienta GCP-GKE-Monitor-Test para crear registros de muestra basados en texto que consultarás más adelante en Cloud Monitoring.

- En la herramienta GCP-GKE-Monitor-Test, en la sección Log Test, haz clic en el botón Enable Debug Logging para aumentar la cantidad de registros que genera la herramienta.

- Haz clic en los otros cuatro botones de entrada de registro para generar algunos mensajes de registro de muestra adicionales. Es importante seleccionar varios niveles de gravedad para que puedas ver cómo se muestran los diferentes tipos de mensajes en Monitoring.

Tarea 3. Usa Kubernetes Engine Monitoring

En esta tarea, usarás Kubernetes Engine Monitoring para consultar el estado actual de tu clúster de GKE y las dos cargas de trabajo que se ejecutan en él.

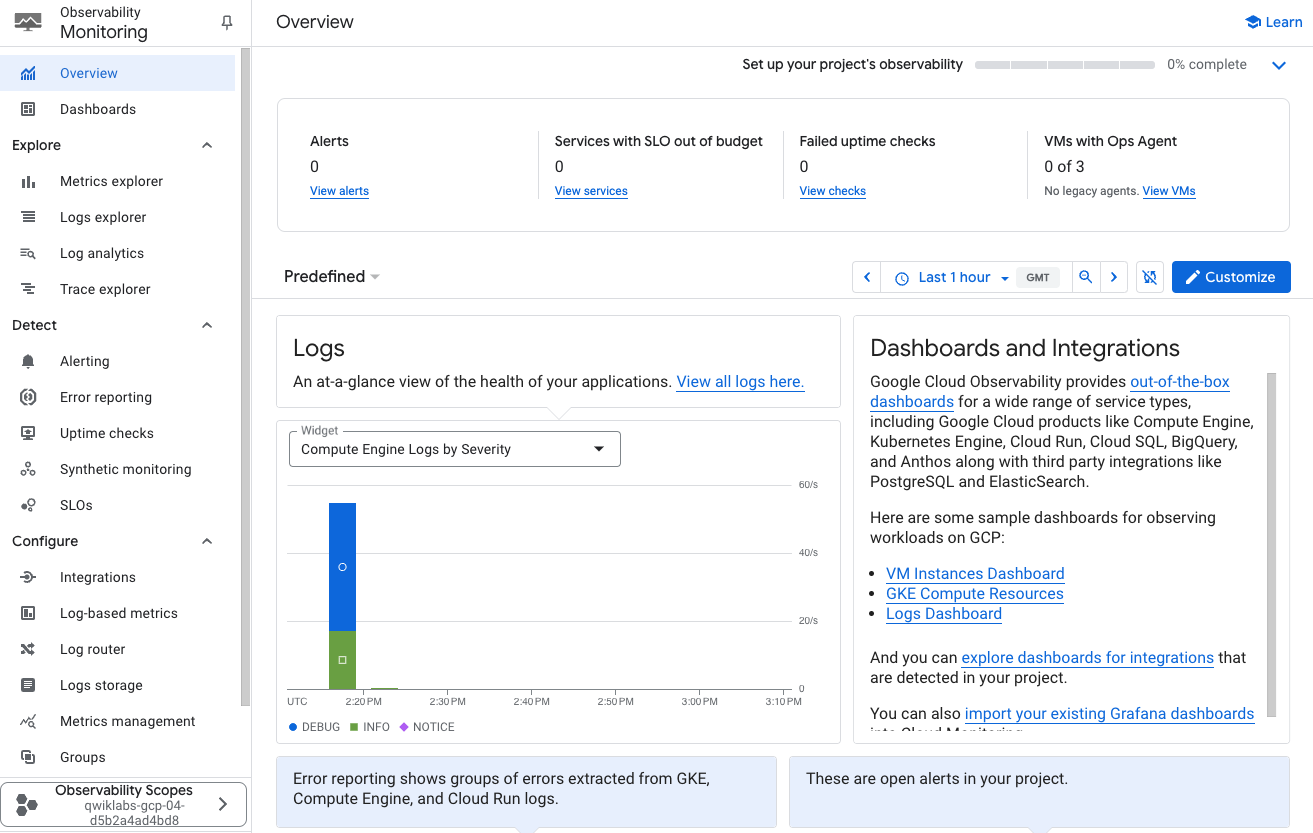

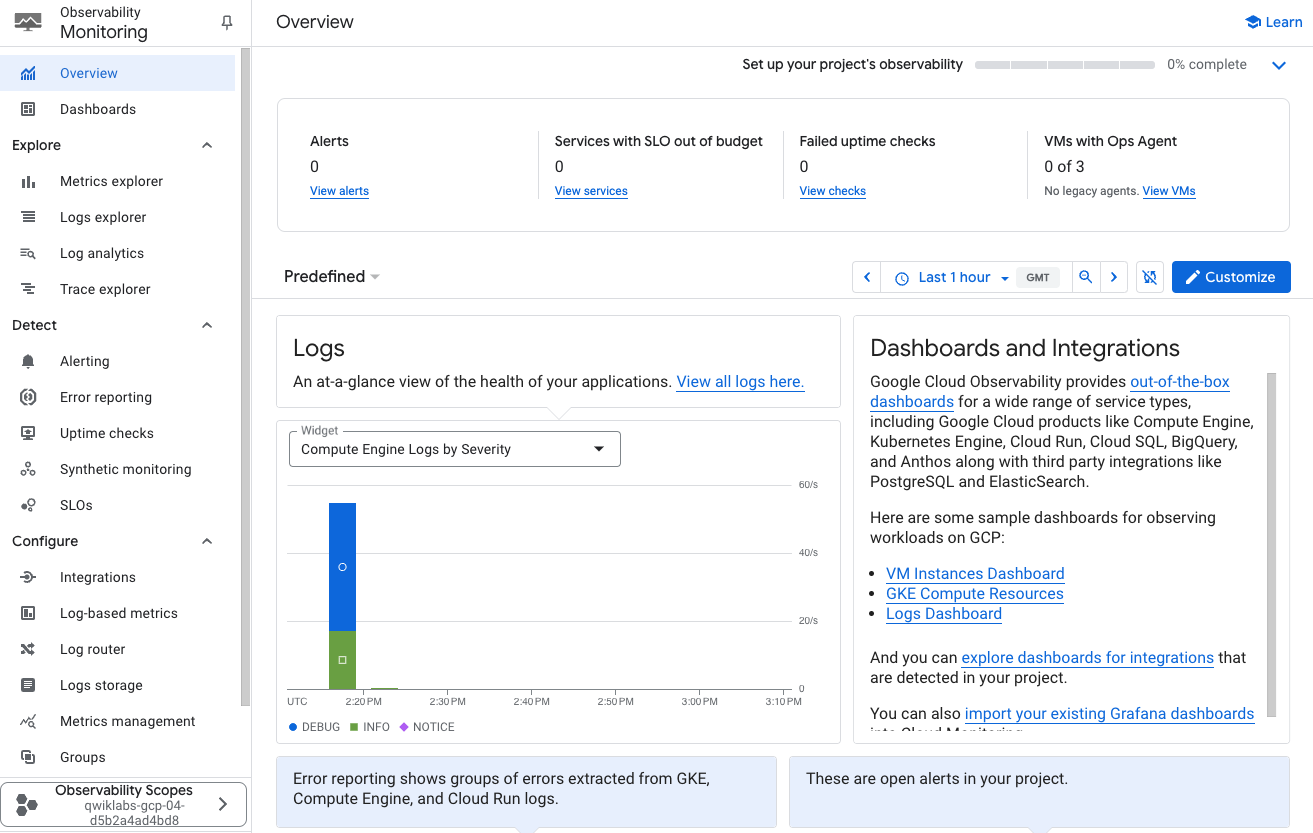

Crea un espacio de trabajo de Monitoring

Ahora, configurarás un espacio de trabajo de Monitoring que esté vinculado con tu proyecto de Google Cloud. Sigue estos pasos para crear una cuenta nueva que incluya una prueba gratuita de Monitoring.

-

En la barra de título de la consola de Google Cloud, escribe Monitoring en el campo Buscar y, luego, haz clic en Monitoring (Control de calidad de infraestructura y apps) en los resultados de la búsqueda.

-

Haz clic en Fijar junto a Observability Monitoring.

-

Espera a que se aprovisione tu espacio de trabajo.

Cuando se abra el panel de Monitoring, tu espacio de trabajo estará listo.

Revisa la interfaz de Monitoring de Kubernetes Engine

Ahora abrirás y explorarás las tres secciones diferentes de la interfaz Kubernetes Engine Monitoring. Las tres secciones son Infraestructura (Infrastructure), Cargas de trabajo (Workloads) y Servicios (Services).

Nota:

Es posible que la opción GKE no aparezca de inmediato en los menús de Monitoring. Habilitar el clúster para las nuevas funciones podría tardar de 5 a 10 minutos. Actualiza la página periódicamente hasta que se muestre la opción.

-

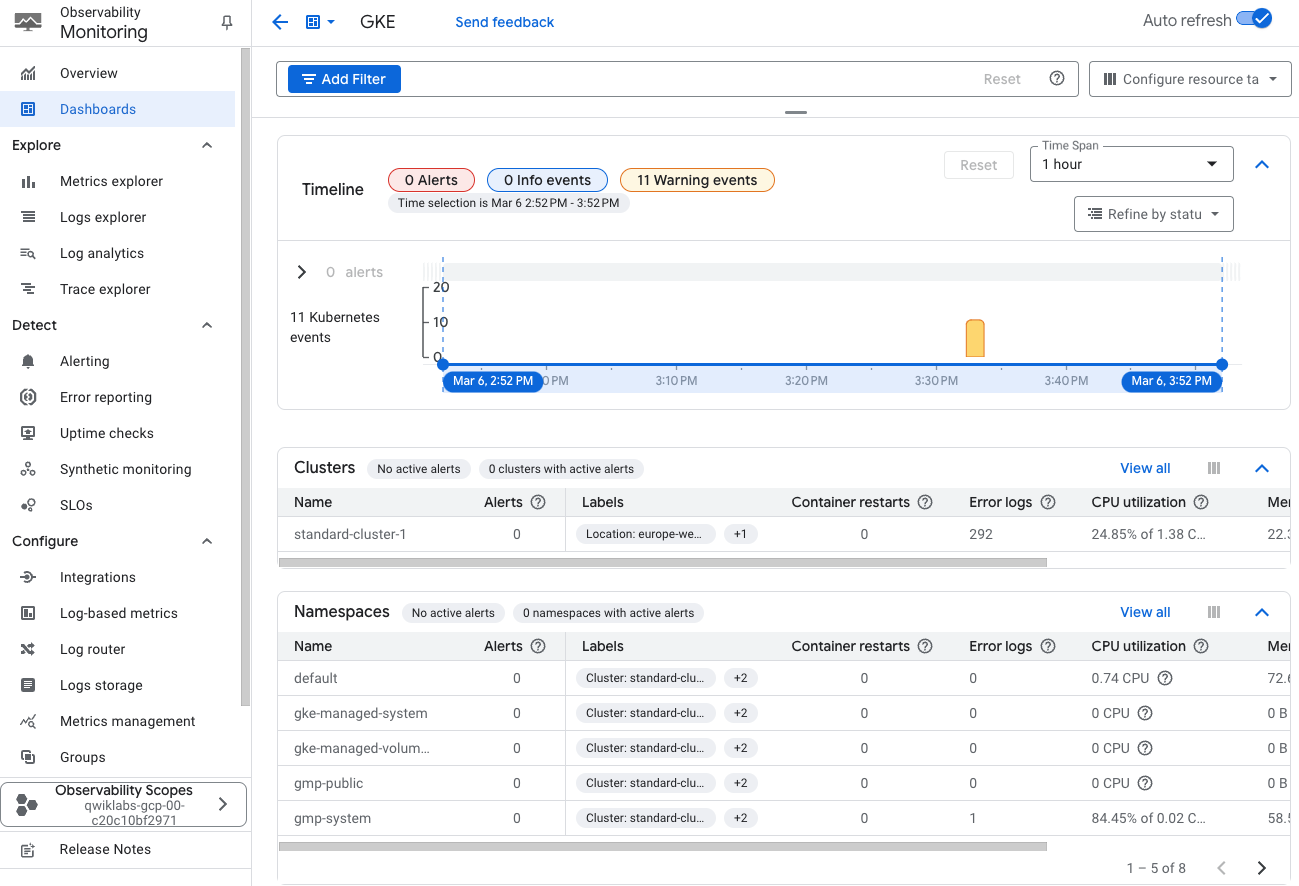

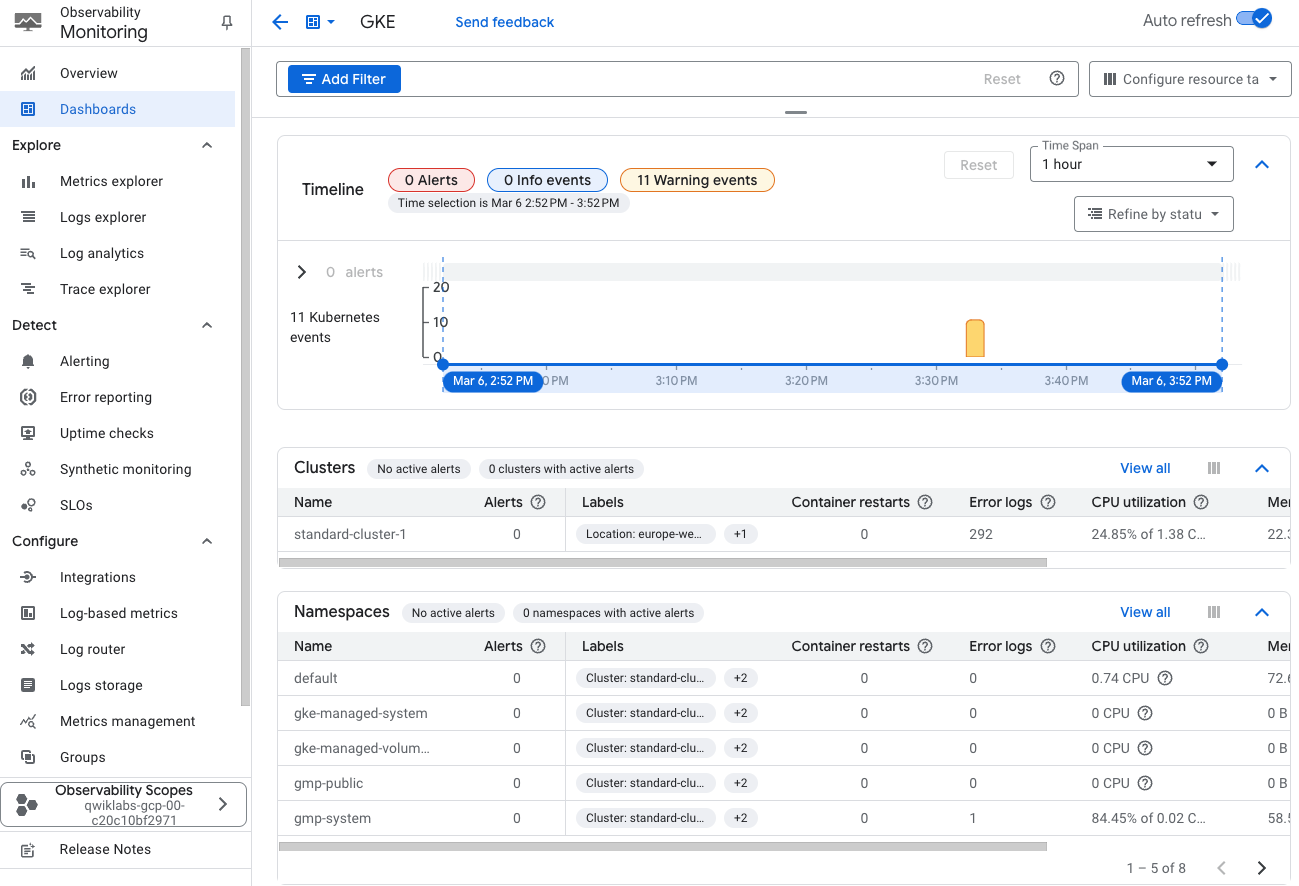

En la interfaz de Monitoring, haz clic en GKE, en la sección Paneles, para ver la nueva interfaz de supervisión.

-

Revisa la interfaz de supervisión. Este es un panel que muestra el estado de tus clústeres de GKE y sus respectivas cargas de trabajo. Observa lo siguiente:

- En la parte superior de la interfaz, se muestra una sección dinámica llamada Cronograma. Si es necesario, expándela con el ícono del menú desplegable. Puedes ajustar el Período en la parte superior de la pantalla con las siguientes opciones: 1h, 6h, 1d, 1w, 1m, 6w o custom. Esta línea de tiempo incluirá marcadores que indiquen los casos de alertas (también conocidos como incidentes).

- El botón de activación Actualización automática (Auto refresh) se ubica a la izquierda de la pantalla. Haz clic en él para permitir que la pantalla se actualice a medida que se reciben nuevos eventos.

- La parte inferior de este panel contiene varias vistas de sección de sus clústeres y sus respectivas cargas de trabajo. La interfaz se divide en varias secciones: Clústeres, Espacios de nombres, Nodos, Cargas de trabajo, Objetos Service de Kubernetes, Pods y Contenedores.

Examina cada sección de la interfaz:

-

Las secciones Clústeres, Nodos y Pods te permiten verificar el estado de elementos específicos en el clúster. También puedes usarlas para inspeccionar los Pods que se ejecuten en un nodo determinado en el clúster.

-

Para consultar los detalles de su clúster, haz clic en el elemento correspondiente.

-

La sección Cargas de trabajo es muy útil, en especial cuando buscas cargas de trabajo que no tienen Services expuestos.

-

La sección Objetos Service de Kubernetes organiza los Services configurados en tu entorno por clúster, luego por espacio de nombres (la barrera administrativa o partición dentro del clúster) y finalmente muestra los distintos Services disponibles para los usuarios dentro de ese espacio de nombres. Haz clic en el nombre de cada servicio para consultar más detalles al respecto.

-

En la sección Espacios de nombres se muestra la lista de espacios de nombres dentro del clúster.

La interfaz de supervisión puede brindar aún más detalles sobre los Deployments y los Pods.

- En la sección Pods, haz clic en aquel que comience con fluentbit-gke-xxxx (si es necesario, haz clic en

View all) y, luego haz clic en la pestaña Métricas para ver más métricas.

Observa el valor de utilización de solicitud de CPU correspondiente a tu Pod. Ese número representa la cantidad de recursos de CPU que el Pod consume en relación con lo que originalmente solicitó del clúster.

-

Haz clic en la X de la esquina superior derecha de la ventana de detalles del Pod.

-

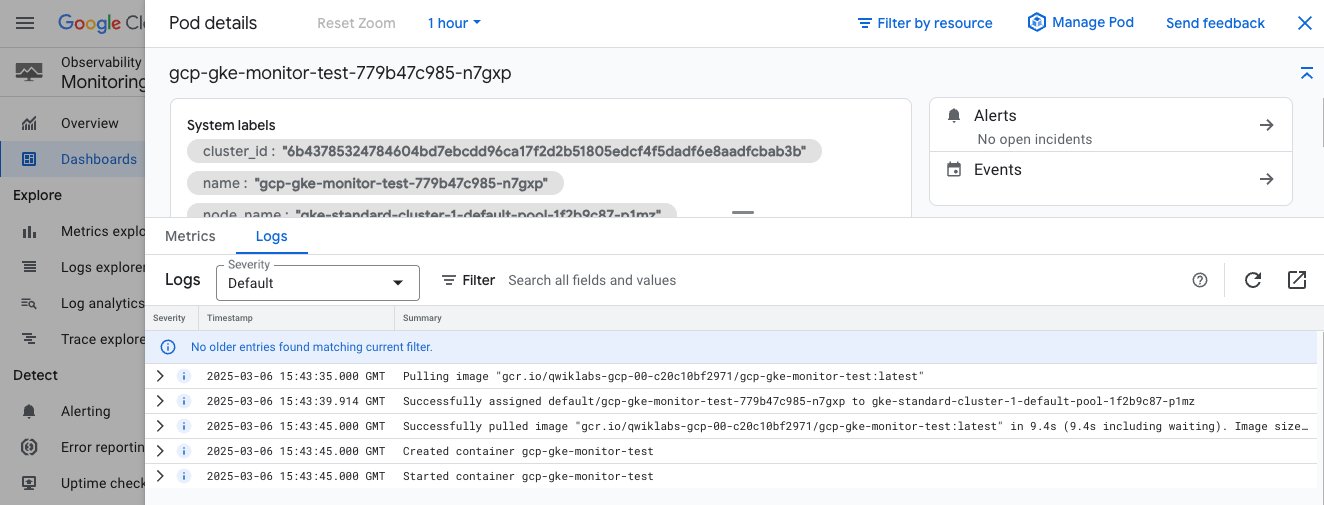

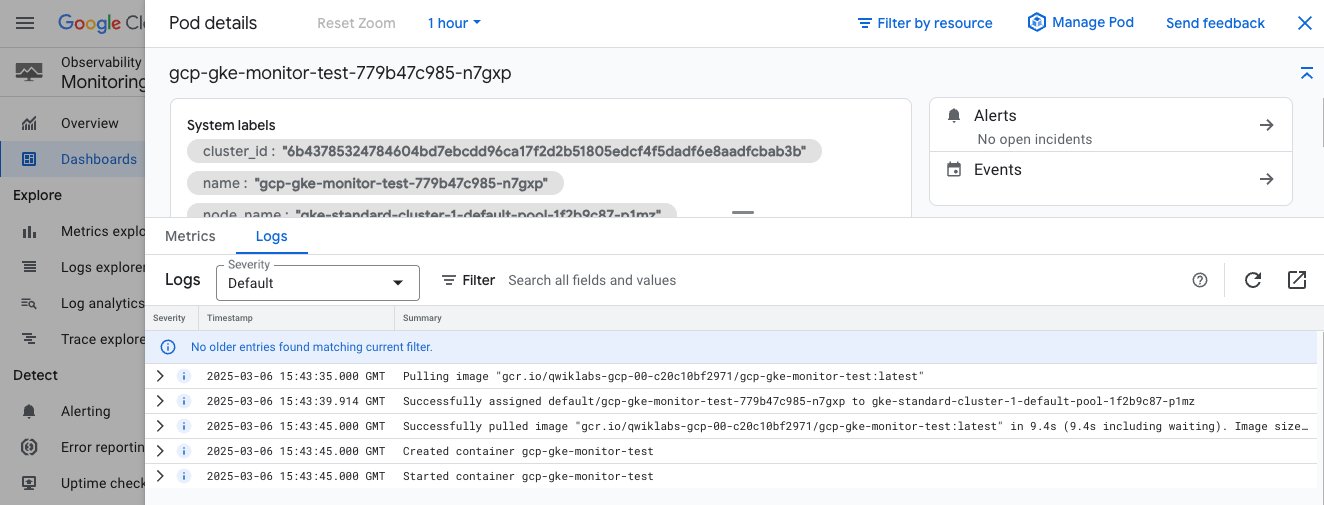

Ahora, haz clic en el Pod que comienza con gcp-gke-monitor-test para consultar más detalles al respecto.

Ten en cuenta que verás información algo diferente si seleccionaste los espacios de nombres en lugar del Pod.

-

Haz clic en la pestaña Métricas (Metrics) para consultar más métricas, como la Utilización de solicitud de CPU (CPU request utilization) y el Tiempo de uso de CPU (CPU Usage Time).

-

En la ventana Detalles del pod (Pod Details), haz clic en la pestaña Registros (Logs) para consultar la actividad de registro del Pod.

Se mostrarán los mensajes de registro que generó el Pod, así como un gráfico que indique la actividad de registro del Pod a lo largo del tiempo. Aquí puedes ver algunos de los registros de muestra que generaste en la herramienta.

- Haz clic en la X en la esquina superior derecha de la ventana Detalles del pod (Pod Details), para regresar a la interfaz de Monitoring.

Crea un panel personalizado de Monitoring para supervisar tus Pods

En Monitoring, puedes crear paneles personalizados en los que se muestren métricas importantes, como el uso de CPU, los reinicios de contenedores y nuestra métrica personalizada para la cantidad de usuarios conectados, entre otras.

-

En la barra de navegación que se encuentra en el costado izquierdo de la página Observability Monitoring, haz clic en Explorador de métricas para comenzar a crear tu panel.

-

Haz clic en Seleccionar una métrica.

Se filtrará la lista por los tipos de recursos que admitan las nuevas herramientas de Kubernetes Engine Monitoring.

-

Selecciona Contenedor de Kubernetes > Métricas populares > Utilización de solicitud de CPU.

-

Haz clic en Aplicar.

Este es el mismo gráfico de utilización de solicitud de CPU que vimos antes cuando examinamos el Pod fluentbit-gke-xxxx, pero ahora el gráfico mostrará esa métrica para todos los Pods.

-

Ahora haz clic en el botón Guardar gráfico, en la esquina superior derecha de la pantalla.

-

Asigna un nombre al título del gráfico como Solicitud de CPU de contenedor y, luego, haz clic en Panel.

El nombre debería representar solo este gráfico. Podrás asignarle un nombre a todo el panel en el siguiente paso.

-

Haz clic en Nuevo panel.

-

Asígnale el nombre Panel de contenedor al panel.

-

Haz clic en Guardar gráfico.

-

Para iniciar el panel, haz clic en Paneles en el panel de navegación. Luego, selecciona el nombre del panel nuevo.

Ahora tienes un panel que muestra un solo gráfico con una métrica estándar de Monitoring. A continuación, crearás un gráfico para nuestra métrica personalizada de Monitoring y, luego, lo agregarás a este panel.

-

Haz clic en Explorador de métricas.

-

Haz clic en Seleccionar una métrica.

-

Selecciona Pod de Kubernetes > Métricas personalizadas > Aplicación web: usuarios activos.

-

Haz clic en Aplicar.

-

Haz clic en Guardar gráfico.

-

Asígnale un nombre al gráfico nuevo, como Usuarios activos.

-

Selecciona Panel de contenedor en el menú desplegable de paneles.

-

Haz clic en Guardar gráfico.

-

Vuelve al panel Contenedor y haz clic en los íconos de ajustes para mostrar el menú de configuración.

-

Luego, haz clic en Leyendas > Tabla para mostrar el texto debajo de cada gráfico.

-

Haz clic en las tres barras verticales junto a la palabra Valor, a la derecha de cada gráfico.

Se mostrará una ventana emergente con las diferentes etiquetas que se incluyeron en los datos de series temporales que envió nuestro servidor de aplicaciones. Puedes usar esta información para filtrar o incluso agregar datos al gráfico.

Tarea 4. Crea alertas con Kubernetes Engine Monitoring

En esta tarea, configurarás una alerta en Kubernetes Engine Monitoring. Luego, usarás el panel para identificar el incidente y responder a este.

Crea una política de alertas

Ahora crearás una política de alertas para detectar el uso de CPU elevado entre los contenedores.

- En la consola de Cloud, en el Menú de navegación, selecciona Monitoring > Alertas.

- Haz clic en + Crear política.

- Haz clic en el menú desplegable Seleccionar una métrica.

- Desmarca la opción Activo.

- Escribe Contenedor de Kubernetes en el campo para filtrar por nombre de recurso y métrica.

- Haz clic en Contenedor de Kubernetes > Contenedor.

- Selecciona Utilización de solicitud de CPU.

- Haz clic en Aplicar.

Nota: Si no encuentras el tipo de recurso Contenedor de Kubernetes, es posible que debas actualizar la página.

- Configura Rolling windows en 1 min.

- Haz clic en Siguiente.

- Establece Posición del umbral en Por encima del umbral.

- Establece 0.99 como Valor del umbral.

- Haz clic en Siguiente.

Configura las notificaciones y finaliza la política de alertas

-

Haz clic en la flecha desplegable junto a Canales de notificaciones y, luego, en Administrar canales de notificaciones. Después, haz clic en Canales de notificaciones, una página se abrirá en una pestaña nueva.

-

Desplázate hacia abajo por la página y haz clic en AGREGAR NUEVO para Correo electrónico.

-

Ingresa tu correo electrónico personal en el campo Dirección de correo electrónico y completa el campo Nombre visible.

-

Haz clic en Guardar.

-

Regresa a la pestaña anterior, Crear política de alertas.

-

Vuelve a hacer clic en Canales de notificaciones y luego en el ícono de actualización para que se muestre el nombre visible que mencionaste en el paso anterior. Vuelve a hacer clic en Canales de notificaciones si es necesario.

-

Ahora selecciona tu nombre visible y haz clic en Aceptar.

-

Asigna el nombre Utilización de solicitud de CPU a la alerta.

-

Haz clic en Siguiente.

-

Revisa la alerta y haz clic en Crear política.

Haz clic en Revisar mi progreso para verificar el objetivo.

Crear alertas con Kubernetes Engine Monitoring

Responde a un incidente

Ahora regresa al panel de Monitoring, en el que se informa un incidente en uno de los contenedores.

- En la página Observability Monitoring, selecciona Descripción general > GKE.

En el panel de Kubernetes Engine Monitoring, deberías ver que se informó un incidente en el contenedor.

- En la pestaña Contenedores, haz clic en el nombre del contenedor que muestra la alerta.

Registrar la alerta tardará uno o dos minutos, y es posible que debas actualizar la página para poder ver la alerta.

- Ve a la página Alertas.

- Haz clic en el nombre de la alerta Utilización de solicitud de CPU para obtener más detalles.

- Abre el incidente y haz clic en la entrada Resumen de incidentes.

- Luego, en Confirmar.

El estado del incidente ahora muestra Confirmado, pero eso no resuelve el problema. Debes corregir la causa raíz del problema, en el contenedor del generador de cargas de CPU.

- Abre la interfaz web de la herramienta GCP-GKE-Monitor-Test.

- En la sección Generate CPU Load, haz clic en el botón Stop CPU Load para resolver el problema deteniendo el generador de cargas de CPU.

- Ahora puedes cerrar la ventana del navegador web de GCP-GKE-Monitor-Test.

Finalice su lab

Cuando haya completado el lab, haga clic en Finalizar lab. Google Cloud Skills Boost quitará los recursos que usó y limpiará la cuenta.

Tendrá la oportunidad de calificar su experiencia en el lab. Seleccione la cantidad de estrellas que corresponda, ingrese un comentario y haga clic en Enviar.

La cantidad de estrellas indica lo siguiente:

- 1 estrella = Muy insatisfecho

- 2 estrellas = Insatisfecho

- 3 estrellas = Neutral

- 4 estrellas = Satisfecho

- 5 estrellas = Muy satisfecho

Puede cerrar el cuadro de diálogo si no desea proporcionar comentarios.

Para enviar comentarios, sugerencias o correcciones, use la pestaña Asistencia.

Copyright 2020 Google LLC. All rights reserved. Google y el logotipo de Google son marcas de Google LLC. Los demás nombres de productos y empresas pueden ser marcas de las respectivas empresas a las que estén asociados.

), haz clic en Kubernetes Engine > Clústeres.

), haz clic en Kubernetes Engine > Clústeres.